2018: a deepfake éve, a valóság vége

- Link másolása

- X (Twitter)

- Tumblr

Emlékszünk még azokra az időkre, amikor emberek tömegei egy egyszerű photoshopolt képre is gondolkodás nélkül képesek voltak rávágni, hogy valódi? Persze, hogy emlékszünk: hiába tűnik ősi technológiának a fotómanipuláció, az emberek még mindig nem tanulták meg helyén kezelni, hogy a technológiai fejlődés felgyorsulásával egyre kevésbé hihetnek a szemüknek.

De még ha meg is tanulták, a világnézetileg egyre megosztottabb társadalomban sokszor könnyebb bevenni a propagandát. Még idén márciusban is százezrek osztották meg heves indulattal azt a képet, amelyen a parklandi iskolai mészárlást túlélő, azóta a fegyvertartás szabályozásáért küzdő Emma Gonzalez kettétépi az amerikai alkotmányt – miközben az eredeti felvételen egy papír céltáblát szakít szét.

És ezek még csak képek voltak. A Motherboard 2017 decemberében számolt be egy új Reddit-trendről: hírességek arcát illesztették pornószínésznőkére, és hétről hétre egyre élethűbb ál-celebpornókat tettek közzé. A folyamathoz mindössze az eredeti pornójelenetre és a híresség minél több arckifejezésére (képeken, videón) volt szükség. Digitális trükkökkel hamisított videók már korábban is készültek, az új jelenség abban különbözik, hogy itt az érdemi munkát nem a felhasználók végzik, hanem a mesterséges intelligencia (AI). Az AI alapú videomanipuláció jelensége a reddites fórumok nyomán deepfake néven terjedt el, ami a deep learning (mély tanulás) és a fake (ál-, hamis) szavakból áll össze.

Bár már az amerikai hadsereg is felvette a harcot ellene, a jó célokra is használható, de tömegmanipulációra és kicsinyes bosszúkra egyaránt alkalmas deepfake megállíthatatlannak tűnik: az álhírek és a poszt-igazság (post-truth, a 2016-os év szava az Oxford Dictionariesnél) korszakának legnagyobb fegyvere lehet, amely végső soron az általunk értelmezett valóság végét jelentheti.

Egy jó GPU, egy kis HDD és egy ANN

Egy-két évvel az előtt, hogy elárasztották az internetet a geek-kedvenc színésznők álpornói, már megjelent az igény a technológiára. A deepfake gyökereit ugyanis a 2015-ben csúcsosodó arccseremániában kell keresni: a Snapchat vagy az azóta a Facebook által felvásárolt MSQRD app szűrőivel saját magunkon tesztelhettük, milyen izgalmas, amikor valós időben bújhatunk digitálisan hírességek vagy más lények bőrébe – például bárki Leonardo DiCaprio arcával mutatkozhatott, akár élő videóban is.

2018 januárjában jelent meg az első olyan felhasználóbarát, ráadásul ingyenes alkalmazás, amely már ennél is többet ígért. A FakeApp a Google nyílt forráskódú mélytanulás-rendszerét, a TensorFlow-t, valamint szabadon használható programozási könyvtárakat (pl. OpenCV) használ, működtetéséhez pedig csak egy jó grafikai processzor (GPU), néhány gigabájt szabad tárhely és egy mesterséges neurális hálózat (ANN) szükséges. Bár több mindentől függ, egy 3-5 perces videó így átlagosan körülbelül 40 óra alatt készül el.

A technológia eddigi legnépszerűbb felhasználásában rejlő személyi jogi krízist érzékelve olyan oldalak tiltották már be a mély tanulással létrehozott pornót, mint a Twitter, a legnépszerűbb felnőttoldal, a Pornhub vagy az egész deepfake-forradalom Pilvax kávéháza, a Reddit. Hosszú távon viszont ennyi biztosan nem lesz elég, főleg, hogy csak idő kérdése, mikor kezdik el valós hatalmi célokra használni a technikát.

Új eszközhöz jutnak az internetes csalók

Aviv Ovadya, aki korábban a kaliforniai startup-világban szabadúszott, ma pedig a Michigani Egyetem közösségi oldalak társadalmi felelősségét vizsgáló intézetében (Center for Social Media Responsibility) dolgozik, már 2016 közepén igyekezett figyelmeztetni a nagy techcégeket arra az információs válságra, amit ma már fake news-ként ismerünk, mindhiába. Ovadya ma már a deepfake-től félti a demokráciát.

A Buzzfeednek azt hozta fel példaként, hogy ha egy gépi tanulásos algoritmus több száz órányi felvételt elemez Donald Trumpról vagy Kim Dzsongunról, akkor közel tökéletes videót vagy hangfelvételt képes létrehozni arról, hogy valamelyik vezető kikiáltja a nukleáris háborút: „nem is kell tökéletesnek lenniük, csak elég jónak ahhoz, hogy az ellenség elhiggye, hogy tényleg megtörtént, és ez hirtelen felindulásból tett megtorló akciót válthat ki”.

Az adathalászat és az internetes csalások területén is forradalmi változásokat hozhat a deepfake, amennyiben a csalók már nem egységes, előre megírt, messziről felismerhető szövegekkel próbálnak személyes információkat, jelszavakat vagy pénzt szerezni az áldozataiktól, hanem például a közösségi oldalakra eresztett algoritmusok segítségével az ismerőseikről gyűjtött adatok alapján írnak személyes hangvételű segítségkérő leveleket, esetleg AI által hamisított képekkel, videókkal illusztrálják a bajba jutott ismerős helyzetét.

A valóságapátia már el is kezdődött

Mindez két következménnyel járhat. Az emberek egyfelől belefáradhatnak abba, hogy mindenhol manipulált üzenetekkel, hírekkel, tartalmakkal szembesülnek, ezért Ovadya szóhasználatával „valóságapátia” lesz úrrá rajtuk, így az addig valósnak vélt hírforrásokba, digitális eszközökön keresztül tartott kapcsolataikba vetett bizalmuk elvesztésével elfordulnak a megszokott platformoktól, ezzel viszont a demokrácia működéséhez szükséges általános tájékozottságnak is lőttek.

Másfelől, ahogy Renee DiResta dezinformációs szakértő elmondta, még ha nem is következik be a tömeges álvideógyártás, az egyszerű hamisítási technológia puszta léte is elég ahhoz, hogy minden digitális tartalom elveszítse a hitelességét. „Nem kell konkrétan elkészíteni a hamisított videót, hogy a technikának komoly hatása legyen. Csak rá kell mutatni, hogy létezik ilyen, és máris kétségbe vonható a valódi dolgok integritása.” DiResta szerint ennek az eddigi legékesebb példája Donald Trump nyilatkozata, amelyben szakértőkre hivatkozva mondta a nagy port kavart Access Hollywood-videóról, hogy valószínűleg nem az ő hangja hallható rajta, és lehet, hogy digitálisan manipulálták a felvételt.

Az orosz trollok már hamisítanak, az amerikaiak védekeznek

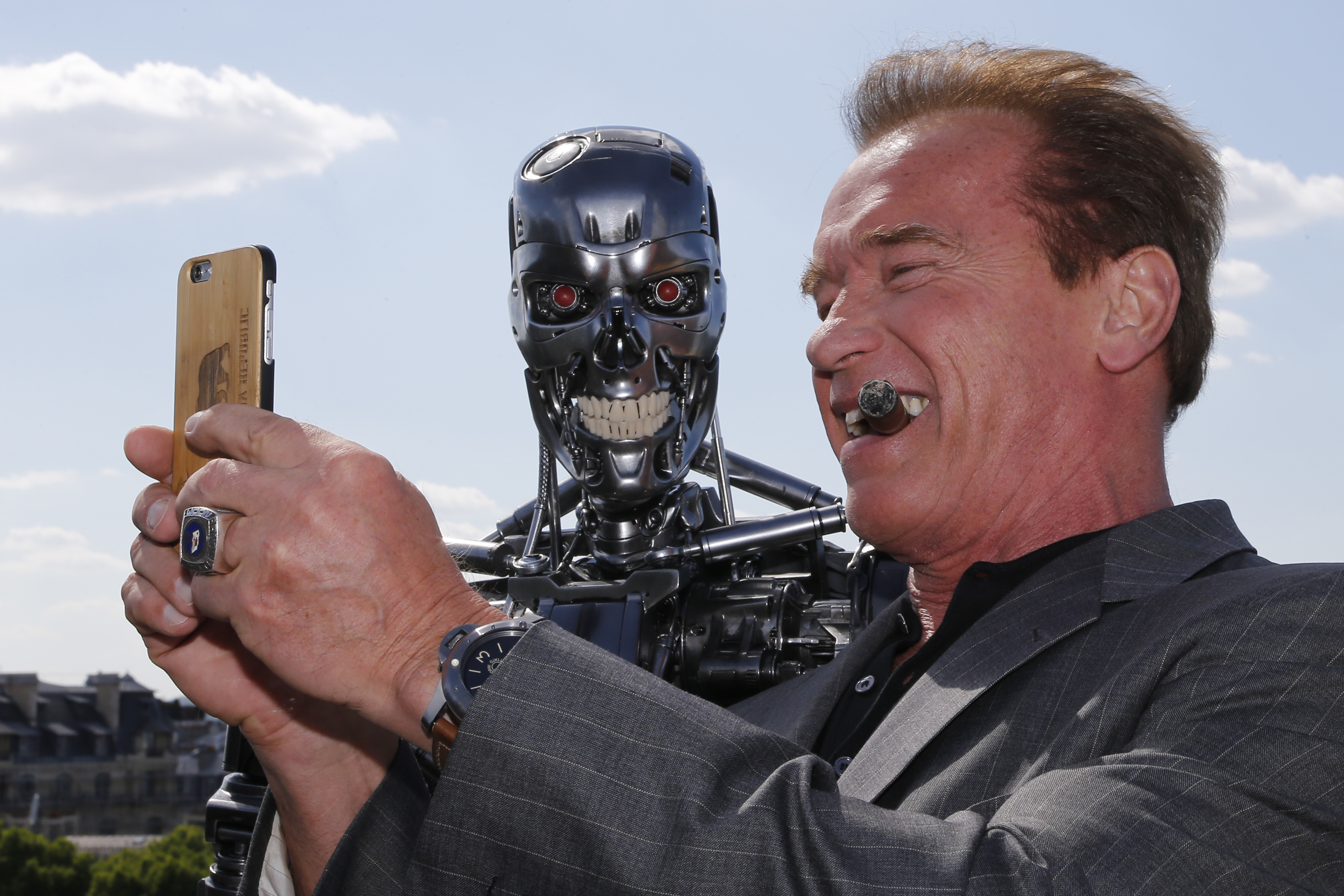

Míg a Washingtoni Egyetem kutatói csak azért választották Barack Obamát a deepfake videójuk alanyául, mert az exelnökről található a legtöbb szabadon felhasználható videó, a Buzzfeed és a Get Out című disztópikus thrilleréért Oscar-díjjal jutalmazott színés és humorista, Jordan Peele videója már szándékosan adott olyan szöveget Obama szájába, amit nyilván soha nem mondana – a virálissá vált videó egyfajta társadalmi célú hirdetés volt a deepfake politikai veszélyeiről.

Néhány napja a Telegraph írta meg, hogy az orosz dezinformációs propaganda ellen harcoló EU-s akciócsoport, az East Stratcom már hozzájutott a Kreml-közeli trollok által készített deepfake videókhoz, amelyek a következő lépcsőt jelenthetik az álhírek háborújában. A csoport szerint a videók elsősorban a bevándorlás és a kisebbségek jogainak témái köré épülnek, az egyik nekik is bemutatott videóról például azt írta a lap, hogy Barack Obamát ábrázolja, amint egy lövöldözés után a meleg áldozatokkal szimpatizál, ezt a közösségi médiában a konzervatív-keresztény csoportok között terjesztették az oroszok.

Az amerikai védelmi minisztérium kutatásokért felelős részlege, vagyis a hadsereg technológiai hátteréért is felelős DARPA új projektjében az ország vezető kiberbiztonsági szakértői gyűlnek össze, hogy egymással versenyezve létrehozzák a leghihetőbb deepfake videókat – a végső cél természetesen az, hogy kifejlesszék az ezek felismerésére képes eszközöket. Aviv Ovadya szerint azonban ez egy végeláthatatlan folyamat, ugyanis ha arra tanítunk egy rendszert, hogy a saját technikáját ismerje fel, akkor az arra is tanítható, hogy kerülje meg a felismerési folyamatokat, és így tovább.

A Futurism szerint viszont ha a DARPA komolyan a technológia legjobbjait keresné, akkor a Google és a Facebook ajtaján kéne kopogtatnia. A lap fel is sorol néhányat a két cég által nyilvánosan publikált tanulmányokból, amelyekben a következőket kutatták:

- a deepfake videók voxel-részletességű hibajavításai (Google),

- a mozgás követése és a pozíció megállapítása a több embert ábrázoló videókon (Facebook),

- semleges, frontális arckép generálása egy bármilyen érzelmet kifejező és bármilyen szögből készített arcképről (Google),

- a Facebook-profilképek animálása (Facebook).

Az utóbbi esetben rá is kérdeztek a kutatás vezetőjénél, hogy mi volt a célja a kísérletnek, és mit lehet tenni, ha manipulációra használnák fel. AI-kutatóhoz méltó, tipikusan felelősségteljes válasz érkezett: „amikor megalkottuk ezt a technológiát, az volt a célunk, hogy feszegessük annak a határait, hogy mit lehet létrehozni egyetlen képből. Nem igazán volt gyártási terv a fejünkben, egyszerűen a legkorszerűbb kutatást akartuk végezni. Nem nagyon gondoltunk ilyenre alkotás közben, de ahogy sok más példa mutatja, a technológiával vissza is lehet élni, ami félelmetes dolog.”

Azé a történelem, akié a technológia

A deepfake legnagyobb veszélye tehát egyértelmű: azt az alapállítást rúgja fel, miszerint ha másnak nem, legalább a szemünknek hihetünk. A tévének vagy a Youtube-nak köszönhetően már a mozgóképek manipulációját, a vágás erejét is viszonylag jól kiismerhették az emberek, de a vágatlan videó hitelessége talán a mai napig szent volt. Talán még ma is Mitt Romney lenne az amerikai elnök, ha nem nevezi ingyenélőnek a szavazók 47 százalékát, de az iszlám állam kegyetlenségei is felfoghatatlanok voltak, amíg nem jöttek sorban a lefejezős videók.

Bár a mesterséges intelligencia segítségével manipulált videók emberi emlékezetre gyakorolt hatásáról még nem készültek tanulmányok, a memóriakutatók több évtizedes eredményei szerint az emberi agy kifejezetten hajlamos a hamis emlékek generálására, főleg, ha neki tetsző eseményekről van szó. A közösségi oldalak és a polarizált média által létrehozott véleménybuborékok és visszhangkamrák különösen kedveznek ennek a jelenségnek, mondta a Qubitnek Németh Kornél pszichológus, a BME Kognitív Tudományok Tanszékének adjunktusa. Németh fő kutatási területe az arcfelismerés és annak zavarai, amelyek különösen fontosak a deepfake jelenség megértéséhez.

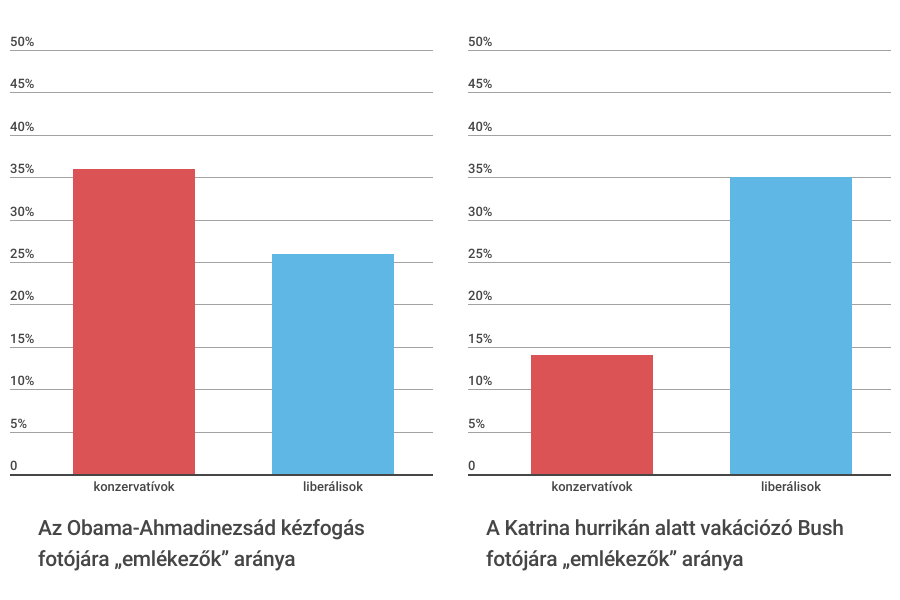

A Vox nemrég egy olyan kutatást mutatott be, amelyben a hamis emlékek kialakulásának politikai tendenciáit vizsgálták. Két manipulált fotót mutattak meg a Slate olvasóinak, és azt kérdezték tőlük, emlékeznek-e rájuk: az egyik Barack Obamát ábrázolja, ahogy kezet fog Mahmud Ahmadinezsád akkori iráni elnökkel, a másik pedig George W. Busht, ahogy a Katrina hurrikán alatt Roger Clemens baseballjátékossal vakációzik. Az eredmény magától értetődő: míg Obama fotójára a konzervatív olvasók 36 százaléka mellett a liberálisok 26 százaléka emlékezett, Bushéra a jobboldaliak 14 százalékához képest a baloldaliak 35 százaléka. Ezek egyébként elég magas számok ahhoz képest, hogy a Slate olvasótáborának nagy részét valószínűleg azok teszik ki, akiket érdekel a közélet.

Egy hamis emlék akkor épül be a legkönnyebben az agyunkba, ha az egyezik a jelenlegi politikai világnézetünkkel, ha ismétlődően találkozunk vele, ha megbízunk az információ forrásában, és ha ezt hozzánk hasonló gondolkodású emberek is megerősítik. Így nem is létezhetne a hamis emlékek generálásának kedvezőbb környezet a közösségi médiánál, ahol az írott álhírek és a manipulált fotók már most nagy gondot okoznak – talán mondani sem kell, mennyivel komolyabb veszélyt rejtenek a deepfake videók ezen a téren.

A deepfake veszélyeivel való szembenézésre a törvényhozók egyelőre nem állnak készen, és kérdéses, hogy egyáltalán milyen jogi kategóriában lehetne felelősségre vonni az álvideók alkotóit. Németh Kornél szerint a deepfake rosszindulatú felhasználásával szembeni küzdelem leghatékonyabb módja „az emberek figyelmének felhívása a kritikus gondolkodás, az információkeresés és felhasználás fontosságára, valamint erre nevelni, edukálni őket. Nem véletlen, hogy a diktatórikus berendezkedésű társadalmakban ez nem prioritás, sőt.”

A valóság végéhez kapcsolódó további cikkek a Qubiten:

Már 25 éve nyakunkon a virtuális valóság, de még mindig nem tudjuk, mihez kezdjünk vele

William Gibson 1984-ben megírta, a Wired 1993 óta erről beszél, a 2010-es évek elejétől bármikor berobbanhat a mainstreambe, egyelőre mégsincs mindenkinek VR-szemüvege otthon. Ennél is nagyobb baj, hogy az oktatásban és a kultúrában is hanyagoljuk, pedig óriási lehetőséget rejlenek a technológiában.

Terrorbotok, dróneltérítések, kamu nagybácsik: vészjósló jelentés a mesterséges intelligencia veszélyeiről

Egy 26 fős nemzetközi kutatócsoport bemutatta, milyen módszerekkel használhatják fel szándékosan az AI-t az emberiség ellen.