A jövő számítógépei nem digitálisak, hanem analógok lehetnek

A St. Louis-i Washington Egyetemen már a jövő számítógépén dolgoznak, ami a neumanni elvekre épülő digitális eszközökkel szemben analóg lehet – írja egy, az IEEE Transactions on Computers október végi számában megjelent tanulmány.

A digitális koncepció jól működik olyan mindennapos felhasználási területeknél, mint az emailezés vagy a játék, de a mai problémák megoldásánál ez a koncepció túlhaladott és kevéssé hatékony lehet. Az információtárolás és -feldolgozás egyidejűsége korlátozhatja a teljesítményt, és erről a platformok digitális jellege tehet.

A jövő számítógépei – írja a Techxplore hírportál – ebből kifolyólag újfajta felépítést használhatnak. Ezek a rendszerek a memóriában végzett feldolgozással (processing-in-memory, PIM) dolgoznak; ez az új számítógépes paradigma egyesíti a feldolgozóegységet és a memóriát, így a számításokat nem a rég ismert és használt bináris elvek, hanem a hardver fizikai tulajdonságai fogják meghatározni.

Meghaladni a neumanni elveket

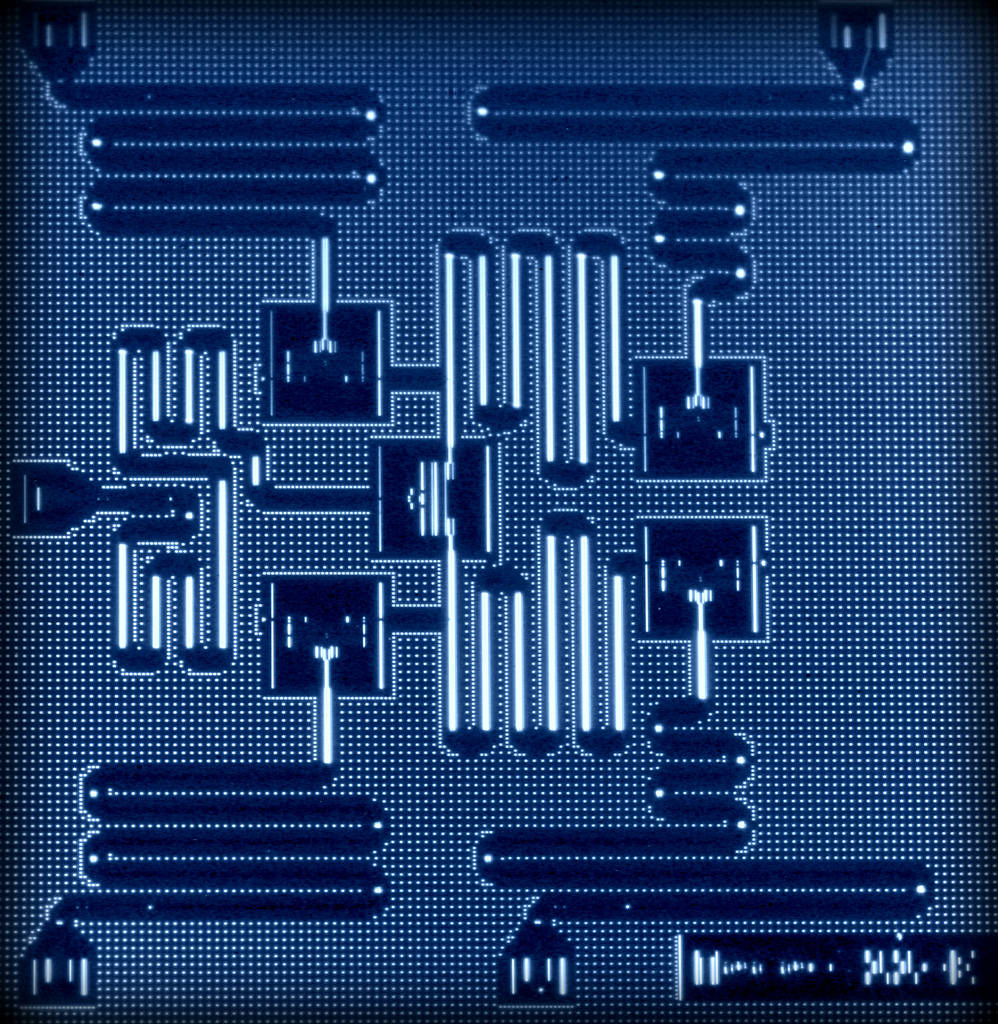

A Washington Egyetem és a MCKelvey School of Engineering kutatói által tervezett PIM áramkör egyesíti a neurális hálózatok rugalmasságát a PIM-alapú számítástudománnyal. Az áramkör elvileg nagyságrendekkel növelheti a PIM komputerek számítási teljesítményét.

A hagyományos számítógépek a Neumann János által lefektetett alapokra épülnek. A neumanni architektúra elkülöníti a memóriát (amiben az adatokat tárolják) és a feldolgozóegységet (azaz az adatok feldolgozását végző processzort). A PIM számítógépek ezt a problémát a processzor és a memória egyesítésével hidalhatják át.

„A számítástudomány mai feladatai elsősorban adatközpontúak. Hatalmas mennyiségű adatot kell megrágnunk, ami teljesítménybeli gátakat képezhet a processzor- és memóriainterfészen.”

– mondta Xuan Silvia Zhang, a McKelvey Rendszermérnöki Tanszékének docense.

Tranzisztor helyett ellenállás

A számítástudomány – különösen a ma gyakran használt, gépi tanulásra képes algoritmusok rendkívül összetett összeadásokra és szorzásokra épülnek. Egy hagyományos számítógépen ezeket a műveleteket tranzisztoralapú processzor végzi. A tranzisztorok gyakorlatilag feszültségvezérelt kapuk, amik blokkolják vagy engedélyezik az elektromosság áramlását. Ezeket az állapotokat egyesekkel és nullákkal jelölik; a bináris kód ezekből épül fel. A bináris kóddal dolgozó processzor a kettes számrendszerben végzi el az aritmetikai műveleteket, amik a számítógépet működtetik.

Azt a számítógéptípust, amin Zhang és munkatársai dolgoznak, véletlen hozzáférésű rezisztív memóriájú PIM-nek nevezik (resistive random access memory PIM). Míg a neumanni rendszerek a biteket a memóriacellában lévő kondenzátorokban (capacitators) tárolják, addig a PIM rendszereknél erre ellenállásokat (resistor) használnak, amik szimultán működnek memóriaként és processzorként.

„Rezisztív memóriával dolgozva nincs szükség digitális vagy bináris fordításra; a tisztán analóg tartományban maradhatunk. Összeadásoknál két feszültséget kell összeadni; szorzásnál pedig az ellenállás értékét módosíthatjuk.”

– mondta Zhang.

A számítássorozat egy pontján persze muszáj digitális formátumba kódolni az adatokat, hogy a mai technológiákkal is használhassuk őket. Ez a pont jelenti a teljesítménybeli szűk keresztmetszetet – és ezen a ponton hasznosul a Zhang és munkatársa, Weidong Cao által fejlesztett áramköre, ami az úgynevezett neurális közelítők (neural approximators) rendszerével hidalja át a teljesítménycsökkenést.

Tízszeres-százszoros teljesítménynövelés

Ha az RRAM–PIM architektúrában az ellenállások elvégzik a számításokat, a válaszokat digitális formátumba konvertálják: az áramkör minden ellenállás-oszlopának eredményét összeadva részeredményeket kapunk, amiket analóg-digitális konverzióval (ADC) fordítanak le digitális jelekké. Ez az átalakítás energiaigényes folyamat, de a neurális közelítő javítja a művelet hatékonyságát. A neurális közelítő ugyanis nem egyenként adja össze az egyes oszlopok eredményeit, hanem egyszerre több számítást is végrehajthat, amihez kevesebb ADC-re van szükség, így növelhető a rendszer hatékonysága.

Zhang és munkatársai már dolgoznak a PIM számítógépek prototípusain, de még számos nehézséggel kell szembenézniük. De ezeket érdemes lesz leküzdeni, mert – mint mondják – az új számítástudományi paradigma akár tízszer-százszor is erősebb lehet, mint azt a ma használt keretrendszer sejteti.

Kapcsolódó cikkek a Qubiten:

Mikor tudjuk már pikk-pakk feltölteni az agyunkba a B-212-es helikopter pilótaprogramját?

Lehet, hogy soha. A technooptimisták az emberi agy digitalizálásával, örök élettel és algoritmikus agyműtétekkel kábítanak, de Mátrix és Neuralink-projekt ide, Kurzweil-fantazmagóriák oda, az emberi agy nem számítógép, és nemhogy a digitalizálásához, de még a feltérképezéséhez is évszázadokra lehet szükség.

Nem biztos, hogy létrehozható a működő kvantumszámítógép, állítja a világhírű matematikus, Gil Kalai

A hatalmas anyagi és szellemi ráfordításokkal fejlesztett kvantum-számítástechnika alapjait kérdőjelezi meg Gil Kalai izraeli matematikus. Szkepszisét több élvonalbeli tudós kollégája is osztja, bár más érvek alapján.

A lyukkártyától az SSD meghajtóig: szédítő fejlődésen mentek át az adathordozók az elmúlt évszázadban

70 éve 163 milliószor többe került 1 megabájt adat tárolása, mint ma, amikor 500 terabájtnyi adatot tudunk rámásolni egy tenyérnyi üveglapra. De hogyan zajlott lépésről lépésre a lyukkártyától az SSD meghajtóig ívelő, folyamatos műszaki paradigmaváltás?