Senki nem tudja, mikor következik be a kvantumfölény, de ha nem készülünk fel rá, az katasztrófához vezethet

Már ma is megéri komolyan venni a kvantum-számítástechnikát, állítja Európa egyik vezető kvantumtechnológiai szakértője, aki szerint a technológiából eredő előnyök kiaknázása mellett itt az ideje, hogy a kormányzatok, intézmények és cégek is számoljanak a várható kockázatokkal, és átálljanak a kvantumrezisztens titkosításra.

„A hype eltúlzott a kvantumhardver esetén, de erősen alulértékelt, amikor a kvantumszoftverről beszélünk” – nyilatkozta a Qubitnek Bent Dalager, a KPMG Denmark partnere, az innovációért és az új technológiákért (Innovation & NewTech) felelős vezetője. Dalager, aki társalapítója és igazgatótanácsi tagja a Dán Kvantumközösségnek (Danish Quantum Community, DQC) szeptember végén látogatott Budapestre, hogy a kvantum-számítástechnikáról adjon elő a 2024-es Brain Baron.

Már léteznek kvantumszámítógépek, mondta Dalager, de jelenleg nincs túl sok qubitjük, vagyis kvantumbitjük (ez a kvantuminformáció alapegysége), amivel dolgozhatnának. Emiatt a kvantumszámítógépek mostani generációját nagyrészt kutatási célokra használják, és kereskedelmi alkalmazásuk eddig korlátozott maradt. A legfontosabb jellemző, mint mondta, ami megkülönbözteti a kvantumszámítógépeket a hagyományos számítógépektől az, hogy képesek párhuzamosan hihetetlen mennyiségű számítást elvégezni.

Míg egy hagyományos számítógépben a bitek 0-ás vagy 1-es értéket vehetnek fel, a kvantumszámítógép qubitjei 0 és 1 között sok különböző állapotot elfoglalhatnak. „Ez azt eredményezi, hogy párhuzamos számításokat tudunk végezni” – mondta Dalager. A kvantumszámítógép qubitjei kombinálhatók és egyszerre munkára foghatók, ami egyes területeken hihetetlenül nagy számítási kapacitást tesz lehetővé, drasztikusan alacsonyabb energiafelhasználás mellett. Az elmúlt években az adatközpontok energiafelhasználása – különösen az AI-modellek tanítására fordított erőforrások – klímapolitikai kérdéssé vált, és mostanában az olyan techvállalatok, mint a Microsoft és a Google már az atomenergiába fektetnek be, hogy működtetni tudják létesítményeiket.

Még a funkcionális kvantumszámítógépek kora előtt, mondta Dalager, egy számítástudománnyal foglalkozó amerikai szakember, Peter Shor rámutatott, hogy ha léteznének ilyen gépeink, azok elképesztően gyorsan tudnának nagy számokat prímtényezőjükre bontani. Ezt egy, a kutatóról elnevezett kvantumalgoritmus, a Shor-algoritmus segítségével végeznék el. Elegendően nagy számok esetén a kalkuláció egy hagyományos számítógépen akár kétmillió évig is tarthat, miközben egy kvantumszámítógép percek alatt megoldja a problémát. – De hol itt a gond? – teszi fel a kérdést Dalager. Ott, hogy a legbevettebb adatbiztonsági megoldás az RSA eljárás, amely pontosan arra épül, hogy elegendően nagy számok prímtényezőkre bontása nagyon nehéz és időigényes feladat. Ez azt jelenti, hogy ezek az algoritmusok hihetetlenül jól védenek, egészen addig, amíg egy elegendő qubittel rendelkező kvantumszámítógép fel nem bukkan a színen.

Ezer qubitnél tartunk, de egymillió kellene

Több lehetséges út létezik egy kvantumszámítógép kifejlesztésére, magyarázta Dalager, de mindegyikben közös, hogy két fő kvantummechanikai elvet használnak ki. Az egyik a kvantum-szuperpozíció, amelynek értelmében a qubit szuperpozícióban létezik, a másik pedig a kvantum-összefonódás, aminek értelmében a szubatomi entitások lényegében egyesülnek, és egyként képesek hasznos munkát végezni.

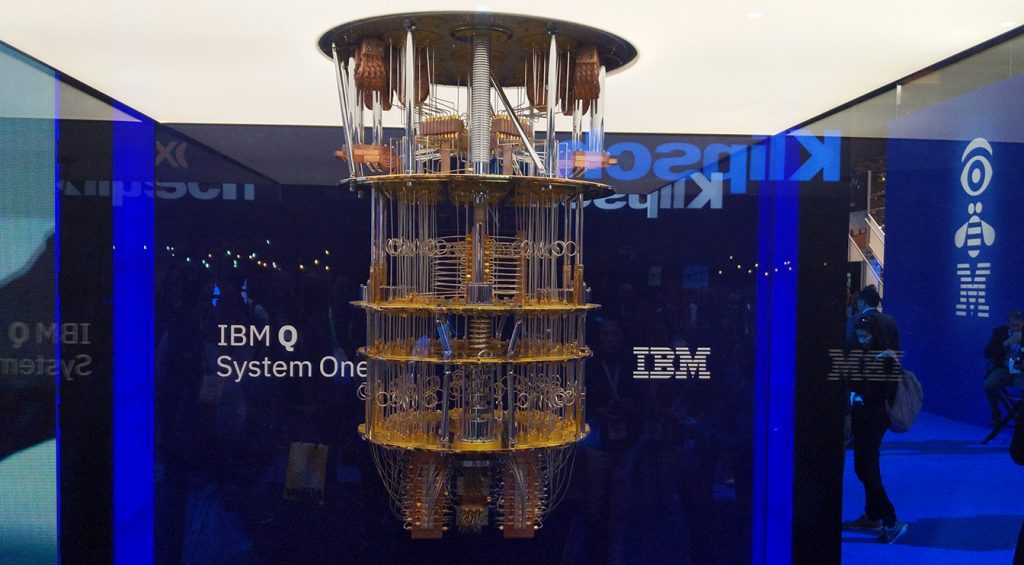

Jelenleg az IBM és a Google ugyanazzal a megközelítéssel épít kvantumszámítógépeket: a chipeket lehűtik az abszolút nulla (-273,15 Celsius-fok, 0 Kelvin) közelébe: ez a szupravezető technológiára épülő kvantumszámítógép. De léteznek más megközelítések is, mint a csapdába ejtett ionokra építő (trapped-ion) kvantumszámítógépek, amikben kevesebb hiba keletkezik, és a topológiai kvantumszámítógépek, amelyek egyelőre nagyon korai stádiumban vannak, de a jövőben megvalósíthatónak tűnnek.

Dalager szerint jelenleg az a probléma, hogy a szupravezetésre épülő kvantumszámítógépeknél nehéz fenntartani a szuperpozíció állapotát, ami ahhoz vezet, hogy a qubitek hajlamosak hibákat felhalmozni (error proneness). A legnagyobb létező szupravezető kvantumszámítógép az IBM által létrehozott Condor, aminek több mint ezer qubitje van, egészen pontosan 1121. De a logikai qubitek száma jóval kevesebb, csupán néhányra tehető, és ezek azok, amelyekre ténylegesen lehet számítani. Az, hogy a qubitek hibákat gyűjthetnek be, ahhoz vezet, hogy rengeteg erőforrás a hibaarány csökkentésére megy el, annak érdekében, hogy hasznos számításokat lehessen végezni.

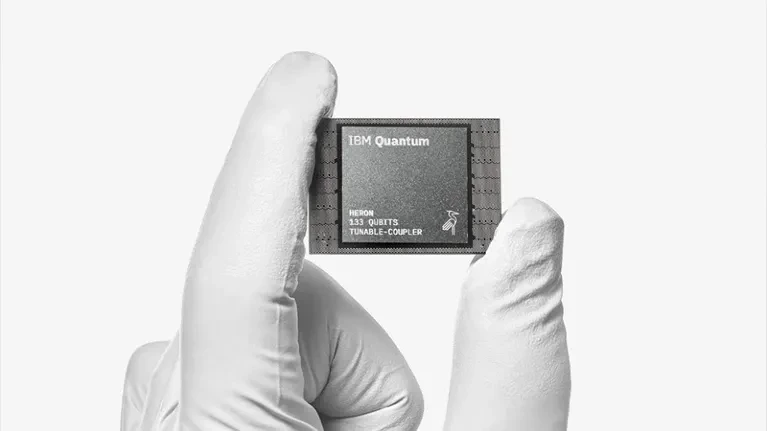

A hangsúly jelenleg ezért a qubitek skálázásán van, mondta Dalager. Az IBM most vezeti be a második generációs kvantumprocesszorát, ami bár kevesebb qubittel rendelkezik, mint a Condor, ha a mérnökök tervei szerint működik, egy másik kvantumprocesszort is hozzá tudnak kapcsolni. Ezután, mint mondta, talán össze lehet kötni egy harmadikkal, és ezzel meg is lehet a megoldás a kvantumszámítógép skálázására, amelyben több kvantumprocesszor összehangoltan működik. A második generációs megközelítés első példánya az IBM Heron. Bár az IBM nem tette nyilvánossá, hogy a processzorok összekapcsolása pontosan milyen technológián alapszik, Dalager szerint az valószínűleg valamiféle kvantum-összefonódást használhat azok összekötésére.

Jelenleg legalább 1 millió qubitre lenne szükség Shor algoritmusának lefuttatásához. A kvantumprocesszorokhoz átlagosan évente 300 qubitet tudnak hozzáadni, és most 1000 qubit környékén tartanak (2017-ben még az IBM 50 qubites kvantumszámítógépe számított nagy dobásnak). „Tehát látszik, hogy van egy kis problémánk” – mondta Dalager, aki szerint az optimista előrejelzések azt állítják, hogy a kvantumfölény, vagyis amikor a kvantumszámítógépek felülmúlják egyes számítási problémák esetén a hagyományos számítógépeket, 3-5 éven belül elérhető lehet. A realisztikusabb jóslatok 8-10 évvel számolnak, vagyis ezek alapján 2030-as évek elején érkezhetünk meg ide.

De mi van, ha nem kell ennyit várni?

Létezik ugyanakkor egy másik fajta, nagyon leegyszerűsített kvantumszámítógép, mondta Dalager, amit a kanadai D-Wave Quantum Systems gyárt. Ez a kvantum annealingnek nevezett technológiát hasznosítja, ami egy optimalizációs folyamat, és képes kombinatorikus optimalizálási problémákat megoldani, mint amilyen a logisztikában vagy rácsoptimalizálásban fontos „utazó ügynök problémája”. A kutatók a kanadai vállalatnál úgy gondolkodtak, mondta Dalager, hogy ahelyett, hogy a qubitek hibákra történő hajlamosságát próbálnák kiküszöbölni, inkább a kvantumszámítás egyes problémáira összpontosítanak, amelyek kvadratikus optimalizálásként (quadratic unconstrained binary optimization, QUBO) ismertek, és direkt ezeknek a megoldására terveznek qubiteket. Sikerült is a dolog, ráadásul fel tudták skálázni a rendszert 10 000 qubitig, így azt sokkal kevésbé érinti a hibahalmozás problémája, és jól működik.

A cikk innentől csak a Qubit+ előfizetőinek elérhető.

Csatlakozz, és olvass tovább!

Ha már van előfizetésed, lépj be vele. Ha még nincs, válassz csomagjaink közül!