A szakértők már fogadásokat kötnek az első deepfake politikai botrányra

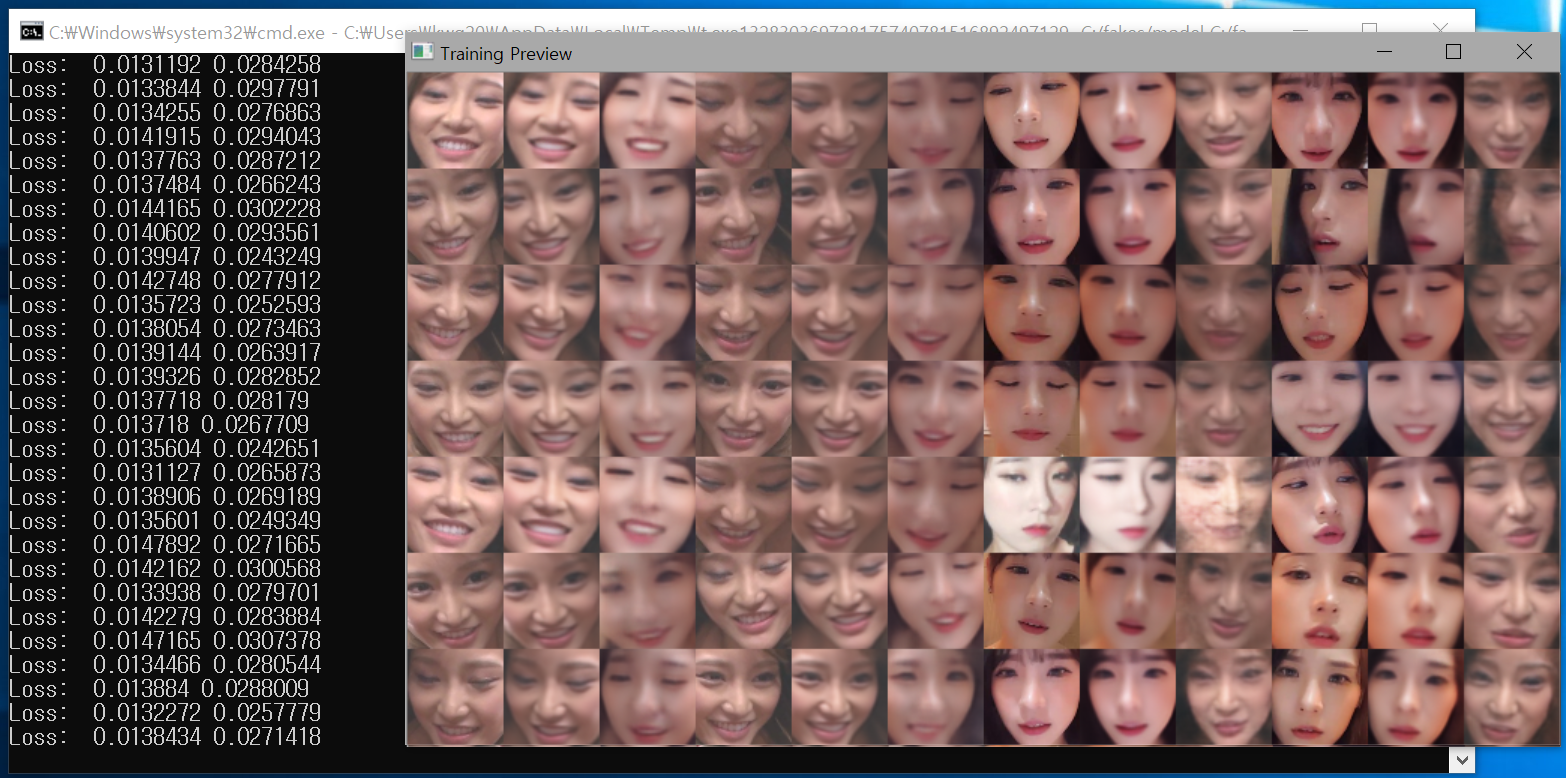

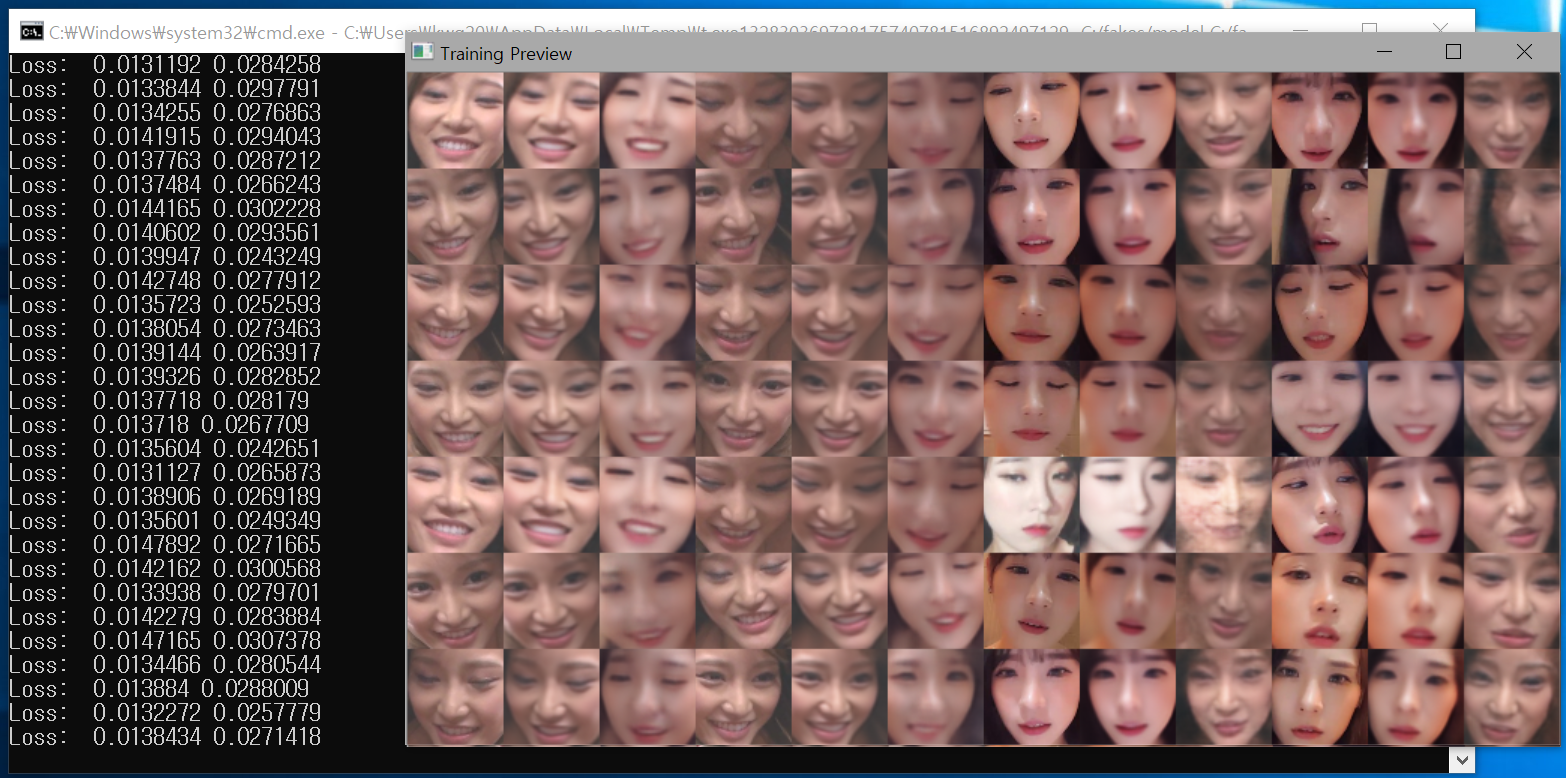

A deepfake technológia 2017 decemberében került először a figyelem középpontjába, ekkor egy DeepFakes nevű Reddit-felhasználó különböző hírességek arcát illesztette be pornóvideókba, méghozzá nem a megszokott trükkök alkalmazásával, hanem mesterséges intelligencia felhasználásával. Ma pedig már arról vitatkoznak a technológiában jártas kutatók, vajon már a 2018. novemberi amerikai időközi választás kampányában bevetik-e a deepfake-et.

Bár a szót eredetileg kifejezetten a hamisított pornográf videókra és fotókra alkalmazták, a technológiát számtalan területen használják a sima arccserétől a hamis szinkronig – a legnagyobb veszélye pedig abban rejlik, hogy széles körben hozzáférhető, így a kutatók attól tartanak, hogy hamarosan mozdulni sem tudunk majd az internetet elárasztó hamisítványoktól.

A több kutató által is elfogadott definíció szerint a deepfake mesterséges intelligencia felhasználásával készül és potenciálisan félrevezető – attól függetlenül, hogy az alkotó propagandacéllal vagy akár csak viccből készítette a kérdéses videót. Hany Farid, a Dartmouth College digitális helyszínelője szerint a technika legnagyobb veszélye nem is abban rejlik, hogy mit hamisítanak, hanem abban, hogy többé már a szemünknek sem hihetünk: hiába látjuk és halljuk például, hogy egy politikus nyilatkozik valamit, később simán letagadhatja arra hivatkozva, hogy csak egy újabb deepfake-videót láttunk, nincs itt semmi látnivaló.

Aviv Ovadya egykori startup-szabadúszó, a Michigani Egyetem közösségi oldalak társadalmi felelősségét vizsgáló intézetének kutatója másban látja a technika veszélyét: szerinte elég, ha csak hihetőnek tűnik egy olyan felvétel, amelyben például Trump hadat üzen Oroszországnak, az már beláthatatlan következményekkel járhat.

A tét kicsi, de nagy

A kérdés csak az, hogy miért nem lepték még el a közösségi médiát a manipulált felvételek – mondja Tim Hwang, az MIT mesterségesintelligencia-kutatója, aki szerint a technológia előbb-utóbb biztosan eljut a politikáig, csak az a kérdés, hogy mikor. A korábban a Google AI-programjában dolgozó szakértő szerint a deepfake 2020-ra jut el arra a szintre, hogy komoly manipulatív erőt képviseljen az elnökválasztási kampány során, és egy koktélban fogad arra, hogy az idei amerikai időközi választásokon még nem találkozhatunk a profi, ám hamis kampányvideókkal.

Jack Clark, az OpenAI kommunikációs igazgatója osztja Hwang véleményét, szerinte a mostani eszközökkel még viszonylag drága és bonyolult lenne egy komolyan vehető deepfake-videó legyártása. Így Clark is arra tippel, hogy a 2018. novemberi időközin még nem játszik szerepet a videómanipulálás. Szavazatával egy Manhattan koktélt kockáztat: ezt ajánlották fel ugyanis azoknak, akik szerint a deepfake-bomba már 2018-ban robbanhat az USA-ban. Azok pedig, akik szerint még várnunk kell a deepfake-invázióra, egy tiki típusú koktélra számíthatnak.

Annak, hogy az igen szavazatok nyerjenek, egész konkrét feltételeket szabtak a fogadó felek: készüljön olyan deefake videó az egyik jelöltről, amelyet az év végéig legalább kétmillióan megnéznek.

Clark szerint a legnagyobb veszélyt nem a profik jelentik, hanem az internet unatkozó népe. Mihelyst szélesebb körben hozzáférhetővé válik a deepfake videók készítéséhez szükséges technika – és az Adobe hamarosan el is készül az ingyenes videó- és fénykép-manipuláló szoftverével –, nincs megállás, egy-egy hamisítvány ugyanolyan sebességgel járja majd be a netet, mint a mai mémek.

Akik nem pislognak

A fenyegetés olyannyira valós, hogy az Egyesült Államok Védelmi Minisztériumának kutatásokért felelős részlege, a DARPA külön programot szervezett a deepfake-videók és az egyéb félrevezető felvételek kiszűrésére. A New York Állami Egyetem szintén mesterséges intelligenciával próbálja felvenni a harcot a deepfake ellen: az intézmény által fejlesztett program a szereplők pislogása alapján próbálja lebuktatni a hamisítványokat (a deepfake-videók szereplői ugyanis nem pislognak).

Miután a jelenséggel kapcsolatosan a szakértők is bizonytalanok (nehéz pontosan meghatározni, hogy mi is az a deepfake), a jogi szabályozás körül is akadnak még kérdések: Clark szerint először is párbeszédre van szükség, csak utána lehet szankciókról beszélni, az elhamarkodott szabályozás ugyanis több kárt okozna, mint amennyi hasznot hajtana.

Rebecca Crootof, a Yale jogásza szerint a jognak is inkább az egyedi esetekre kell koncentrálnia, különben lehetséges, hogy a nagy deepfake-vadászat közepette nem a megfelelő esetekben intézekednek majd – mindeközben pedig tiszteletben kell tartani a szólásszabadsághoz való jogot is. Tegyük föl, hogy valakiről elterjed egy manipulált videó, és eljárást indít a készítője ellen, aki viszont arra hivatkozik, hogy pusztán egy politikai karikatúrát állított elő, amelyhez az amerikai alkotmány első kiegészítése értelmében minden joga meg is van. A videó főszereplőjévé tett illető azzal vághat vissza, hogy a deepfake hitelrontó – Crootof álláspontja szerint ez többet nyom a latba, mint a szólásszabadsághoz való jog, mivel a videó készítője tudta, hogy valótlanságot terjeszt.

A deepfake technológia által egy színész teljes kontroll alatt tudja tartani a célszemély arcát, ahogy az alábbi videóból kiderül. A Stanford által készített összeállításban a legéletszerűbb deepfake portrék közül válogattak:

Az oroszok már a spájzban vannak

Miközben Hwang és társai találgatják, mikor indulhat be teljes gőzzel a deepfake-offenzíva, az orosz trollok már rá is találtak az új eszközre, és nem félnek használni. Májusban röppentek fel az első hírek, amelyek brit hírszerzési forrásokra hivatkozva azt állították, hogy a Kreml-közeli hackerek következő húzása a deepfake bevetése lesz – csak az a kérdés, hogy hol.

Michael Horowitz, a Pennsylvaniai Egyetem politológusprofesszora szerint is lehetetlen, hogy Oroszország kihagyja ezt az alkalmat – kérdés, hogy hogy jut el a célközönséghez, ugyanis az efféle videók közzétételét a Facebook mellett a Reddit és a Pornhub is tiltja. Walter Scheirer, az University of Notre Dame kutatója szerint szabályos fegyverkezési verseny folyik a DARPA és a trollok között, Hany Farid pedig egyenesen úgy fogalmaz, hogy az állami programban részt vevők egyenesen a demokráciát védik egy olyan világban, ahol az ember már a saját szemének sem hihet többé.

Az egészséges kétely

De mi lehet a megoldás? Farid óva int attól, hogy minden bizalmunkat a technikába vessük: igaz, hogy a technika ellen mindig a technikával veszik fel a harcot, de ebben a tények utáni világban a felhasználóknak is meg kell változatniuk a médiafogyasztási szokásaikat. A kutató szerint a Facebookon megosztott cikkek nyolcvan százalékának csak a címét olvassák, így nagyon valószínű, hogy az emberek többségének meg sem fordul a fejében, hogy az a videó, amit esetleg néz, talán egy ismeretlen troll munkája.

Michael Zollhöfer, a deepfake-videókat pislogás alapján kiszűrő Deep Video Portraits egyik fejlesztője több más kutatóhoz hasonlóan a tájékoztatásban látja a megoldást: ha több emberhez eljut, mikre képes ma már a videószerkesztés, talán kevesebben is dőlnek majd be a manipulált felvételeknek.

Hogy mi a deepfake, arról az alábbi cikkben írtunk bővebben.

2018: a deepfake éve, a valóság vége

A kép-és videóhamisításra használt deepfake technológia odáig jutott, hogy egyes szakértők már információs apokalipszist emlegetnek. A kamu felvételek elterjedése felrúgja azt alapigazságot, miszerint ha másnak nem, legalább a szemünknek hihetünk. Miközben még nincs igazi megoldás a problémára, a mesterséges intelligencia vadul fejlődik tovább.