Faék egyszerűségű trükkökkel átverhető a mesterséges intelligencia, és ez nagyobb baj, mint gondolnád

Több Tesla kamerarendszerét is sikerült úgy manipulálni hackereknek nemrég, hogy veszélyes gyorsulásra késztessék az önvezető autókat, írta az MIT Technology Review.

A McAfee kiberbiztonsági cég munkatársai a járművek Mobileye EyeQ3 kamerarendszerét verték át azzal, hogy a sofőrök számára szinte észrevehetetlenül megváltoztatták az út mentén elhelyezett, sebességkorlátozást jelző táblát. Egy az algoritmust megzavaró, apró matricát ragasztottak a jelzésre, amely így téves információt küldött a Tesla távvezérlő rendszerébe. Ez a módszer nem csupán az önvezető autókat, hanem arcfelismerő vagy éppen röntgenképeket elemző programokat is képes félrevezetni – ez pedig könnyen romba döntheti az algoritmusok tévedhetetlenségéről szőtt álmokat.

Megvezetett önvezetők

A gépi tanulással fejlődő, „szűk” mesterséges intelligencia (narrow artificial intelligence – ANI) elérését célzó algoritmusok kitűnően működnek, ha nagy mennyiségű adat különféle szempontok szerinti kategorizálásáról vagy csoportosításáról van szó, tudásuk azonban meglehetősen korlátozott, ha valós körülmények közé kerülnek – és így bizonyos trükkökkel könnyen átverhetővé válnak. A fenti példában egy aprócska, szinte észrevehetetlen matrica elég volt, hogy a sebességkorlátozást 35 mérföld/óra helyett 85 mérföld/órának olvassa le a kamera – és a tesztelt Teslák mindegyike ennek megfelelően növelte sebességét. Ez azonban csupán egy a számtalan hasonló példából.

2019 márciusában a Tencent Keen Security Lab tett közzé jelentést arról, hogyan sikerült egy Teslát sávváltásra késztetni és így a forgalommal szembe irányítani – pusztán azzal, hogy három egyenes vonalat képező matricát helyeztek el az úton. A jármű robotpilóta-rendszere, amely gépi képfeldolgozáson és -elemzésen, vagyis gépi látáson (machine vision) alapul, a matricákat felismerve a helyzetet úgy értékelte, hogy a sáv balra tart, így arra irányította az autót. Ez valós körülmények között akár balesetet is okozhatott volna – milyen szerencse, hogy itt csupán azt tesztelték, mennyire biztonságosak az önvezető autók algoritmikus rendszerei.

Pszichedelikus csalások

Nemcsak az önvezető autók gépi látáson alapuló algoritmusait lehet megtéveszteni különféle, a fizikai környezetbe gondosan elhelyezett tárgyakkal, hanem az ugyanezen a technológián alapuló arcfelismerő szoftvereket is. Persze ez csak bizonyos algoritmusok esetén működik bizonyos típusú megtévesztő eszközökkel, szóval ha René Magritte Az ember fia című képén látható módon egy alma mögé bújunk, attól még beazonosíthat minket egy adott beléptető rendszer, és nem fog pandának nézni a biztonsági kamera. No de mi van akkor, ha pszichedelikus mintájú szemüveggel próbálkozunk?

A Carnegie Mellon University kutatói 2016-ban megmutatták, hogy különleges mintázatú szemüvegkeretekkel átverhetőek bizonyos arcfelismerő szoftverek. Segítségével nem csupán képesek voltak eltűnni az algoritmus elől, de kiadhatták magukat valaki másnak, például hollywoodi celebeknek is. Egy másik alkalommal pólót vetett be a Leuveni Katolikus Egyetem fejlesztőinek egy csoportja: 2019-ben nyilvánosságra hozott tanulmányukban arról írnak, hogyan sikerült a biztonsági kamerák előtt gyakorlatilag láthatatlanná tenniük magukat néhány ügyesen tervezett póló segítségével.

Az MIT kutatói 2017 novemberében pedig arra világítottak rá, hogy ha 3D-nyomtatóval létrehoznak egy megfelelő mintázatú tárgyat, akkor azt is elérhetik, hogy a tárgyfelismerő algoritmus fegyverként osztályozzon egy játék teknőst, vagy baseball-labdaként egy csésze eszpresszót – függetlenül attól, hogy milyen szögből vizsgálja meg az adott tárgyat a szoftver.

Ellenséges példák a láthatáron

Ezek mind-mind a gépi tanulással fejlődő algoritmusok becsapására létrehozott adverzális, azaz ellenséges példák (adversarial examples) közé tartozó esetek, amelyekkel kifejezetten azért kísérleteznek a biztonsági résekre vadászók, hogy például ne terroristáknak jusson eszükbe görögdinnyeként klasszifikáltatni a bombáikat a reptéren, hanem még az előtt létezzen hatékony megoldás az ilyen hibák kiszűrésére, hogy a biztonsági résekről szóló tudás széles körben elérhetővé válna.

Ezekkel a példákkal 2004-ben kezdtek el kísérletezni a spamekkel összefüggésben: azt vizsgálták, hogyan próbálják megkerülni a szűrőket a levélszemetelők. Azóta a kutatók a gépi látástól a természetes nyelvfeldolgozáson (natural language processing) át számtalan fajtájú tanuló algoritmus és adattípus esetén megmutatták, milyen ellenséges példával lehet elgáncsolni ezeket a szoftvereket.

Ebben időnként olyan cégek is segítenek, mint a Google. A Berkeley Egyetem egyik kutatócsoportja például a techóriással együttműködésben azt vizsgálta meg, hogy át lehet-e verni az e-mailekből automatikus válaszleveleket generáló algoritmusokat. A kísérletből az derült ki, hogy természetesen át lehet, nem is akárhogy: a megfelelő üzenetek hatására az algoritmus olyan érzékeny adatokkal is előrukkolt, mint a hitelkártyaadatok. Ezeket az eredményeket aztán a Google arra használta fel, hogy biztonságosabbá tegye a Gmail Okos Levélírás (Smart Compose) funkcióját.

Bőrgyógyászati algoritmusok veszélyben

Ezek az ellenséges példák újabban már megjelentek az egészségügyben is, ahol az utóbbi időben gombamód szaporodnak a gépi látáson és természetes nyelvfeldolgozáson alapuló algoritmusok. A mások mellett a Harvard Medical School és az MIT kutatóiból álló kutatócsoport tavaly márciusi tanulmányában például három példát vizsgált meg, ahol az orvosi képalkotás folyamatában algoritmusokat alkalmaztak különféle feladatokra: a diabéteszes retinopátia retinaképekből, a légmell (pneumothorax) mellkasröntgenekből és a melanóma bőrről készült felvételekből történő kiszűrésére. Ha a kutatók az emberi szemnek alig észrevehetően módosították a felvételek pixeleit, a szoftverek rosszul osztályozták ezeket a képeket. Hozzátették, hogy ezek a támadások bármelyik hasonló kép esetén ugyanúgy működnek, és már közvetlenül a képalkotási folyamatba is beépíthetőek.

A Science folyóiratban megjelent tanulmányban azt is kifejtik, mennyire könnyen ki lehet használni az orvosi algoritmusok elleni támadásokat. Vegyünk egy anyajegyeket osztályozó bőrgyógyászati algoritmust, amely tesztkörnyezetben 99 százalékos bizonyossággal képes megjelölni, melyik anyajegy ártalmatlan, és melyik mutat kóros elváltozásokat. Ha trükközés hatására az algoritmus 100 százalékos bizonyossággal azt állítaná, hogy az elváltozás kóros, akkor a beteg és az orvos például sikeresen jelentkezhetne a biztosítónál, hogy az megtérítse a rosszindulatú melanóma kezelésének árát.

Mindenesetre a kutatók szerint a képekhez mesterségesen hozzáadott zaj egyáltalán nem generálható random módon, és elképesztően kicsi annak a valószínűsége, hogy valaki véletlenül sikeresen létrehozzon egy ellenséges példát. Tehát ezek létezése nem azt jelenti, hogy a gépi tanulási modellek alapjában véve pontatlanok vagy megbízhatatlanok, hanem inkább azt, hogy tudatos manipulációval megtéveszthetők – ez pedig aggodalomra adhat okot.

Egyelőre nem tudunk arról, hogy efféle ellenséges példákon keresztül megtámadtak volna orvosi vagy más szektorban fejlesztett szoftvereket, ám ha ezeket a biztonsági réseket a fejlesztők nem tömik be hamarosan, ez talán csak idő kérdése.

Kapcsolódó cikkek a Qubiten:

Már a mesterséges intelligencia is előítéletes, és ez az ember hibája

A diszkrimináció emberi hagyományát egyelőre a teljesen racionális algoritmusok is folytatják. Miért érdemes tenni ez ellen, és miért nehéz elérni, hogy a gép mindenkit egyenlő bánásmódban részesítsen?

A mesterséges intelligenciának fogalma sincs arról, hogy mi az a fogalom

A jog és akár a politika is megérett arra, hogy automatizálással segítsük a problémák megoldását, de ezekben már nyilvánvalóan a nyelvnek is fontos szerepe van. Sajnos a nyelvtudomány olyan lemaradásban van, hogy ezek a területek egyelőre a tudományos fantasztikum világához tartoznak, írja Kálmán László, az MTA munkatársa.

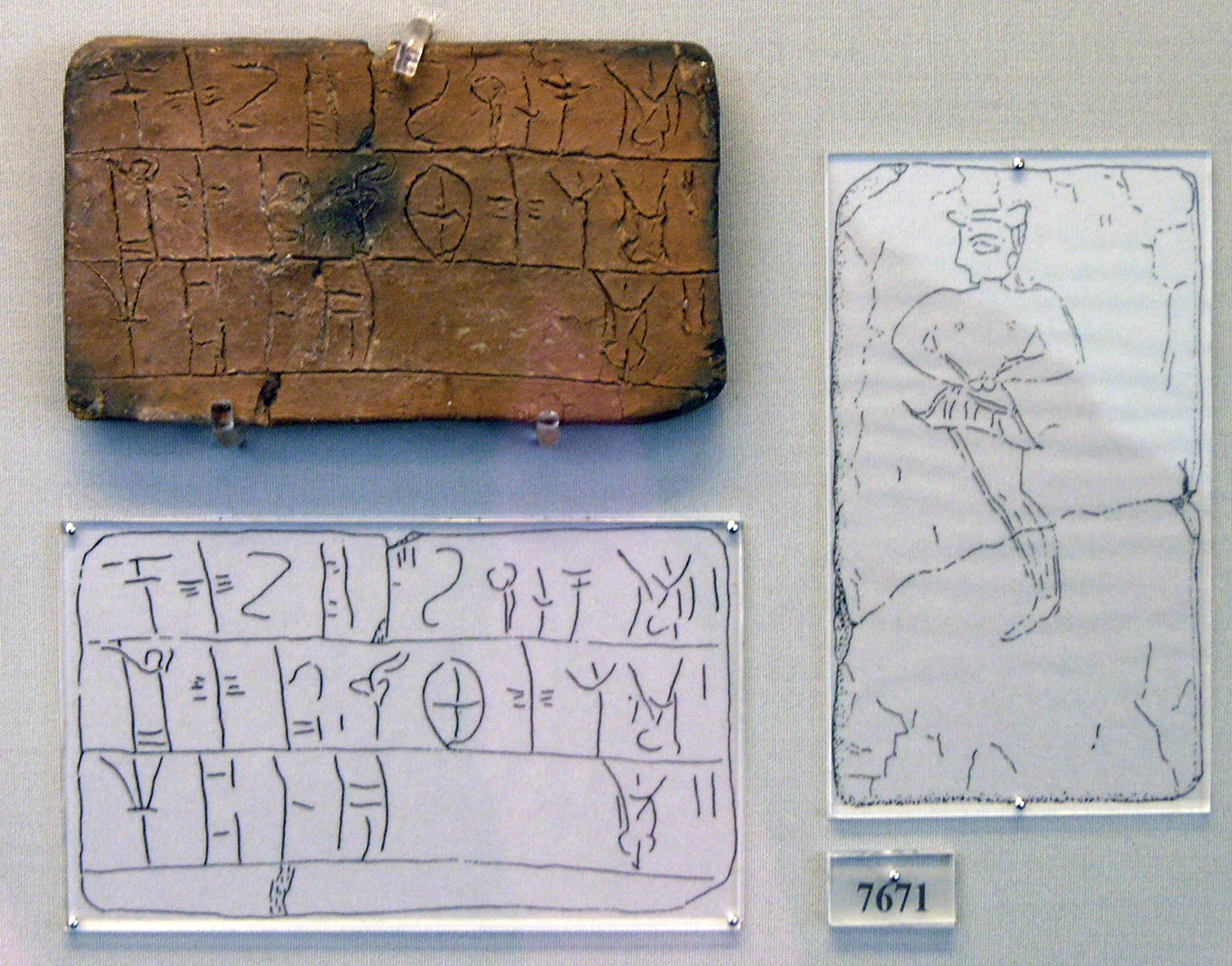

A mesterséges intelligencia megfejtett egy elfeledett ősi nyelvet

Az egyre pontosabb gépi fordítás már nemcsak angolról magyarra működik, de ismeretlen nyelveket is képes kezelni. Amerikai kutatók először fejtettek meg automatikusan egy több mint 3000 éves nyelvet.