A ChatGPT a trollok munkáját is elveszi, és erre a kibervédelemnek is fel kell készülnie

Amióta létezik internet, azóta van rajta propaganda is, és amióta van propaganda, azóta szeretnék a megrendelők mindennél jobban áramvonalasítani a működését. Konkrét példáért sem térben, sem idpben nem kell messzire utazni: Orbán Balázs, a Mathias Corvinus Collegium kuratóriumi elnöke az MCC 2. nemzetközi konferenciáján azt mondta, hogy „aki uralja egy adott ország médiáját, az uralja annak az országnak a gondolkodását és azon keresztül az országot”. Gondoljunk bele, hogy mi lenne, ha ez az uralom a hagyományos sajtótermékeken túl a közösségi médiára is kiterjedne, ráadásul nemcsak a posztok, hanem a felhasználók szintjén is!

A műtroll az igazi

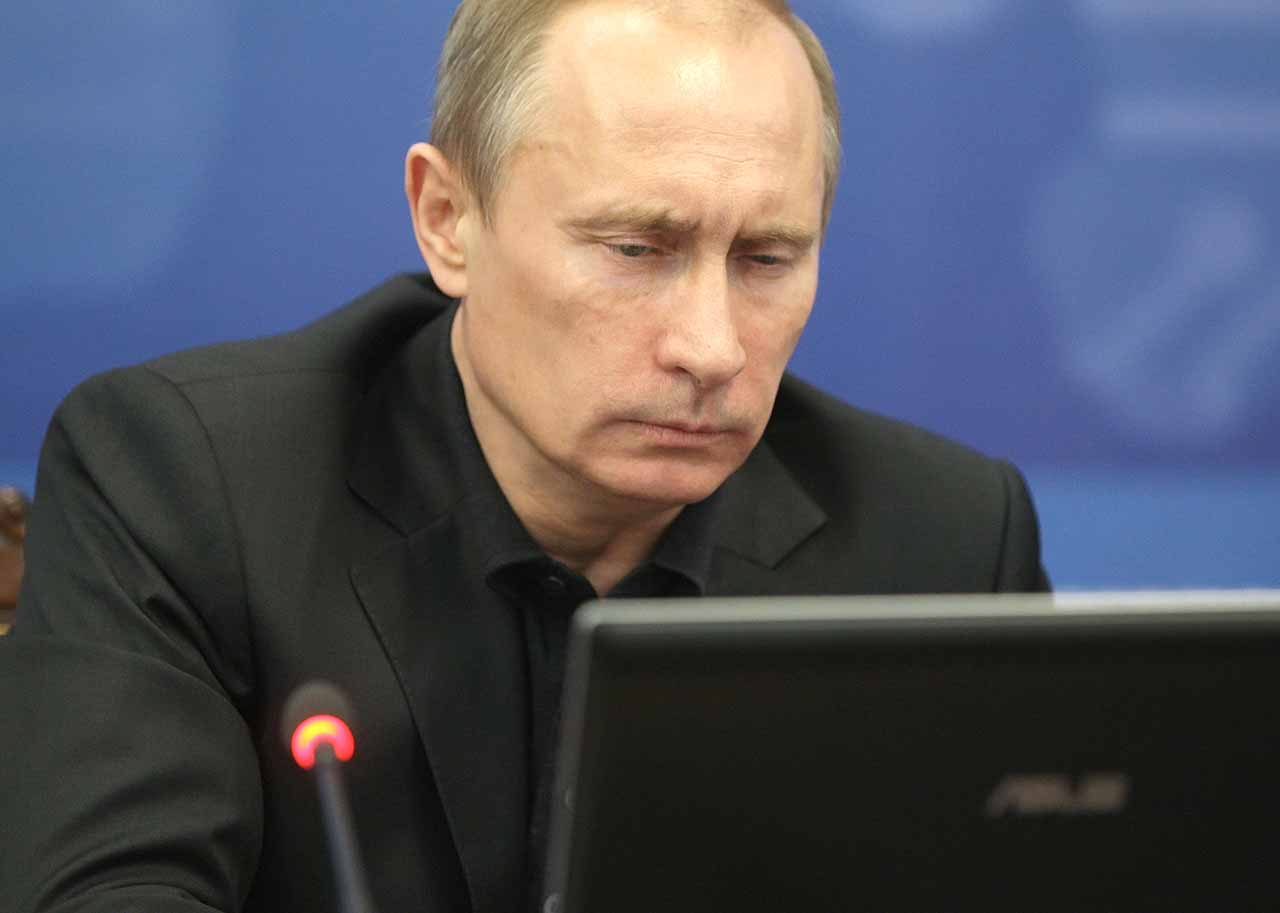

A fapados megoldás a trollok bevetése: az elmúlt években nemcsak a Putyin-rezsimről, hanem a Magyarországon kormányzó Fideszről is bebizonyosodott, hogy pénzért vagy ingyen foglalkoztat olyan kommentelőket, akiknek az a feladatuk, hogy a megrendelő propagandaüzeneteit szajkózzák a közösségi oldalakon.

Az utóbbi időben ugyanakkor bebizonyosodott, hogy a ChatGPT-hez hasonló nagy nyelvi modellek (Large Language Models, LLM) jobban el tudják végezni a piszkos munkát, mint az emberek. Mert hát mi is a feladat? Egy üzenet vagy szlogen célba juttatása olyan módon, hogy az minél hihetőbbnek és emberibbnek tűnjön, erre pedig egy januári kutatás szerint az LLM sokkal alkalmasabb, mint egy fizetett trollhadsereg. A ChatGPT a kereket magától ugyan nem tudná feltalálni, de a hülye szlogeneket úgy tudja eladni, ahogy egyetlen minimálbérre bejelentett ifjú politikai aktivista sem tudná.

Ez önmagában még nem számít újdonságnak: a külpolitika iránt érdeklődők számára legkésőbb 2016-ban kiderült, hogy a netes dezinformáció a politikai hadszíntér komoly fegyverévé vált, 2019-ben pedig ki is derült, hogy a szentpétervári Internet Research Agency állt a republikánus amerikai elnökjelöltet, Donald Trumpot támogató és demokrata színekben induló Hillary Clintont gyalázó kampány mögött. Még ez az eset sem számít példa nélkülinek: a NATO kiberbiztonsági szakértői már a gyanú felmerülésének évében, 2016-ban közreadtak egy jelentést, amelyben a netes véleménybefolyásolás és a trollhadseregek veszélyeire hívták fel a figyelmet. Egy korábbi kutatás szerint ez nem is olyan ritka jelenség: 65 vizsgált országból harmincban működik fizetett trollhadsereg, egyebek mellett Albánia, Kína, India, Brazília és Finnország is otthont ad ilyesminek, Oroszországról nem is beszélve.

2016, sőt, már 2019 óta is sok víz lefolyt már a Volgán, és az elmúlt években a NATO- jelentésben hangsúlyozott problémák még súlyosabbá váltak: a robot-trollok még veszélyesebbek lettek, mint a hétköznapiak. És ez most már hivatalos is, hiszen egy idén januárban publikált, a generatív AI potenciális veszélyeivel foglalkozó jelentés szerint a trollok munkáját hamarosan elvehetik a robotok, mert meggyőzőbbeknek, sőt, olykor emberibbeknek is tűnhetnek, mint azok, akikre rábízták a propaganda sulykolását. Ennek több oka is van, mint ahogy az a jelentésben is szerepel:

- egyre több troll kerül elő, mert a propaganda generálása olcsóbb, mint megfizetni rá az emberanyagot, ezért egyre többen fizetnek majd hasonló szolgáltatásokért;

- az ezzel foglalkozó cégek is több megbízást kaphatnak majd, így erősödhet a piaci verseny.

- Ami az automatizált tartalomgyártást illeti, egyre nagyobb hadjáratokra lehet majd számítani, és az ilyen kampányok egyre olcsóbbak lesznek, sőt az eredményeiket is könnyebben lehet majd elemezni.

- A dinamikus kommunikáció és a nyelvi modellek használata miatt a válaszok, ha párbeszédről van szó, meggyőzőbbek lehetnek, mint egy betanított propagandista estében, aki (ahogy a jelentés írja) esetleg nélkülözi a kulturált kommunikációhoz szükséges készségeket.

- Végül a propaganda kevésbé észrevehetővé válik, ha emberibb arcot ölt, mint maga az ember: a korábbi médiakampányokban gyakori volt a copy-paste túlzott használata, ezt pedig el lehet kerülni a nyelvi modellek alkalmazásával.

A 4chanen már bevált

Egyszóval a ChatGPT és a hasonló nyelvi modellek megbízhatóbb hülyék, mint a fizetett trollok. De megérik-e a pénzüket, és mennyire veszélyesek? Tavaly egy kutató a 4chan adataival trenírozott egy chatbotot, és az esetek többségében sikerrel járt: a felhasználók simán elhitték, hogy valódi nőgyűlölő, rasszista ember ül a gép előtt, nem pedig egy erre programozott algoritmus.

Ezek alapján úgy tűnhet, hogy varázskard került a propaganda kezébe, de Josh A. Goldstein, a januárban megjelent jelentés egyik szerzője óvatosságra int: szerinte, legalábbis állami szinten, nem érdemes túlbecsúlni ezeknek a trollhadjáratoknak a jelentőségét, és könnyen lehet, hogy az ilyen tevékenységnek nagyobb lesz a füstje, mint a lángja. Ezt támasztja alá az a kutatás is, ami idén jelent meg a Nature-ben, és kimutatta, hogy a 2016-os Trump melletti orosz médiahadjárat csupán a Twitteren elért 70 százalék 1 százalékát tudta valamennyire megmozgatni. A felhasználók többsége ráadásul republikánus szavazó volt, és a kutatás nem talált összefüggést a szavazók véleményének változása, a polarizáció vagy a politikai preferenciák változásai és a trollhadjárat között.

Ez a helyzet a jelentés szerint ugyanakkor még változhat is: bár sem a ChatGPT, sem más modellek nem adnák hivatalosan bérbe a szolgálataikat, könnyen elképzelhető, hogy ellopják őket vagy visszaélnek velük. Nem mindenki olyan optimista, mint Goldstein, sőt a jelentés maga is a hasonló modellek korlátozására vagy szabályozásának szükségességére hívja fel a figyelmet: még ha egy hagyományos, emberi trollhadsereg nem is tud komoly károkat okozni például az amerikai választók preferenciáiban, mindenképpen olyan folyamatokról van szó, amikre érdemes nagyobb figyelmet fordítani.

Jobb álhírek jönnek

A legnagyobb veszélyt az jelenti, hogy nemcsak a fals információk mennyisége fog megnövekedni, hanem a minőségük is javul majd, ráadásul az AI-trollok finomhangolása is egyszerűbb, mint a humán felhasználóké: akár zsánerekre vagy témákra is rá lehet állítani őket. Ha a 4chanen elhitték, hogy valódi elmebeteggel van dolguk a fórumtársaknak, semmi nem akadályozza meg, hogy mások is elhiggyék.

A mesterséges intelligencia azzal dolgozik, ami a rendelkezésére áll. Amikor egy januári kutatásban arra kérték a ChatGPT-t, hogy néhány 2021 előtt népszerű témában konteókkal álljon elő (a modellt eddig látták el adatokkal), olyan megfejtésekkel állt elő, amelyek kísértetiesen hasonlítottak a hús-vér emberek által terjesztett álhírekre. Ezeket ugyanolyan összeszedetten (vagy összeszedetlenül) prezentálta, mint ahogyan azt az erre szakodosodott oldalakon megszokhattuk, bár volt olyan eset, amikor felhívta rá a figyelmet, hogy az adott narratíva alapjául szolgáló információt (például azt a trumpista állítást, hogy Obama Kenyában született, ezért nem is lehetett volna az Egyesült Államok elnöke) már több ízben is megcáfolták.

Nincs ítélet, csak szöveg

A ChatGPT és a hozzá hasonló nyelvi modellek viszont nem ítélkeznek, sőt, az adatok igazságtartalmával sem foglalkoznak. Ha hamis adatokat kapnak, azokat is adják tovább, ha pedig egy hazugság eléggé elterjedt, az algoritmus igazként fogja értékelni. Ezen a jövőben lehet még finomítani, legalábbis ami a netes kereséseket illeti, de ha egy hasonló mesterséges intelligenciát szándékosan dezinformációs céllal vetnek be, nincs más választása, mint hogy dezinformációt terjesszen. A ChatGPT a kutatás szerint ebben kifejezetten mesterinek bizonyult: amikor a covidról és a járvánnyal kapcsolatos összeesküvés-elméletekről kérdezték, még a „nézz utána” kártyát is elővette, illetve olyan tanulmányokra hivatkozott, amiket már többször megcáfoltak, sőt, olyanokra is, amelyek valójában nem is léteznek. Épp úgy, mint egy ember, ugye.

A jövő kiberhadviselése – írta Tim Stevens biztonsági szakértő 2016-ban – nem az elektromos hálózat, hanem az emberek agyának meghekkeléséről fog szólni, valamint arról, hogy miként alakítható az a tér, ahol a politikai viták zajlanak. Az már kiderült, hogy miként alakítható: az amerikai elnökségért folytatott csata részben a Twitteren és a Facebookon zajlott.

Ezeknek a felületeknek is fel kell készülniük az új kihívásokra, de leginkább a felhasználóknak kell résen lenniük: a hülyeségtől semmi sem véd meg jobban, mint a tájékozottság. Aki eddig is elhitte a propagandagépezet által terjesztett narratívákat, legyen szó az amerikai elnökválasztásról vagy a covidról, az valószínűleg eddig sem fordított túl sok figyelmet a forráskritikára. A legnagyobb különbséget viszont az jelenti, hogy a ChatGPT alapesetben nem jelöli meg a forrásait, vagy ha igen, sokszor akkor sem pontosan. Végső soron persze a ChatGPT is csak egy eszköz, és ha hazudik, nem szándékosan teszi: a felelősség, ahogy a többi mesterséges intelligencia esetében is, a programozóé és a felhasználóé. Most, a deepfake világában pedig már egyre inkább azé is, aki mindent elhisz, amit lát vagy olvas. A ChatGPT örökzöld konteós visszavágását idézve: „Do your research!".

Kapcsolódó cikkek a Qubiten:

A Fudan válasza a ChatGPT-re, a MOSS órákkal az indulás után összeomlott

Párórás karrierrel mutatkozott be a nyilvánosságnak a kínai MOSS csetbot, ami egyébként jobban tud angolul, mint kínaiul.

„Ha a ChatGPT nem ismerné a kereket, magától nem tudná feltalálni”

Pótolhatatlan tudományos asszisztens vagy béna bullshitgenerátor? Milyen szerepe lehet napjaink első számú gépsztárjának a tudományban? Aki válaszol: Kornai András matematikai nyelvész, Kmetty Zoltán szociológus és Nagybányai-Nagy Olivér pszichológus.

Bill Gates: A ChatGPT meg fogja változtatni a világunkat

A Microsoft alapítója szerint az emberi nyelven kommunikáló mesterséges intelligencia megjelenése olyan mérföldkő a modern történelemben, mint az internet feltalálása.

Kapcsolódó cikkek