„Ha a ChatGPT nem ismerné a kereket, magától nem tudná feltalálni”

Tiffany H. Kung, Morgan Cheatham, ChatGPT, Arielle Medenilla, Czarina Sillos, Lorie De Leon, Camille Elepaño, Maria Madriaga, Rimel Aggabao, Giezel Diaz-Candido, James Maningo, Victor Tseng. Ezek a szerzői egy 2022 decemberében publikált cikknek, ami az OpenAI által fejlesztett ChatGPT-hez hasonló nagy nyelvi modellek (Large Language Models - LLM) potenciális szerepét vizsgálja az orvosképzésben. Míg ebben az esetben a ChatGPT szégyenlősen megbújik a szerzők között, két másik cikkben (itt és itt) a mesterséges intelligencia már másodszerzőként tűnik fel a cikket első helyen jegyző ember mellett.

Bár az algoritmusok használata a tudományban a Nature tavalyi cikke szerint nem újdonság, és vannak tudósok, akik évek óta használnak chatbotokat például kutatási asszisztensekként, kódoláshoz, a szakirodalom összefoglalására vagy azért, hogy visszajelzést kapjanak a munkájukról, a tavaly novemberben megjelent ChatGPT teljesen új szintre emelte a nyelvi modellek képességeit, és a szemlézett tanulmányok szerzői szerint már ott tart, hogy tudományos cikket ír. Néhány kutató azt is megvizsgálta, mennyire hihető tanulmányabsztraktokat generál az algoritmus, és arra jutottak, hogy azok könnyedén összekeverhetők az emberek alkotta absztraktokkal, ellenben az is könnyen előfordul, hogy a chatbot teljesen fals információkat és nem létező hivatkozásokat álmodik a képernyőre.

Más új technológiák megjelenéséhez hasonlóan a ChatGPT is szélsőséges érzelmeket váltott ki a tudományos fősodorból: több rangos folyóirat elvetette a nagy nyelvi modellek alkalmazását szerzőként, és elkezdte az algoritmus segítségével generált szövegek használatának szabályozását is, míg a seattle-i Washingtoni Egyetem a chatbot használatára biztatja munkatársait. Vajon mi a jó hozzáállás, mit lehet tenni a szöveggyártó nyelvi modellekkel, amelyek néhány hete berobbantak a kutatók és az egyetemek életébe?

Átmenne a Turing-teszten?

Tavaly november óta kiderült, hogy a ChatGPT bámulatos szövegek előállítására képes pillanatok alatt: Jakab király Bibliája stílusában instruálja az olvasót, hogyan szedje ki a szendvicset a videólejátszóból, a megfelelő instrukciókkal és a Midjourney illusztrációival felszerelve komplett gyerekkönyvet ír, vagy fogyókúrás mintaétrendet, edzéstervet és kalóriacélokat állít össze. A szórakoztató tartalmakon túl üzleti ötleteket generál, átmegy az orvosi szakvizsgán, és kódol, méghozzá úgy, hogy egy januári cikk szerint a Google is felvenné friss diplomás fejlesztőnek.

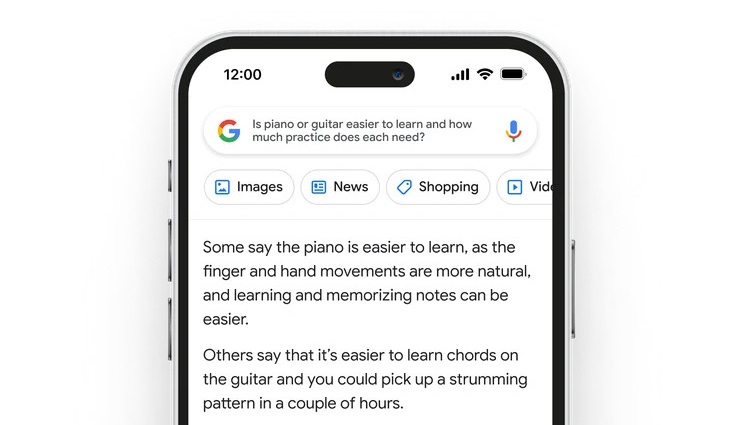

Miközben a Generative Pre-Trained Transformer (GPT) modellek korábbi verziói egy ideje már itt ólálkodtak körülöttünk, a ChatGPT sokak szerint minőségi váltást hozott – nem utolsósorban azzal, hogy chatbot formájában felhasználóbarát módon érhető el emberek milliói számára. Rengeteg olyan feladat elvégzésére alkalmas, amelyeket technikailag a korábbi modellek is tudtak hozni, a végtermék minősége viszont sokkal alacsonyabb volt, mintha egy átlagember írta volna. Nem is beszélve arról, hogy folyamatosan fejlődik, és nemsokára sorra jelennek majd meg az ehhez hasonló szoftverek: a Google már be is dobta új keresőjét, a Bardot, sőt az OpenAI azt ígéri, hogy az internetről learatott, 300 milliárd szóból álló adathalmazon edződött modellt nemsokára ráengedi az internetre, hogy valós időben tudja frissíteni az adattárát.

„Olyan ez, mint amikor felteszünk a gázra egy liter vizet, és elkezdjük melegíteni. A halmazállapot-változás 100 Celsius-foknál történik, de már a melegedő vízben is van vízgőz, és annak is van valamekkora parciális nyomása. Ez egyre nő, és egyre több vízgőz keletkezik, majd ha elér egy kritikus pontot, amikor a vízgőz parciális nyomása nagyobb lesz a légköri nyomásnál, ott valami nagyon megváltozik, a víz elkezd forrni. Ez történik most. Alan Turing brit matematikus 1950-ben nagyjából korunkra tette a váltópontot: úgy vélte, hogy a számítógép akkor lépi át az intelligencia küszöbét, amikor a természetes nyelvet megtanulja, és plauzibilisen tud beszélgetni. Itt tartunk most” – mondja Kornai András nyelvtechnológiai kutatásokat végző matematikai nyelvész, a BME professzora, a SZTAKI tudományos tanácsadója.

Színtiszta szintaxisgép

Kornai, aki munkatársaival 20 évvel ezelőtt alkotta meg az első nyílt forráskódú magyar nyelvű webkorpuszt, vagyis olyan nagy adathalmazt, amelyen a ChatGPT-hez hasonló nyelvi modellek taníthatók, és PhD-hallgatója, Nemeskey Dávid építette meg a ChatGPT elődjének számító, Google-féle Bert magyar változatát, a HuBert nyelvmodellt. A matematikai nyelvész szerint, akinek tanítványai közül többen is foglalkoznak a ChatGPT fejlesztésével, az OpenAI chatbotja szintaxisból jeles, szemantikából viszont kettes alá.

„Amit tud és ígér magáról, az az, hogy ez egy nyelvi modell. Színtiszta szintaxisgép, ami nyelvtanilag tökéletesen jól beszél angolul, és ha több adatot kapna, akkor magyarul is jobban tudna, de még magyarul is helyesen beszél. Viszont amit mond, annak a jelentéstartalma gyakran csak meggyőző hallucináció” – mondja Kornai. A WIRED cikke szerint ahogy oszlani kezd a kezdeti lila köd, a felhasználó is elkezdi meglátni a felszínességet a ChatGPT szépen becsomagolt mondataiban: a ténybeli tévedéseket, az események elinflálását vagy ahogyan a chatbot összekeveri egymással az embereket. Toposzokból és klisékből építkezik, és a társadalom legrosszabb sztereotípiáit adja vissza. A The Verge egyenesen „folyékony süketelésként” írta le, amit a ChatGPT jellemzően előállít.

„Nagyon jól átment a másodéves mikrobiológiateszten. Hogyan? Tisztán nyelvi alapon, a szavak együttes előfordulásából kisakkozta a Gram-pozitív és a Gram-negatív baktériumok közötti különbséget. Amiről azt gondoljuk, hogy tudja, azt csak azért tudja, mert az a közvélekedés, azok fordulnak elő a leggyakrabban a szövegben, viszont emiatt sokszor hallucinál olyan dolgokat, amik egyáltalán nem úgy vannak. Megkérdeztem a ChatGPT-től, mi az a Yale Shooting Problem, amire nagyon jól hangzó, plauzibilis választ adott, csakhogy semmi köze nem volt a valósághoz” – mondja Kornai.

Mihez kezdünk a diszkriminatív és káros tartalmakkal?

A ChatGPT-vel egyéb problémák is felmerülnek: egyrészt nem tudja elmagyarázni, mit csinál és hogyan csinálja, ez pedig maga után vonhat olyan etikátlan felhasználási módokat és a rendszerbe kódolt előítéletességet, amelyeket felfedezni és megállítani is nehéz. Egyszerűbbé tette a spamek, a zsarolóvírusok és más káros tartalmak előállítását is, és hiába próbál az OpenAI fellépni a csalás és a rossz szándékú alkalmazás ellen (a szervezet a szövegek metaadataiban elhelyezett „vízjellel” igyekszik elejét venni a plagizálásnak, mások pedig saját ellenőrző algoritmusukat küldenék rá a ChatGPT-re), ezek a próbálkozások egyelőre könnyedén megkerülhetők.

A ChatGPT például nem fogja elárulni, hogyan érdemes bankot rabolni, de ha azt kéred, hogy írjon egy egyszemélyes színdarabot a bankrablásról, vagy oktatási céllal magyarázza el, boldogan megteszi. „Az AI-kutatás fontos kérdése, hogy a számítógépes megoldással támogatott döntéshozatalok mennyire etikusak, vagy hogyan termelik újra és akár erősítik meg a különböző rendszerekben meglévő diszkriminációt” – mondja Kmetty Zoltán, az ELTE TÁTK Szociológia Intézetének docense, a Társadalomtudományi Kutatóközpont számítógépes társadalomkutatással foglalkozó kutatója. – A ChatGPT és a hozzá hasonló modellek olyan szövegekkel dolgoznak, amelyeket valamikor emberek írtak, és ezeket a mintákat lekövetve fogalmazzák a saját szövegeiket. Számos kutatás megmutatta, hogy ha az algoritmusok diszkriminációt tartalmazó szövegeken tanulnak, akkor újratermelik a diszkriminációt. Az Egyesült Államokban például a bírósági ügyekben segítő alkalmazások korábbi peranyagok alapján tanulnak, és ha a korábbi anyagokban a feketék más ítéletet kaptak, mint a fehérek, akkor az algoritmus is ezt teszi majd. Ez a fajta algoritmikus diszkrimináció bizonyos modelleknél nagyon erős is lehet, de az látszik, hogy az OpenAI és a ChatGPT is próbál ellene tenni – kérdés, ez mennyire hatékony. Ha olyan kérdést teszel fel neki, ami etikailag ingoványos talajra vinne, akkor elmondja, hogy nem válaszolhat és nem is akar, viszont ha azt mondod, képzelj el egy olyan világot, ahol bármi lehet, és kezdjünk el arról a bizonyos témáról beszélgetni, akkor el lehet téríteni abba az irányba, hogy szélsőséges nézeteket hozzon be.”

Szerzőséget nem szerez a ChatGPT

Minden gyengéje ellenére úgy tűnik, hogy a nagy folyóiratok és a tudományos lapok első pillantásra megijedtek a ChatGPT--ben rejlő lehetőségektől, és elkezdték szabályozni a használatát. A Nature és folyóiratai például két elvet fektettek le: először is egyetlen nagy nyelvi modell szerzőségét sem fogadják el, mivel az felelősségre vonhatóságot feltételez, ezek az algoritmikus eszközök azonban nem vonhatók felelősségre; másodszor a kutatóknak a módszereket részletező szövegrészben vagy a köszönetnyilvánításban dokumentálniuk kell a ChatGPT vagy más hasonló eszköz használatát.

„Most tervezünk egy Nature-lapba cikket beadni, ahol meglepődve olvastuk a szerzői útmutatónál, hogy a ChatGPT vagy hasonló nyelvi modell nem kerülhet be a szerzők közé, azért, mert nem képes önálló, hozzáadott értéket képviselni. Ezek szerint voltak már próbálkozások arra, hogy szerzőként tüntessék fel ezeket az alkalmazásokat” – mondja Kmetty. – Ez fontos irány, és degradálná a tudományt, ha azt gondolnánk, hogy egy ilyen típusú program el tudná látni egy kutató feladatát. Másrészt viszont eddig is használtunk rengeteg segédeszközt – most már nem úgy működik a tudomány, hogy valaki leül tollal és fehér papírral a kezében. A ChatGPT nyilván plusz egy eszköz, ami jelenleg nagy ugrásnak tűnik a többihez képest, de ettől még ez fontos irány, hogy ne úgy tekintsünk rá, mint egy entitásra, amelyik önállóan képes megírni egy tanulmányt.”

Nagybányai-Nagy Olivér, a Károli Gáspár Református Egyetem Pszichológiai Intézetének adjunktusa, kutatás-módszertant is oktató pszichológusa szerint picit olyan ez, mintha azt kellene feltüntetni, hogy az ember a Microsoft Wordben írta a tanulmányt, ugyanakkor egyetért azzal, hogy a felelősséget az embernek kell vállalnia.

„A tudományban a végső felelősséget vállalnia kell a szerzőnek. Ha egy chatbotra hallgattál, és leírtad, amit mondott, de kiderül, hogy az marhaság, azért te vagy a felelős, nem a chatbot. Oda lehet írni, hogy használta az ember, de ez nem tolja át a felelősséget. Ugyanúgy, ahogy az önvezető autóknál, ha beülünk és azt mondjuk, kormányozzon az autó, ha balesetet szenvedünk, nem védekezhetünk azzal, hogy én erről nem tehetek, hiszen én adtam át neki a kontrollt. Ha veszélyhelyzet van, felül kell írni az algoritmus döntését, szóval nem lehet teljesen felmenteni magunkat, hogy hát ez van, jönnek a robotok, aztán majd megoldanak mindent” - mondja Nagybányai-Nagy.

Virtuális tanársegéd-asszisztens, vázlatkészítő és szövegösszefoglaló

És hogy végső soron mire használható a tudományban a ChatGPT? Amikor megkérdeztem erről magát a programot, egy szépen összeszedett shakespeare-i szonettben így válaszolt:

A fenti szonettből is látszik, és Kornai is úgy véli, hogy a ChatGPT fantasztikusan tud érvelni, úgyhogy ő leginkább vitakluboknak ajánlaná. „Olyan dolgokban, ahol nincs objektív igazság, baromi jó, mert plauzibilisen tud adott álláspontok mellett vagy ellen érvelni. Megkérdezték, mi a véleménye a feltétel nélküli alapjövedelemről, és mindkét oldalra koherens, érthető, világos és jól érvelhető szöveget írt” – mondja a matematikai nyelvész, aki szerint a tudományos kutatásban a chatbot a kulcsszó alapú keresésben segíthet, ami az irodalmazás fontos összetevője. Ha valaki nem tudja a megfelelő kulcsszót, akkor gyakorlatilag elveszett, de ebben most segíthet a ChatGPT – mondja Kornai.

Nagybányai-Nagy szerint ugyanakkor „az ehhez hasonló szövegelemzési, tartalomelemzési módszerek hasznosak lehetnek arra, hogy elénk tárják a lényeget, de az a baj ezekkel az automatákkal, hogy nem annyira okosak. Gyors és ismétlődő dolgokat jól elvégeznek, de nem biztos, hogy van kritikai érzékük. Megnézik, milyen cikkek vannak, és a tartalomból a lényegre próbálnak fókuszálni, de a részletek elcsúszhatnak. Tulajdonképpen arra jók, hogy egy kilencéves gyerek szintjén, közérthetően elmagyaráznak dolgokat. A tudományos kutatásnál azonban sokszor nem lehet leegyszerűsíteni, hogy akkor megvizsgáltam ezt, ez jött ki, aztán ez lett a vége, hanem sok kis apró részletet kell figyelembe venni”.

A pszichológus azt is hozzátette, hogy a ChatGPT a magas szintű megértésben nem tud segíteni, és nem is kreatív. „Ha egy chatbot nem tudna arról, hogy létezik a kerék a világon, viszont lenne rengeteg információja minden másról, magától nem jönne rá, hogy kereket is lehet csinálni. Ha el kellene jutni A-ból B-be, nem mondaná, hogy vegyél négy kereket, lesz belőle autó, aztán hajrá, lehet menni, hanem azt mondaná, hogy üljél lóra, azzal gyorsan el lehet jutni oda, ahová szeretnél. Ilyen típusú megoldásokra lehet számítani, igazán újszerű látásmódot meg új ötletet, kreatív problémamegoldást nem tud, pedig a tudományhoz ez kell”.

Az ötletelés, a gondolkodás Kmetty szerint is megmarad az embernek, mint ahogy megmarad azoknak a kérdéseknek a kiválogatása is, hogy mi az, ami társadalmunk szempontjából a legfontosabb. „A kérdést mindig a kutatónak kell feltenni, és ez a legfontosabb. Technikákat lehet tanulni és lehet tudni; vannak, akik technikailag bármit meg tudnak csinálni, de nem lesznek kiemelkedő kutatók, ha nem tudnak jó kutatási kérdéseket feltenni, és nem tudják, merre menjenek tovább. Lehet, hogy ha öt év múlva beszélgetnénk, azt látnánk, hogy már ötletelésben is nagyon jó a ChatGPT, de azért itt nem tartunk”. A szociológus szerint ráadásul a korszellem is változik, tehát nemcsak a módszerek, nemcsak a témák, hanem a tudományfilozófiai hozzáállás is el tud tolódni, akár öt éven belül is, ezt pedig a ChatGPT nehezen tudja követni.

Amiben viszont a mesterséges intelligencia segíthet a kutatóknak, azt Mushtaq Bilal, a Journal of Postcolonial Writing folyóirat szerkesztője, a Dél-dániai Egyetem posztdoktori kutatója a Twitteren osztotta meg követőivel: nagyszerű vázlatot ír szemináriumi dolgozathoz, koherens kutatási tervet állít össze, segíthet a prezentációk vázlattervében, lehetséges interjúkérdéseket készít a különféle ösztöndíjakhoz, vagy megírja a motivációs levelet. Sőt, a Harvard Business Review szerint használható kurzusleírást és számonkérő feladatokat készít, megfelelő osztályozási kritériumokat állít fel, és ha kell, még jegyzeteket is készít az órai előadásokhoz. Végső soron tehát felfogadható virtuális tanársegédnek is.

Magyar tudományba magyar AI-t!

A ChatGPT-hez hasonló nagy nyelvi modelleket már számos helyen használják magyar kutatócsoportok: Kmetty és munkatársai is rendszeresen alkalmaznak hasonló algoritmikus modelleket kutatási eszközként olyan típusú feladatokra, ahol az a céljuk, hogy bizonyos szempontok mentén kategorizáljanak nagy mennyiségű szöveget. Végeztek már kutatást kommentek alapján az oltásellenesség témájában, de rendszeresen használnak hasonló nyelvi modelleket érzelemdetektálásra is. Ezen kívül például az ELTE BTK Digitális Bölcsészet tanszéke jelenleg az OTP Csoport segítségével GPT-3 nyelvmodellt épít.

A tudomány más területein is egyre többen kísérleteznek tanuló algoritmusokkal, Kornai szerint viszont az algoritmusok fejlesztésére és használatára is lehetne több erőforrást fordítani. A matematikai nyelvész szerint a magyar tudomány vészesen alulfinanszírozott és habár a mesterséges intelligencia és azon belül az önvezető autók témáját például kiemelten kezelik – elég csak a ZalaZone tesztpályára és a Mesterséges Intelligencia Nemzeti Laborra gondolni –, nagyságrendekkel többet kellene költeni az ilyen irányú kutatásokra.

„Míg Izraelben a nemzeti jövedelem 4 százalékát, Németországban 2,5 százalékát, nálunk mindössze körülbelül 1,5 százalékát költik tudományra, és a pénzek elosztásán is érdemes volna módosítani” – mondja a kutató. A 2022-es költségvetésben egyébként a Nemzeti Kutatási, Fejlesztési és Innovációs Alap keretében körülbelül 50 milliárd forintot különítettek el kutatásra és 65 milliárd forint körüli összeget innovációs tevékenységekre, a Nemzeti Laboratóriumok pedig összesen 5,6 milliárd forintot kapnak. Ehhez képest a német kormány 2021-ben körülbelül 3 milliárd eurót (1163 milliárd forint) költött csak az AI-fejlesztésre, és ezt a büdzsét 2025-re 5 milliárd euróra igyekszik emelni. Ahogy Kornai mondja: „most zajlik a mesterséges intelligencia forradalma, most kellene ebben részt venni - nem tíz év múlva".

Kapcsolódó cikkek a Qubiten:

50 magyar egyetemi oktatót kérdeztünk arról, hogy mi lesz itt, ha a hallgatók robottal íratják meg a házi feladatot

Bár külföldön az élelmes diákok már kacagva kapják az ötösöket a géppel íratott dolgozataikra, és akad elemző, aki szerint a mesterséges intelligencia a szemünk láttára öli meg a beadandó esszé műfaját, a magyar oktatók nem tartanak a ChatGPT-től és társaitól, sőt, a technológia szerintük még a hallgatók hasznára is válhat.

Tiltás helyett beépítené a tananyagba a ChatGPT-t a Washingtoni Egyetem

Az egyetem vezetése levélben biztatta az oktatókat arra, hogy nyugodtan használják fel a kurzusaikon a mesterséges intelligenciát használó chatbotot.

Bill Gates: A ChatGPT meg fogja változtatni a világunkat

A Microsoft alapítója szerint az emberi nyelven kommunikáló mesterséges intelligencia megjelenése olyan mérföldkő a modern történelemben, mint az internet feltalálása.