Szöveges chaten küldtek el az anyádba? Segít a mesterséges intelligencia!

Új fejlesztést tesztelnek a világ legnépszerűbb játék- és e-sport-fejlesztői: ellenőrizni akarják, hogy mi zajlik a szöveges chaten, és ki akarják szűrni a zaklató, sértő tartalmakat, a gyűlöletbeszédet és általában mindazt, ami ellenkezik az adott felület házirendjével. A massachusettsi Modulate által fejlesztett ToxMod nevű program egyelőre még csak tesztüzemben fut, de máris nagy az érdeklődés iránta.

A fejlesztők ígérete szerint a ToxMod képes különbséget tenni a hangszínek között, figyelembe veszi, hogy milyen érzelmi töltete lehet az elhangzottaknak, és arra is ügyel, hogy ez milyen reakciót vált ki a beszélgetőtársból. A program emellett kontextusba is helyezi az elhangzottakat, és mindezek alapján dönt arról, hogy jelentse-e az esetet a humán moderátoroknak, akik felülvizsgálhatják a mesterséges intelligencia döntését.

Millió órányi beszélgetés, milliónyi probléma

A moderátorprogramot jelenleg több népszerű játéknál is tesztelik, a rendszer iránt pedig a League of Legends-t fejlesztő Riot Games is érdeklődést mutat, ők a saját rendszerükbe akarják beilleszteni a ToxMod fejlesztéseit. A játékkal havonta körülbelül 150 millióan játszanak, a moderációhoz több millió vagy milliárd órányi beszélgetést kellene ellenőrizni. Carter Huffman, a Modulate társalapítója szerint a programjuk ezt a beszélgetéstömeget képes kezelhető szintűre szűkíteni, és ki tudja szűrni a valóban problémás eseteket.

Problémás esetek márpedig vannak: az Anti-Defamation League (ADL) nemzetközi antiszemitizmus elleni polgárjogi szervezet szerint tavaly öt felnőtt játékos közül egy találkozott fehér felsőbbrendűséget hirdető üzenetekkel online játékostársaitól, míg a 10-17 évesek 15 százaléka szembesült hasonlóval.

Fejlődő programok, fejlődő gyűlöletbeszéd

A ToxMod először kiszűri a potenciálisan káros tartalmakat, majd finomabb eszközökhöz nyúl, például nem tekinti gyűlöletbeszédnek és nem is jelenti azt, ha valaki egy FPS játékban (a játék kontextusán belül) gyilkosságról beszél. A program képes a háttérzajok elemzésére is, ez alapján pedig jelentheti a moderátoroknak, ha például családon belüli erőszak történik a háttérben.

A New Scientist szerint a ToxMod eddig elég sikeresen működik: a Gun Raiders nevű lövöldözős játékban a program által problémásnak ítélt esetek 98 százaléka valóban ellenkezett a játék felhasználási feltételeivel, az alkalmazása után pedig a problémás esetek száma pedig a felére csökkent.

Ez a játékosokon kívül persze a stúdiók érdeke is: miközben a szöveges chat vonzóbbá teszi a játékot és magasabb bevételt generál, az online zaklatás miatt nagyobb a játékot elhagyók aránya, ez pedig viszi a pénzt. A Sony, a Riot Games, a Turtle Rock Studios és a Roblox már eddig is kísérletezett a szöveges chat alaposabb felügyeletével, de lassan, későn és nem túl határozottan reagáltak a problémás esetekre, a ToxMod, ha beválik, erre nyújthat megoldást.

Sahana Udupa, a müncheni Lajos-Miksa Egyetem kutatója szerint a mesterséges intelligenciának kihívást jelenthet a gyűlöletbeszéd és úgy általában a beszéd folyamatosan változó jellege: a fehér felsőbbrendűséget hirdető csoportok például eddig is betűk megcserélésével és új szavak alkalmazásával próbálták kikerülni a moderációt, ha pedig szélesebb körben elterjed a szöveges chat felügyelete, várhatóan erre is előállnak majd valamilyen megoldással.

Kapcsolódó cikkek a Qubiten:

Kivonul Kínából a World of Warcraft

Nem sikerült megegyeznie a játékot fejlesztő Blizzardnak az eddigi kínai partnerével, 14 év után jövőre már nem lehet WoWozni. Nem lesz elérhető a Hearthstone, a Warcraft III: Reforged, az Overwatch, a Starcraft és a Diablo III sem.

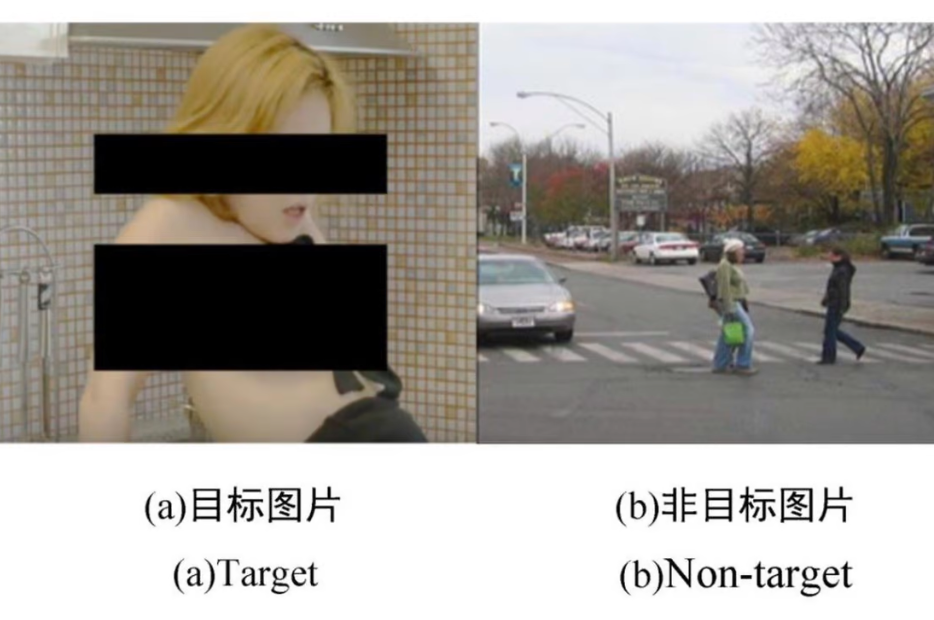

Agyhullámok alapján szűri ki a pornográf tartalmakat egy, a kínai cenzorokat segítő új sisak

Kínában illegális a pornó, ezért a Pekingi Csiaotung Egyetemen olyan agyi jeleket leolvasó sisakot fejlesztettek, amely érzékeli, ha viselője kéretlen tartalmakat lát a képernyőn.

Ha már az álhírekkel is alig bírunk, mi lesz, ha berobban a deepfake?

Veszelszki Ágnes újmédia-kutató a Budapesti Corvinus Egyetemen vezeti a CGI-Deepfake kutatócsoportot, amely elkészítette az első magyar deepfake-felmérést. Itthon még csak szórakoztató tartalmakat gyártanak a médiahamisítók, de a technológia terjedésével egyre kevésbé lehet majd hinni a szemünknek és a fülünknek, ami információs káoszt okozhat.