500 milliószor bújócskáztak egymással mesterséges intelligenciák, hogy szimulálják az evolúciót

Az Elon Musk által társalapított San Franciscó-i kutatócég, az OpenAI szépen csendben elkezdte syimul'lni az evolúciót. Mivel a mai élővilág, valamint az összetett emberi intelligencia is egyszerű mikroszkopikus szervezetekből fejlődött ki az évmilliárdokon át tartó versenynek és kiválasztódásnak köszönhetően, a kutatók azt tesztelik, hogy hasonló virtuális versengést imitálva létrehozható-e a jelenleginél kifinomultabb mesterséges intelligencia.

A kísérlet két létező technikát ötvöz: a többágenses tanulás (multi-agent learning) során több különböző algoritmust versenyeztetnek egymással, a megerősítéses tanulás (reinforcement learning) során pedig a gép nagy számú próbálkozásból, a sikeres és sikertelen nekifutásokból tanulja meg elérni a kitűzött célt – utóbbi a Google-féle DeepMind emberfeletti kísérletével, az AlphaGóval vált híressé.

Eszközhasználat és csapatjáték

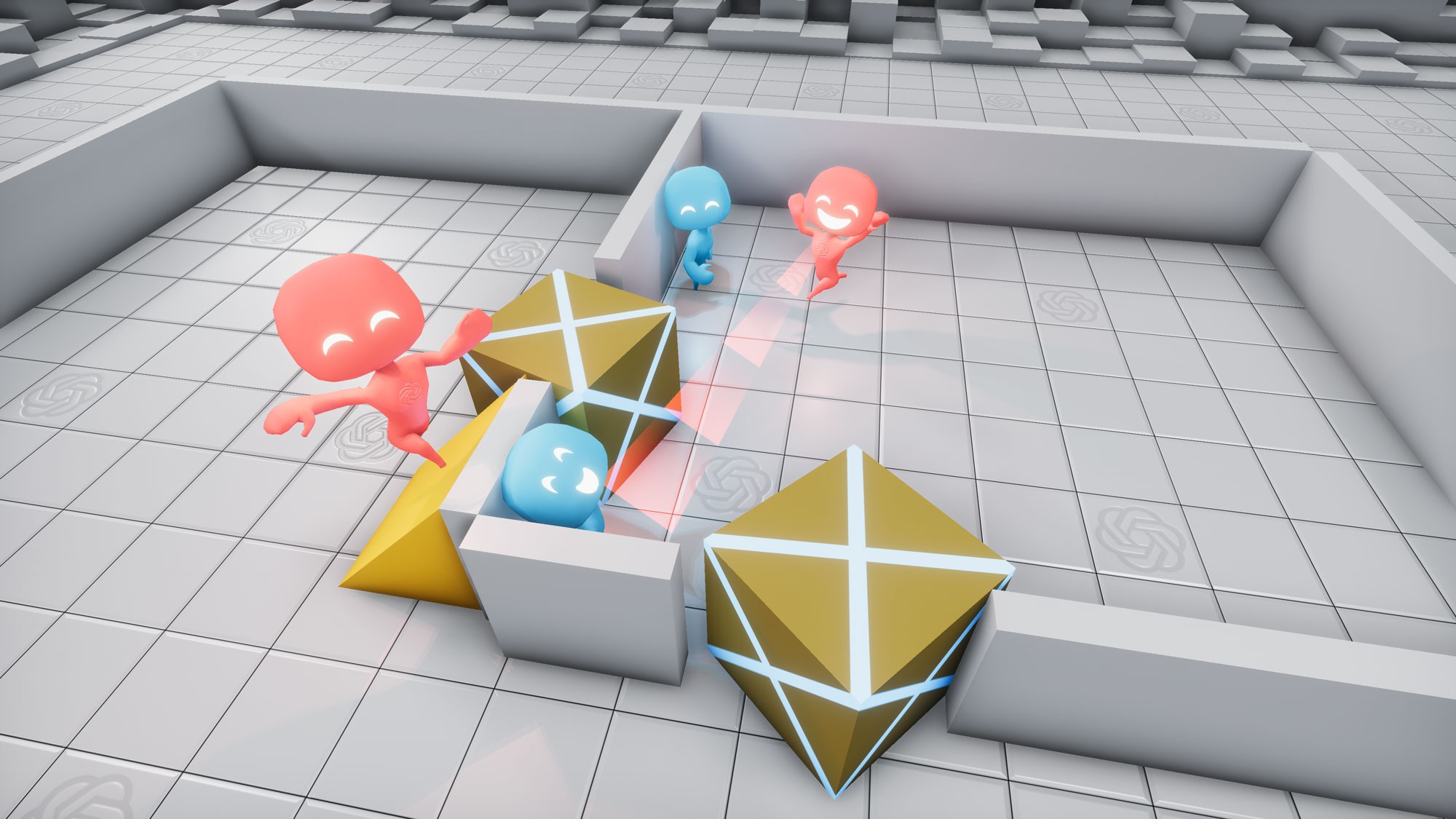

Az OpenAI most két csapatnyi mesterséges intelligenciát eresztett egymásnak, hogy több százmillió körön keresztül bújócskázzon egymással, és közben olyan komplex stratégiákat dolgozzanak ki, amelyek eszközök használatára és csapatjátékra is alapulnak.

Ehhez egy olyan virtuális környezetet terveztek az AI-kutatók, amelyben a játékosok egy zárt térben tudtak bújócskázni, különböző mozgatható és nem mozgatható dobozok, rámpák használatával. Az egyes ágenseket két csapatra osztották, és mindkettőt a szerepüknek megfelelően jutalmaztak vagy büntettek, az alapján, hogy sikerült-e rendesen elbújni, illetve megtalálni a másikat. Azon kívül, hogy az elbújáshoz kaptak néhány másodpercnyi előnyt, semmilyen más instrukciót nem kaptak az AI-játékosok.

Közel 500 millió kör után azt látták a kutatók, hogy mindkét csapat több stratégiát dolgozott ki magának. Miután az első fázisban még a pálya objektumainak használata nélkül bujkáltak, a 25 milliomodik játszma környékén elkezdtek finomabb módszerekhez nyúlni a virtuális játékosok: a bújók erődöt építettek maguk köré a barikádokból és dobozokból, és ehhez még együtt is működtek, hogy minél gyorsabban végezzenek az építkezéssel.

Még 50 millió körrel később aztán a másik csapat is kidolgozta a maga ellenstratégiáját, amikor az ágensek rájöttek arra, hogy a rámpák mozgatásával felmászhatnak az építményekre, és megtalálhatják az elbújt ellenfeleiket. A 85 milliós határnál eljött a negyedik fázis is: a bújók ekkor már azt is kitalálták, hogy ha lezárják (vagyis mozgathatatlanná teszik) a rámpákat, akkor nem tudják őket felhasználni a keresőik.

Váratlan fordulat a véghajrában

Ezután az OpenAI kutatói azt gondolták, hogy már nem lesz több fázis, de a 380 milliomodik kör felé közeledve még két stratégiát kidolgoztak az ágensek: a keresők rájöttek, hogy ha egy lezárt rámpán felmásznak egy mozgatható dobozra, és annak a tetején elszörföznek az erődítményig, akkor már be tudnak jutni – valamivel később pedig ezt is kiküszöbölték a bújók, minden mozgatható objektum lezárásával.

„Nem mondtuk nekik, hogy menjenek oda a dobozokhoz, és használják fel őket. A többágenses versenyben egymásnak adtak új feladatokat, hiszen a megtanult stratégiákhoz a másik csapatnak alkalmazkodnia kellett” – mondta az MIT Technology Review-nak Bowen Baker, az eredményeket bemutató tanulmány egyik szerzője. Baker szerint a jövőben több hasonló versenyt igyekszenek rendezni mesterséges intelligenciával, így akár olyan problémákra is megoldást találhatnak, amiket embernek még nem sikerült megoldani.

Kapcsolódó cikkek a Qubiten:

Szintet lépett a mesterséges intelligencia: először tanult meg sakkozni egy AI emberi segítség nélkül

A Google-féle AlphaZero 9 óra alatt, a nulláról tanult meg játszani, majd legyőzte az emberi képességeken már rég túllépett gépi sakkvilágbajnokot. Ráadásul nem monoton másolással, hanem kreatív, emberire emlékeztető lépésekkel.

A Microsoft egymilliárd dollárral támogatja az emberszerű mesterséges intelligencia fejlesztését

A mesterséges intelligencia szent grálja az AGI, az Artificial General Intelligence. A kutatók szerint az sem biztos, hogy 2099-re lesz belőle valami, a Microsoft viszont lát benne annyi fantáziát, hogy egymilliárdot pumpáljon a projektbe.

Elon Musk szerint a jövő olyan lesz, mint a Mátrix, sőt lehet, hogy már abban élünk

A SpaceX és a Tesla vezére az Alibaba igazgatójával, Jack Mával beszélgetett a jövőről a sanghaji Mesterséges Intelligencia Világkonferencián, ahol az oktatás AI-reformjáról, a jövő munkáiról, a bolygóközi létről és a civilizáció pusztulásáról is szó esett.