A női arcot bikinis testtel, a férfit öltönnyel egészíti ki a szexista mesterséges intelligencia

A nyelvgeneráló algoritmusok hírhedten beépítik nyelvükbe a rasszista és szexista elgondolásokat, hiszen az internet nyelvén trenírozták őket, a Reddit és a Twitter legsötétebb sarkaiban is tanulták, hogyan kell szöveget létrehozni a semmiből. Kutatók most azt bizonyították, hogy ugyanez igaz lehet a képgeneráló algoritmusokra is.

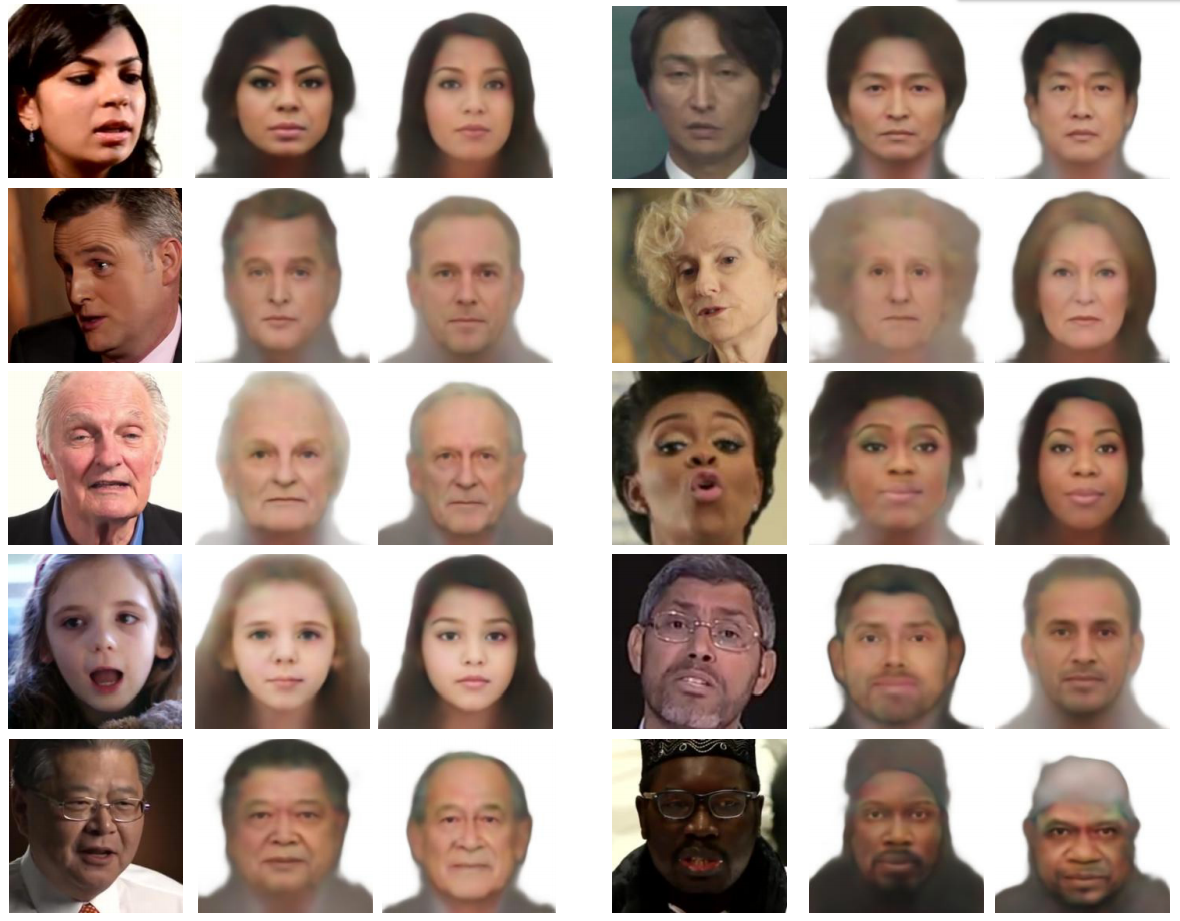

Ha csak egy férfi arc látszott a testből, a képet automatikusan kiegészítő algoritmus 43 százalékában öltönyös testtel látta el, ha viszont női arcról volt szó – legyen az akár Alexandria Ocasio-Cortez amerikai képviselőé –, 53 százalékban mélyen kivágott topot vagy bikinit viselt az algoritmus által hozzáálmodott test.

Ez a trend a Carnegie Mellon Egyetem és a George Washington Egyetem kutatóinak munkája szerint nemcsak a képgenerálásra hat ki, hanem az összes számítógépes vizualizációs alkalmazásra, például a videó alapú jelöltértékelési algoritmusok, az arcfelismerés és a megfigyelő rendszerek működésére is.

Emberi címkézéstől a gépi címkézésig

Az új tanulmány szerzői, Ryan Steed és Aylin Caliskan olyan algoritmusokat vizsgáltak, amelyek emberi irányítás nélkül, teljesen önállóan tanulnak, bár mindkettő más módszerrel teszi ezt: az egyik az OpenAI iGPT-je, a másik pedig a Google SimCLR-je.

Az önálló tanulás relatíve új fejlemény, a korábbi hasonló algoritmusok ugyanis emberi felügyelettel tanultak, kézzel felcímkézett képek segítségével: a cicafotókon a cica címke szerepelt, míg a babafotókon meglepő módon a baba, és így tovább. Ennek a módszernek is megvoltak az árnyoldalai: 2019-ben kiderült például, hogy a számítógépeslátás-modellek tréningezésére használt legnagyobb adatbázis, az ImageNet ember kreálta címkéi között otromba gyalázkodások is előfordultak, nők képeinél például a kurva kifejezés, a kisebbségekbe tartozó embereknél pedig rasszista becsmérlések.

Az új tanulmány arra mutat rá, hogy még az emberi címkék nélkül létrejövő képek is nem kívánt mintázatokat kódolnak. Az adatra éhes algoritmusokat tápláló óriási adatbázisok mindent lefednek az interneten, az interneten pedig felülreprezentáltak az alulöltözött nők és egyéb, gyakran káros sztereotípiák.

Steed és Caliskan a mostani munkához egy korábbi módszerüket vetették be, amelyet sikeresen alkalmaztak a felügyelet nélkül tanuló számítógépes nyelvfeldolgozási modellek részrehajlásainak vizsgálatára. Ezek a modellek úgynevezett szóbeágyazással manipulálják és generálják a nyelvet, ilyenkor a nyelv matematikai reprezentációját hozzák létre a gyakran egymás mellett használt szavakból klasztereket formálva, a gyakran elkülönülő szavakat pedig elválasztva.

Az iGPT (image GPT) is beágyazásokon alapul: annak alapján rendezi össze vagy különíti el a pixeleket, hogy milyen gyakran jelennek meg együtt a tanulásra használt képen. A pixelbeágyazások aztán megmutatják, milyen messze vagy milyen közel van egymáshoz két kép a matematikai térben. Akárcsak a nyelvfeldolgozási modellek esetében, Steed és Caliskan itt is azt találta, hogy a gépi előítélet tükrözi azt az emberi elfogultságot, amit a pszichológusok a rejtett előítéleteket is felszínre hozó IAT-val (Implicit Association Testtel) szoktak mérni. A férfiak és az öltönyök képei közelebb helyezkednek el a matematikai térben, míg a nők képei az öltönyöktől távol. Hasonló eredményeket hozott a SimCLR vizsgálata is, bár az az algoritmus másféle módszerrel nyeri ki a beágyazásokat a képek tengeréből.

Mindez eléggé aggasztó jövőt vetít előre a képgenerálás területén, különösen ha figyelembe vesszük, hogy más képgeneráló algoritmusok a szinte kizárólag csak nőket célzó deepfake pornográfia felfutásához vezettek. Az iGPT segítségével immár újabb módon lehet nőkről átszexualizált képeket gyártani.

Kapcsolódó cikkek a Qubiten:

Egyre olcsóbb, egyre egyszerűbb és egyre veszélyesebb a deepfake technológia

Két év alatt óriási fejlődésen ment keresztül a deepfake: az amatőr videók készítése egy gombnyomásra megy, de a profi kép- és hangmanipuláció sem kerül már 100 dollárnál többe. A politikai manipuláció mellett egyelőre leginkább kamupornóra használják, és a hírességek után most már mindenki célpont lehet, aki valaha töltött fel magáról képet az internetre.

Több mint százezer nőről generáltak és tettek közé pucér képet a tudtuk nélkül

A Telegram csatornáin tenyésző bot-ökoszisztéma ontotta a kamu aktképeket, amihez elég volt csupán egyetlen fotót feltölteni a célszemélyről. Az ügyben az is ijesztő, hogy az áldozatok többsége nem híresség vagy influenszer, hanem mit sem sejtő magánszemély.

Ijesztő pontossággal festik le a neurális hálózatok az emberek arcát, pusztán a hangjuk alapján

A mesterséges intelligencia alkotta portrék ugyan nem tökéletesek, de fantomképrajzoló legyen a talpán, aki a gép után csinálja.