Egyre olcsóbb, egyre egyszerűbb és egyre veszélyesebb a deepfake technológia

A University College London kutatói augusztusban tették közzé azt a tanulmányt, amelyben a mesterséges intelligenciához kötődő lehetséges csalásokat, bűncselekményeket tárták fel, és a rangsor elejére a videó- és hanghamisítást helyezték. „Az emberek hajlamosak hinni a szemüknek és a fülüknek. A deepfake technológia bűnügyi felhasználásai sokfélék lehetnek: gyerekek nevében kérhetnek pénzt az idősebb felmenőktől videohívás keretében, telefonon kérhetnek hozzáférést biztonságos rendszerekhez, vagy közszereplőket eljátszva manipulálhatják az embereket különböző célok érdekében” – írták a kutatók, a következő 15 év legnagyobb biztonsági fenyegetésének nevezve a deepfake-et.

Idén februárban először vetették be a technológiát választási kampányban, ám Indiában még csak arra használták fel, hogy egy politikus különböző, általa nem beszélt nyelveken és dialektusokban is meg tudja szólítani a szavazókat, és az utólag felvett beszédhez illeszkedjen a szájmozgása. Az amerikai elnökválasztási kampányt csodával határos módon eddig elkerülte a deepfake, egyedül a RepresentUs nevű korrupcióellenes szervezet próbált olyan videókat a tévébe küldeni, amelyeken Vlagyimir Putyin és Kim Dzsongun deepfake verziói hívják fel a figyelmet a demokrácia törékenységére – a felvételek közlésétől végül a Fox, a CNN és az MSNBC is elállt.

Áttörő politikai támadások híján így a deepfake – legalábbis a felszínen – egyelőre megmaradt annak, ami már 2018-ban is volt, amikor először írtunk róla: a celebpornó, a vicces videók, a filmes szerepcserék és az alternatív történelem kedvelőinek kedvenc technológiájának.

Itt van például az Apollo–11 tragédiájának felvétele, amely után Richard Nixon tájékoztatja a népet arról, hogy Neil Armstrong és Buzz Aldrin életét vesztette a Holdon (deepfake 4:30-tól):

Ingyen szórakozás, olcsó profizmus

Aki használt már Snapchat- és Messenger-filtereket, vagy aki tavaly megosztotta valamilyen platformon, hogy hogyan nézne ki öregen, szakállal vagy ellenkező neműként, tehát kipróbálta a FaceAppet, az már kapcsolatba került a deepfake technológiával. Az említett alkalmazások esetében még nem volt annyira szembetűnő, hogy ez a veszélyesnek kikiáltott, szuperfejlett technológia lapul mögöttük, hiszen csak egy saját fotóra vagy videóra került új effekt, idén nyáron egy olyan app kezdett hódítani, amely egy gombnyomásra tett elérhetővé korábban napok alatt megvalósítható funkciókat.

Az ukrán startupperek által piacra dobott, korábban Doublicat néven ismert Reface app ingyenes verziójában a naponta ajánlott körülbelül 10 jó minőségű videó mellett szinte minden ismert gifen ki lehet cserélni a kiválasztott arcot a sajátunkra, és ehhez csak egy szelfit kell készíteni. A tíz másodperc alatt elkészült mozgóképeket le lehet tölteni, meg lehet osztani, nyáron kiakadtak tőle a csoportos csetablakok – az appot több tízmillióan telepítették már, és ki tudja hányan fizettek elő (havi 2 vagy évi 10 ezerért) a napi limitet eltörlő, reklám- és vízjelmentesítő Pro verzióra.

Az ingyenes, cserébe alacsonyabb minőségű képeket készítő alkalmazásokon túl már nem kell nagy befektetés ahhoz, hogy értőbb szemeket is be lehessen csapni.

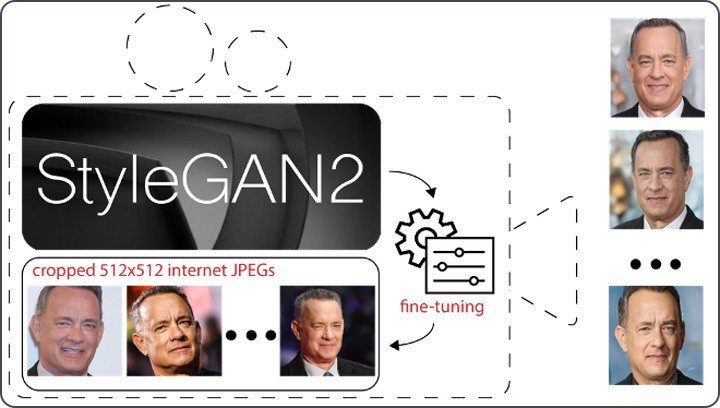

Augusztusban a virtuális Black Hat konferencián egy Tom Hanks-generátoron keresztül mutatták be a legolcsóbban hozzáférhető profi technológia képességeit. A FireEye nevű kiberbiztonsági cég egyik munkatársa csekély tapasztalattal vágott neki a feladatnak, de így is sikerült kevesebb mint 100 dollárból nem létező Hanks-fotókat gyártania, és beszédeket kreálnia a színész hangján. A hangutánzáshoz egy Google-féle beszédszintézis-projekt (TacoTron2) nyílt forráskódú változatát vette igénybe, a képek előállításához pedig a következőkre volt szüksége:

- Az internetről letöltött Hanks-fotókat megvágta úgy, hogy az arc középre kerüljön, és 512x512 képpontosak legyen a képek.

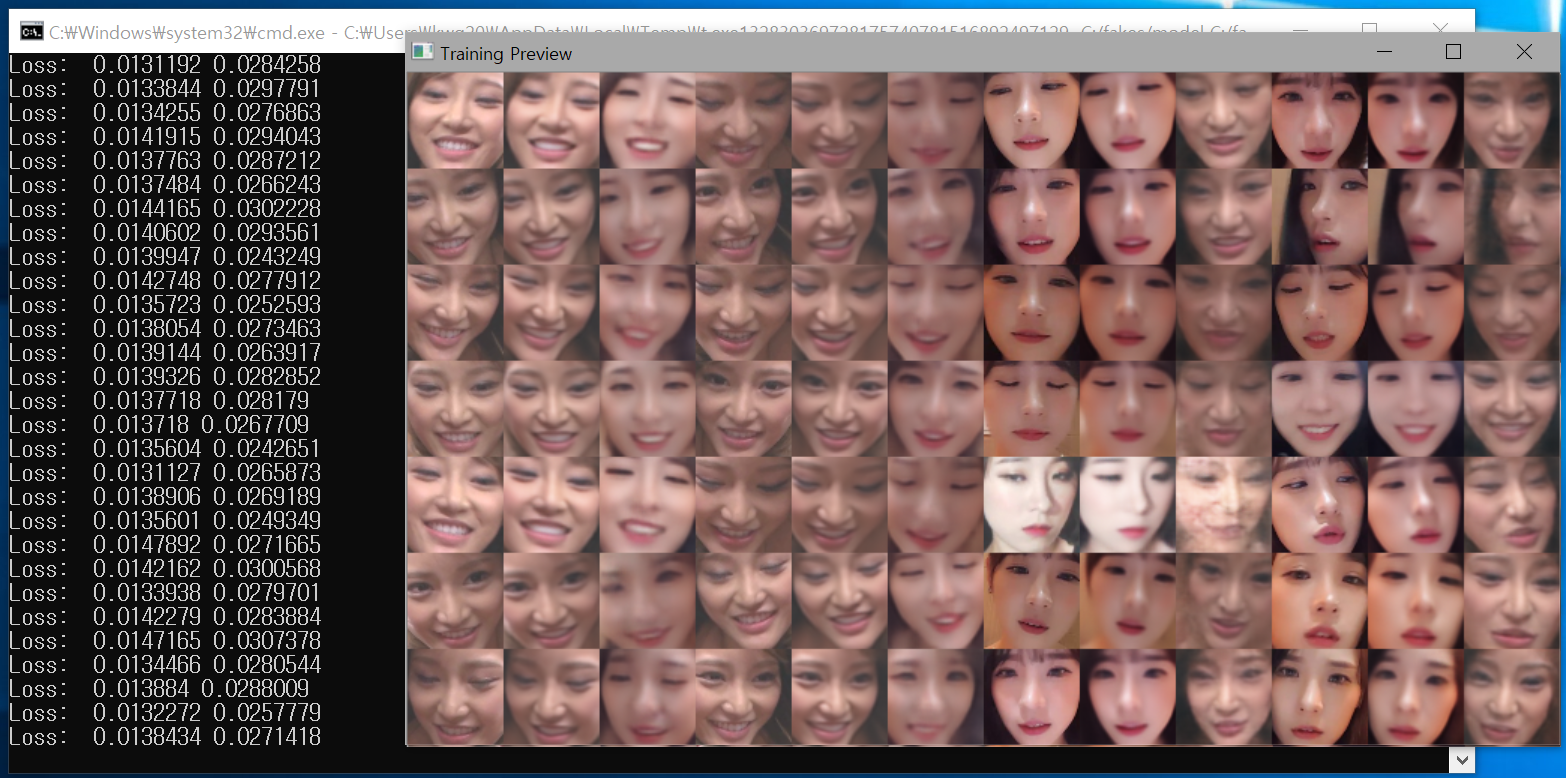

- A képeket betáplálta egy előre betanított AI-modellbe (StyleGAN2), amely nem létező arcokat generál valódi fotók millióiból, majd egy napig hagyta az algoritmusokat tanulni és dolgozni egy felhőn keresztül bérelhető grafikai processzoron (GPU).

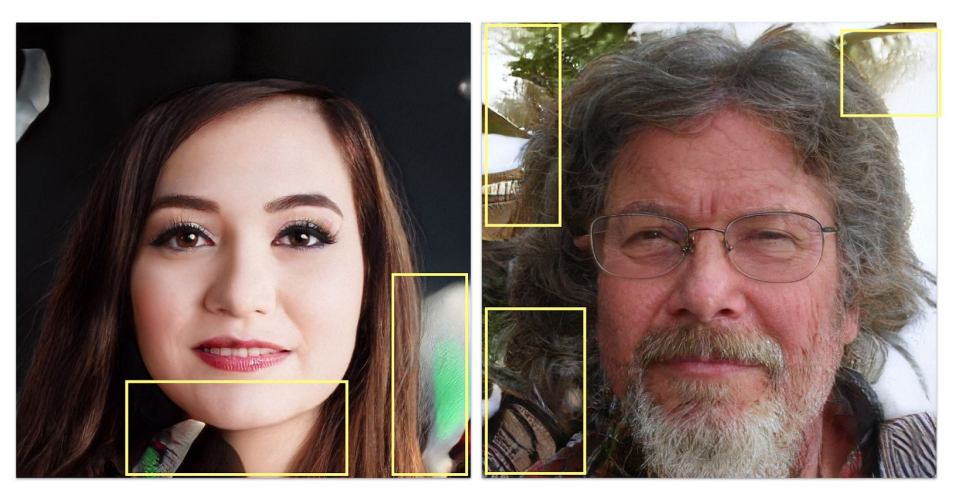

- Eredmény:

Ez a folyamat korábban legalább napokat vett volna igénybe, de a finomhangolásnak nevezett módszerrel szinte bárki könnyen hozzáférhet a legkorszerűbb technológiákhoz. Ez annak köszönhető, hogy a területtel foglalkozó, neurális hálózatokat versenyeztető cégek és kutatók szabadon elérhetővé teszik modelljeiket a GitHubhoz hasonló forráskódtárakban, így a felhasználók elé már egy jól betanított, kész technika kerül, amit kedvükre továbbfejleszthetnek, nem feltétlenül nemes céllal.

A hírességek után már minden nőt fenyeget a deepfake-pornó

Bár a deepfake segítségével akár az alany testmozgásán is lehet alakítani, vagy az eredetitől eltérő beszédhez lehet igazítani a szájmozgását, a képhamisítási technológia veszélyeit kutató Sensity vezetője, Giorgio Patrini szerint az interneten keringő deepfake videók 99 százaléka egyszerű és ingyenes (vagy nagyon olcsó) programokkal készült, és arccserén alapul.

A Sensity 2019-ben közel 15 ezer deepfake videót talált a neten, ezek 96 százaléka arccserélős pornó volt. A cég idén júniusban egy újabb kutatás során már 49 ezer deepfake videót talált online (vagyis a deepfake videók száma körülbelül félévente duplázódik), és bár még mindig a pornó dominál, egy jelentős változást észrevettek. Míg a műfaj 2017-es születése idején szinte csak hagyományos hírességek (színésznők, popsztárok) estek a technológia áldozatául, mára egyre gyakrabban tűnik fel internetes hírességek (influenszerek, youtuberek, Instagram- vagy Twitch-sztárok) arca ezekben a videókban.

A Sensity felmérése szerint havonta nagyjából ezer deepfake videót töltenek fel a legnézettebb pornóoldalakra, amelyek szabályzata hiába tiltja a videókban szereplő személyek hozzájárulása nélkül készült felvételek közzétételét, a deepfake-kel nem nagyon tudnak, vagy nem nagyon akarnak mit kezdeni. De már vannak kifejezetten deepfake-fókuszú pornóoldalak is, több százmilliós közönséggel, és olyan is van közöttük, amely kérésre gyártja a hamisított videókat – a szolgáltatásért bitcoinban lehet fizetni. A szakértők a trendekből arra következtetnek, hogy a hírességek mellett hamarosan a hétköznapi embereket – leginkább a nőket – is fenyegetheti a deepfake-pornó veszélye.

A felöltözött nőket algoritmus segítségével levetkőztető DeepNude alkalmazását ugyan megjelenése után gyorsan lekapcsolták tavaly, a forráskódját valószínűleg sikeresen visszafejtették – ez állhat a héten felfedett Telegram-botrány mögött is. A titkosított üzenetek küldésére használt app több mint százezer felhasználóját érintő ügyben fiatalkorú lányok is érintettek, a manipulált képeket pedig nemcsak terjesztették, de pénzért is árulták a Telegramon.

Míg a hagyományos felvételeken szereplők beleegyezése nélkül feltöltött képek vagy videók esetében becsületsértés vagy személyiségi jogok megsértése miatt lehet perelni, esetleg szerzői jogi panasszal élni, a deepfake-pornóra egyelőre nincs megfelelő jogi eszköz. A Wired cikke szerint az USA-ban elsőként elfogadott deepfake-törvények csak a politikai célú felhasználásra vonatkoznak, Nagy-Britanniában pedig már elkezdték vizsgálni az intim képek (a deepfake felvételeket is ideértve) online megosztásának szabályozási lehetőségeit, de a jogi környezet változása évekbe telhet.

„Ez a technológia már köztünk van, és sokkal gyorsabb ütemben fejlődik, mint amivel a társadalom tartani tudja a lépést. Nem vagyunk felkészülve arra a mesterséges média korára, amelyben már videókat is bárki könnyen tud hamisítani” – mondta a lapnak Nina Schick, a Deepfake és az Infokalipszis című könyv szerzője. Szerinte a problémára a techszféra szereplőinek, a politikusoknak és a jogászoknak együtt kellene megoldást nyújtani, a nyilvánosság bevonásával, ennek jeleit azonban egyelőre nem látni.

Techcégek és katonák fejlesztik az ellenszert

A Facebook még 2019 szeptemberében hirdette meg azt a versenyt, amelyben a leghatékonyabb deepfake-vadász algoritmust keresték, és idén júniusban meg is nevezték a győztest, akit több mint kétezer pályázó közül választottak ki. „Eléggé frusztrált, hogy okos kutatók mennyi időt és energiát fektettek abba, hogy minél jobb deepfake-eket készítsenek, anélkül, hogy az ezeket felismerő módszerek kifejlesztésébe fektettek volna” – mondta a Facebook technológiai igazgatója, Mike Schroepfer.

A cég 10 millió dollárt költött a versenyre, és több mint 3500 embert bízott meg deepfake videók ezreinek készítésével – a profi videók helyett a közösségi médiában inkább terjedő, telefonos minőségű amatőr felvételekre fókuszáltak. A győztes algoritmus 82 százalékos pontossággal ismerte fel a deepfake videókat, amit Schroepfer sikernek könyvelt el. A Facebook saját deepfake-detektora ugyan a cég állítása szerint ennél pontosabb, de a szervezők szerint arra mindenképp jó volt a verseny, hogy az (amatőr és hivatásos) AI-kutatókat ráállították egy olyan probléma megoldására, amely a következő években meghatározó lehet.

A deepfake-elhárítás lassan önálló iparággá növi ki magát. Vannak a Facebookhoz hasonló techcégek, amelyek saját megoldással szállnak harcba a deepfake ellen – ilyen például a Microsoft is, amely szeptemberben jelentette be a manipulált videók felismerését célzó Video Authenticator nevű szoftver fejlesztését. És vannak olyan cégek, amelyek kifejezetten a deepfake biztonsági fenyegetéseinek elhárításán dolgoznak.

Utóbbiak közé tartozik az izraeli védelmi erők veterán kiberbiztonsági szakértői által 2017-ben alapított Cyabra is, amely már több amerikai partnerrel együtt igyekszik fellépni a deepfake technológiákkal megtámogatott dezinformációs kampányokkal szemben. Ahogy a cég társalapítója, Yossef Daar az Observernek elmondta, egy jól felépített dezinformációs kampány három, piramisban is elképzelhető elemre épül:

- a piramis alján az egyértelmű kamuprofilok, Twitter-botok és hasonlók állnak, amelyek feladata egy adott üzenet tömeges terjesztése, felhangosítása;

- középen kapnak helyet a valódinak tűnő, AI-generált fotóval is rendelkező profilok, amelyek egy fokkal értelmesebbnek tűnnek, ezáltal emberi arcot adva az üzenetnek;

- a piramis tetején pedig valós személyek állnak, akik általában pénzt kapnak az üzenet terjesztéséért, hogy az még hitelesebbnek tűnjön.

Vannak, akik szerint az egyszeri bombaként használható deepfake videók helyett az emberfeletti ütemben szaporodó, mesterségesen generált arcképekkel megtámogatott kamuprofilok jelentik az igazi veszélyt.

A deepfake-hez hasonlóan szintén a generatív versengő hálózatokat (GAN) hasznosító technológia első kiterjedt használatára tavaly decemberben bukkant rá a Graphika közösségimédia-elemző cég és az Atlantic Council nevű think tank digitális kutatóintézete: egy olyan, több mint 900 oldalból, csoportból és profilból álló hálózatot lepleztek le, amelynek szálai a szélsőjobbos-trumpista-konteós Epoch Media Groupig vezettek.

„Kamuprofilokkal próbálták erősíteni a Facebook-jelenlétüket, hogy szélesebb közönséghez juttathassák el üzeneteiket” – mondta a kutatásban részt vett Max Rizzuto a Financial Timesnak.

A Graphika ezen kívül Kínában és Oroszországban is felfedezte már a technológia megjelenését. A vizsgált kínai Facebook-kampányokban nem létező személyek szájába adták a pekingi propagandát érzékeny külpolitikai ügyekkel kapcsolatban, míg az oroszok fiktív újságszerkesztők nevében hoztak létre profilokat, így próbálva befolyásolni az olvasók gondolkodását.

* * *

Érdekel a nagyvárosok jövője? Szeretnéd tudni hogyan menthető meg Budapest a rossz levegőtől és a közlekedési-urbanisztikai káosztól? Akkor semmiképp ne maradj le a ma esti online beszélgetésünkről, ahol magyar kutatók: Lehoczky Annamária éghajlatkutató, Csontos Csaba geográfus, Szabó Árpád urbanista vitáznak majd erről. (október 28., szerda 19.00, Energiahajó)

Kapcsolódó cikkek a Qubiten:

2018: a deepfake éve, a valóság vége

A kép-és videóhamisításra használt deepfake technológia odáig jutott, hogy egyes szakértők már információs apokalipszist emlegetnek. A kamu felvételek elterjedése felrúgja azt alapigazságot, miszerint ha másnak nem, legalább a szemünknek hihetünk. Miközben még nincs igazi megoldás a problémára, a mesterséges intelligencia vadul fejlődik tovább.

Deepfake Putyin beszállt az amerikai elnökválasztási kampányba

Kim Dzsongun kollégájával együtt arra figyelmezteti az amerikai választókat, hogy az ő beavatkozásuk nélkül is felszámolják a saját demokráciájukat. Három nagy tévécsatorna az utolsó pillanatban elállt a sugárzástól.

Először vetettek be választási kampányban deepfake videókat

Az indiai Delhi választási kampányában olyan videókat készített a kormánypárt jelöltje, amely a különböző nyelveken beszélő szavazókat szólítja meg úgy, mintha tényleg a politikus beszélne.