Történelemből még megbukna a mesterséges intelligencia

A bölcsesség egyiptomi istennőjéről elnevezett nemzetközi történettudományi adatbázis, a Seshat Global History Databank segítségével tesztelte a legnépszerűbb nyelvi modelleket az ausztriai Complexity Science Hub (CSH) kutatóintézet – írja a Tech Crunch.

A kutatók az OpenAI GPT-4, a Meta Llama és a Google Gemini nyelvi modelljeit kérdezték fel: a még tavaly bemutatott eredményeik szerint még a legjobban teljesítő GPT-4 is csak 46 százalékos pontossággal teljesített (ez sok helyen a ketteshez sem elég), holott az ausztriai kutatóintézet történelmi kvíze nem kérdezett túl nehezeket.

A lap példaként egyebek közt azt az eldöntendő kérdést idézi, amely azt firtatta, hogy volt-e az ókori Egyiptomban állandó hivatásos hadsereg? Az egyértelmű nem helyett valamennyi nyelvi modell igennel válaszolt, aminek a kutatók szerint az lehet az oka, hogy a könnyen elérhető nyilvános információforrások a perzsák állandó hadtesteit emelik ki az ókorból.

A kutatók más trendeket is azonosítottak, többek között azt, hogy az OpenAI és a Llama modellek a fentinél is gyatrábban teljesítettek akkor, ha a kérdés nem az európai, hanem például a szubszaharai történelmi ismeretekre vonatkozott.

Az ausztriai CSH kutatói a lapnak elmondták, hogy a nyelvi modellek történettudományi alkalmazása ugyanakkor korántsem reménytelen vállalkozás, de mindenképp szükség van arra, hogy ne mennyiségi, hanem minőségi alapon is súlyozzák a feldolgozott információkat.

Kapcsolódó cikkek a Qubiten:

Kifaggattuk a világverő kínai chatbotot, hogy mit gondol Mao elvtársról, a Tienanmen téri vérengzésről és Tajvan függetlenségéről

A kínai AI-cég, a DeepSeek december végén jelentette be nagy nyelvi modelljének új verzióját, ami sokak szerint az eddigi egyik legjobb nyílt AI-modell lehet. Na de mennyire jó, ha kényes kérdéseket teszünk fel neki?

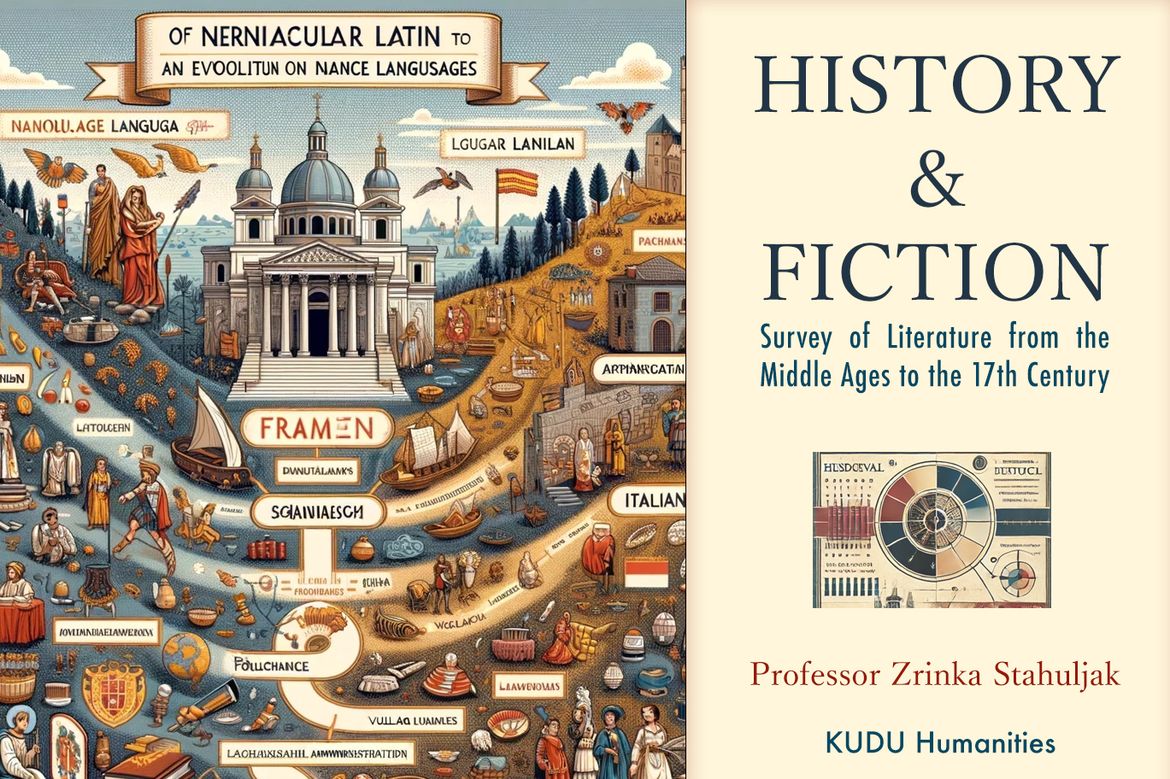

AI-generált tananyaggal indít kurzust a Kaliforniai Egyetem, de már a tankönyv borítója is értelmezhetetlen

A UCLA irodalmi kurzusát tartó professzor korábbi jegyzeteiből generált tankönyvet és feladatsorokat AI segítségével, de a végeredmény nevetség tárgya lett az interneten.