Miért nem létezik tökéletes időjárás-előrejelzés, és segíthet-e a mesterséges intelligencia?

„A meteorológus az a szakember, aki úgy is kap fizetést, hogy a munkaideje felében téved.” Még ha az utóbbi két évtizedben sokat javult is az előrejelzés pontossága, a másnapi időjárást akár 90-95 százalékos pontossággal is be lehet lőni, a meglehetősen szakállas viccben még ma is van némi igazság. Egy teljes hétre tervezni ugyanis még ma is legfeljebb 70-75 százalékos beválási aránnyal lehet, tíz napnál későbbi tömegrendezvények szervezésekor pedig végképp nem érdemes az előrejelzésekre támaszkodni. Mindezen nemigen fog változtatni az Országos Meteorológiai Szolgálatnál (OMSZ) idén január 10-én ünnepélyes keretek között hadrendbe állított vadonatúj – HPE Apollo 6000 típusú – szuperszámítógép sem.

Más kérdés, hogy az új gép kétszer gyorsabb, mint a nagyjából 7 évig szolgáló korábbi IBM modell. A számítási kapacitás, persze, nem kizárólag a hardver, például a processzorok számának és (ezzel arányosan növekvő) gyorsaságának a függvénye. Sok múlik a szoftvereken, így azon is, hogy azokkal a masina képes-e az időjárási, illetve éghajlati szimuláció végereményét meghatározó részadatokat egymással párhuzamosan is kalkulálni.

Az OMSZ-ben teljes egészében idén nyárra felálló rendszer 85 perc alatt futtat le egy olyan programot, ami a négy évvel ezelőtti számítási kapacitással 500, 2011-ben pedig 1000 percet vett igénybe – tájékoztatta a Qubitet Tölgyesi László meteorológus-informatikus, az OMSZ informatikai és módszertani főosztályának vezetője. Hozzátette azonban, hogy a szuperszerverrel elsősorban a globális éghajlatváltozás regionális következményeit fogják szimulálni.

Százezer mérőállomás sem elég az egyenletek tökéletes megoldásához

Nincs az a szuperszámítógép, amellyel atombiztos időjárás-előrejelzést lehetne készíteni. A másnapi előrejelzések pontosságát a tudomány mai állása szerint 1-2 százaléknál többel már nemigen lehet növelni – mondta Tölgyesi. Ennek oka elsősorban a számítások alapjául szolgáló adatmennyiség eredendő hiányosságaiban keresendő.

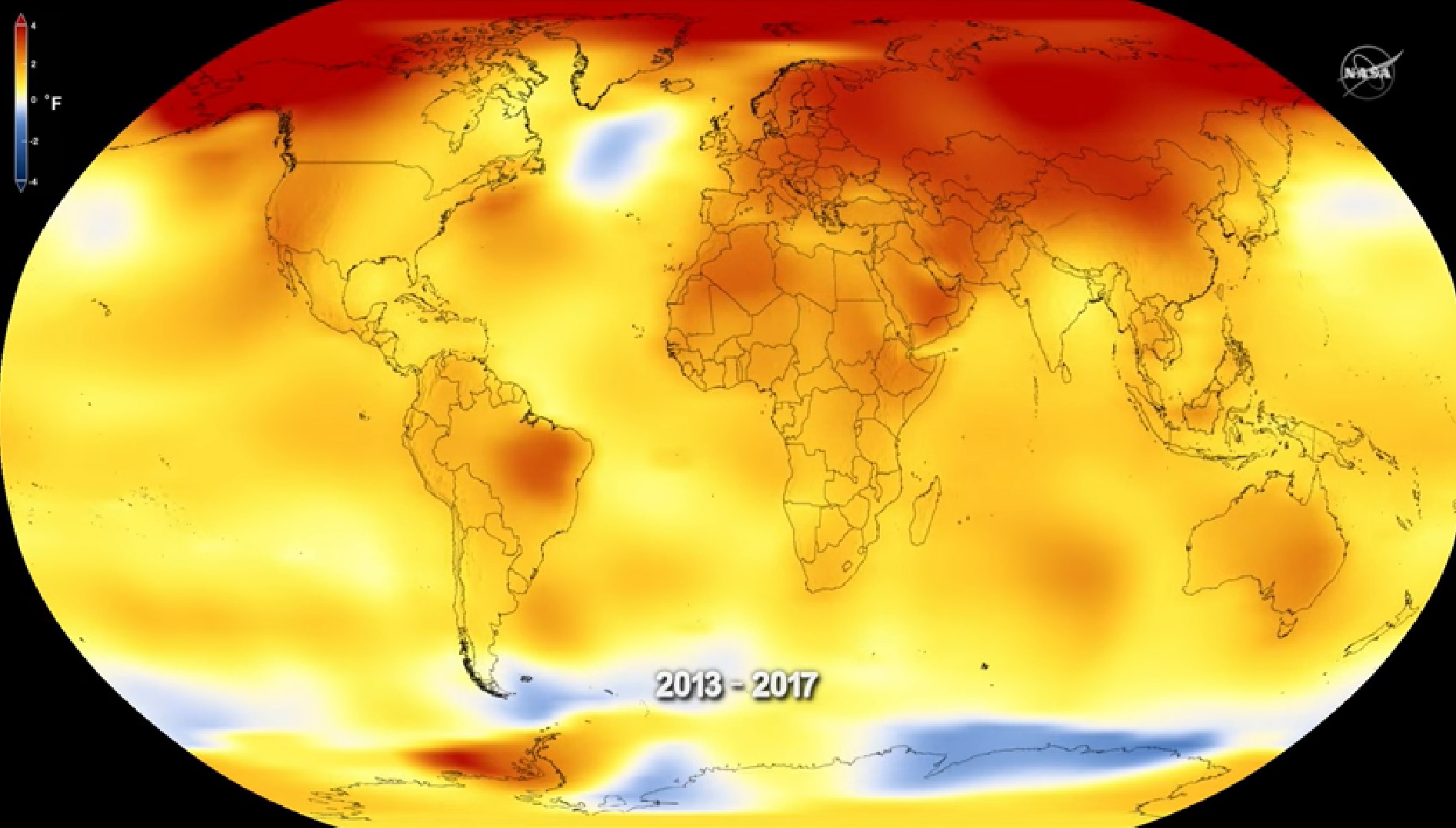

Minél több adatot táplálnak a szimulációkat lefuttató szuperszámítógépekbe a Földet körülölelő háromdimenziós légkörről, annál pontosabb a differenciálegyenletek megoldása. A glóbuszon elhelyezett több százezer egyedi mérőállomás soknak tűnhet, pedig az egyenletek tökéletes megoldásához közel sem elég. Nem szólva arról, hogy a Föld nehezen hozzáférhető pontjain, például a sivatagokban, óceánok, tengerek közepén, szakadékokban, a sarkvidékeken alig-alig akadnak szenzorok. Ugyancsak kevés adat származik a légkör magasabban található részeiről, épp onnan, ahol az időjárási jelenségek zajlanak.

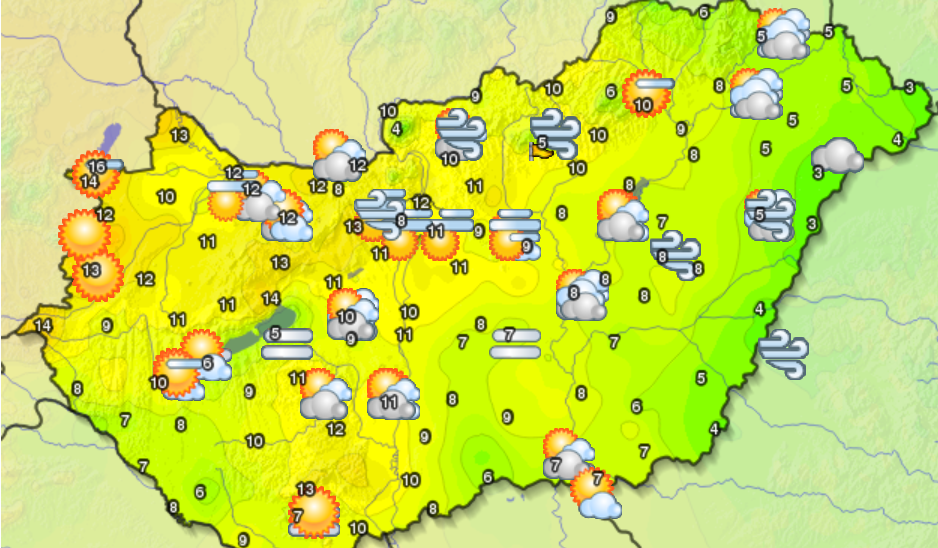

Magyarországon a földfelszín közelében 250, a légkört 10 percenként szondázó automata mérőállomás működik. Magaslégköri eseményeket figyelő, úgynevezett troposzféra-állomás viszont csak Szegeden és Budapesten van, és az itt található műszerekkel is csak egy mérést végeznek minden 12 órában.

Az adatok hiányosságán valamelyest enyhít, hogy a légkört felülről is szondázza több mint ezer meteorológiai műhold. A számítógépes szimulációkban kulcsszerepet játszó hidro-termodinamikai egyenleteknek azonban így is legfeljebb csak közelítő megoldása lehet. Az sem mindegy, milyen adat számunkra a legfontosabb: miközben a várható hőmérséklet egész precízen (egy-egy jobban megfigyelt területen akár tizedes pontosságig) kiszámítható, a csapadékmennyiség és a szélerősség előrejelzése rendszerint lényegesen pontatlanabb.

A szuperszámítógépeknek mégis nagy keletje van szerte a világon. Az Egyesült Államok Óceánológiai és Légkörkutató Hivatala (NOAA) két éve egyik pillanatról a másikra tízszeresére növelte számítási kapacitását. A szuperszámítógépeiről híres Cray vállalat csúcsgépét az amerikai szakemberek azzal a nem titkolt céllal szerezték be, hogy végre maguk mögé utasíthassák az időjóslásban évek óta verhetetlennek számító Középtávú Időjárás-előrejelzések Európai Központját (ECMWF).

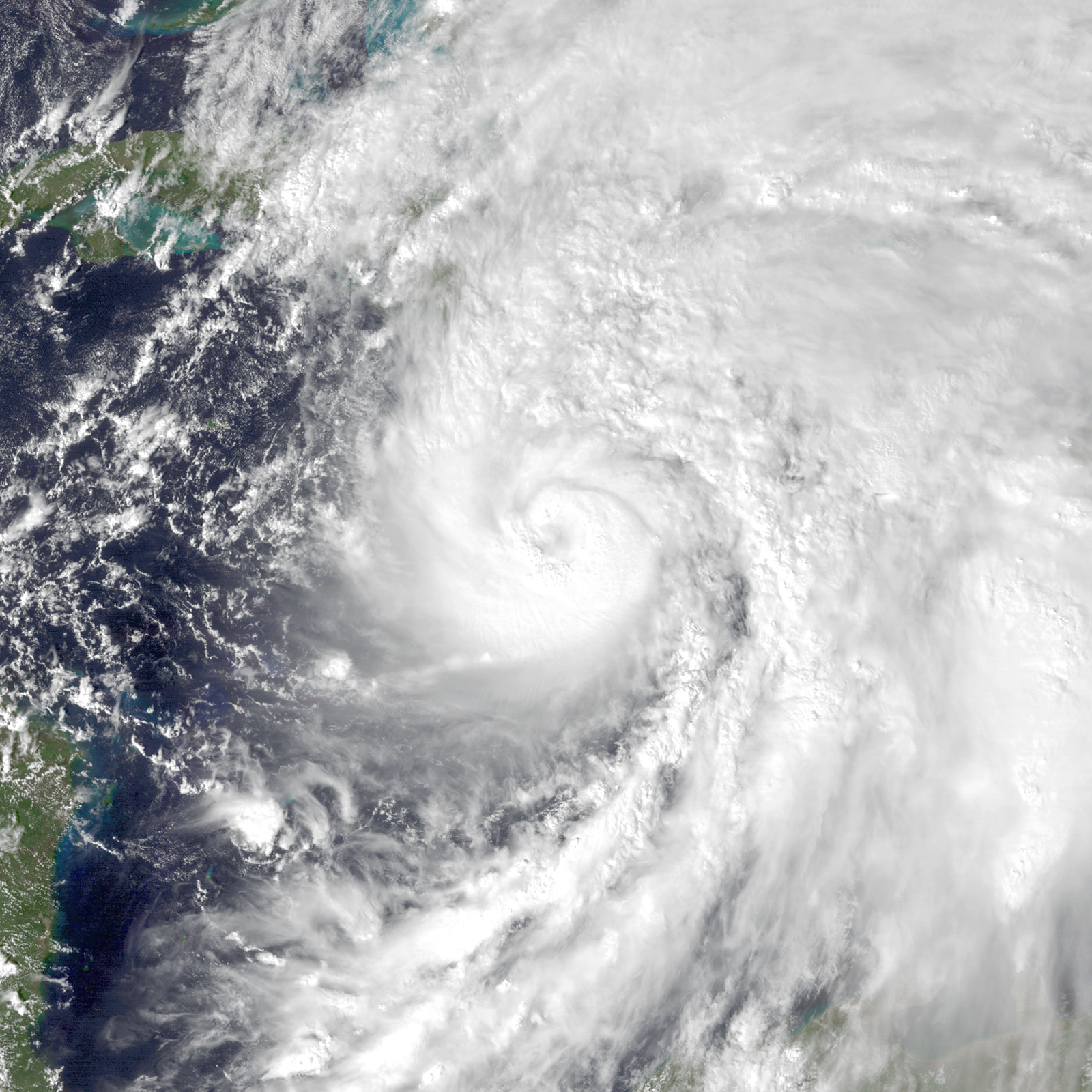

A tengerentúlon 2012 októberében voltak kénytelenek végképp elismerni az európai fölényt, miután a Sandy hurrikán az Atlanti-óceán felől egy hirtelen balkanyarral New Jersey felé vette az irányt, és 65 milliárd dollárnyi kárt okozott. Ezt és a trópusi vihar erősségét az amerikai légkör-szimulációk – az európaiakkal ellentétben – nem jelezték előre. Arról egyelőre nincs hír, hogy a világon nagyjából a 42. legerősebbnek számító, kapacitásában mintegy 12500 csúcskategóriás laptop teljesítményét összpontosító Cray-géppel az amerikai időjósoknak valóban sikerült-e átvenni a stafétát.

A világ első számítógéppel szimulált fizikai kísérlete

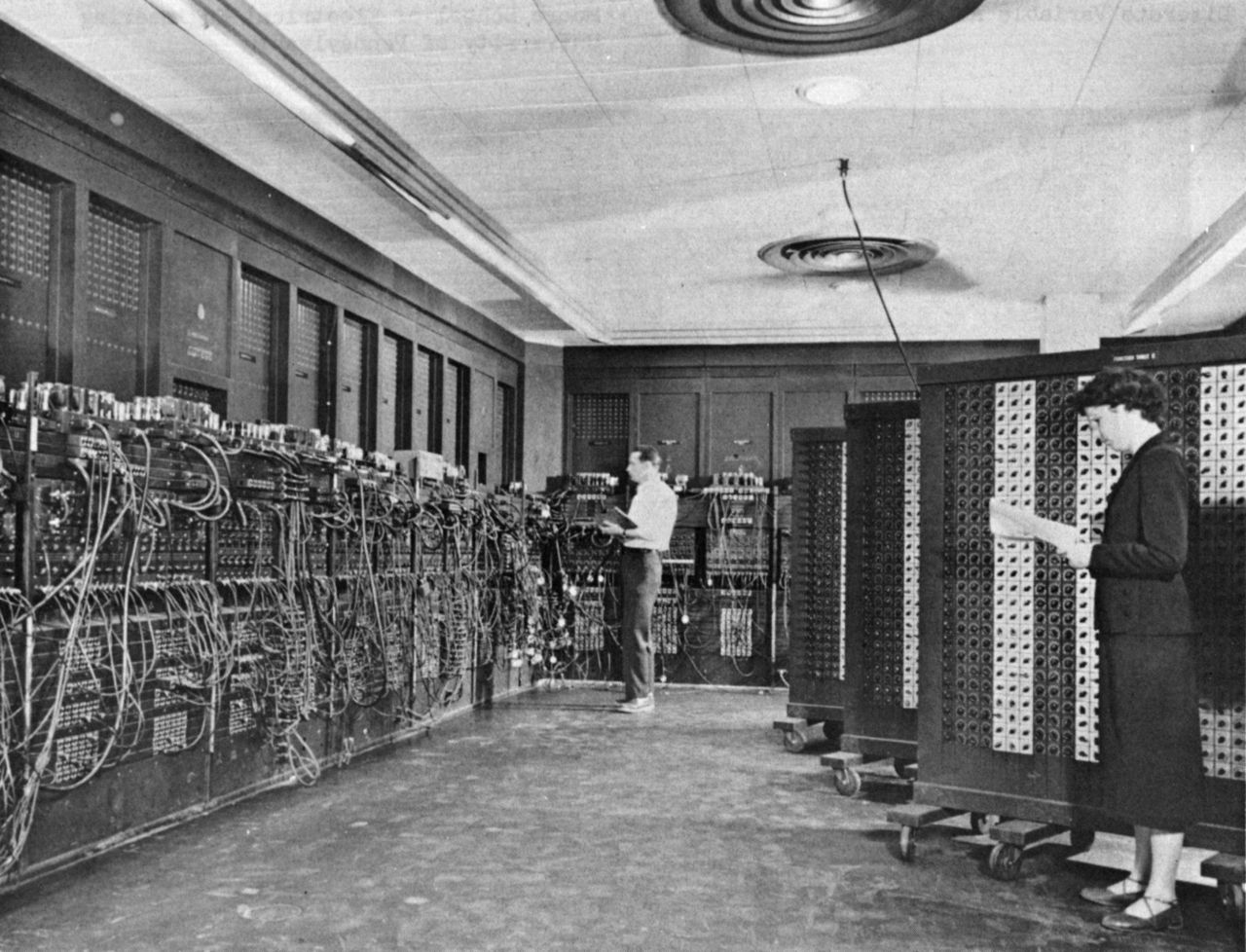

Az időjóslás szuperszámítógépesítése nem manapság kezdődött. A meteorológiát a világ leghíresebb számítógépe forradalmasította a második világháborút követő leszerelése után. Az 1947-ben Los Alamosból Marylandbe szállított ENIAC-ot tervezője, a magyar származású Neumann János és ugyancsak magyar származású (második) neje, Dán Klára két év alatt fejlesztette belső vezérlésűvé – bináris kód és a korábban használt lyukkártyákat helyettesítő beépített memória révén.

Az irdatlan kapacitást igénylő légköri számítások iránt élénken érdeklődő Neumann ezután a múlt század derekának legnagyobb meteorológiai szaktekintélyeivel állt össze, hogy gépét tesztelje. A Jule Charney, George Platzman, Margaret és Joseph Smagorinsky amerikai, valamint Ragnar Fjörtoft norvég meteorológusokból álló csapat a Princeton Egyetem színeiben 1950-ben, egy hónapnyi munkával sikeresen elő is rukkolt két 12 órás és négy 24 órás időjárás-előrejelzéssel. Ez volt a világ első számítógéppel szimulált fizikai kísérlete.

A világsajtó már akkor is azt hangsúlyozta, hogy a vadonatúj technológia előnyei a mezőgazdaság, a szállítmányozás, a légiközlekedés és egyéb iparágak számára „teljesen nyilvánalóak”. Hasonló érvekre alapozva okosítanák egészen az önállóságig a légkörszimulációs programokat futtató 21. századi számítógépeket.

Lenyomhatja a szuperszámítógépeket a mesterséges intelligencia?

Az IBM meteorológiai szolgálata, a Weather Company például nemrégiben egy negyedóránként 2,2 milliárd előrejelzési adat kiszámítását és modellezését végző mesterséges intelligenciát állított az időjóslás szolgálatába. Miközben a szuperszámítógép a klasszikus modellezési eljárásoknál legfeljebb 10-20 százalékkal jósol pontosabban, a hurrikánok várható erejének és mozgásának a kiszámításában akár 30 százalékot is ráverhet a hagyományos módszerekre. A hurrikánok mozgását, erőgyűjtési képességét és egyéb paramétereit is kivételes éleslátással feltérképező program ugyanazt az algoritmust, a Monte Carlo-módszert használja, amely a 2015 óta profi gójátékosokat is kenterbe verő AlphaGo alapja is.

Hasonlóval kísérletezgetnek a Stanford Egyetem kutatói is, akik önfejlesztő neurális hálózatokkal próbálták lepipálni a differenciálegyenletek megoldásán alapuló tradicionális modellt. Az általuk használt algoritmusok teljesítménye elmaradt ugyan a hagyományos szimulációkétól, a kutatók mégis arra a következtetésre jutottak, hogy az AI már most is jobb lehet a hosszabb távú előrejelzésekben, idővel pedig tanulhat annyit, hogy rövid távon is verhetetlenné váljon.

Mennyit ér a precizitás?

A pontosabb időjárás-előrejelzést mindenesetre igen könnyen (nem is olyan apró) pénzre lehet váltani, és korántsem csak azért, mert egy-egy sűrűn lakott tengerparti területen másfél kilométernyi szakasz evakuációja akár egymillió dollárba is kerülhet. A mezőgazdasági károk 90 százalékáért ugyancsak az időjárási változások okolhatók, és ezek negyede – legalábbis az IBM szakértői szerint – hatékonyabb időjóslással megelőzhető lenne. Az amerikai központi költségvetésből 2016-ban mintegy 3,5 milliárd, míg 2012-ben – az időjárási anomáliák kiugróan magas száma miatt – 17,5 milliárd dollárt költöttek mezőgazdasági kártérítésre.

Az energiaszolgáltatók számára nemcsak a hőmérséklet-ingadozás, hanem például a szélerősség pontos kalkulációja is dollármilliókat érhet. 2015-ben például közel 50 millió dollárt spórolt a szélerősség-előrejelzések javulásán az Egyesült Államok közép-nyugati régiójának nagy részét kiszolgáló, az energia ötödét szélenergiából fedező Xcel Energy. Hasonló nagyságrendű extra profitot (vagy épp veszteséget) jelenthet egy-egy tömegeket vonzó A-ligás mérkőzés szervezőinek a rendezvény időpontjának az időjárással való körültekintő összehangolása. A repülőtársaságok pedig nemcsak azzal spórolhatnak jelentős összegeket, ha előre készülhetnek a kedvezőtlen időjárásra, hanem – főleg fel- és leszállásnál – azzal is, ha meglovagolhatják a kedvező széláramlatokat.

Tudósok nélkül mégsem megy

A jellemzően államilag finanszírozott meteorológiai szolgálatoknál egyelőre nem tartanak attól, hogy akár a szuperszámítógépek, akár az önfejlesztő algoritmusok miatt munka nélkül maradnának. Igaz, a globális időjárás alapszámításait alig tucatnyi nagy meteorológiai központban végzik a világ minden táján elhelyezett érzékelők gyűjtötte, nemzetközi hálózatba betáplált adatokból.

Az így kapott eredményeket azonban az egyes országok meteorológiai szolgálatai a saját regionális számításaik eredményeivel is kiegészítik, a nagyobb felbontású, világméretű szimulációk ugyanis jóformán teljesen vakok a relatíve kis területek speciális jellemzőire. A Kárpát-medencére jellemző „hidegpárna” például épp ezek közé tartozik – mondta a korábban már idézett Tölgyesi László. Miután a hideg levegő (télen) a medencében megül, előfordulhat, hogy nagyobb tengerszint feletti magasságokban jönnek-mennek az esetleg jelentősebb, több fokos felmelegedést okozó kisebb frontok.

Így előfordulhat, hogy a világelsőnek számító readingi meteorológiai központban – az adatok milliárdjaiban elsikkadó helyi jellemzőket figyelmen kívül hagyva – lényegesen melegebb időjárást jósolnak Magyarországra, mint ami valójában van. Ezért is lesz jó eséllyel mindig jelentősége annak, hogy a hazai meteorológusok a regionális szimulációk eredményei alapján milyen időjárást valószínűsítenek.