Történelmi fegyvertény: a Facebook algoritmusa legyőzte pókerben a legjobb profi játékosokat

Miután a Google mesterséges intelligenciával (AI) foglalkozó műhelye, a DeepMind algoritmusai emberi segítség nélkül megtanultak humán játékosokat is megszégyenítő szinten gózni és sakkozni, a Facebook felvette a kesztyűt, és egy olyan pókeralgoritmust fejlesztett ki, amely most először az összes embert legyőzte a hatszemélyes Texas Hold'Em asztalnál. Korábban csak kétszemélyes játszmában tudott győzni pókeres AI.

Pedig a Pluribus nevű bot nem kispályásokkal állt szemben: a játékosok között ott volt a négyszeres World Poker Tour-győzelmével rekordot tartó Darren Elias és a hatszoros World Series of Poker-győztes Chris „Jesus” Ferguson is, de a többiek is teljesítették azt a kritériumot, hogy legalább egymillió dollárt nyertek már pókerversenyeken – írja az MIT Technology Review.

„Kettőről hatszemélyes játékra ugrani magától értetődőnek tűnhet, de valójában hatalmas lépés. A többjátékos felállás semelyik másik tanulmányozott játékban nem merül fel” – mondta a lapnak Julian Togelius, a New York-i Egyetem AI-játékokkal foglalkozó kutatója.

Elértük az emberfeletti szintet

Az alkotók a korábban kétszemélyes pókerjátszmákban győzedelmes Libratus nevű algoritmusra építve hozták létre a Pluribust, amely egy 12 napon át tartó játéksorozatban több mint 10 ezer leosztást játszott összesen 15 profi pókeressel. Volt olyan felállás, ahol a Pluribus öt ember ellen játszott, és volt, amikor a bot öt, egymással együttműködni képtelen változata állt ki egy ember ellen, de a lényeg nem változott: a gép mindig nyert.

„Kijelenthetjük, hogy elértük az emberfeletti szintet, és ez már nem fog változni” – fogalmazott az eredményről a Verge-nek Noam Brown, a Facebook AI-kutatócsoportjának tagja, a Pluribus egyik alkotója. A Pluribus elsöprő sikere miatt a kutatók úgy döntöttek, nem teszik nyilvánossá az algoritmust, mivel annak felhasználásával pillanatok alatt csődbe lehetne vinni az online pókerben utazó cégeket.

Bár eddig a sakk és a go számított az AI ember elleni sikerei fokmérőjének, ebben a két játékban viszonylag kevés teret kap az emberi kreativitás, ráadásul az ellenfél lépései is nyíltan látszanak. A hatszemélyes pókerben elért AI-siker így nemcsak azért jelent áttörést, mert nem egy az egy ellen nyert a gép, hanem azért is, mert a játékmenetnek szerves része a rejtett kártyákkal történő taktikázás. „Teljesen elképesztő. Nem gondoltam, hogy a közelében járunk ilyesminek, csak körülbelül egy éve kezdtem el egyáltalán hinni benne” – mondta Tuomas Sandholm, a Carnegie Mellon AI-professzora, az algoritmus egyik fejlesztője.

Míg a sakkszerű kétszemélyes, zéró összegű játékokban a játékelmélet szerint mindig van egy optimális stratégia, a többszemélyes játékokban, ahol nincs egyértelmű győztes-vesztes felállás, teljesen más utakat kell bejárnia egy algoritmusnak a győztes taktika kidolgozásához. A készítők szerint a póker már sokkal jobban rímel a való élet kihívásaira, így a Pluribus olyan komplex AI-technológiák előtt nyithatta meg az utat, mint az automatizált tárgyalás vagy a csalások hatékonyabb észlelése, de az önvezető autók előtt álló problémák megoldásában is segíthet.

Mivel magát tanítja, olyan lépéseket tartogat, amik túlmutatnak az emberi logikán

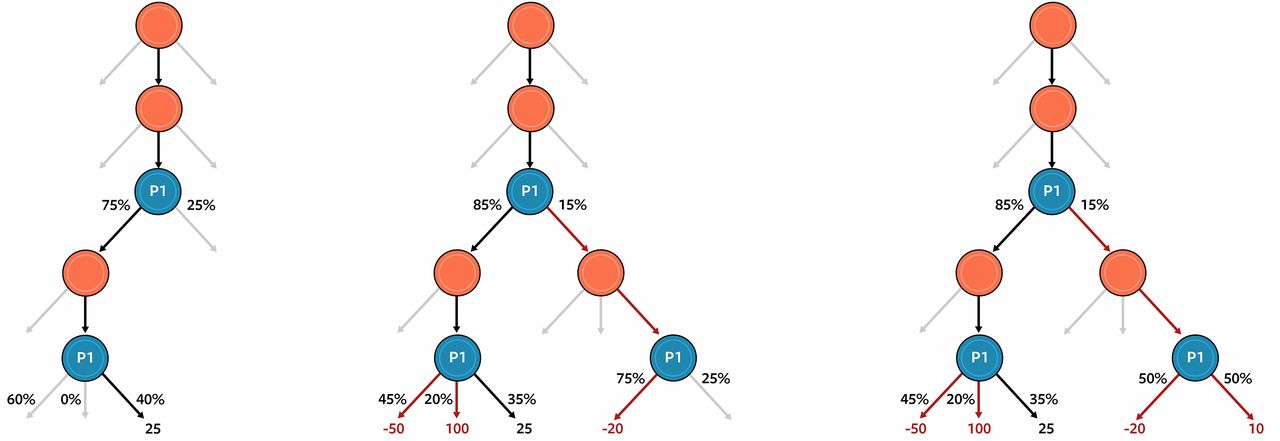

Brown és Sandholm előző pókerbotja, a Libratus a legtöbb játékos AI-hoz hasonlóan a döntési fa végéről keresett olyan lépéseket, amelyeket az adott helyzetben a legjobbnak ítélt, de ez a hatszemélyes pókerben nem célravezető. Mivel a pókerben rejtett információkkal kell dolgozni, a játékosoknak nemcsak arra kell alapozniuk a stratégiájukat, hogy milyen lapokat tartogathatnak az ellenfelek, hanem arra is, hogy ők mit gondolhatnak a többiek lapjairól az előző lépéseik alapján. Ez a felállás nyilván jelentősen megnöveli a lehetséges lépések számát.

A legnagyobb áttörést akkor érték el az alkotók, amikor sikerült egy olyan módszert kifejleszteniük, aminek segítségével a Pluribus képessé vált csak néhány lépéssel előre gondolkodni, és nem az összes lehetséges lépést tartalmazó döntési fa legvégén kereste a megoldást.

A Pluribus a Google-féle AlphaGóhoz és az AlphaZeróhoz hasonlóan gépi tanulással, tehát emberi segítség nélkül tanul játszani. Az első, esetlen játszmák után fokozatosan tanul bele a pókerezésbe: minden egyes játék után kielemzi a lépéseit, megnézi, hogy az összes lehetséges lépés közül melyikkel nyerhetett volna még több pénzt, levonja a következtetéseket, és a legközelebbi játszmára már ezek alapján építi fel a stratégiáját. Persze mielőtt emberek ellen is kiállt, előbb saját magával játszott több billió leosztást, hogy élesben már legyen egy alapvető taktikája – ennek köszönhető, hogy olyan húzásai is voltak, amelyek meg tudták lepni a tapasztalt ellenfeleit, hiszen nem emberi gondolkodásmód vezetett hozzájuk.

„Általában rá lehet jönni, hogy az ellenfeleknek mi a gyengesége, de ebben az esetben nem volt semmilyen gyengeség. Ez az AI olyan erős volt, hogy nem találtunk rajta fogást” – mesélte az MIT lapjának az egyik játékos, Jason Les, aki elmondta, az algoritmus többször rajtakapta őt blöffölés közben, de sikerült tőle ellesnie különböző technikákat is.

„Képes mindenre, amire a világ legjobb játékosai, és néhány olyan lépést is tartogat, ami az embereknek nehezen megy” – nyilatkozta az algoritmusról a New York Times-nak Darren Elias. A játékos szerint a Pluribus tudta, mikor kell blöffölni, ahogy azt is, hogy mások mikor blöffölnek, miközben mindig jókor váltott taktikát, mielőtt az ellenfelek rájöttek volna a stratégiájára.

A Pluribus sikere a Nature szerint nagyrészt a hardveres hatékonyságának köszönhető. Míg az AlphaGo 1920 processzoron futott, amikor először nyert profi játékos ellen, a Libratusnak pedig 100 processzor kellett ugyanehhez, A Pluribus már csak kettő darab (Intel Haswell E5-2695 v3) processzort használt, és kevesebb mint 128 gigabájtnyi memóriára volt szüksége. Egy leosztáshoz így átlagosan 20 másodpercre volt szüksége – ez a Science-ben megjelent tanulmány szerint kétszer gyorsabb az emberi játékidőnél.

Kapcsolódó cikkek a Qubiten:

Szintet lépett a mesterséges intelligencia: először tanult meg sakkozni egy AI emberi segítség nélkül

A Google-féle AlphaZero 9 óra alatt, a nulláról tanult meg játszani, majd legyőzte az emberi képességeken már rég túllépett gépi sakkvilágbajnokot. Ráadásul nem monoton másolással, hanem kreatív, emberire emlékeztető lépésekkel.

A mesterséges intelligencia végre feltárhatja a fehérjék szerkezetének rejtélyeit

Egyre közelebb kerülünk ahhoz, hogy pontosan meg tudjuk jósolni a fehérjék szerkezetét, ami forradalmasíthatja a biokémiát, és közelebb vihet súlyos betegségek gyógyításához is.