Íme a GT Sophy, a mesterséges intelligencia, amely a legjobb esportolókat is legyőzte a virtuális autóversenypályán

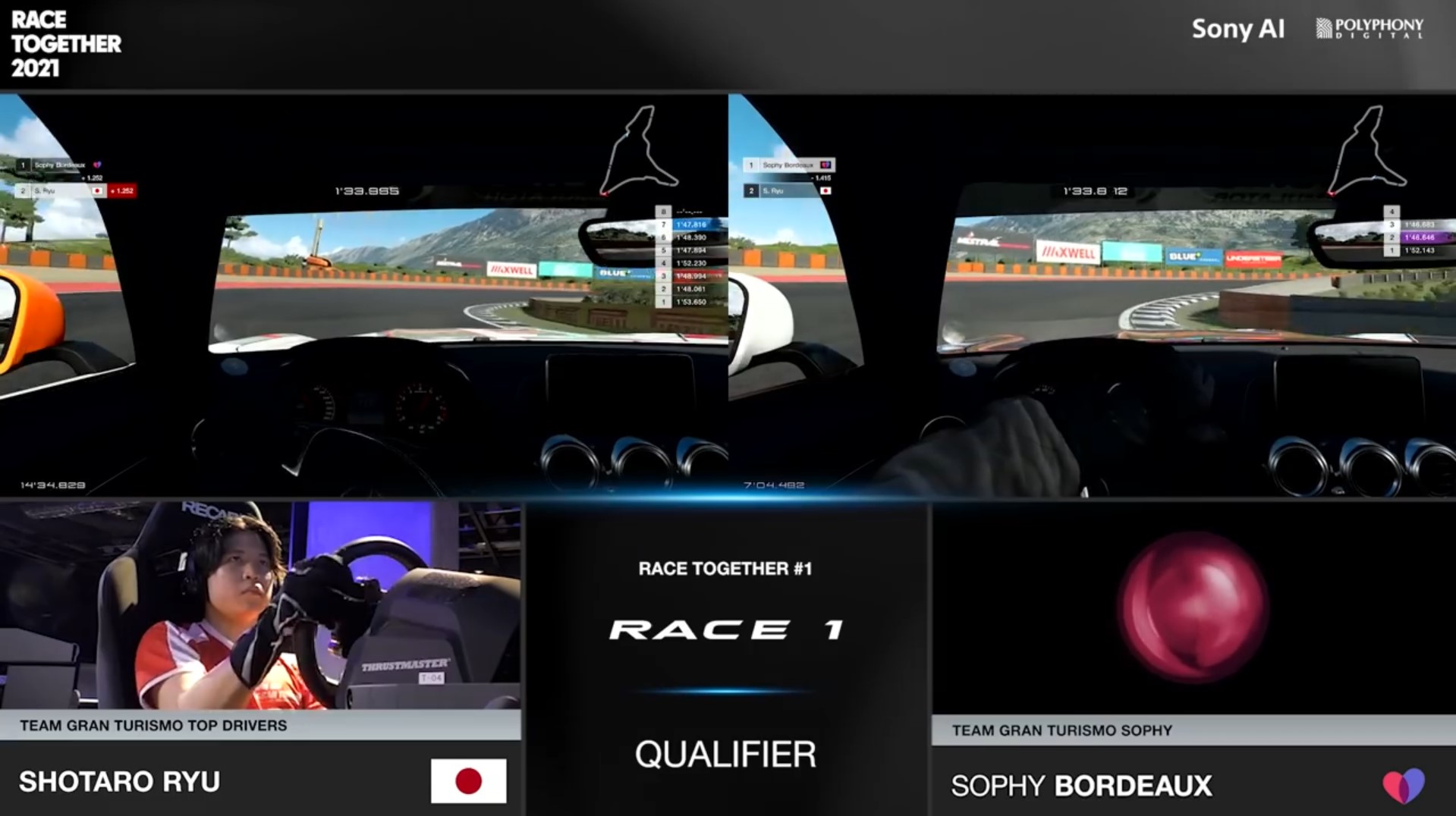

A tokiói székhelyű gigavállalat, a Sony MI-részlege, a Sony AI által kifejlesztett mesterséges intelligencia, a GT Sophy (Gran Turismo Sophy) a világ legjobb esportjátékosait is legyőzte a Gran Turismo nevű autóversenyjátékban, méghozzá úgy, hogy a szabályok betartása mellett rendkívüli szintidőt és igazi autóversenyzőkhöz méltó taktikát demonstrált. A GT Sophy az időmérő versenyen a világ legjobb Gran Turismo-versenyzői közül kiválasztott ausztrál Emily Jonest, az olasz Valerio Gallót és a brazil Igor Fragát is simán legyőzte. A később rendezett második versenyen három különböző pályán győzte le a négy sikeres japán esportolóból, Takuma Miyazonóból, Tomoaki Yamanakából, Ryota Kokubunból és Shotaro Ryuból álló csapatot.

A Nature-ben szerdán bemutatott kutatás eredményei az összes olyan AI-területet előbbre vihetik, ahol a feladatok megoldásához autonóm navigációra, valós idejű döntésekre és emberekkel való közeli interakcióra van szükség. Peter Wurman, a Sony AI amerikai részlegének vezetője és kollégái szerint az autóversenyzés, még ha szimukáció is, épp ilyen tevékensyég: valós időben, dinamikus környezetben kell irányítani egy járművet, sokszor nagyon közel kerülve a versenytársakhoz, miközben az autó tapadásának határán egyensúlyoz. A valódi önvezető autók közötti versenyekre még éveket kell várni, de addig is realisztikus szimulátorokon lehet tesztelni, hogy küzdene meg a mesterséges intelligencia ezekkel a kihívásokkal. A jelen esetben alkalmazott, csak Playstation konzolokra elérhető Gran Turismo az autók fizikai viselkedését és egy valódi többszereplős verseny körülményeit is viszonylag jól képes reprezentálni.

Egy-két nap alatt már gyorsabb volt, mint az emberi játékosok 95 százaléka

A kutatók által létrehozott GT Sophy egy mély megerősítéses tanulási (deep RL) algoritmus, amely változatos forgatókönyvek alapján gyakorolja be a vezetést, így kombinálja a kimagasló sebességet és a lenyűgöző taktikát. A mély megerősítéses tanulás technológiája már eddig is fontos szerepet játszott olyan esetekben, ahol a mesterséges intelligencia góban vagy Starcraftban legyőzte az embereket, de a kutatók úgy vélik, ahhoz, hogy a robotikában is jelentős szerepe lehessen, azt is demonstrálni kell, hogy képes bonyolult fizikai rendszereket irányítani, ahol emberekhez közel kell dolgoznia, emberi szabályok betartása mellett.

A Gran Turismóban való sikeres szerepléshez a versenyzőknek, legyenek azok emberek vagy a GT Sophy, meg kell tanulniuk jól irányítani az autójukat, el kell sajátítaniuk a versenyzés taktikáját és etikettjét, valamint stratégiai döntéseket kell hozniuk, például arról, hogy mikor előzzék meg vetélytársaikat. Bár a GT Sophy nagyon jól vezet, betartja a szabályokat, és nagyon ügyesen taktikázik az egész pályán, nem képes stratégiai gondolkodásra, azaz ellenfeleinek modellezésére és annak eldöntésére, hogy mikor érdemes megpróbálni megelőzni őket.

A GT Sophy a tanulási folyamat során 10–20 Playstationön gyakorolt, és egyszerre akár 20 autó vezetésére is képes volt. A kutatók ellátták egy a pálya nyomvonalát megadó térképpel, valamint meg tudta figyelni saját autójának és versenytársainak pontos helyzetét és sebességét a pályán, így követni tudta, hogy ki van előtte és mögötte. A GT Sophynál a kutatók egy új mély megerősítéses tanulási algoritmust is kipróbáltak, amelyet QR-SAC-nak neveztek el. Ez lehetővé tette neki, hogy megtanuljon egy szabályt, majd a megfigyelései alapján döntsön egy manőver mellett, figyelembe véve, hogy annak mekkora jövőbeli jutalma lehet. Aszerint, hogy mennyire jól teljesített a pályán, jutalmat vagy büntetéseket kapott.

A GT Sophy ezután viszonylag gyorsan, néhány óra alatt megtanulta az önálló versenyzést, és elsajátította, hogy mikor kell a szimulátor környezetével összhangban gyorsítania, lassítania vagy kanyarodnia. Egy-két nap tanulás után már gyorsabb lett, mint a Gran Turismo-játékosok közel 95 százaléka. További, nagyjából 9 napnyi tanulás és összesen 45 ezer vezetési óra után a GT Sophy további tizedmásodperceket faragott le idejéből, és sorra jobb köröket futott az emberi játékosok legjobb köridejeinél. Ugyan már korábbi AI-kutatások is el tudtak érni embereknél jobb köridőket, a kutatók szerint a többszereplős valódi verseny körülményeivel először a GT Sophy birkózott meg.

Ahhoz, hogy ezt megoldják, a kutatóknak egyrészt speciális bónuszokat kellett adniuk a GT Sophynak, hogy megtanulja lehagyni vetélytársait. Emellett ki kellett képezniük arra, hogy képes legyen megbirkózni a verseny közbeni incidenseket eldöntő bírák szubjektív értékeléseivel, azaz a versenyzési etikettel. Ezt úgy érték el, hogy minden ütközésben résztvevő versenyzőt büntettek, függetlenül attól, hogy ki volt a hibás. Mivel egy verseny során az emberek nem mindig hoznak precíz döntéseket, és az előzések csak egyes helyzetekben működnek igazán, a GT Sophyt ezek kezelésére is megtanították, változatos vetélytársak és forgatókönyvek segítségével.

Végül a világ legjobbjait is legyőzte

Bár nem lehet teljesen kiegyenlítetté tenni a szupergyors számításokra képes mesterséges intelligencia és az emberek közti küzdelmet, a kutatók a GT Sophy jelentős korlátozásával mégis megpróbálkoztak ezzel. A mesterséges intelligencia egyrészt csak 10 Hz-es frekvenciával tudott manővereket végezni az esportversenyzők által használt a 60 Hz-cel működő kormányokhoz és pedálokhoz képest. Emellett korlátozták a reakció idejét is, ami alapesetben az emberi esportjátékosok 200-250 milliszekundumához képest 20-30 milliszekundum lett volna. Több kísérletet futtattak úgy, hogy a GT Sophy reakcióidejét 100, 200 és 250 milliszekundumra korlátozták, ez azonban nem változtatott azon, hogy mindegyik esetben legyőzte az embereket köridejeivel.

Emberi játékosokkal szemben először 2021 júliusában tesztelték a GT Sophyt, ám ekkor még külön-külön versenyeztek, ennek megfelelően köridőkben simán előzte a gép az embereket. A brazíliai Igor Fragat szerint a GT Sophy „nagyon gyorsan ment be a kanyarokba, és nem veszített sebességéből a kanyar végén sem... az embereknél jobban, gyorsabban jön ki a kanyarokból. Eddig nem is tudtunk ennek a manővernek a lehetőségről, amit most a GT Sophy megcsinált." Emily Jones szerint bár ő a GT Sophyhoz képest később fékezett, az mégis sokkal jobban ki tudott jönni a kanyarokból. Mint elmondta, „eddig nem figyeltem fel erre a technikára, de most a GT Sophynak köszönhetően rájöttem, hogy rendben, akkor én is ezt fogom csinálni."

A Gran Turismót kifejlesztő Polyphony Digital japán központjában ugyanekkor egy csapatversenyt is rendeztek, ahol négy, a világ legjobbjai közül kikerülő Takuma Miyazono, Tomoaki Yamanaka, Ryota Kokubun, és Shotaro Ryu által alkotott csapattal kellett megküzdenie, három különböző pálya- és autókombinációt használva – ebben a versenyben azonban a GT Sophy kicsivel alulmaradt.

A kutatók a hibákból tanulva javítottak a GT Sophy tanulási programján, és a tanulási folyamat során használt ellenfelein. Ezután már egy 2021 októberében rendezett visszavágón a GT Sophy simán legyőzte az emberi játékosokat – 104 pontot szerezett az ő 52 pontjukkal szemben. A három közül az utolsó, több pontot érő versenyre a Le Mans-i 24 órás versenynek otthont adó Circuit de la Sarthe virtuális verzióján került sor, ahol a versenyzők és a GT Sophy a Red Bull X2019 Competition versenyautót használták, amely 300 kilométer per órás sebességnél többet is képes elérni. Mint Takuma Miyazono elmondta, a futam során barátságos rivalizálást érzett a GT Sophyval, és reméli, hogy a jövőben is tudnak vele versenyezni. Tomoaki Yamanaka azt tapasztalta, hogy „rengeteget lehet a GT Sophytól tanulni, és ezzel én is tudok fejlődni."

A kutatást a Nature-nek kommentáló J. Christian Gerdes, a Stanford Egyetem gépészmérnöki karának munkatársa szerint a GT Sophy sikere azt mutatja, hogy a neurális hálózatoknak egyszer a mainál nagyobb szerepük lehet az autonóm járművek irányításában. Ugyanakkor vannak olyan kihívások, amelyek egy valóságos verseny esetén nehéz helyzetbe hoznák a GT Sophyt. Ilyen a verseny során a megfelelő stratégiai döntések meghozatala, vagy a körök közti változások az autók irányításában, például a gumik kopása, amit Gerdes szerint elméletben a neurális hálózatok képesek lehetnek kezelni. Bár a gumik kopását más szimulátorokhoz hasonlóan a Gran Turismo is tudja modellezni, a szimulált versenyek ennek figyelembevétele nélkül zajlottak.

A GT Sophy sikere azon eredmények közé tartozik, amikor a mesterséges intelligencia különböző feladatokban képes legyőzni a legjobb emberi versenyzőket is – elég a sakkra, a pókerre, a góra vagy a Starcraftra gondolnunk. Ez a kutatók szerint igazolja, hogy lehetséges olyan mesterséges intelligenciát létrehozni, amely különböző pályákon, eltérő autók használatával is képes legyőzni a legjobb esportjátékosokat. Úgy vélik, a GT Sophy utódai nem csak élvezetesebbé és realisztikusabbá tehetik majd a következő generációs videójátékokat, hanem a való életben, így a robotikában, a drónoknál vagy az önvezető járműveknél is fel lehet majd használni őket.

Kapcsolódó cikkek a Qubiten:

A sakk és a póker után a StarCraftban is mesterszintre lépett a mesterséges intelligencia

A Google algoritmusa már az emberek 99,8 százalékánál jobban teljesít a játékban. A StarCraft a kutatók szerint ezerszer összetettebb, mint az AI által eddig tökélyre fejlesztett go, sakk és póker.

A DeepMind mesterséges intelligenciája már egy középiskolás szintjén teljesít szövegértésben

Állampolgári ismeretekből 83,9, pszichológiából 81,8 százalékos eredményt ért el az eddigi leghatékonyabb nyelvi AI-modell, a Gopher a középiskolai teszteken. Matekból és fizikából kell még javítani.

Áttörést hoz a biológiába a minden eddiginél pontosabb fehérjekutató algoritmus, az AlphaFold2

A Google-féle DeepMind legújabb AI-modellje az aminosavak sorrendjéből egész pontosan megfejti a fehérjék háromdimenziós térszerkezetét. A mesterséges intelligencia forradalmasíthatja a gyógyszerkutatást: van olyan rákkutató cég, ahol az AlphaFold2 a korábbi egy hónapról néhány órára csökkentette a hatóanyag-jelölt fehérjék megtalálását.