Egyszerű szövegekből videókat kreál a Meta új AI-modellje

Az utóbbi hónapokban ellepték az internetet a mesterségesintelligencia-alapú képgenerátorok, például az OpenAI-féle Dall-E 2, amely elképesztően jó minőségben generál szörnynek kinéző gyapjúlevest és steampunk medvéket is, vagy az elődeivel ellentétben nyílt forráskódú Stable Diffusion.

Mark Zuckerberg Metája tegnap egy újabb AI-modellel emelte a tétet az algoritmikus tartalomgyártásban: csütörtökön bemutatta a Make-A-Video programot, amely egyszerű szövegből képes videót generálni.

A Meta gépi tanulással foglalkozó mérnökei olyan modellt hoztak létre, amely néhány másodperces, mozgó képkockákat kreál az írott szövegből, állóképeket is bemozgat és már meglévő felvételeket is továbbfejleszt. A videókról egyelőre ordít a mesterkéltség, az animáció nem tökéletes és a tárgyak is elmosódnak, a fejlesztés azonban mégis óriási lépés az AI-alapú kontentgyártás terén.

Mark Zuckerberg Facebook-posztjában azt írta, a képeknél sokkal nehezebb videókat generálni, mivel a szoftvernek minden egyes pixel megfelelő legenerálásán túl azt is előre meg kell tudnia mondani, hogy azok hogyan fognak változni. A Make-A-Video ezt egy olyan mélytanuló algoritmus segítségével oldja meg, amely lehetővé teszi a modellnek, hogy megpróbálja a maga módján „megtanulni”, hogyan működik a mozgás a fizikai világban, és alkalmazza ezt a hagyományos, szövegből generált képek esetén. Ezt nevezik felügyelet nélküli gépi tanulásnak (unsupervised learning).

A Meta AI-kutatói a modellt magyarázó tanulmányukban azt írják, hogy a Make-A-Video programot felcímkézett képpárokon és jelöletlen videóanyagon tanították. Ez utóbbi több millió videófelvételt jelent a WebVid-10M és a HD-VILA-100M adatbázisokból, és az internetről leszedett videóktól kezdve stockvideókig bezárólag rengeteg órányi képkockát tartalmaz.

A videókat mindenesetre a Meta tette közzé, és egyelőre senki más nem férhet hozzá a modellhez, vagyis könnyen lehet, hogy a cég kiválogatta a legjobbakat, hogy a lehető legjobb színben tüntesse fel a programot.

De nem csak a Meta kísérletezik szövegalapú videógyártó programokkal. A Csinghua Egyetem és a Pekingi Mesterséges Intelligencia Akadémia (BAAI) kutatói például szintén idén tették közzé saját modelljüket, a CogVideo nevű szoftvert, amely szintén szövegből generál videót. Alább néhány példa, hol tartanak a kínaiak.

Kapcsolódó cikkek a Qubiten:

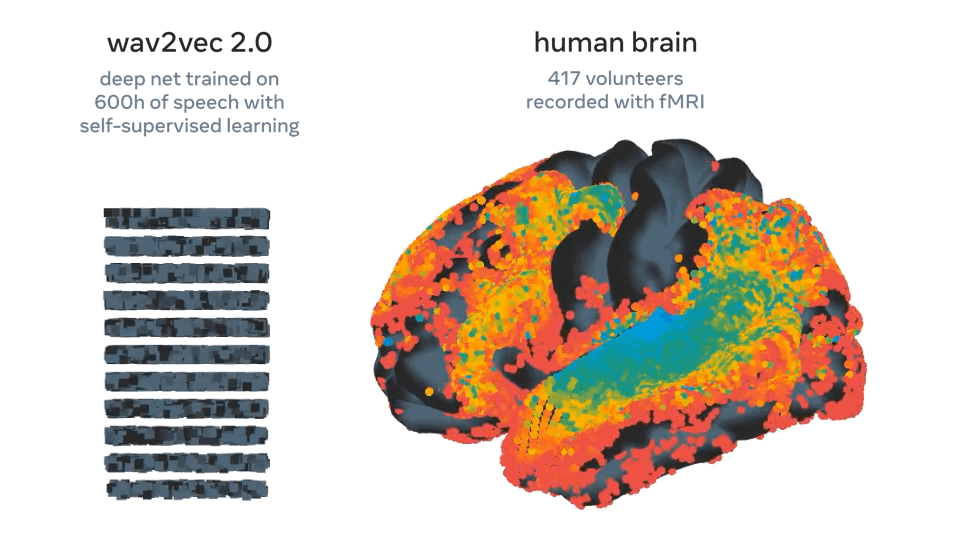

A Meta olyan mesterséges intelligenciát fejlesztett, amely az agyhullámokból találja ki, mit mondunk

A rendszer 73 százalékos pontossággal megjósolta, hogy egy elhangzott beszéd milyen szavakat tartalmazott, és bár korai szakaszában jár a technológia, a legtöbb hasonló megoldással szemben nincs hozzá szükség invazív beavatkozásra.

A Meta és az Nvidia a világ leggyorsabb szuperszámítógépét fejlesztik

A Research SuperCluster (RSC) névre keresztelt mesterségesintelligencia-alapú rendszer év közepére épülhet meg. A szuperszámítógép lelkét 760 Nvidia DGX A100 rendszer alkotja, és összesen 6080 grafikus processzora van.

70 ezer órát szánt rá, de megtanult minecraftozni az OpenAI mesterséges intelligenciája

Mondhatni, az emberek segítettek neki: A Youtube-on nézett meg ennyi videót. És már gyémántcsákányt is tud építeni!