Kulcsszerepet játszanak a magyar szakemberek a világ legnagyobb részecskegyorsítójának fejlesztésében

Kedden magyar részecskefizikusok és szakemberek virtuális bemutatót tartottak az Európai Nukleáris Kutatási Szervezet (CERN) központjából és a Nagy Hadronütköztető (Large Hadron Collider, LHC) részecskegyorsító detektorai mellől. A Wigner Fizikai Kutatóközpont és a CERN sajtóirodája által szervezett program során kiderült, hogy magyar kutatók és mérnökök is kulcsszerepet játszanak az LHC fejlesztésében. Ez reményeik szerint a következő években a Higgs-bozon jobb megértéséhez, és a részecskefizika standard modelljén túlmutató fizika megpillantásához járulhat hozzá.

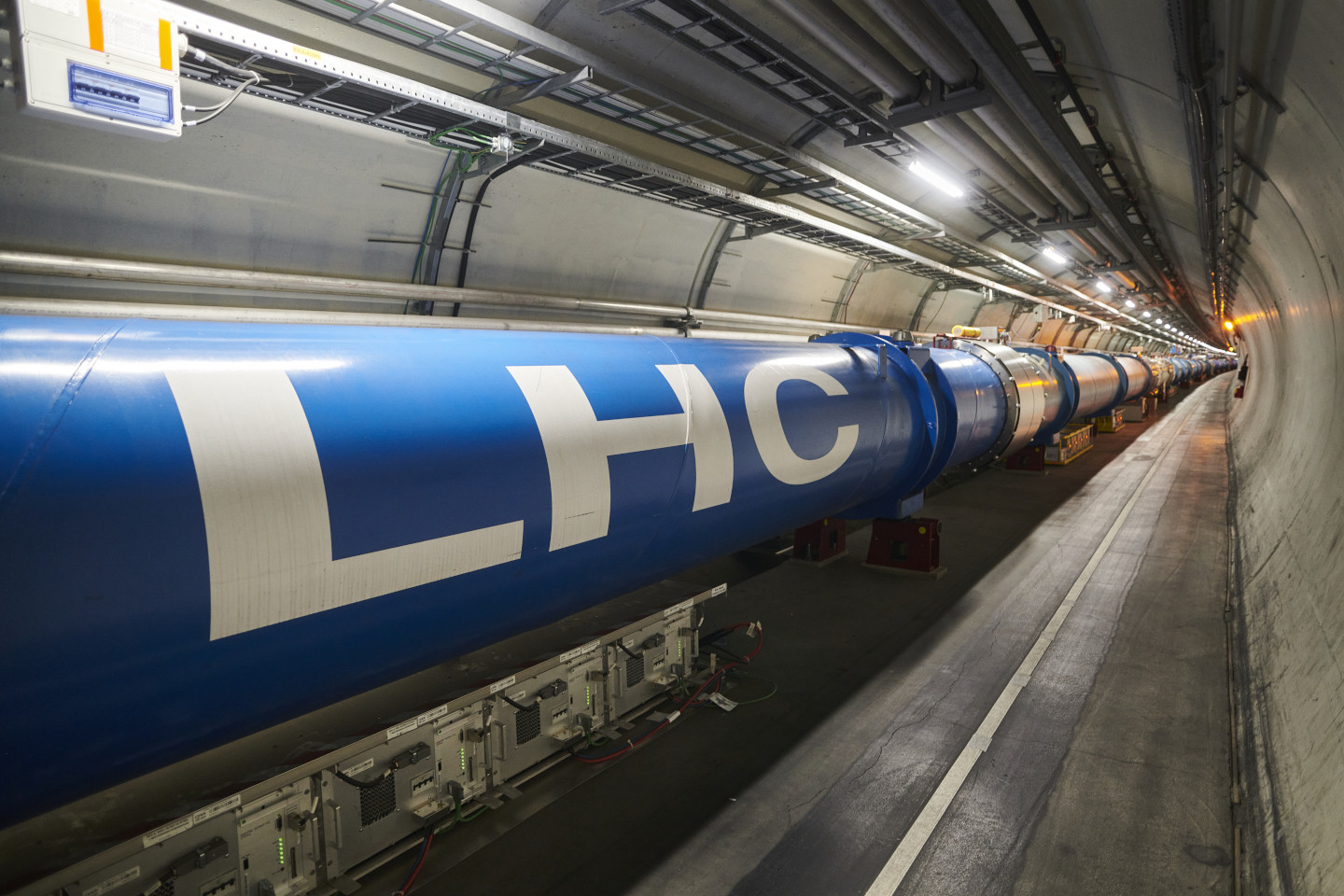

A félig svájci, félig francia területen elhelyezkedő CERN több részecskegyorsítóval rendelkezik, közülük a 27 kilométer hosszú LHC gyűrű a legnagyobb. Az LHC-ben négy detektor, az ATLAS, a CMS, az ALICE és az LHCb vizsgálja az univerzumot felépítő anyag rejtelmeit – ezek már több mint 10 éve tették lehetővé a standard modell által megjósolt Higgs-bozon felfedezését. Az LHC betáplálását több kisebb részecskegyorsító adja, köztük a nemrég jelentős fejlesztésen átesett Linac4, valamint az LHC előfokozatának tekintett, 7 kilométeres kerületű Szuper Protonszinkrotron (SPS). Ezek számtalan más kísérletet is ellátnak protonokkal, amelyeknek az előállított mennyiségéből az LHC csak 1-2 százaléknyit használ fel.

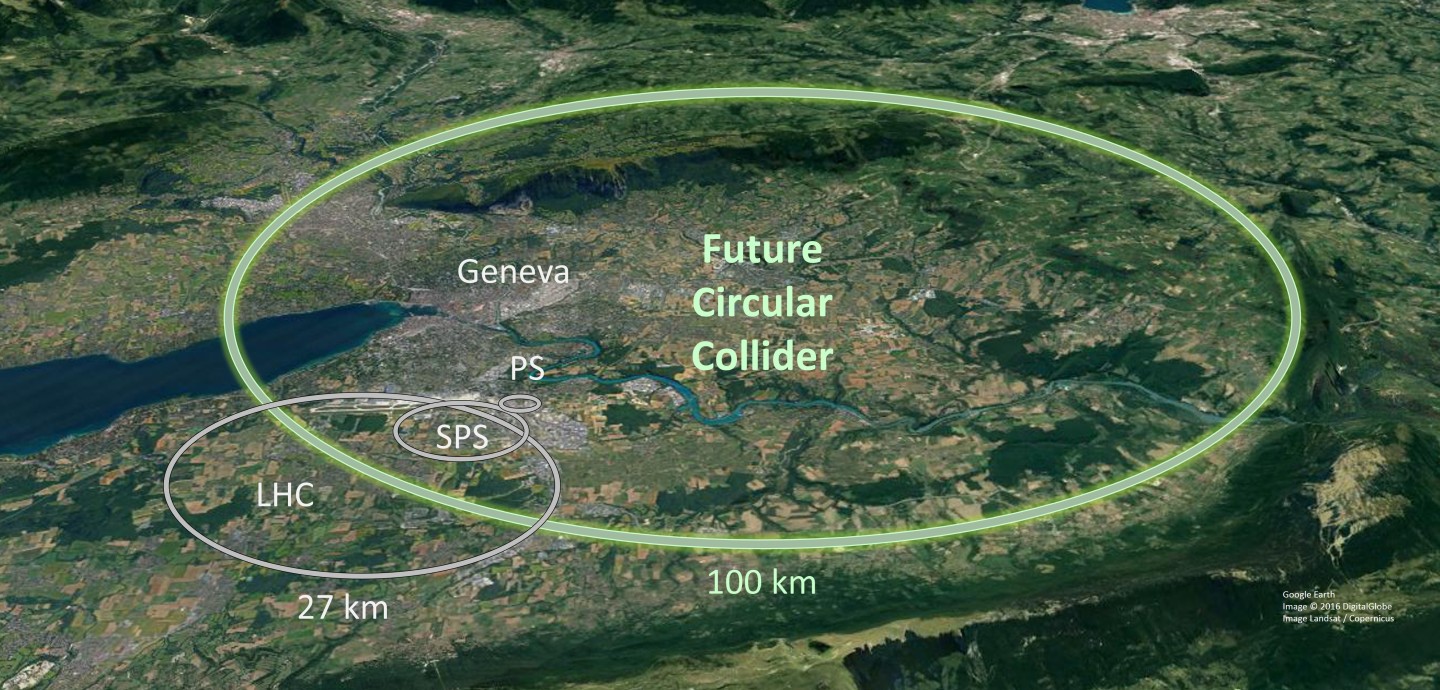

Az LHC a téli szünet után március 27-én indul majd újra, mondta el Bukovics Tibor, aki a CERN vezérlőközpontjában az LHC-t betápláló kisebb gyorsítók felügyeletével és szoftverfejlesztéssel foglalkozik. A Nagy Hadronütköztető következő nagy fejlesztési projektje, a nagy luminozitású LHC (High Luminosity LHC, HL-LHC) a tízszeresére növelheti az összegyűjtött adatok mennyiségét – ez a projekt már folyamatban van, várhatóan 2029-ben készül majd el. Emellett továbbra is tervezés alatt áll a 100 kilométer hosszú jövőbeli gyorsítógyűrű (Future Circular Collider, FCC) is, amely a nagy luminozitású LHC-t válthatná föl 2040 után.

Magyarország 1992. június 1-je óta teljes jogú tagja a CERN-nek, 22 másik országgal együtt, és jelenleg a költségvetés 0,73 százalékát fizeti be. A kutatóintézetben kisebb-nagyobb megszakításokkal 98 magyar szakember dolgozik, akik közül 15-en CERN-alkalmazottak.

Az univerzum keletkezésének körülményeit vizsgálják az ALICE-szal

Barnaföldi Gergely Gábor, a Wigner Fizikai Kutatóközpont tudományos főmunkatársa 80 méterrel a felszín alól, az ALICE kísérlet mellől jelentkezett be. A magyar ALICE csoport munkáját irányító fizikus elmondta, a kísérlet célja az, hogy ólom-ólom atomok ütköztetésének segítségével előállítsa a kvark-gluon plazmának nevezetett állapotot, amely az univerzum születése utáni másodpercekben létezhetett.

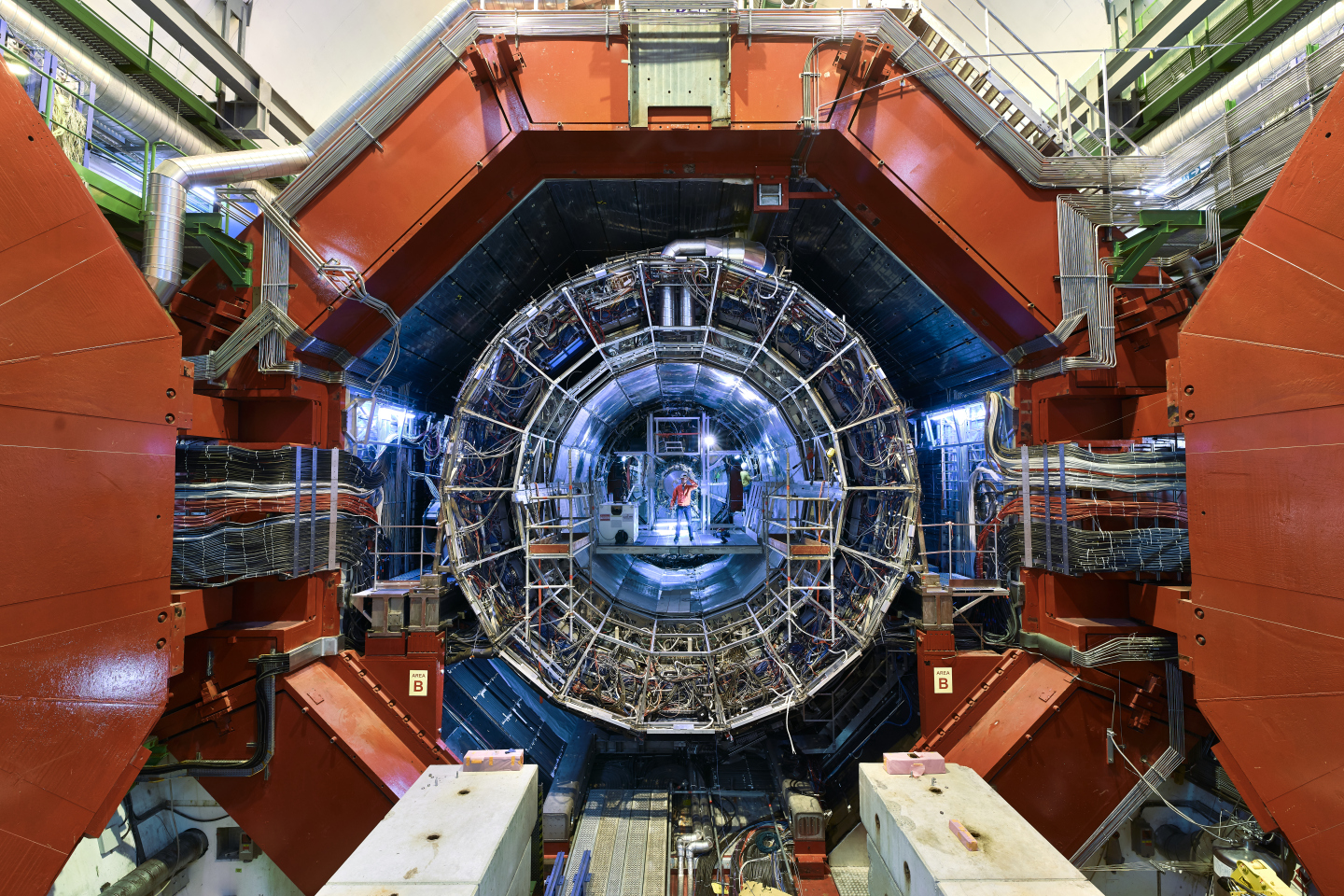

Az LHC gyorsító alagútjából a részecskenyaláb egy hatalmas, vörösre festett ajtó mögött található detektorba jut, amely 13 méter átmérőjű és 26 méter hosszú, azaz több autóbusz is elférne benne. A nyaláb maga egy vastag, csillogó csőben helyezkedik el, ami elnyeli az előre szóródó részecskéket. Az ALICE középső részét az L3-nak nevezett, piros színű szolenoid mágnes burkolja, a hátulján pedig egy kékre festett, dipólus mágnes található, amelynek hála müonokat lehet észlelni. A csarnokban a detektort táp-, hűtő-, és adatgyűjtő egységek veszik körbe.

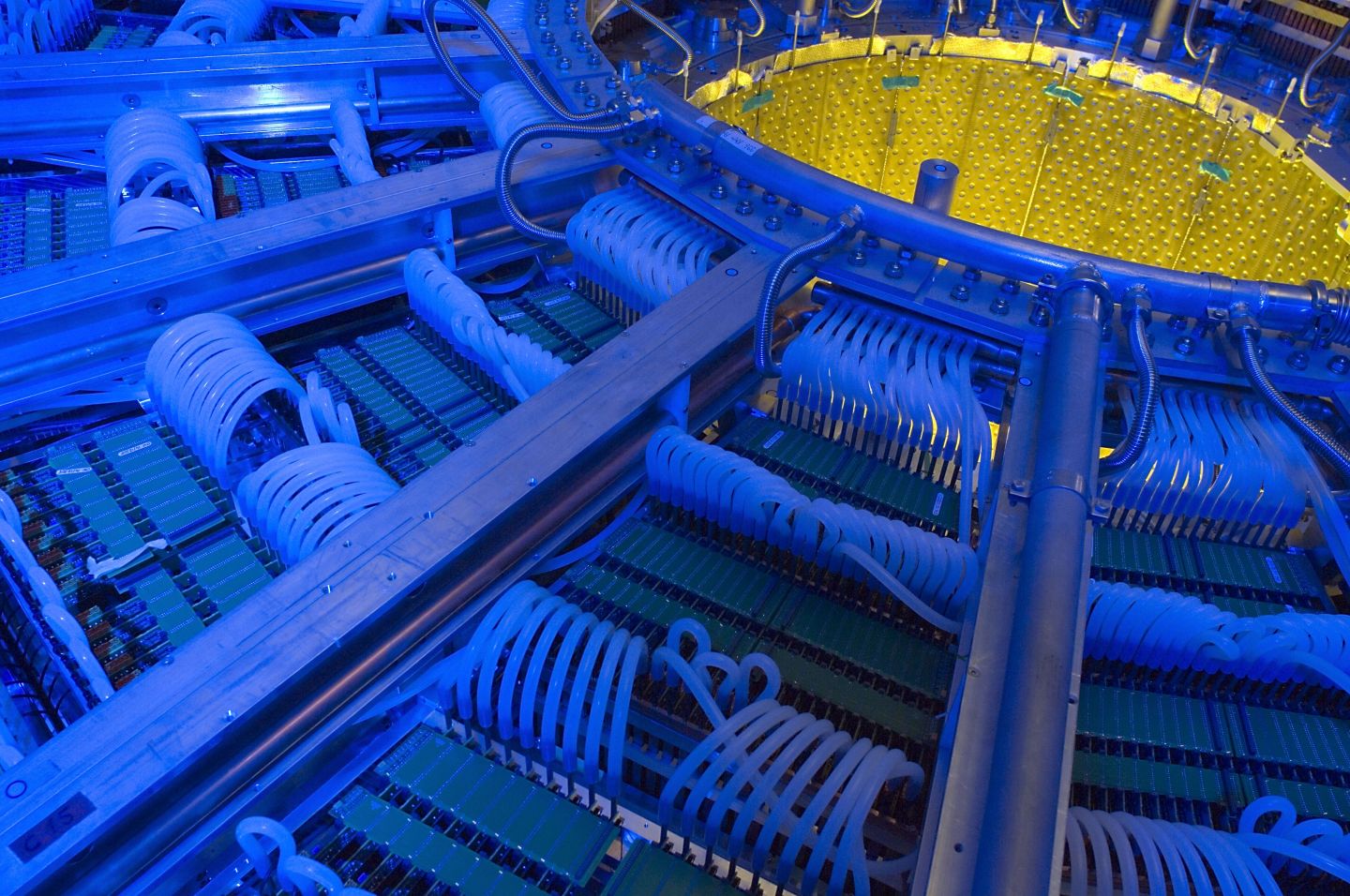

A megnövelt luminozitású LHC-ben másodpercenként 50 ezer ólom-ólom ütközés történik majd, amiből egyenként fél-fél gigabájt adat keletkezik. Mint Barnaföldi elmagyarázta, ezt ki kell hozni ebből az óriási felületű, több millió szenzorból álló berendezésből. A fizikus elmondta, hogy Magyarország adta a detektor adatgyűjtő rendszerének a lelkét, ami ki tudja vezetni a berendezésből a keletkező hatalmas mennyiségű adatot, amit aztán a számítógépek később feldolgoznak. Ehhez olyan sugárzásálló berendezéseket fejlesztettek, amelyek másodpercenként 4 terabit sebességgel tudják összegyűjteni az adatokat.

Barnaföldi szerint az elmúlt években végzett fejlesztési munkák eredményeként, amihez a magyar csoport is hozzájárult, jelenleg is tudják mérni a kvark-gluon plazma tulajdonságait. Ezekből a belső nyomkövető rendszert, több aldetektort és a világ legnagyobb ilyen típusú, 90 köbméter térfogatú időprojekciós kamráját (TPC) emelte ki, amiknek egy része Magyarországon, míg másik része a CERN-ben készült, szintén magyar szakemberek bevonásával. Míg a belső nyomkövető rendszer az ütközések észlelésére, addig az úgynevezett gázelektron-sokszorozó (Gaseous Electron Multiplier, GEM) technológiára épülő időprojekciós kamra a részecskepályák rögzítésére szolgál.

A fizikus szerint utóbbival nem csak azt tudják nagyon pontosan megmondani, hogy merre ment egy adott részecske, hanem az is rögtön kiderül, hogy milyen fajta keletkezett. A részecskék összetétele pedig a létrejött anyag tulajdonságairól árulkodik, és hogy ha ez olyan, mint az univerzumban az ősrobbanás utáni mikromásodpercekben volt, akkor ez a saját eredetünket is segíthet visszakövetkeztetni. Barnaföldi elmondta, hogy olyan mennyiségű információt kaptunk a kvark-gluon plazmáról az elmúlt 30 év alatt, ami csak egy közel 330 oldalas összefoglaló műben fért el – ez tavaly év végén jelent meg.

Az időprojekciós kamra fejlesztése során fellépő kihívásokról Barnaföldi elmondta, hogy korábban a legnagyobb hasonló berendezés is legfeljebb csak néhány négyzetméteres volt, így a tervezési fázisban még nem látszódott, hogy ez működhet-e a valóságban a detektor méreteiben is. Aztán amikor elkészült az első, 10 négyzetméteres darab, már megnyugodtak, hogy jól fog teljesíteni. A nehéz, de egyben csodálatos pillanat az volt, amikor összerakták a külön-külön legyártott elemeket a CERN-ben, és működésbe lendült az időprojekciós kamra.

A korábbi megoldáshoz képest a berendezés különlegessége a fizikus szerint abban rejlik, hogy ez folyamatosan szolgáltatja az adatokat, azaz trigger nélküli módban működik. A trigger alatt azt a folyamatot értik, amikor az egész detektorban minden aldetektor jelez, hogy készen áll a mérésre, és amikor ez megtörténik, akkor mérnek egyet. Ez egy hagyományos időprojekciós kamránál elég hosszú idő, míg a GEM-et alkalmazó berendezésnél már sokkal gyorsabb, és az adatok is folyamatosan jönnek belőle, ami miatt a jövőben jóval több eseményt el tudnak majd kapni.

Az adatszortírozást segítik a CMS új müonkamrái

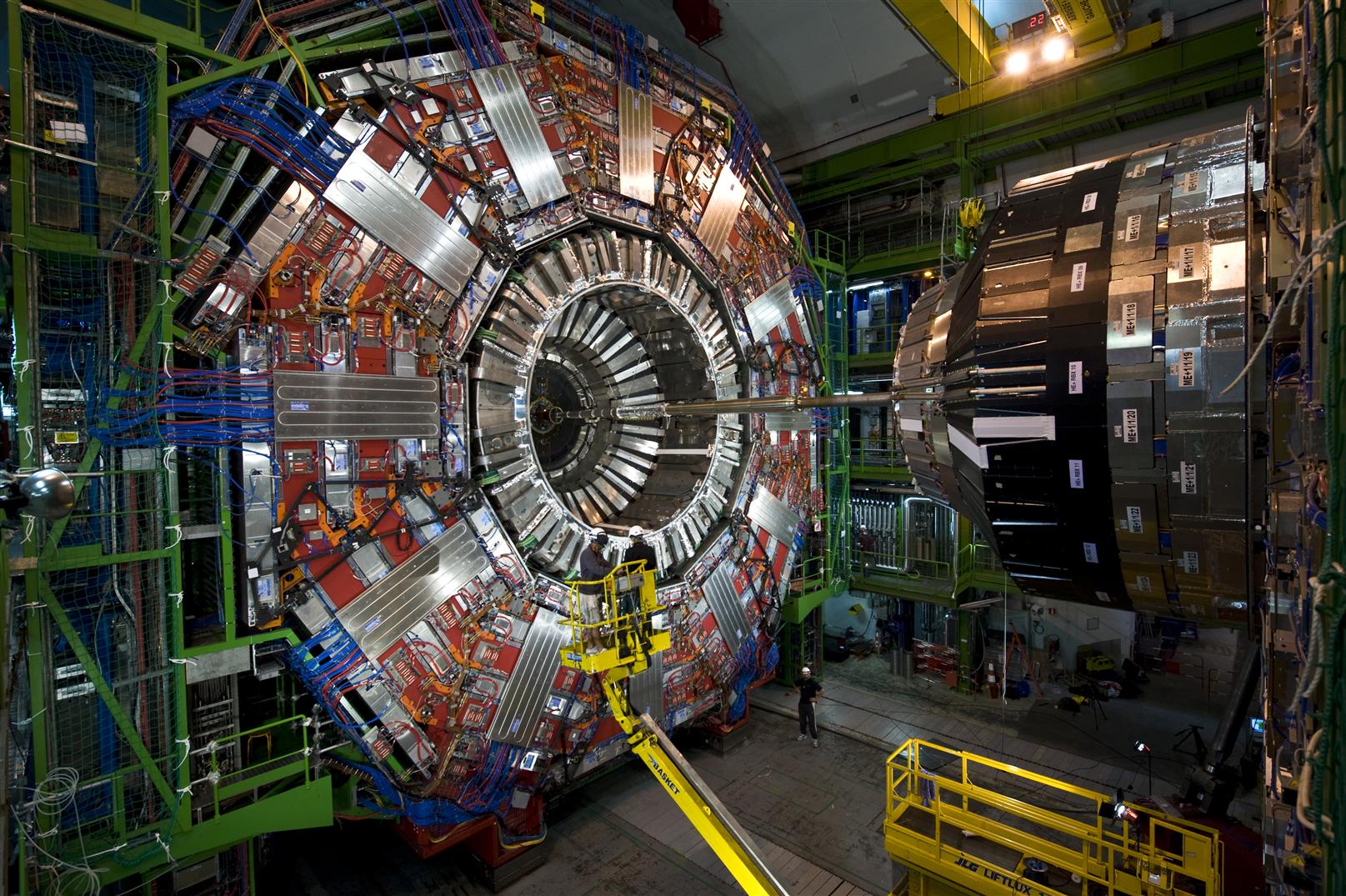

A kompakt müon szolenoid (Compact Muon Solenoid, CMS) detektorcsarnokban Béni Noémi, a Debreceni Atommagkutató Intézet tudományos munkatársa tartott virtuális vezetést. Először az LHC alagút széléről induló nyalábcsövet pillanthattuk meg, ahonnan a detektor felé haladnak a protonok. Ezeket az 1-2 mm átmérőjű protonnyalábokat a hajszálnál vékonyabbra fókuszálják össze, hogy a detektor közepén értékelhető mennyiségű ütközés keletkezhessen, magyarázta Szillási Zoltán, a Debreceni Atommagkutató Intézet tudományos főmunkatársa. Béni mögött ezután feltűnt az ALICE-nál is nagyobb, kör alakú CMS detektor, amelyen a két magyar kutató több mint 10 éve dolgozik.

A detektor súlya két Eiffel-toronyénak felel meg, amit a vörösre festett, vasból készült külső részek okoznak, mondta Szillási. Ezek lényegében visszafordítják és bezárják azt a Föld mágneses teréhez képest százezerszer erősebb teret, amit a közepén található hatalmas szupravezető mágnes kelt, hogy az kezelhető és homogén legyen. A felszínen megépített detektort – ami lényegében egy, a hadronok energiájának mérésére szolgáló kaloriméter – egy jókora aknán eresztették le az LHC építésekor a 85 méter mélyen található mai helyére. A detektor nevéhez hűen tényleg kompakt, ami Szillási szerint azzal jár, hogy az egyes elemeihez és a külső berendezésekhez is korlátozottan lehet hozzáférni.

A bemutató alatt a szakemberek éppen a detektor másik részének összezárásán dolgoztak, így be tudtunk pillantani a lenyűgöző műszer belsejébe. Béni itt megmutatta a már említett GEM technológián alapuló müonkamrákat, amelyek szerinte a jövő detektorainak számítanak, és az ALICE-hoz hasonlóan a trigger folyamat javításában vesznek részt. Szillási hozzátette, hogy a magyar segítséggel megépített berendezések jelentőségét többek közt az adja, hogy eddig nem voltak olyan műszerek, amik ezt a rendkívüli részecskefluxussal rendelkező környezetet kibírták volna.

Arra a kérdésünkre, hogy a müonkamrákon kívül milyen más fejlesztések történtek az elmúlt években, Szillási azt válaszolta, hogy az igazán komoly változások a nagyjából 2026-ban kezdődő és 2029-ben véget érő harmadik nagy leállás során várhatók. Ekkor lecserélik majd a detektor legmélyén található elektromágneses kalorimétert, valamint a részecskék pályáját követő trackert egy nagyobb felbontású műszerre. A legfontosabbnak a detektort lezáró „orrba” elhelyezendő, úgynevezett nagy granularitású kalorimétert nevezte, amely a detektor helyfelbontását, valamint az előre irányuló energia felbontását javítja majd jelentős mértékben.

A fizikus szerint „ha itt minden adatot, mindig ki akarnánk szedni a detektorból, akkor azt szoktuk mondani, hogy a Jóisten sávszélessége sem lenne ehhez elegendő. De ha ez sikerülne, akkor a tárolással lenne gond, ha pedig még azt is megoldanánk, akkor meg az analízisre nem jutna a világon elegendő CPU, tehát valamit csinálni kell”. Erre való a trigger, amivel megpróbálják csak azoknak az eseményeknek a méréseit kiszedni a detektorból, amik izgalmasnak tűnnek. Mint Szillási elmondta, ha az ütközési pontból jó időben müonok jönnek ki, akkor valószínű, hogy olyan fizika történt, ami érdekes.

A mesterséges intelligencia nem játszik nagy szerepet a CERN-ben

Kérdésünkre, hogy mennyiben jelenthetnek megoldást a gépi tanulási algoritmusok ezekre az adatfeldolgozási kihívásokra, Barnaföldi elmondta, hogy „a gépi tanulást itt a CERN-ben adatelemzésre körülbelül az 1970-es években elkezdtük használni”. Ráadásul ez éppen a magyarok munkája volt, akik a kvark és gluon nagyenergiás részecskezáporokat (jetek) próbálták meg szétválogatni egy neurális hálóval megírt kóddal. A nehézség annak idején az volt, hogy magát a hálót is meg kellett írni, és nem lehetett a polcról levenni, mint most a legtöbb esetben.

A szakember szerint a kérdés másik oldala, hogy azokon a területeken, ahol ma az iparban sok helyen használják a gépi tanulási algoritmusokat, ott valamilyen nagyon komplex, általában sok paraméteres és bemenő adatos megoldásra van szükség. Mint mondta, a CERN-ben az adatelemzési folyamat elején alkalmazzák ezeket az újonnan elterjedt technológiákat, de általában inkább csak szortírozásra. Barnaföldi szerint viszonylag könnyű eldönteni ezekkel, hogy egy adat hibás eredetű-e, és általában sokkal többet nyernek azzal, ha kiszórják a hibásnak vagy nem fontosnak tartott adatokat.

A kutató szerint az az érdekes, hogy ennek az egész adatfolyamnak a végén, magára az adatok elemzésére vannak próbálkozások, de ezek rendkívül nehezen terjednek el a tudományban. Ennek szerinte az az oka, hogy azt a több szigmás pontosságot, amit nemcsak a fizikusok várnak el egymástól, hanem a társadalom is a fizikusoktól, ezek az algoritmusok még nem nagyon tudják hozni, vagy nem becsülhetők meg belőlük annyira nagy biztonsággal a hibahatárok. Ezt azzal érzékeltette, hogy nehéz lenne bebizonyítani, mekkora volt a tényleges hiba abban az esetben, ha a Higgs-bozont egy gépi tanulásos algoritmus ásta volna ki a rengeteg adatból.

Horváth Dezső, a Wigner Fizikai Kutatóközpont emeritus professzora és a CMS kísérlet résztvevője is megosztotta saját tapasztalatát ezzel kapcsolatban. Az egyik nagyenergiájú kísérletben egy bonni és egy calgaryi csoport versengett egymással, ami megszokott az ilyen adatértékelési folyamatoknál, és a kanadaiak egy korai neurális hálót használtak, míg a németek egy hagyományos, legnagyobb valószínűségnek (maximum likelihood) nevezett módszert. Ennek az volt a következménye, hogy a kanadai csoport egyszerűen lemaradt az eredményről, annak ellenére, hogy a válogatásuk látszólag valamivel pontosabb volt, mert a szisztematikus bizonytalanságot nem tudták megbecsülni. Az egyévnyi munkájukból így egyetlen mondat került be a végleges publikációba arról, hogy ezeket az adatokat a neurális ideghálók módszerével is elemezték, és hasonló eredményt kaptak.

Barnaföldi hozzátette, hogy pont egy magyar kutató, ifj. Krasznahorkay Attila felel az ATLAS kísérletben a gépi tanulásért, aki ott kifejezetten jetek elemzésével és az erre való stratégia kidolgozásával foglalkozik. Ez szerinte nem egy egyszerű feladat, mert a neurális hálót valamilyen mintán tanítják, és ha nem tudják nagyon pontosan azt a mintát jól meghatározni, amivel a hálót validálják, akkor az egész próbálkozás hiábavaló. Mint mondta, ez az adatforgalom és adatminőség ellenőrzésre nagyon jól használható, de az a kérdés túlságosan nyitott, hogy létezik-e egy új részecske, így azt nem lehet az algoritmusnak ledefiniálni.

Mit hoz a jövő?

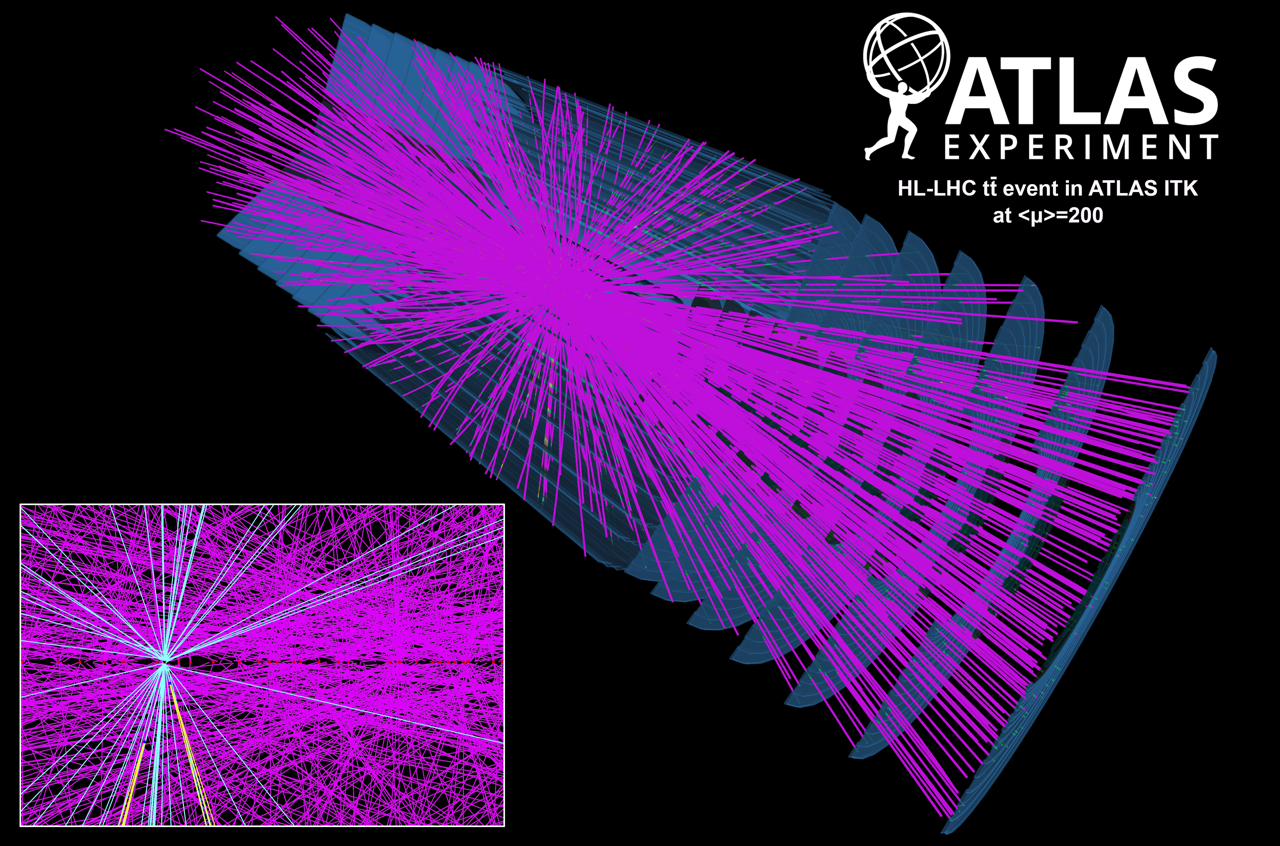

Arról, hogy a mostani tervek szerint 2029-re elkészülő nagy luminozitású LHC (HL-LHC) milyen új vizsgálati irányokat és előrelépéseket tesz lehetővé, Szillási elmondta, hogy a fejlesztés lényegi eredménye, hogy a segítségével nagyon sok részecskeütközést lehet majd létrehozni. Azt tudni kell, hogy ezek a folyamatok, (például a Higgs generálása) borzasztó ritkán zajlik le proton-proton ütközéseknél – az LHC indításakor elért energiaszinten 3 ezer milliárd ütközésenként volt várható egy Higgs. Ahhoz viszont, hogy a Higgs paramétereit behatóbban vizsgálni lehessen, rengeteg statisztika és sok ilyen ütközés kell.

Az ütközések számának növelésével továbbá könnyebben meg lehet találni a részecskefizika standard modelljén túlmutató, a gyorsító által ezen az energiaszinten direkt módon el nem érhető részecskék valamiféle lenyomatát is. Erre a kutató szerint megvan a precedens a részecskefizikában, de ahhoz, hogy ezek a nüansznyi különbségek kijöjjenek az elmélet és a mérések között, nagyon sok adat kell.

Bajkó Márta, aki 24 éve dolgozik a CERN-ben, és részt vett az LHC szupravezető mágneseinek kifejlesztésében is, elmondta, hogy ha az LHC-t nem újítják fel, akkor a szakemberek nem tudják garantálni, hogy a részecskegyorsító bizonyos részei korrekt módon működnek. Erre példaként a detektorok két oldalán található mágneseket hozta, amelyek több éves működésük alatt jelentős sugárzást kaptak. A fejlesztés során néhány száz mágnest cserélnek majd ki, fejlettebb technológiájú, nedímium-ón alapúra, amelyekkel képesek lesznek erősebb mágneses teret generálni. A szakember szerint egy ilyen motivációja is van a HL-LHC-nek, hogy ezeket mindenképpen föl kell újítani, és ha ez megvalósul, akkor természetesen jobb, ha a felújítással együtt egy nagyobb kapacitású, jobb gépet tudnak létrehozni.

A cikk eredeti változatában nem szerepelt, hogy másodpercenként történik majd „a megnövelt luminozitású LHC-ben 50 ezer ólom-ólom ütközés”. A hibáért elnézést kérünk.

Kapcsolódó cikkek a Qubiten:

Boldog 10. születésnapot, Higgs-bozon!

A CERN kutatói 2012. július 4-én jelentették be a Higgs-bozon felfedezését, ami hatalmas mérföldkő a részecskefizikában. Most, tíz évvel később elmondható, hogy az LHC részecskegyorsító adatai szerint minden eddigi mérés egybevág a részecskefizika standard modelljével.

100 kilométeres új részecskegyorsítót tervez a CERN

A részecskefizikusok a következő egy évben dönthetik el, hogy javasolják-e az európai nukleáris kutatási szervezetnek az óriási gyorsítógyűrű megépítését. Nem minden kutató lelkesedik a bizonytalan kimenetelű projektért.

A fizikusok a szépség bűvöletében élnek, és közben eltávolodtak a természet megértésétől

Az elméleti fizikában negyven éve nem történt jelentős áttörés, mégpedig azért, mert a fizikusok a szép elméletek bűvöletében művelik a tudományt, miközben egyre inkább eltávolodnak az igazolható elméletek világától. A szépség hajszolása tehát elfedi előlük, így előlünk is a természeti világ valódi lényegét – állítja Sabine Hossenfelder német fizikus, aki nemrég a magyar közönségnek is kifejtette nézeteit.