A Mátrixba illő adatközpontokba szerveztük ki az életünket, és ezek egyre több áramot követelnek

A legfrissebb felmérések szerint egy ember naponta átlagosan 6 óra 40 percet tölt az internet böngészésével valamilyen eszközön. Ez azt jelenti, hogy az éber óráinak jó negyven százalékát online tölti, vagyis egy évben úgy 100 teljes napon át aktív részese a legnagyobb globális hálózatnak. És ez csak az átlag; hányan vannak, akik a nyolc munkaórájukból hetet végigneteznek, aztán otthon átpörgetik – generációjuknak és kultúrkörüknek megfelelően – a Facebookot, Instát, TikTokot, megnéznek pár Youtube-videót, elalvás előtt még lemehet egy-két epizód a Netflixen is, és máris megvan a napi tíz óra, alsó hangon.

Az internetet már rég készpénznek vesszük – persze egyre többen vannak, akik beleszülettek a digitális életbe, de a tőlük idősebbek is hajlamosak elfelejteni, milyen volt, amikor nyugodtan meg lehetett ebédelni, mire lefuttatott egy keresést az Altavizsla. Hogyha ma beírom a telefonom böngészőjébe, teszem azt, hogy www.qubit.hu, akkor körülbelül két másodperc alatt ott van az egész oldal a szemem előtt, pedig a wifin, a routeren, az internetszolgáltatón, a tűzfalakon és adatközpontokon keresztül több száz különálló folyamat játszódik le a háttérben, cache-eléssel, csomagolással, titkosítással, azonosítással, mindennel.

Ezek legnagyobb része adatközpontokban történik, vagyis olyan létesítményekben, ahol nagy teljesítményű számítógépek (szerverek) és hálózati eszközök tömegei tárolják, dolgozzák fel és továbbítják a megfelelő helyre azokat az óriási adathalmokat, amelyekből felépül az internet. Az adatközpontok adják tehát a világháló gerincét, és el lehet képzelni, hogy az internethez való hozzáférés terjedésével, az okostelefonok, a felhőszolgáltatások, a közösségi média, a streaming vagy a kriptovaluták megjelenésével mennyivel nőtt a rájuk rótt teher – gyakorlatilag a Mátrixba illő, a digitális világot zakatolva működtető, óriási gépparkokba szerveztük ki életünk egy jelentős részét.

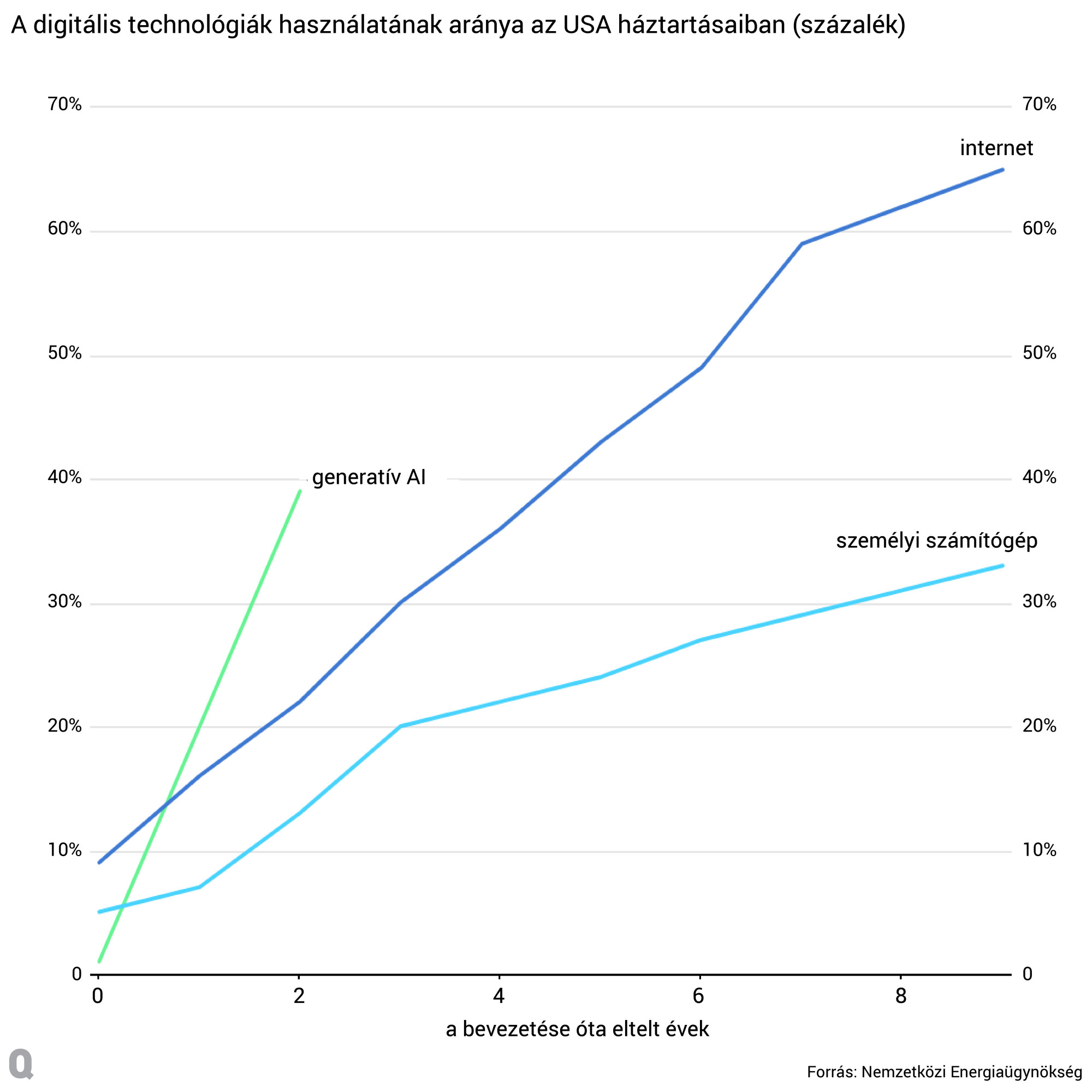

De az igazi kihívás még csak most jön, a (generatív) mesterséges intelligencia (AI) ugyanis működésénél fogva azonnal igényel nagyon nagy számítási kapacitást, hogy a ChatGPT rögtön helyesen válaszoljon, vagy hogy a Midjourney öt másodpercen belül megfesse azt, ami nekünk öt hónap alatt sem sikerült volna. Márpedig a generatív AI tényleg úgy robbant be az életünkbe, mint még soha semmi, már ha maradunk a digitális technológiáknál.

Na de lépjünk egyet hátra: egyáltalán hogy néz ki a valóságban egy adatközpont? Bár egy átlagos létesítmény területe ezer és tízezer négyzetméter között mozog, az olyan nagyvállalatok, mint a Microsoft vagy a Google számos, akár több százezer négyzetméteres adatközpontot működtetnek, míg a világ legnagyobb ilyen komplexuma a China Telecomé, ami egymillió négyzetméteren (azaz egy négyzetkilométeren) terül el, vagyis elfoglalná a teljes Városligetet. Az egyszerűség kedvéért nézzünk egy kisebb (18 ezer m2) Google-adatközpontot, a hollandiai Eemshavenből:

Ezekben a nagy csarnokokban rengeteg szerverszoba, hálózati berendezés, tápegység és hűtőrendszer található, amelyek jó esetben a lehető legnagyobb hatékonyságra vannak tervezve, így a hardverek gyakran hosszú folyosókon, szekrénysorokban találhatók. Egy szerverszoba hidegfolyosója (ahol a hűtést kapják a hardverek) például így néz ki, a változatosság kedvéért a Microsoftnál:

Ezekben az úgynevezett rack szekrényekben sűrűsödnek az egyes szerverek, vagyis azok a nagy teljesítményű számítógépek, amelyek – a rájuk szerelt processzorokon, memóriachipeken és egyéb összetevőkön keresztül – az adatokat tárolják, feldolgozzák, és elvégzik azokat a számításokat, amelyek például az internet vagy az AI-chatbotok működéséhez kellenek. Közelebbről így néznek ki:

Csak rá kell néznünk ezekre a képekre, és máris arra gondolunk, hogy ez a villanyszámla bizony még rezsicsökkentéssel együtt sem lesz kellemes – igen, a nagy teljesítményű számítógépek tömegeit éjjel-nappal működtető és komoly hűtést igénylő adatközpontok rengeteg áramot fogyasztanak. Globálisan körülbelül a teljes áramfogyasztás 1,7 százalékát teszik ki, vagyis annyi energiát zabálnak fel egy évben (2022-ben 460 terawattórát), hogy ha az adatközpontok egy országot alkotnának, az a rangsorban Németország és Franciaország között foglalna helyet a top 10 legvégén.

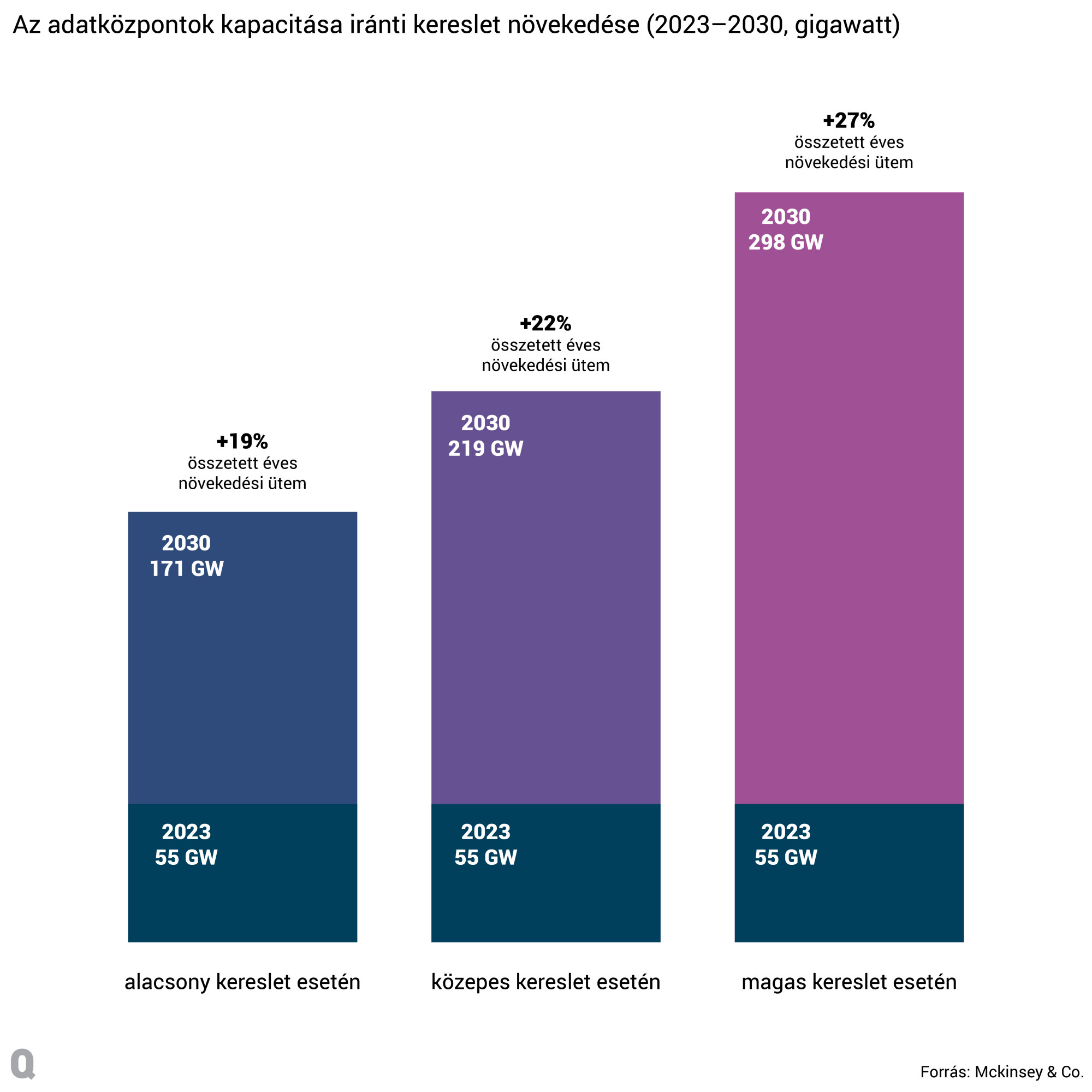

Ez sem kevés, de elemzők szerint még csak most kezdődik igazán az infrastruktúra kiépítése. A McKinsey becslése szerint az adatközpontok kapacitására mutatkozó igény az évtized végéig évi 19-27 százalékkal növekedhet, vagyis a globális kapacitás legalább a háromszorosára, de akár az ötszörösénél is nagyobbra nőhet 2030-ra. (A tanácsadó cég a legfrissebb AI-használati trendek, a kritikus chipek rendelésének növekedése, valamint az AI-folyamatokhoz szükséges számítási, tárolási és hálózati kapacitás alapján végezte a háromféle becslést.)

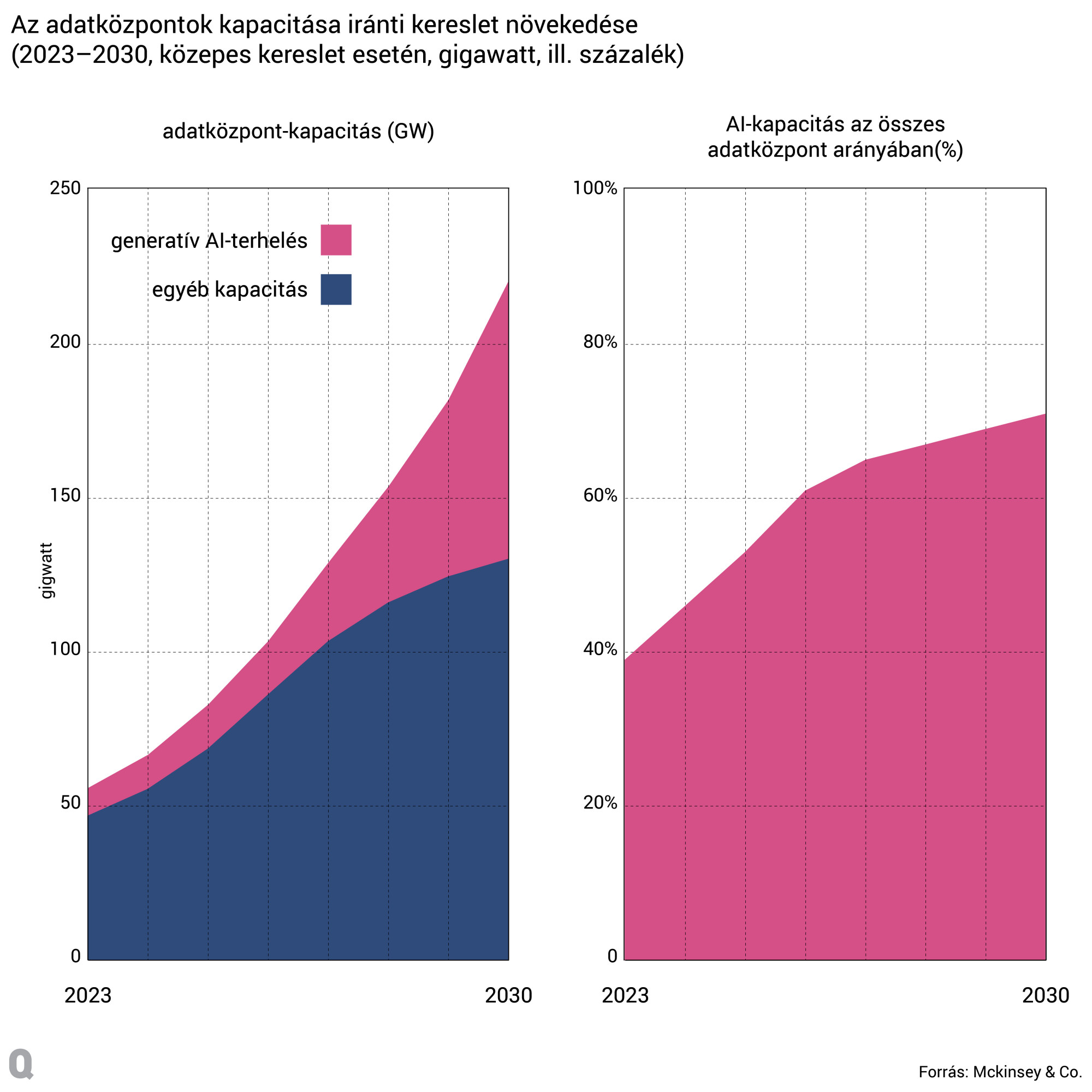

Az előrejelzés szerint a generatív AI egyre nagyobb ütemben járul majd hozzá a teljes kapacitásnövekedéshez, miközben a fejlett AI-hardverrel rendelkező adatközpontok aránya is jelentősen megnő, így akár a 70 százalékukban lehet majd generatív AI-folyamatokat futtatni.

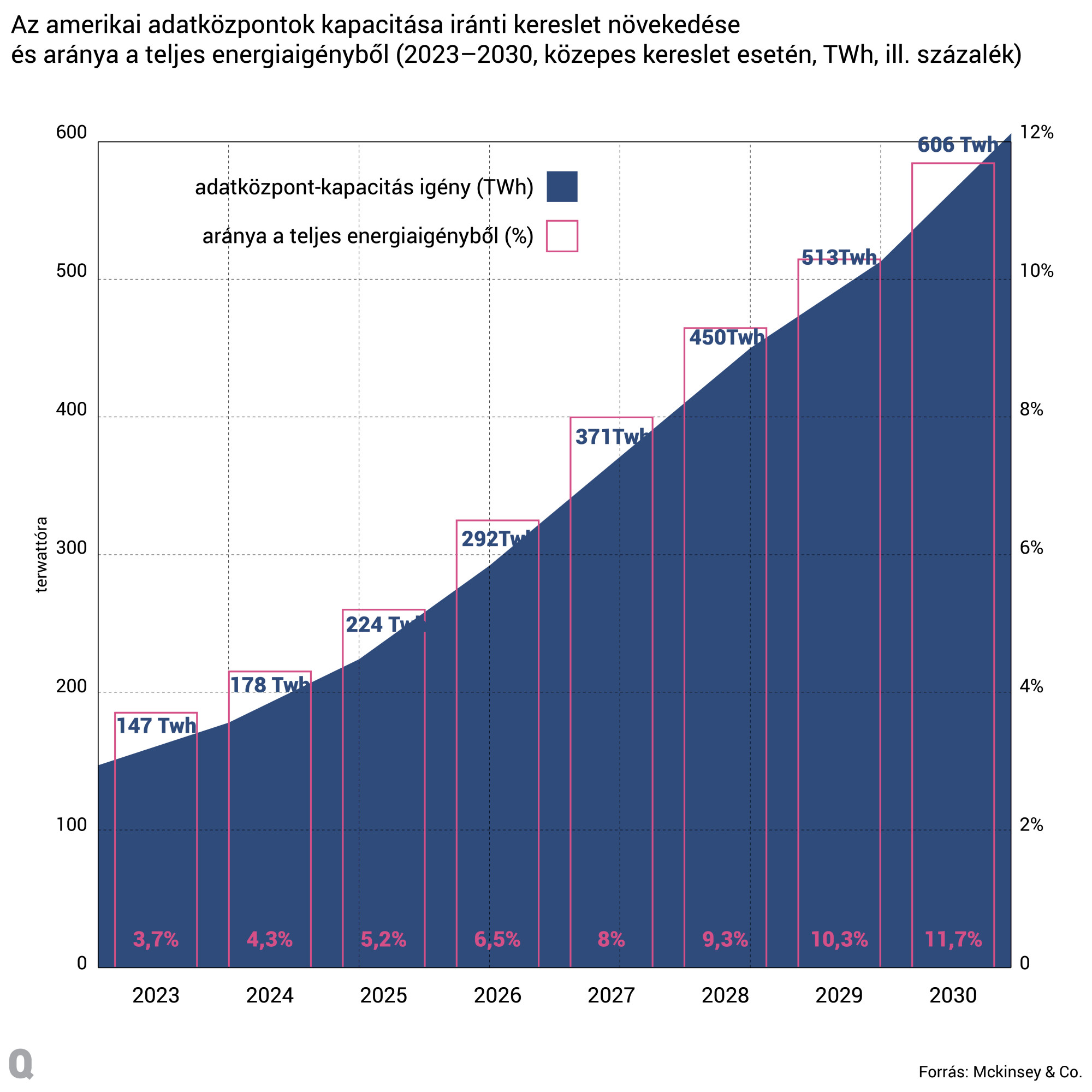

A kapacitásnövekedés természetesen az adatközpontok energiaigényét is megemeli, a McKinsey számításai szerint ráadásul az ilyen létesítmények jóval nagyobb arányban veszik majd ki a részüket a teljes áramigényből, mint ma, legalábbis az Egyesült Államokban: míg a közepes forgatókönyv szerint a fogyasztásuk ugyanúgy a négyszeresére nő, ahogy a kapacitásuk, ez már nem a teljes amerikai energiaigény 3-4 százalékát, hanem annak 11-12 százalékát emésztheti fel.

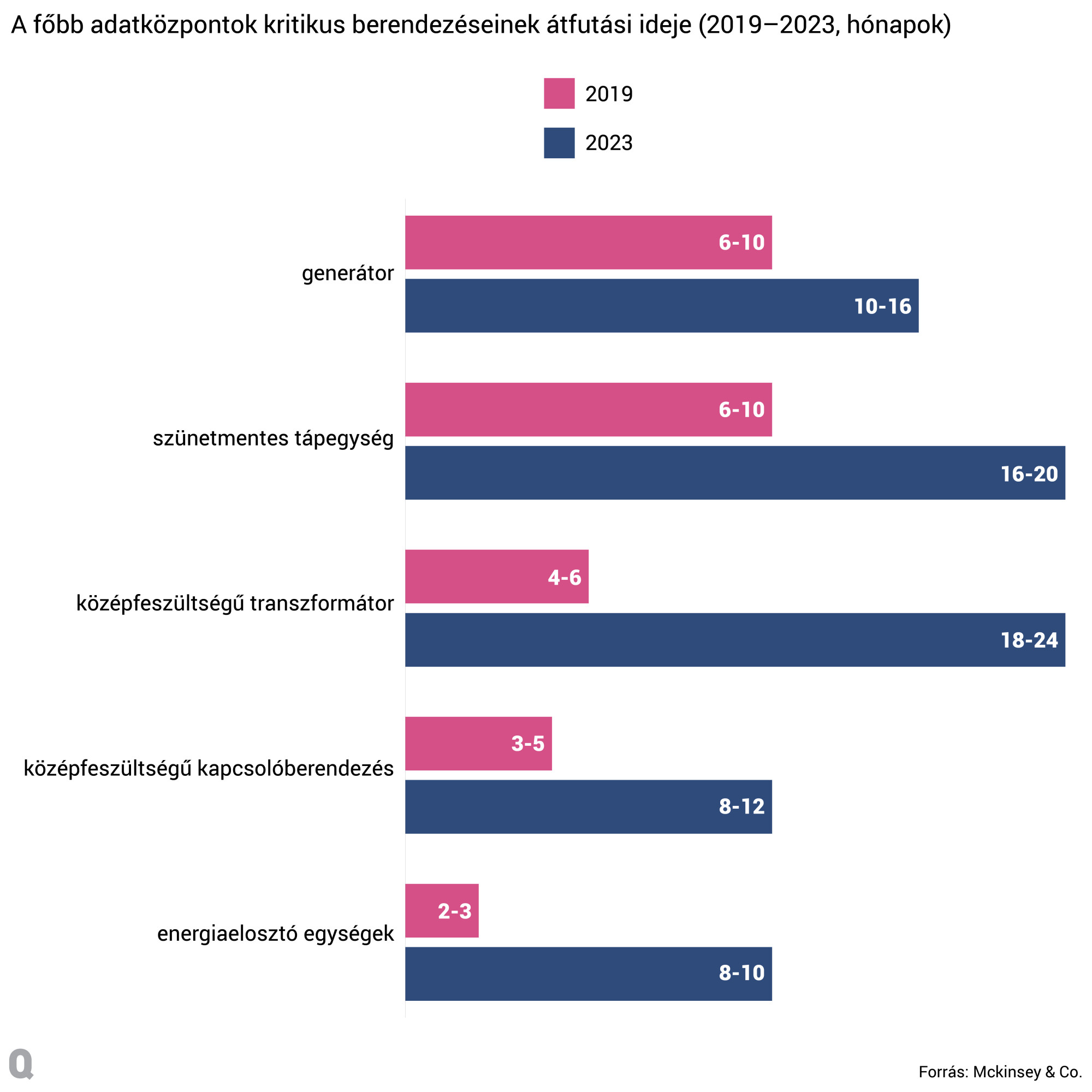

A növekedést persze megtorpanthatja az, hogy a villamosenergia-hálózatok nincsenek felkészülve egy ilyen mértékű bővülésre, és az adatközpontok terjedésének üteme a megújuló energiaforrásokét is lekörözheti, ami még több fosszilis energia felhasználásával járhat. Emellett úgy tűnik, az adatközpontok beszállítói sem tudják tartani a tempót, az elmúlt években legalábbis több fontos berendezés rendelési ideje is a duplájára vagy akár a három-négyszeresére nőtt.

Hogy akkor mégis mit lehet tenni annak érdekében, hogy a technológiai fejlődést ne hátráltassák fizikai tényezők? Az ipar az energiahatékonyság fejlesztésében látja a megoldást.

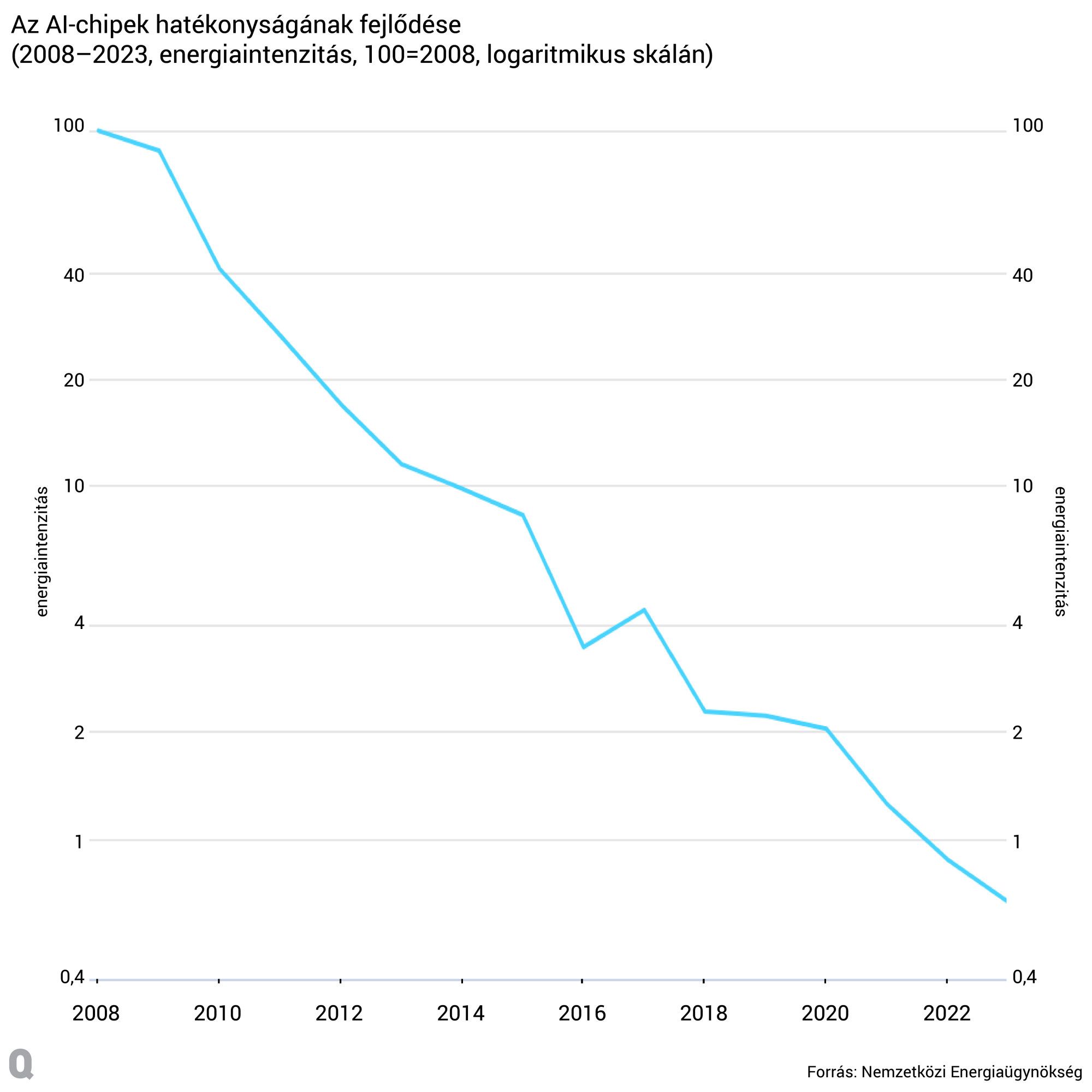

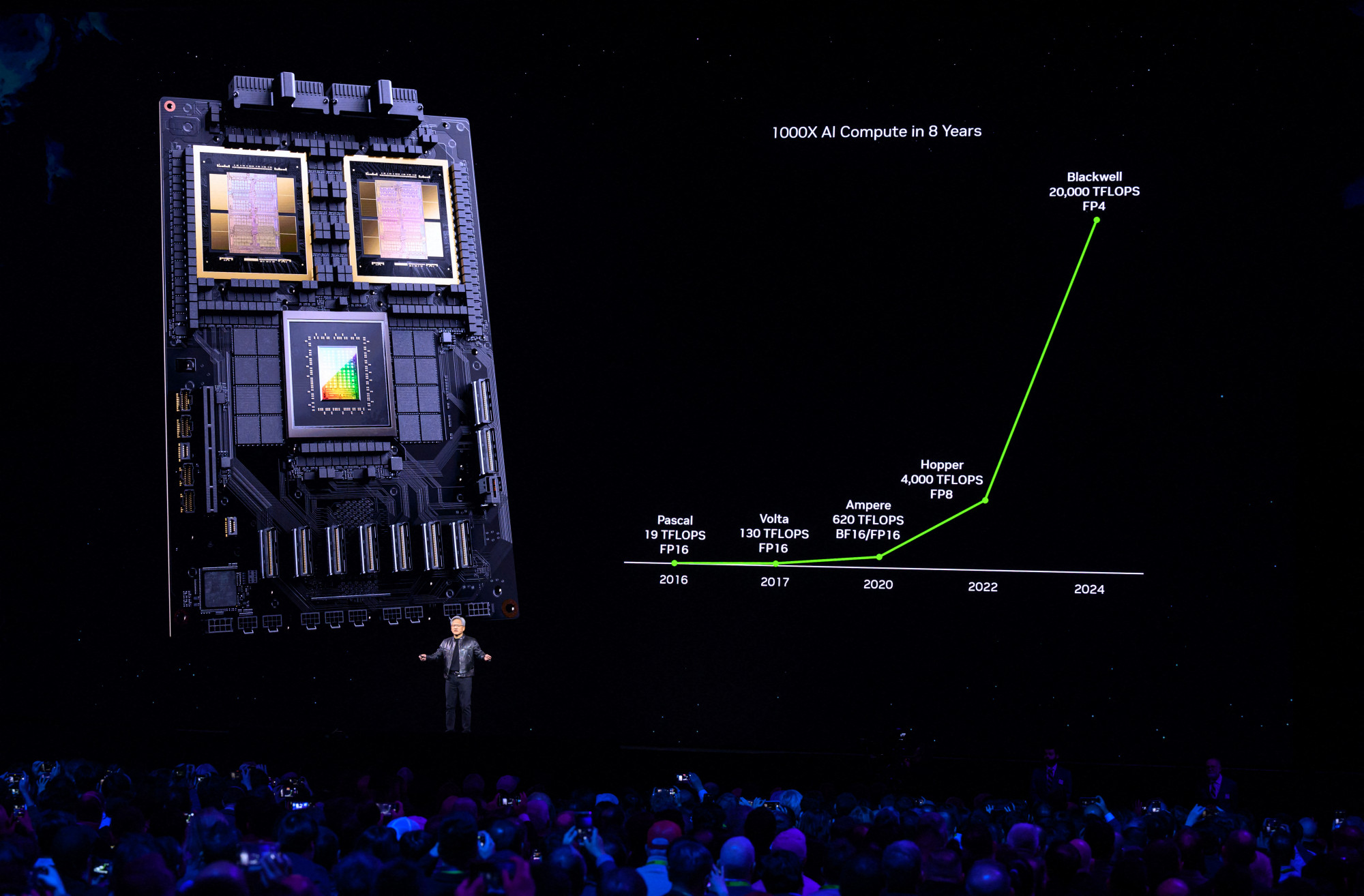

Amióta kimondottan a mesterséges intelligencia különböző alkalmazásaira gyártanak chipeket, rengeteg innováció történt a területen, az áramkörök felépítésében vagy a félvezető anyagok gyártásában, arról nem is beszélve, hogy maguk az AI-modellek is optimalizálva lettek, így kevesebb erőforrással érik el ugyanazt a teljesítményt.

Az adatközpontok legalapvetőbb építőelemei, a chipek hagyományosan szilíciumból készülnek, de ez a félvezető anyag kezdi elérni a korlátait. A mesterséges intelligencia komplex feladatai ugyanis a szokásosnál jobban megterhelik a chipeket, de a szilícium magasabb feszültségen egyrészt veszít a hatékonyságából, másrészt kegyetlenül felmelegszik, ami nemcsak veszélyes, de jóval több hűtést is igényel.

A félvezetőipar két nagy reménysége a gallium-nitrid (GaN) és a szilícium-karbid (SiC), amelyek egyaránt képesek magasabb feszültségen és hőmérsékleten is működni, és akár 25-30 százalékkal is csökkenthetik az energiafelhasználást a szilíciumhoz képest, ami gigantikus adatközpont léptékben már elég vonzó ajánlat lehetne. Csakhogy a GaN és a SiC egyelőre alapanyagukat, feldolgozásukat és a gyártásba való integrálásukat tekintve is drágának számít, elsősorban azért, mert a szilíciumra beállt ipar nem rendelkezik az új anyagokra szabott berendezésekkel és infrastruktúrával, és persze a tapasztalat is hiányzik. Egyelőre.

A grafén, ahogy szinte minden területen, az adatközpontok energiahatékonyságában is a jövő csodaanyagának számít, amelynek tényleges alkalmazási lehetőségeit még bőszen kutatják. Az ígéretek szerint mindenesetre a kivételes vezetőképességéről, rugalmasságáról és keménységéről ismert grafén a hatékony, kisebb méretű és nagyobb teljesítményű chipek fenntartható paradicsomját hozza majd el.

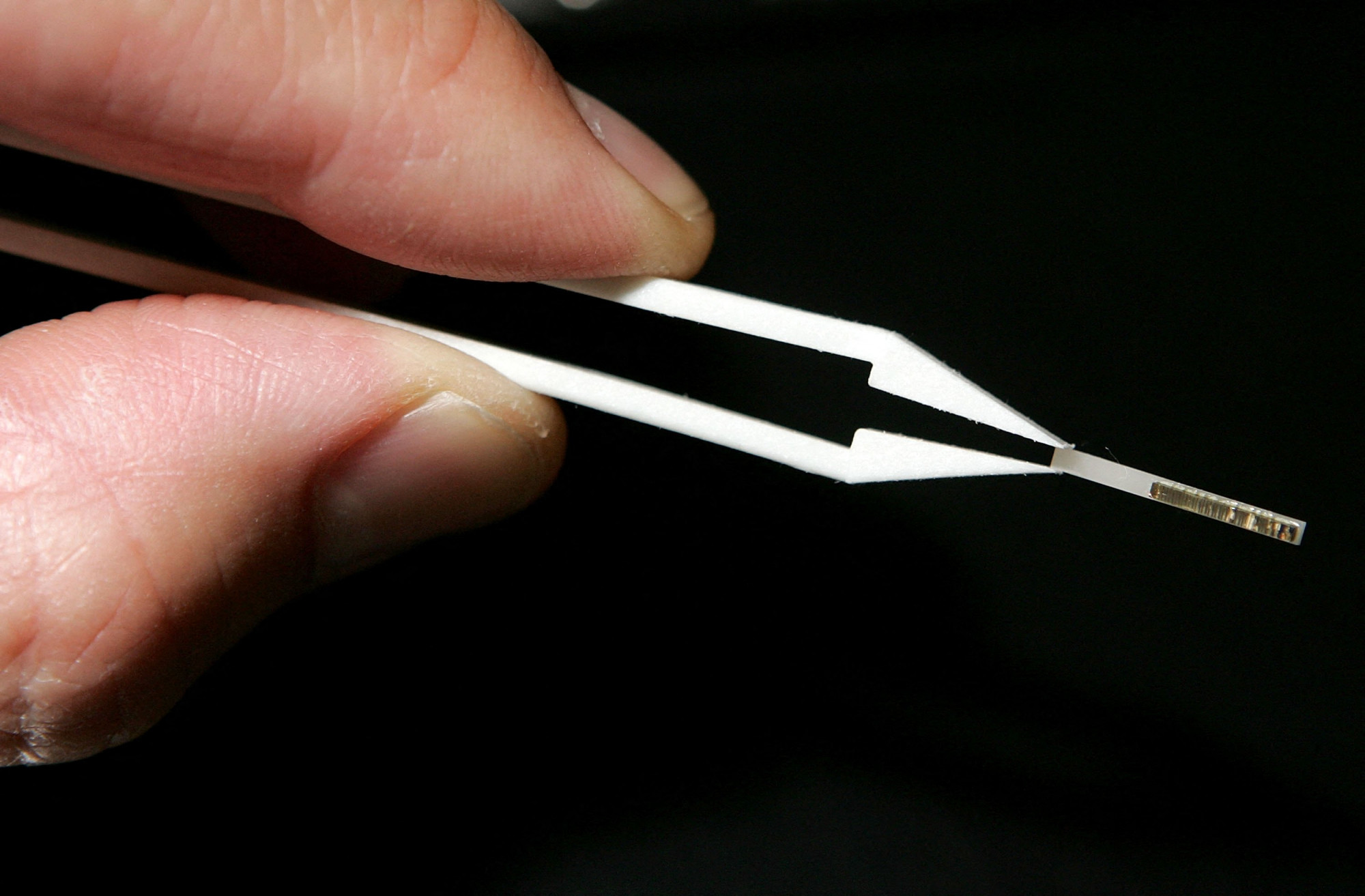

Addig is vannak hibrid próbálkozások. A Georgiai Műszaki Egyetem (Georgia Tech) kutatói például idén januárban mutatták be az első működőképes grafénalapú chipet, aminek valójában szilícium-karbid az alapja, de a bevonatként használt, úgynevezett félvezető epitaxiális grafén (SEC) felerősíti annak egyébként is jó tulajdonságait. A SEC ugyanis a szilíciumnál lényegesen nagyobb elektronmobilitást mutat, így alkalmas nagy sebességű tranzisztorok anyagaként, amelyek terahertzes frekvencián is képesek működni, vagyis a mai szilíciumalapú chipeknél akár tízszer gyorsabbak lehetnek.

Azt korábban egy németországi adatközpontban közelről is megtekinthettük, hogy milyen fontos kérdés egy adatközpont életében a hatékony hűtés biztosítása. Egyes számítások szerint a létesítmények energiaigényének 40 százalékát a hűtési rendszerek adják, mivel a szerverek és más berendezések jelentős hőt termelnek munka közben. A levegővel való hűtés sok esetben már nem elég, ezért csöveken keresztül haladó folyadékhűtési rendszerekkel, valamint az immerziós (merüléses) hűtéssel próbálkoznak, de itt már jelentős különbség van a két alternatíva között. Míg előbbi a léghűtéshez képest 30 százalékkal csökkentheti a energiafelhasználást, utóbbi, ahol a szervereket egy hővezető folyadékba merítik, ami közvetlenül elnyeli a hőt, akár a hűtés energiaigényének 90 százalékát is lefaraghatja.

És az is nagy kérdés lesz az elkövetkező években, hogy az adatközpontok növekvő energiaigénye hogyan érinti a klímacélokat. Míg egyes szakértők attól tartanak, hogy 2030-ra már annyi földgázra lesz szükség a gyarapodó létesítmények működtetéséhez, amennyit egész Kalifornia állam használ fel egy nap alatt, ma már igazából a fosszilis ipar amerikai reneszánszát sem lehet teljesen kizárni. A következő évtizedre szóló tervek központjában viszont egyelőre az atomenergia áll, és a Google, az Amazon és a Microsoft is különböző stratégiákkal igyekszik elérni, hogy több áramhoz jusson – az első kettő a kis moduláris reaktorokba (SMR) fektet, utóbbi pedig egy öt éve leállított atomerőmű újraindításában bízik.

Kapcsolódó cikkek a Qubiten:

Így lett a régi kedvenc videókártya-gyártódból a világ leggazdagabb cége

Az idén az Apple és a Microsoft tőzsdei teljesítményét is túlszárnyaló Nvidia sztorija egyszerre nyújt tökéletes látleletet az AI-ipar kaotikus helyzetéről és egy ügyesen helyezkedő techcégben rejlő lehetőségekről.

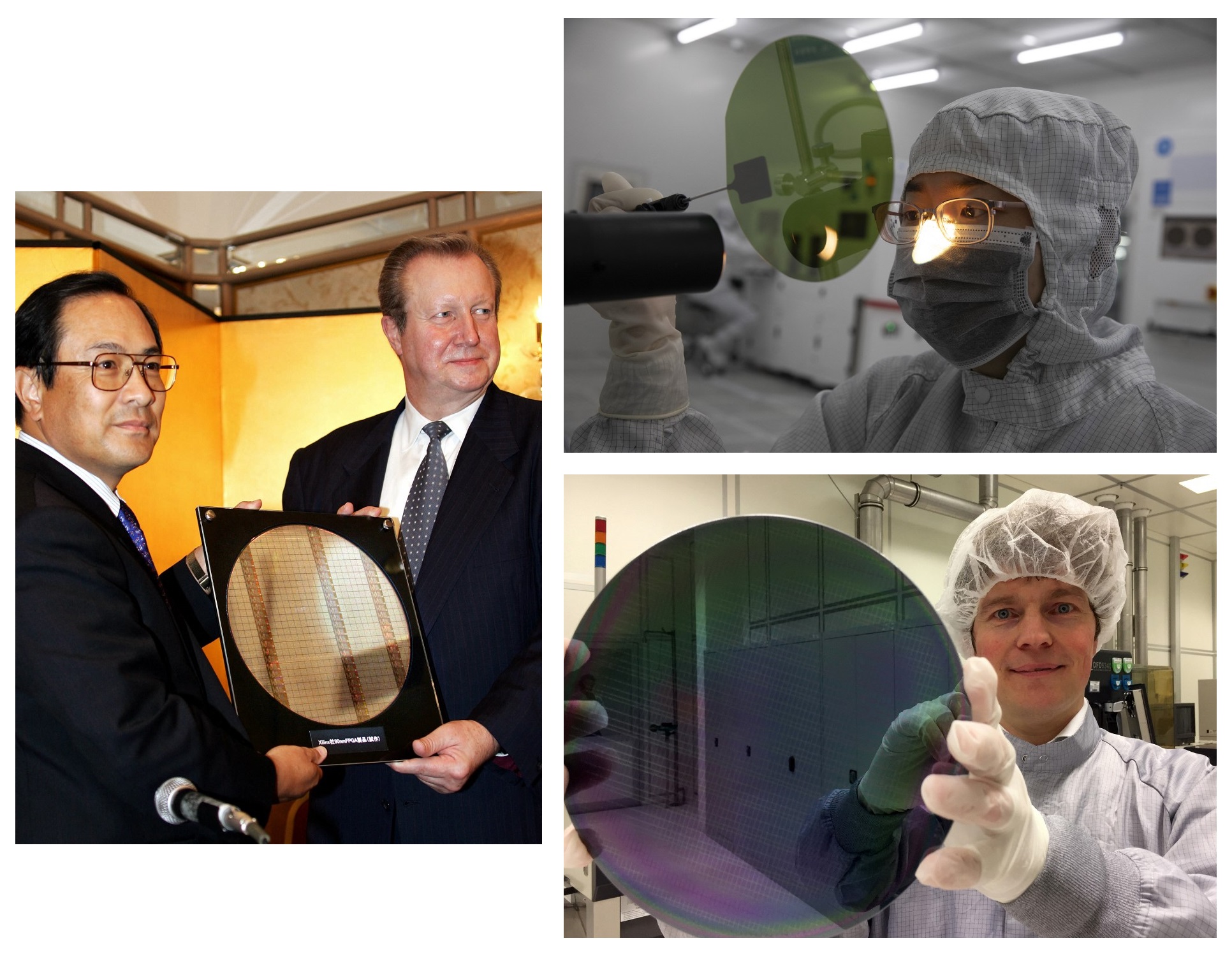

Szabad szemmel alig látható, mégis rá alapoztuk az életünket, mi az?

Az elmúlt 70 év technológiai forradalmát és tudományos áttöréseit az egyre kisebb mikrochipeknek köszönhetjük, amelyek méretükkel mostanra a fizika határait feszegetik. A modern civilizáció építőkockáit előállító félvezetőipar ugyanakkor mára nagy bajban van.

Németországban bemutatták, hogyan élheti túl az internet az energiaválságot

Az emberiség a felhőbe költözött, de nagy árat fizethet érte: a szervereket tároló adatközpontok rengeteg áramot fogyasztanak, és folyamatos bővítést igényelnek, miközben Európát így is áramszünetek fenyegetik. A Terra Cloud hüllhorsti központjában megnéztük, hogyan készül az ipar a zöld fordulatra.