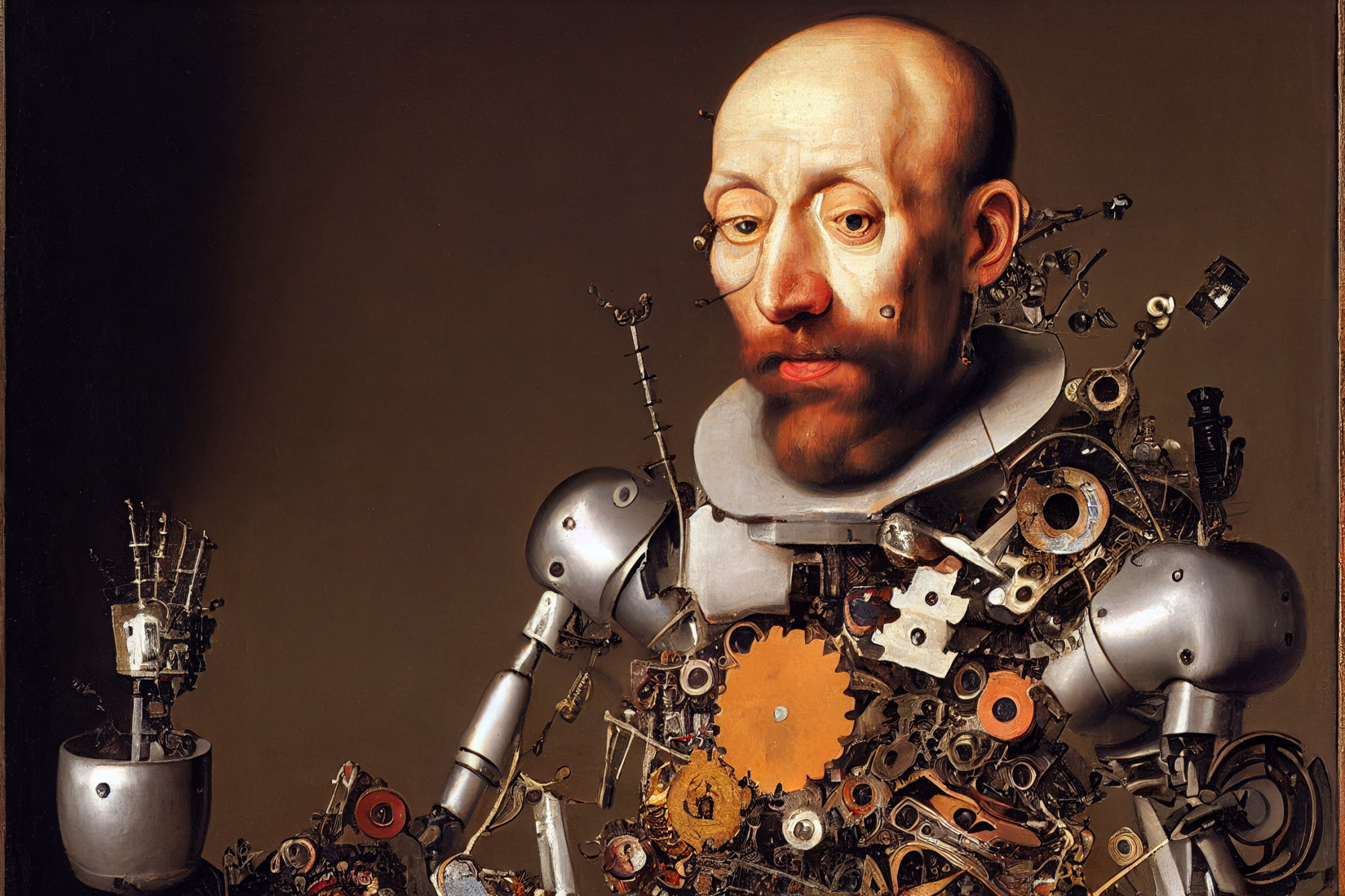

Nyilvános lesz a jövő mesterséges intelligenciája, vagy a nagy cégek uralják majd a Mindenható Kódot?

Nagyjából egy éve annak, hogy végigsöpört a világon az AI-láz, de amilyen hamar betört a mainstreambe a generatív mesterséges intelligencia, olyan gyorsan meg is rekedt az alapoknál, már ami a felhasználói szintet illeti. Az átlagos internetező nagy valószínűséggel hallott már a ChatGPT-ről, esetleg tudja, hogy azokat a nagyon élethű képeket a Midjourney-vel csinálják, és valahonnan mélyről, a windowsos tudatalattiból újra felszínre törhetett a Bing név is.

Aki viszont valamivel figyelmesebben követi az eseményeket, tudja, hogy az internet valójában már most tele van olyan AI-eszközökkel (köztük egy rakás ingyenessel, még ha elsősorban angol nyelvűekkel is), amilyeneket két-három éve még legfeljebb csak elképzelni tudtunk, 15-20 évvel ezelőtt pedig abszolút sci-fi-alapanyagok lettek volna. Hogy pontosan milyenek? A teljesség igénye nélkül, csak az ingyenesen kipróbálható eszközök közül válogatva:

- a CLIP Interrogator megfordítja a Midjourney képletét, és kép alapján generál promptot, vagyis szövegesen leírja, mi látható rajta, milyen stílusban;

- a Remove.bg egy kattintásra eltünteti egy fotó hátterét, és gyakorlatilag tökéletesen kivágja a lényeget;

- az ElevenLabs eszköze ingyen is nagyon élethűen olvassa fel a beírt szöveget;

- a Boomyval már több millióan készítettek saját zenét néhány gombnyomásra;

- az Adobe Enhance-szel a rossz minőségű hangfelvételeinket tisztíthatjuk meg a zajtól;

- a GPTZero ellenőrzi, hogy egy dokumentumot ember vagy AI írt-e;

- a ChatPDF beolvassa a pdf fájlt, és chat formájában lehet kérdezni a tartalmáról;

- egyes Chrome-bővítmények egész jól összefoglalják szövegesen a cikkek és Youtube-videók tartalmát;

- a MemeCam azonosítja az arckifejezésed, és megalkotja a hozzá illő szöveges mémet;

- a RoomGPT lakberendezési tippeket ad, és a szobáidról készült fotók alapján generál új bútorokat és környezetet;

- a Durable segít, hogy bárki egyszerűen össze tudjon rakni egy weboldalt;

- a Kickresume használatával gyerekjáték az ütős önéletrajz szerkesztése és a motivációs levelek írása (angolul, persze);

- a Socratic füzetből befotózott matekpéldából vagy versrészletből formál izgalmas feladatokat, teljes új tanulásélményt nyújtva (szintén angolul);

- a Pi pedig tartalmas, terápiás jellegű beszélgetésekhez nyújt terepet (még ha, illik megjegyezni, a professzionális segítséget nem is helyettesíti).

Aki pedig ennél is sokkal jobban beleásta magát, az már home office-ból, hátradőlve élvezi, ahogy dől a pénz a startupjába.

Mindeközben jól megszokott szoftvereinkbe is kezd szépen lassan beépülni a technológia. A Gmail már réges-rég AI-alapú szövegkiegészítést ajánlgat levélírás közben, a Photoshopba nemrég beszerelték az egyik legerősebb képgeneráló és -szerkesztő AI-eszközt, az Adobe Firefly-t, a Microsoft Copilottal pedig egy életre megváltozott a Word-, Excel- és PowerPoint-élmény. Ahogy az új Bing is a Microsoft Edge motorja lett – jó, Edge-et továbbra sem használ senki.

Mindez azért fontos, mert az újabb és újabb AI-alkalmazásokkal rohamosan gyarapodik és összefonódik az AI-ökoszisztéma – mindenki egymás nyelvi modelljét, adatbázisát, tanulási algoritmusát használja, és a további fejlődést nagyban befolyásolja, hogy ez meddig mehet ilyen vadnyugati módszerekkel.

GPT, PaLM, LLaMA? Mi van?

A mesterséges intelligencia jövőjének egyik legfontosabb kérdése tehát az, hogy a ChatGPT- vagy Midjourney-szerű eszközök alapját jelentő nagy nyelvi modellek (LLM) közül a nyílt forráskódú vagy a nyilvánosságtól elzárt változatok uralják-e a piacot. Ez így könnyen valami technikai részletkérdésnek tűnhet, pedig ezen múlhat az is, hogy biztonságban lesz-e az emberiség, ha az AI túl fejletté válik.

A nagy nyelvi modellek olyan AI-rendszerek, amiket arra képeztek ki, hogy megértsék és reprodukálják az emberi nyelvet. Ehhez először gigantikus szöveges adatbázisok kellenek, amelyek forrásai általában az interneten található szövegek (cikkek, könyvek, fórumok), majd a modell gépi tanulási algoritmusok segítségével fejlődik, ahogy elemzi a szavak és mondatok közötti kapcsolatot, vagyis megtanulja a nyelv logikáját, hogy emberi szövegeket tudjon generálni.

Ezek a modellek lehetnek zártak, mint az OpenAI-féle ChatGPT mögött álló GPT–3.5 (fizetős verzióban már GPT–4) vagy a Google Bard alapjául szolgáló PaLM 2, és lehetnek nyílt forráskódúak, mint a Meta által kiadott LLaMA vagy a brit Stability AI modellje, a StableLM. Előbbiek tulajdonsága, hogy nem nyilvános, honnan származnak a szöveges adatbázisaik, egyáltalán mekkora az adathalmaz, milyen módszerekkel tanították be, és hogy mekkora számítási kapacitással járt a tanulási folyamat. A zárt modelleket cégek birtokolják, és csak licencelni lehet őket, korlátozott személyre szabási lehetőségekkel – ellenben a nyílt forráskódú modellekkel, amiket közzétételük után szabadon lehet használni, másolni, módosítani és terjeszteni.

A nyílt vs. zárt modellek vitájának üzleti, jogi és a biztonságot érintő elemei is vannak.

A nagyok kijátsszák a biztonságkártyát

Ha közzéteszik a forráskódot, az értelemszerűen átláthatóbb megoldás, és nagyobb teret ad az adathalmazban található jogvédett szövegek (vagy képek) tisztázását. De a nyílt modellek az innovációt is elősegítik, hiszen az AI-startupok és a kisebb cégek általában nem engedhetik meg maguknak, hogy a nulláról fejlesszenek – idő- és kapacitásigényes – saját nyelvi modellt, így ha hozzáférnek egy olyanhoz, ami nyilvános, azt testreszabhatják, finomhangolhatják, vagy épp tovább tökéletesíthetik.

A probléma a biztonsággal kezdődik. Június elején két amerikai szenátor, a demokrata Richard Blumenthal és a republikánus Josh Hawley közösen kérdezte fel a Metát, amiért az eredetileg csak kutatási célokra kiadott LLaMA modelljük forráskódja kiszivárgott a 4chanen, és így bárkinek elérhetővé vált. A politikusok szerint a cég nem mérte fel eléggé, hogy milyen veszélyekkel járhat, ha nyilvánosságra kerül a modell.

A biztonságkártyát játszotta ki az alapításakor még a nyílt forráskódú AI élharcosaként tetszelgő, de neve ellenére ma már zárt rendszerekben gondolkodó OpenAI is, amikor bemutatta legutóbbi nyelvi modelljét, a GPT–4-et. A megjelenést kísérő technikai jelentésben emellett az üzleti érdek is előkerült: „A versenyhelyzetre és a GPT–4-hez hasonló nagy modelleket övező biztonsági kockázatokra való tekintettel ez a jelentés nem tartalmaz több részletet az architektúráról (beleértve a modell méretét), a hardverről, a tanítás számításigényéről, az adatkészlet felépítéséről, a tanítási módszerekről és hasonlókról.”

Ilya Sutskever, az OpenAI vezető kutatója és társalapítója a Verge-nek elmondta, hogy egyelőre az üzleti titok fontosabb, mint a biztonsági megfontolások, de ez a jövőben minden bizonnyal megfordul. „Ezek a modellek nagyon erősek, és egyre erősebbé válnak. Valamikor a jövőben nagyon könnyű lesz nagy károkat okozni ezekkel a modellekkel, ha valaki azt akarja. És ahogy fejlődnek a képességeik, egy ponton logikusan nem lesz célszerű nyilvánosságra hozni őket” – mondta. Amikor az OpenAI profilváltásáról kérdezték, Sutskever szerint a legelején hibáztak, nem lett volna szabad a nyílt kutatás felé mozdulni: „Ha más is úgy gondolja, ahogy mi, és az AGI [általános mesterséges intelligencia] tényleg rendkívül, hihetetlenül nagy képességekkel rendelkezik majd, akkor egyszerűen nincs értelme nyilvánossá tenni. Rossz ötlet. Arra számítok, hogy néhány éven belül mindenkinek teljesen egyértelművé válik, hogy a nyílt forráskódú AI nem bölcs megoldás.”

A GPT–4 ugyan már jóval több mindenre képes, mint az elődei (például szöveget és képeket is tud kezelni egyszerre), de még mindig nagyon messze van az általános mesterséges intelligenciától, amit általában úgy szoktak jellemezni, hogy minden olyan szellemi képességgel rendelkezik, amivel az ember – csak éppen az emberi agynál több milliárdszor gyorsabban képes feldolgozni az információt. A lényeg, hogy nem is kell idáig eljutni, a GPT–4 a szakértők szerint már most is képes lenne olyan szintű információs káoszt kiváltani, amibe még jobban beleremegnének a világ demokráciái.

A nyílt forráskódú AI-kutatásairól ismert William Falcon, a Lightning AI vezetője ennek ellenére azt mondta, azt még megérti, hogy az OpenAI-nak üzletileg megéri rejtegetni a titkos receptet, de ezzel nagyon rossz precedenst állít az alapjában véve nyilvános kutatásokhoz és modellekhez szokott, az akadémiai világból a profit felé éppen csak elmozdult közösség elé. „Ha valami baj lesz a [GPT–4] modellel, márpedig lesz vele, láttuk a hallucinációkat és a téves információkat, akkor hogyan kellene a közösségnek reagálnia? Hogy tudnak így az etikus kutatók megoldásokat javasolni, hogy min és hogyan kellene változtatni?” – tette fel a kérdést Falcon.

Linux, Wiki, Transformer

Nagyot változott a világ az elmúlt 25 évben. A büszke (bár valószínűleg crackelt) Windows-felhasználók a nagy kényelmükben sokáig csak röhögtek a nyílt forráskódú, de nem egy gombnyomásra indítható Linux operációs rendszeren, erre ma a világ összes okostelefonjának közel 80 százalékát a Linuxra épülő Android vezérli. Az Internet Explorer nélkül nem lehetett elképzelni az online életet, aztán megjelent a Netscape meg a Mozilla, majd később a Google, és nyílt forráskódú böngészőikkel tökéletesítették az élményt. Na és hogyan tudnánk ma csillapítani a szűnni nem akaró információéhségünket a Wikipédia, valamint annak nyílt forráskódú motorjára, a MediaWikire épülő oldalak nélkül?

A korszellemet szépen lassan a legnagyobb techcégek is felismerték: a zárt szoftverek régi motorosa, a Microsoft Satya Nadella vezetésével igazi nyíltforráskód-templommá épült, a Google pedig már alapból is nyilvános kódokra alapozta a sikerét, de legalább most vissza is ad belőle, ugyanis a cég kutatói által fejlesztett TensorFlow gépi tanulási keretrendszer és a korszakalkotó Transformer (a GPT-ből a T) modell nélkül most nem beszélnénk a mesterséges intelligencia aranykoráról.

És úgy tűnik, hiába zárják el a nyilvánosság elől legújabb modelljeiket a generatív AI nagyágyúi, tucatjával jelennek meg azok a nagy nyelvi modellek, amelyeket bárki szabadon használhat, ráadásul nem is feltétlenül rosszabb eredménnyel. Március végén amerikai egyetemek közösen adták ki a Vicuna nevű chatbotot, ami a nyílt forráskódú LLaMA modellre alapult, és bár csak 300 dollár volt betanítani, 92 százalékot ért el a ChatGPT-vel való összehasonlítás során. Aztán áprilisban a Berkeley-n már 100 dollárból be tudtak tanítani egy szintén LLaMA-alapú chatbotot, amit az emberek nem tudtak megkülönböztetni a ChatGPT-től.

Májusban ki is szivárgott egy belső Google-dokumentum, amelyben a névtelenül maradt szerző már megkongatta az open-source vészharangját: Bár a mi modelljeink még mindig némi előnyt élveznek a minőséget illetően, a különbség elképesztő gyorsan csökken. A nyílt forráskódú modellek gyorsabbak, testreszabhatóbbak, privátabbak és jobb képességűek. Olyan dolgokat csinálnak 100 dollárból és 13 milliárd paraméterrel, amilyenekkel mi 10 millió dollárból és 540 milliárd paraméterrel szenvedünk. És mindezt hetek, nem hónapok alatt.”

Amikor az OpenAI vezére, Sam Altman az elmúlt hónapokban bejárta a világot, hogy az AI jövőjéről tárgyaljon különböző kormányokkal és szervezetekkel, felmerült egy hibrid ökoszisztéma ötlete, és úgy tűnik, ez a megoldás most a nyerő mind a szabályozók, mind a nagy techcégek szemében. Eszerint meghatároznának egy küszöbértéket az adott nyelvi modell kapacitásában, ami alatt nyílttá kellene tenni a kódot, fölötte viszont el kéne zárni a külvilágtól. Az USA valami ilyesmit alkalmaz a Kínával vívott chipháborúban is: a csúcstechnológiás áramkörökre érvényes az exporttilalom, kevésbé fejlett chipeket viszont továbbra is eladnak Kínának. Hogy hol húzzák meg a vonalat, na, az jó kérdés.

Mindenesetre kezd kialakulni valamiféle konszenzus:

- a nyílt forráskódú nyelvi modellek átláthatóbb és hatékonyabb fejlődést tesznek lehetővé, cserébe a túl fejlett képességű csúcsmodelleket kockázatos bárki kezébe adni;

- a zárt, céges tulajdonú modellek pedig üzletileg versenyelőnyt jelenthetnek és csökkentik a veszélyes felhasználás esélyét, viszont hátráltatják az innovációt, nem tudni, hogy milyen adatokból és hogyan merítenek, valamint fenntartják a lehetőségét annak, hogy a jövőben egy mohó vállalat majd nem akarja kiadni a kezéből a szuperintelligencia kulcsát.

A szabályozók ennek fényében teszik a dolgukat, és igyekeznek megtartani a nyílt és zárt modellek minden előnyét, a veszélyek kiiktatásával. Nem véletlenül tart ilyen sokáig a mesterséges intelligencia megregulázása. Pedig amikor már az Egyesült Államok legkíméletlenebb megfigyelő-adatelemző vállalata, a kormányszervekkel, hatóságokkal, katonai beszállítókkal és más magáncégekkel is együttműködő Palantir Technologies vezérigazgatója is úgy számol be a cég legújabb AI-fejlesztéseiről, hogy „abban sem vagyok biztos, hogy ezt el kellene-e adnunk az ügyfeleinknek”, ott már nagyon kikívánkozik az a szellem a palackból, ami ha egyszer kiszabadul, már nem nagyon lehet visszatuszkolni.

Kapcsolódó cikkek a Qubiten:

Kapcsolódó cikkek

Hiába égető kérdés az AI szabályozása, az EU a gyors helyett a hosszú távú megoldásban bízik

NSA-botrány kicsiben: évek óta titokban figyelik New Orleans lakóit a Palantir technológiájával