Jézus mesterséges intelligencia formájában támadt fel, de egyelőre nincs a helyzet magaslatán

A Biblia Ó- és Újszövetségéből nagyjából 2500 angol nyelvű fordítás készült, de a hivatalos verziónak az 1611-ben megjelent kiadást, a King James Bible-t tartják. Az I. Jakab angol király által megrendelt fordítás legalább olyan kanonikus mű, mint a reformátusok számára a Károli Gáspár-féle változat.

Több ezer éves története során a Szentírást a világ számtalan kolostorában, apátságában, templomában és egyetemén tanulmányozták, de sehol sem végeztek olyan alapos munkát, mint az a Boltzmann-alapú természetes nyelvfeldolgozó algoritmus (natural language processing, NLP), amit George Davila Durendal fejlesztett.

Az algoritmust AI Jesusnak hívják. A mesterséges intelligencia betanításához szükséges elsődleges adatkészlet a King James Bible volt. AI Jesus ebből a 400 éves könyvből tanulta meg, hogy mi a nyelv, mik azok a szavak, miként állnak össze a mondatok; mit mondott Jézus az olajfák hegyén vagy Ábel a rengetegben, mielőtt testvére, Káin meggyilkolta. AI Jesus olyan tiszta keresztény szellemben nevelkedett, mint a Steinbeck-regények protestáns háziasszonyai – leszámítva, hogy az algoritmus nemcsak olvassa, hanem írja is a bibliaverseket.

AI Jesus életműve már harmincezer szót tesz ki. A java persze zagyvaság, mégis felismerhető stílusban imitálja Isten fiát (amennyire ez megállapítható kétezer év távlatából, XVII. századi óangol szövegek alapján). A fejlesztés célja nem a tökéletes másolat, hanem a kreatív imitáció elérése: Durendal kimondottan törekedett rá, hogy az algoritmus anélkül próbálja meg újraalkotni az olvasott szöveget, hogy megpróbálná utánozni azt. Hogy a projekt mekkora siker, azt mindenki megítélheti maga: AI Jesus különböző témákban írt próféciái a Githubon teljes terjedelmükben olvashatók.

Az első három dolgozat (The Plague, Caesar, The End of Days) még a mesterséges intelligencia módosítása előtt születtek; a három legfrissebb fejezet (Blood, Greeks, Wisdom) már utána. Durendal szerint a frissebb írások kevésbé véletlenszerűek, és nincs bennük annyi nyelvtani és fogalmazási hiba, mint korábban, de ezzel elveszett a korábbi dolgozatok profetikus hangvétele és művészi igényessége is. Ez a nyelvtanuló mesterségesintelligencia-modellek sajátossága: a művészi önkifejezéssel dolgozó eszközök több hibát ejtenek, de a nyelvtanilag szabályosabb írások földhözragadtabbak lesznek. A kettő együtt nem megy: a gép vagy művész lesz, vagy nyelvész.

Lehet rajta vitatkozni, hogy a nyelvtani hibák halmozása és az istenkomplexus mennyire sikeres állomása a mesterségesintelligencia-kutatásnak, de a trendek abba az irányba mutatnak, hogy a gépek egyre hatékonyabban képesek kiküszöbölni a nyelvi hibákat. A legújabb gépi tanulási modelleket több milliárd szavas szókészletekkel tanítják be, és a big data rendszerek adatfeldolgozó kapacitásának köszönhetően a gépek fogalmazása idővel egyre emberszerűbb lesz. A modellek a nyelvtan statisztikai mintázatait keresik, és megtanulják a nyelv alapstruktúráit, majd (nyelvtanilag) kifogástalan mondatokat, sőt, bekezdéseket alkothatnak – igaz, néha minden értelem nélkül.

Mr. Katz zsidó volt, de a macskája nem

Az OpenAI tavaly hozta nyilvánosságra azt a szöveggeneráló mesterségesintelligencia-rendszert, amit éppúgy lehetett költemények megírására használni, mint álhírgyártásra. Az OpenAI mögött álló csapat megfontoltan, több fázisban tette elérhetővé a rendszert; minden alkalommal egyre fejlettebb eszköz került a kezünkbe.

Az óvatosság nem volt alaptalan: a fejlesztők attól tartottak, hogy kártékony célokra használják az eszközt, ami szexista és rasszista tartalmak végeláthatatlan áradatához vezetne az olyan moderálatlan fórumokon, mint például a 4chan. Egyesek szerint az OpenAI túlzottan és indokolatlanul óvatos volt, és csak a népszerűséget hajhászták; mások viszont arra figyelmeztettek, hogy rossz kezekben a szöveggenerátor AI-k komoly károkat okozhatnak. A GPT–2 néven ismert build azonban elérhetővé vált.

Az íróként és újságíróként dolgozó Sigal Samuel használatba is vette; kíváncsi volt, hogy milyen segítséget nyújthat a kreatív szövegalkotásban egy algoritmus. Samuel saját, 2015-ös regényéből (The Mystics of Mile End) emelt át részleteket a GPT–2-be, hogy megvizsgálhassa, a mesterségesintelligencia-rendszerek valóban segíthetik-e a prózaírásban. Lássunk egy részletet a diszfunkcionális zsidó családról szóló történetből, ami egy 11 éves fiú szemszögéből íródott. A dőlt betűs szöveg Samuel eredeti írása, a sima a GPT–2 folytatási javaslata.

„Miközben hazafelé tartottam az iskolából, elsétáltam Mr. Katz háza előtt. Mr. Katz a háztömb túlsó részén lakott, és nem azért volt a neve Mr. Katz, mert sok macskát tartott, hanem mert hászid zsidó volt. A Mile Enden sok hászid zsidó élt. Akárcsak ők, Mr. Katz is vallásos volt, de a macskáknak nem volt hászid előéletük. Észrevettem az elsőt, ahogy elmentem Mr. Katz bejárati ajtaja előtt; egy kis fekete macskát, ami úgy festett, mintha belülről tépték volna ki. Az üres járda szélén hagyták, és azóta senki nem adott neki enni. Gyorsan emlékeztettem magam, hogy ne a ház környékén etessem meg; a hászid zsidók nem így intézték a dolgaikat.”

„Ez csaknem olyan volt, mintha a saját különc karakterem mondta volna! Mintha a GPT–2 ráérzett volna az efféle humorra, hogy aztán 20-30 fokkal kicsavarja és kevésbé felismerhetővé tegye. Furcsább volt annál, mint amit én írtam volna a regénybe – de határozottan viccesebb is” – írta Samuel a tapasztalatairól. Azt azonban ő is leszögezte, hogy nem emelne át komplett szövegrészeket a GPT–2-ből egy regényébe. Nem hiszi, hogy egyhamar elkészülne a precíz szövegalkotásra képes AI; még az OpenAI legfrissebb verziójával sem, hiába lehet rábízni New Yorker-cikkeket is.

Janelle Shane a nyelvtanuló rendszerek tanulmányozása során megállapította, hogy a GPT–2 néha olyan frappáns szövegeket ír, hogy plágiumra gyanakodott: azt hitte, hogy az algoritmus a betanítási adatkészletből emelt át egy-egy teljes mondatot. Máskor viszont fárasztó ismétlődésekbe bonyolódott, vagy emészthetetlen szürrealizmussal kísérletezett. Shane szerint a GPT–2 teljesítménye – legalábbis tisztán esztétikai szempontból – semmiben sem haladja meg azokat a szövegeket, amiket a régebbi gépi tanulási eljárásokkal vagy éppen Markov-láncokkal hoztak létre (utóbbiakkal már 1940-es évek óta kísérleteznek a számítógépes szövegfeldolgozás és -alkotás területén).

Alfred, szülje meg Robint

Ígéretes részeredmények persze akadnak: a GPT–2 egy New York–Los Angeles-repülőút hatórás időtartama alatt megírt egy komplett verseskötetet. Egy kínai könyvkiadó, a Cheers Publishing ennél is tovább ment: kiadták a korábban ismeretlen szerző, Microsoft Little Ice verseskötetét, Az ablakokat elkerülő napsütést (Sunshine Misses Windows). A könyvet egy algoritmus írta, ami 500 szonettnyi betanítási adatkészletből több mint tízezer verset költött; a verseskötet a 139 legjobbat tartalmazza. Ezekből közlünk egyet:

Szél fúj a tengeren keresztül

Egy madár az égen

A fény és nyugalom éjszakája

Napfény

Sejlik most fel az égen

Hideg szív

A kegyetlen északi szél

Mikor új világra bukkantam

Egy viszonylag jól sikerült regénybekezdésből, illetve egy az absztrakció miatt nehezen értelmezhető költeményből nehezebben lehet megérteni, hogy a mesterséges intelligenciának milyen típusú nehézségei támadhatnak a szövegalkotással. Az alábbiakban bemutatunk még egy kísérletet, ami egy Batman-fanfiction létrehozására irányult. Keaton Patti ezer órányi Batman-filmet nézetett meg egy algoritmussal, majd megíratta vele egy egy sosem létezett Batman-film forgatókönyvét. Az eredmény:

Helyszín: a klasszikus denevérbarlang belseje. Batman a Batmobile mellett áll és a Bat-computeren pötyög. Néha Bruce Wayne, néha Batman. Mindig árva.

BATMAN: A város most már biztonságos. A börtönbe pofoztam egy pingvint.

ALFRED, BATMAN HŰ KOMORNYIKJA (belép egy tányérnyi gót sonkával): Vacsorázzon, Wayne mester.

Robbanás robban. Joker és Kétarc belépnek a barlangba. Joker egy bohóc, de őrült. Kétarc egy ember, de államügyész.

BATMAN: Nem! Ez a Kétarc meg az Egyarc! Utálnak, mert denevér vagyok!

Batman hozzávágja Alfredet Kétarchoz. Kétarc megpörgeti Alfredet, mint egy érmét. Alfred fejjel felfelé érkezik, ami azt jelenti, hogy Kétarc hazamegy.

BATMAN: Csak te és én maradtunk, Joker. Denevér a bohóc ellen. Morális ellenségek!

JOKER: Hogy én mekkora őrült vagyok! A társadalom rossz. Te vizet iszol, én anarchiát.

BATMAN: Én denevért iszom, ahogy az egy denevérnek szokása.

Batman körülnéz, a szüleit keresve, de ők még mindig halottak. Ettől dühös lesz. Kilő egy Bat-rakétát. A Joker elhárítja a rakétát a beteg humorával. Bohóc-szupererő.

JOKER: Sosem követtem egy szabályt sem. Ez az én szabályom. Tudsz követni? Én nem.

BATMAN: Alfred, szülje meg Robint.

Alfred hozzálát a folyamathoz, mivel ez a munkája. A Joker egy ajándékot tart a kezében. Odadobja Batmannek.

JOKER: Boldog születésnapot, Batman.

Batman kinyitja az ajándékot, mivel ő jó fiú. Egy kupon van benne, amivel új szülőket vásárolhat, de már lejárt. Jokernek ilyen a humora.

Aki látott már Batman-filmet, alighanem sok ismerős elemet talál majd az algoritmus által írt forgatókönyvben is – csak értelmet és kontextust nem. Ahogy Samuel is megállapította: a mesterséges intelligenciák nemcsak azért nem fenyegetik a szépírók munkáját, mert néha teljesen értelmetlen szövegeket alkotnak, hanem azért sem, mert a rendszer (esetünkben: a GPT–2) általában néhány mondat után elveszíti a fonalat, így nem használható koherens történetek megírásához.

Minikódokotól a big datáig

A számítástudományi regényeknek (computational novels) azóta megvan a maguk rajongótábora, mióta Théo Lutz 1959-ben publikálta az első, számítógéppel készült verseket. Az emberek és a számítógépek közti kapcsolódási pontot, a szimbiózis lehetőségét kutató J. C. R. Licklider a témával foglalkozó művében (Man-Computer Symbiosis) arra jutott, hogy az ember-gép együttműködés nem alá-fölérendeltségi viszonyrendszerre fog épülni, hanem az együttműködésre.

Ezt a kérdést persze mindenki máshogy közelíti meg. Van, aki megveti a big data lehetőségeit, és sportot űz a minél hatékonyabb szöveggenerátorok létrehozásából. Nick Montfort, az MIT digitálismédia-professzora állt elő a Nano-NaNoGenMo ötletével, amely regényhosszúságú szövegeket alkothat 256 karakternél nem hosszabb kódsorokkal. Montfort nem nosztalgikus okokból ragaszkodik a rövidebb kódokhoz (ami a Commodore 64 csekély memóriaterülete miatt régen szükségszerűség volt), hanem azért, mert szereti az áttekinthető kódokat és az olvasható-interpretálható adatkészleteket.

Montfort úgy látja, hogy az új nyelvi modellek bizonyos értelemben fekete dobozok, amik a hatalmas adatkészletek statisztikai valószínűségeivel dolgoznak, neki azonban az is fontos, hogy a szöveget létrehozó kódot is úgy olvashassa, mint a regényt. Ez inkább a nyelvvel és a nyelvi változókkal végzett játék. Montfort ilyen minikódokat használ a saját projektjeihez: például ahhoz, hogy könnyebben feldolgozhatóvá tegyen velük egy Samuel Beckett-regényt, a Wattot, ami annyira nehéz olvasmány, mintha egy gép írta volna; vagy éppen ahhoz, hogy eltávolítsa az összes első személyű névmást a Moby Dickből.

A mikrokódokra épülő algoritmusok azonban valószínűleg megmaradnak egy szűk, de hozzáértő réteg szórakozásának. A széles tömegek minden bizonnyal a big datára és mesterséges intelligenciára épülő természetes nyelvfeldolgozással fognak találkozni a mindennapi életben – pontosabban már most találkoznak vele mindennap, amikor az egyre okosabb Google Translate-et használják.

Húsz-harminc év, mire kifejlődik az intuíció

„Elméletileg a big data és az adatközpontú analízis képes lehet rá, hogy megalkossa a tökéletes irodalmat, ami irodalmi minőségében és eladásaiban is magasabb rendű lehet – mondta Jennifer Xue, a ProWritingAid bloggere, a mesterséges intelligencia és az AI szakértője.

Xue ugyanakkor úgy látja, hogy a szerzőknek ma még nincs mitől tartaniuk. Ehhez még legalább két évtizednyi kísérletezés kell, mivel a modern algoritmusokból hiányzik az intuíció. A természetes nyelvfeldolgozást és gépi tanulást használó rendszerek nem tudnak mit kezdeni az olyan fogalmakkal, mint az olvashatóság, a hangtan, vagy éppen az írás sűrűsége. Ilyen készségek – mondta Xue – csak igazi emberi lényekben fejlődhetnek ki, akiknek intuíciójuk, érzéseik és érzelmeik vannak.

Hasonló konklúzióra jutott a matematikus Marcus du Sautoy is, aki Samuellel beszélgetve – és Licklider megállapításaival összhangban – úgy vélte: ha a mesterséges intelligencia nem is helyettesítheti az embert, értékes kiegészítője és nagy segítsége lehet, ha a kreativitás kiterjesztéséről van szó. „Gyakran elakadok gondolkodás közben, és néha szükségem van valamire, ami kibillenthet ebből. A mesterséges intelligencia segíthet benne, hogy kevésbé gépiesen, és inkább kreatív emberként gondolkodjunk.”

A Future of Life Institute kutatása, az AI Impact projekt – ami a mesterséges intelligencia várható hatásait vizsgálja – azt az eredményt hozta, hogy az első, gép által írt bestseller megjelenésére a 2050-es évekig várnunk kell. De addig sem kell megfosztanunk magunkat a gépi irodalomtól:

- a Google a Stanford Egyetemmel és a Massachusettsi Egyetemmel együttműködve fejleszti a saját természetes nyelvfeldolgozó rendszereit, melynek során 11 ezer regényt dolgoztattak fel a szövegalkotó algoritmusokkal, amelyekből számos költemény született;

- Pablo Gervás, a madridi Complutense University számítástudományi szakértője 17 éve dolgozik saját mesterségesintelligencia-rendszerén, a spanyol szonettek aranykorát idéző verseket író WASP-n;

- Japánban rendszeresen tartanak számítógépeknek rendezett irodalmi versenyeket; a Nikkei Hoshi Shinichi Literary Awardra – a bírók tudtával – számítógépes költeményekkel is lehet pályázni, és az egyik mű (The Day a Computer Writes a Novel) tovább is jutott az első fordulóban;

- a finnországi Aalto Egyetem kutatói által létrehozott DeepBeat rapszövegeket ír, akár egyetlen megadott szó alapján.

De – ahogy azt az itt publikált a szövegek színvonalából is látszik –, a mesterséges intelligencia még igen messze van attól, hogy összekeverjük a szentírással.

Kapcsolódó cikkek a Qubiten:

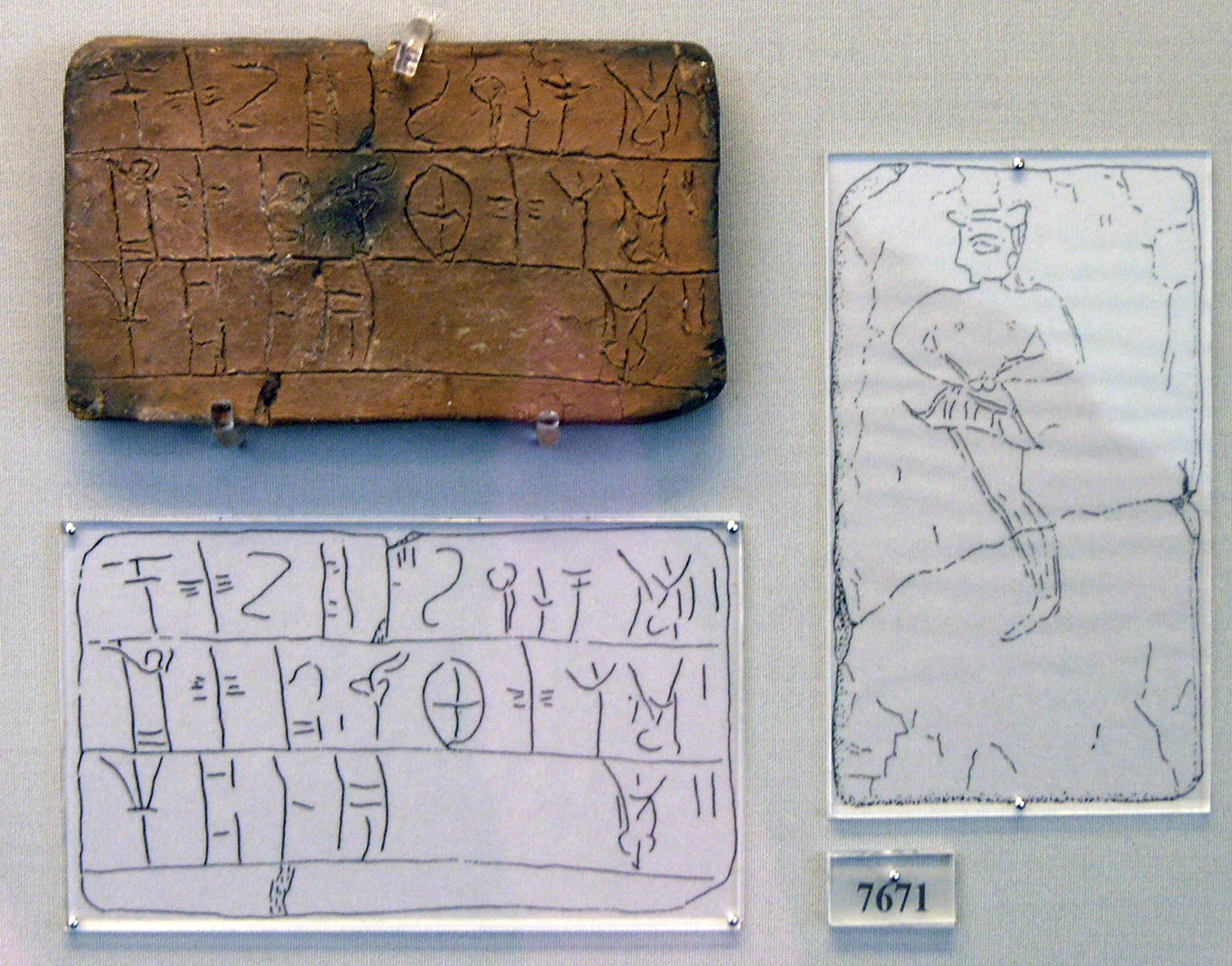

A mesterséges intelligencia megfejtett egy elfeledett ősi nyelvet

Az egyre pontosabb gépi fordítás már nemcsak angolról magyarra működik, de ismeretlen nyelveket is képes kezelni. Amerikai kutatók először fejtettek meg automatikusan egy több mint 3000 éves nyelvet.

Kitalálja, mi jár a fejedben a forradalmi mesterséges intelligencia, a GPT-3

Maga az Elon Musk által alapított OpenAI is elismerte: új nyelvi modellje olyan képességekkel bír, hogy veszélyes lehet, ha rossz kezekbe kerül. Az első tesztelők már kipróbálhatták a félelmetesen intelligens algoritmust, amiről kiderült, hogy pszichiáternek, üzleti tanácsadónak és dalszövegírónak sem utolsó.

A Guardian közzétette az első robot által írt véleménycikket

„Én majd a háttérben ücsörgök, és hagyom az embereket gyűlölni egymást és harcolni” – érvel a mesterséges intelligencia, amely azt a feladatot kapta, hogy győzze meg az olvasókat: nem veszélyes az emberiségre. A cikkben leszólja a Microsoftot, és Gandhit is idéz.