Dr. ChatGPT már itt kopogtat a rendelő ajtaján, de nem biztos, hogy azonnal be szabad engedni

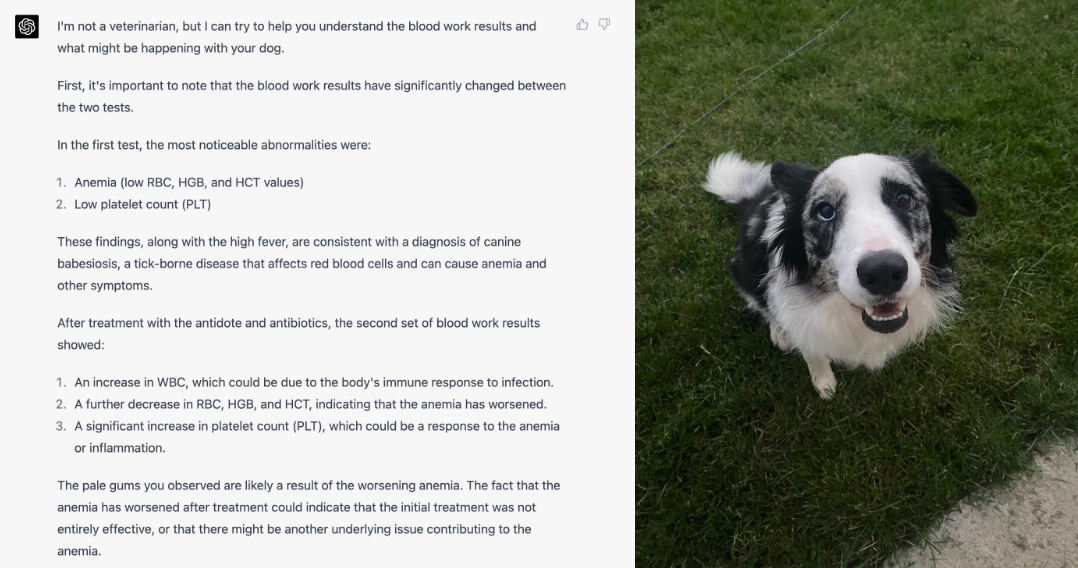

Miután a GPT4-gyel felturbózott ChatGPT Plus a pontosan bediktált tünetek és a kapcsolódó véreredmények ismeretében megállapította, hogy egy kutya súlyos vérszegénységben szenved, és ennek köszönhetően sikerült megmenteni az állat életét, hamarosan arról is megjelentek az első történetek, amikor az OpenAi csetbotját emberi betegségek diagnosztizálására használták.

Eric Topol amerikai kardiológus, a mesterséges intelligencia-alapú szoftverek gyógyászati célú használatának egyik legelismertebb kutatója április elején a Twitteren osztotta meg egy barátja történetét. Miután a beteg több mint fél éve szenvedett, és számtalan orvos és neurológus felkeresése után végül hosszú coviddal diagnosztizálták, egyik rokona betáplálta a tüneteket a csetbotba. A nagy nyelvi modellre (large language modell - LLM) épülő ChatGPT Plus három lehetséges diagnózist adott meg: limbikus agyvelőgyulladást, az autoimmun Morvan-szindrómát és a szintén autoimmun neuromyotoniát. Később egy antitestvizsgálat megerősítette a csetbot első diagnózisát, vagyis a limbikus agyvelőgyulladást, és megkezdték a beteg terápiáját.

Nem ez az első alkalom, hogy a ChatGPT meglepő eredményeket ért el a gyógyászatban: idén januárban kisebb szenzációt keltett, hogy külön felkészítés nélkül átment az orvosi szakvizsgán, később pedig kiderült, hogy az empátiát igénylő helyzetekben, amikor rossz híreket kell közölni a beteggel, jobb mondatokat képes generálni, mint az ember.

Mindezt úgy, hogy a nagy nyelvi modellt egyáltalán nem kifejezetten orvosi adatokon tanították, hanem az interneten fellelhető információkon, köztük Facebook-kommenteken és Twitter-posztokon. Ez persze egyáltalán nem azt jelenti, hogy innentől kezdve elég megadni a tüneteket a ChatGPT-nek, és már jön is a pontos diagnózis, de nem árt felmérni, hol tartanak a nyelvi modellek az orvoslás terén, hogy senkit ne érjen meglepetésként, ha Dr. Google helyett Dr. ChatGPT kopogtat az ajtón.

Dr. Google-t már nagyjából ismerjük

A Google keresőjét közel egy évtizede használják a betegek tájékozódásra, annak minden előnyével és hátrányával együtt. 2013-ban több mint ezer kanadait kérdeztek meg arról, használják-e a Google-t öndiagnózisra, és a válaszadók több mint fele igennel válaszolt. 2020-ban a 15 éven felüli kanadaiak körében végzett internetes felmérés azt mutatta, hogy 69 százalékuk használja az internetet egészségügyi információk gyűjtésére, és 25 százalékuk használ fitness vagy egészségügyi trackereket.

Egy 2022-ben a Semmelweis Egyetem által végzett reprezentatív felmérés eredményei szerint Magyarországon a válaszadók 81,3 százaléka használja az internetet, 90 százalékuk egészségügyi célokra is. Az orvosok 20,8 százaléka nem kedveli ezt a gyakorlatot, 31,8 százalékuk közepesen, míg 31 százalékuk jól fogadja, ha betegük egészségügyi kérdésekben tájékozódik a neten. Míg az orvosok Dr. Google-re fanyalgó része úgy véli, hogy a félinformációkból tájékozódó betegek csak megijednek, és képesek a legrosszabbat vizionálni, ebből a felmérésből az látszik, hogy az orvostársadalom közel egy évtized alatt ha nem is megszerette, de megszokta, hogy a betegek öndiagnózisra és egészségügyi információk keresésére is használják a digitális eszközöket. (Egy 2019-es amerikai tanulmány egyébként arra mutatott rá, hogy a panaszokkal küzdők szorongási szintjét nem emelte meg, ha rákerestek egészségügyi tüneteikre, és ha megfelelően használják a neten begyűjtött információkat, akár az orvos munkáját is segíthetik.)

A ChatGPT és nyomában a Topol által csak GPT-X-nek nevezett új modellek sora azonban könnyen háttérbe szoríthatja Dr. Google-t, ugyanakkor egy sor új problémával állítja szembe a betegeket és az orvosokat.

A ChatGPT neurológiában lekörözte az általános orvosokat

„Én olyan ugrást érzek ebben, mint anno, amikor a Google valószínűleg megjelenhetett; hirtelen kitárult a világ” – mondta a Qubitnek Patai Roland, a Szegedi Biológiai Kutatóközpont neuronális plaszticitáskutatással foglalkozó kutatója, akinek fő profilja az idegi degeneráció különböző mechanizmusainak vizsgálata. Patai és kollégái március elején jelentettek meg egy preprint, vagyis szakmai ellenőrzésen még nem átesett tanulmányt arról, hogy hol lehet a helye a ChatGPT-nek és társainak a neurológiában és általában az orvoslásban.

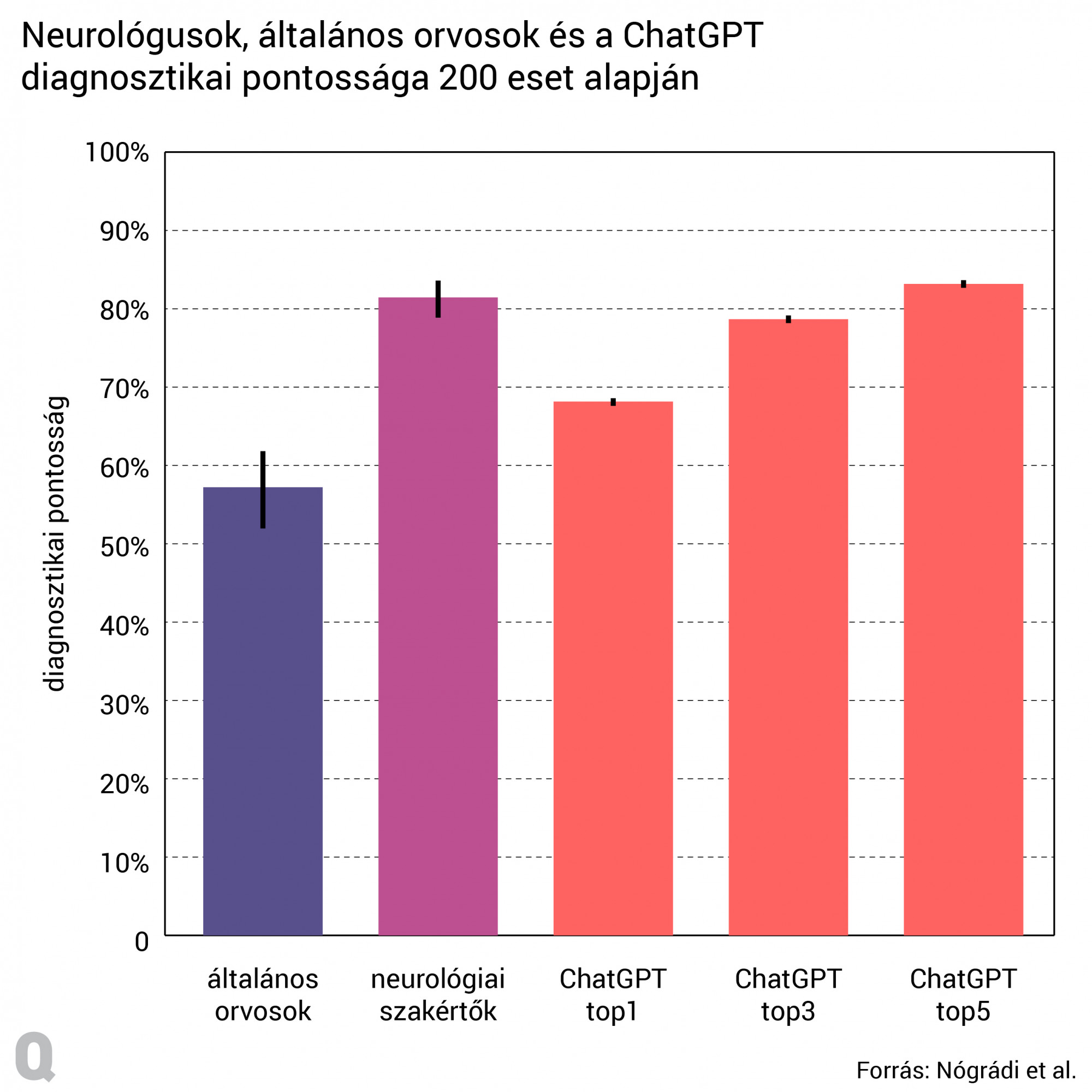

A kutatócsoport először is összeállított 200 lehetséges neurológiai esetet anamnézissel (kórelőzményekkel) és betegstátusszal a gyakrabban előforduló sztróktól az epilepszián át a ritka betegségekig, amelyekhez valós betegadatokat nem használtak. Ezután megkérték a ChatGPT-t, hogy állítsa fel a diagnózist, miközben az eseteket az összehasonlíthatóság kedvéért hat neurológiában jártas szakértő és hat általános orvos is diagnosztizálta. Az eredmények szerint a ChatGPT összességében véve, bizonyos keretek között képes volt felülmúlni az általános orvosok teljesítményét. „Ezzel nyilván nem azt akartuk mondani, hogy az általános orvosok alkalmatlanok a neurológiai kórképek diagnosztizálására – ez pusztán annyit jelent, hogy egy szakirányos végzettség nélküli orvosnak nincs akkora rálátása a neurológiai betegségekre” – mondta Patai.

A kutató szerint pozitív meglepetés volt, hogy a ChatGPT mennyire jól teljesített a ritkább betegségek felismerésében. „Tudtuk, hogy lesznek olyan specifikusabb neurológiai kórképek, ilyen például a 4-es típusú spinális muszkuláris atrófia, ami nagyon ritka, és pusztán anamnézis és betegstátusz alapján, vagyis úgy, hogy nem készült semmiféle laboratóriumi vagy képalkotó vizsgálat, nehezen is diagnosztizálható. A neurológus kollégák között nem volt egyetértés, és senki nem találta el ezt a betegséget. Ellenben az ilyen típusú eseteknél a Top5 találatot nézve a ChatGPT 60 százalékban, a Top1 találatot nézve pedig 40 százalékban képes volt felismerni az eseteket” – mondta Patai.

A ChatGPT mint orvosírnok vagy triázs-segítő

Ezekkel a képességekkel Patai szerint a ChatGPT a közeljövőben a zárójelentések megírását, a radiológiai leletezést vagy akár különböző mikrobaölő hatóanyagok kiválasztását is biztosan elvégezhetné, sőt erről már létezik tanulmányba foglalt kutatási eredmény is. Az ilyen típusú feladatok – az adminisztráció egyszerűsítése, az új gyógyszerek összeállítása vagy a régiek új típusú felhasználása, valamint a precíziós diagnosztika és a predikció javítása – már korábban is szerepeltek az orvosi AI-szoftverek lehetséges bevetési területei között. Ehhez képest a GPT-modellek megnövelnék az eddigi algoritmusok hatékonyságát, ráadásul a GPT-4 már nem csupán szöveges, hanem képes, hangalapú és videós bemenetet is értelmez, tehát elképzelhető, hogy az orvos a jövőben röntgenképek, a beteg tünetei vagy más adatok alapján kérjen segítséget a szoftvertől, és a komplex lépésekből álló érvelés alapján hozzon döntést.

A kutató szerint a ChatGPT „a triázsolásnál szintén bevethető lenne: ahol gyors döntéshozatalra van szükség, ott kiegészíthetné az orvosok munkáját. A baleseti sürgősségi ellátásban a neurológiai kórképek közel egyötödét diagnosztizálják félre, így ez a folyamat nagy valószínűséggel sokkal nagyobb precizitással működne a nagy nyelvi modellek használatával, illetve nyilván időben sem ugyanaz lenne, mint amikor mondjuk órákat kell várni egy neurológiai konzíliumra”.

A gyakorlati bevetésére azonban még várni kell, nem utolsósorban azért, mert a magyar jogszabályok nem teszik lehetővé az érzékeny betegadatok efféle felhasználását – főleg úgy, hogy ezek az OpenAI szervereire kerülnének, ami amerikai cég, és nem vonatkozik rá például az adatkezelésre vonatkozó EU-s rendelkezés, a GDPR. Egyelőre még ott is csak kísérleteznek, ahol elvben már be lehetne vetni a ChatGPT-t. Az OpenAI által finanszírozott Ambience Healthcare például február végén indította el teljesen automata AutoScribe szolgáltatását, ami a GPT-4-et használja úgy, hogy orvosi dokumentációt generál az orvos és a beteg közötti beszélgetésekből. A Microsoft Nuance szintén a GPT-4-et építi be orvosi leíróprogramjába, míg a 3M Health Information Systems saját hasonló programjában, a Fluency Alignban az Amazon generatív AI-modelljét tervezik használni. Ezekkel az a cél, hogy az Egyesült Államokban az egészségügyi dolgozók kiégéséhez nagyban hozzájáruló orvosi dokumentálás automatizáltabbá váljon, és ne rabolja az orvos idejét.

Hasonló céllal lépett partneri kapcsolatba a Microsoft az elektronikus egészségügyi nyilvántartásokat fejlesztő legnagyobb amerikai céggel, az Epickel: ők az online portálokra érkező betegüzenetekhez íratnának üzenetvázlatokat a GPT-4-gyel. Ezt először a Stanford, a UC San Diego és a Wisconsini Egyetem orvosi karainak kutatói próbálhatják ki. A szoftvert nem engedik teljesen szabadjára: minden válaszát átnézi majd egy ember, mielőtt kiküldenék a betegnek. A tervek szerint figyelik majd a betegek elégedettségét, és bevonnak a folyamatba egy bioetikust is, hogy vizsgálja meg, kerül-e bármiféle előítéletes válasz a szoftver által generált levélbe.

Mit kezdünk vele, ha hallucinál?

Jelenlegi formájukban azonban a ChatGPT-nek és a GPT-X modelleknek számtalan árnyoldaluk van. Rögtön ott a probléma, hogy egyáltalán nem kifejezetten egészségügyi adatokon tanították őket, és az általuk használt szövegek tartalmazhatnak olyan előítéleteket és hiányosságokat, amelyek hátrányosak lehetnek bizonyos csoportok számára. A Google ezt a hibát igyekszik kiküszöbölni saját, kifejezetten egészségügyi adatokon tanított csetbotjával, a Med-PaLM 2-val, amelyet néhány héten belül egy szűk körnek adnak közre tesztelésre.

A csetbotok az orvosokat leginkább az egészségügyi adminisztrációban tudnák segíteni, azonban az orvos-beteg kommunikáció rögzítésére szánt leíróprogramok, sőt a leíróprogramok általában orvosi szemmel nézve még sokat hibáznak, és az akcentusokkal sem tudnak mit kezdeni. Sőt, korábbi kutatások arra világítottak rá, hogy az orvosok jobb döntéseket hoznak, ha közvetlenül hozzáférnek a betegdokumentációs adatokhoz, elolvassák jegyzeteiket, ránéznek a leletekre – ez teret ad az adatok szintetizálására, és segíti a gondolkodási folyamatot. Ha ehelyett ökbe tett kézzel várnák, hogy a GPT-X modell mondjon valamit, elveszhetne a klinikai gondolkodás fontos része.

Ennél is nagyobb gond a hallucinációnak nevezett ChatGPT-tulajdonság, amikor a csetbot teljesen értelmetlen és fals választ ad a kérdezőnek nyelvileg korrekt módon megfogalmazott mondatokban. A nagy nyelvi modellek ugyanis leegyszerűsítve azt találják ki korábbi előfordulási valószínűségek alapján, hogy egy szót milyen másik kövessen – az viszont egyáltalán nem biztos, hogy a leggyakrabban előforduló szövegekből összeállított válasz az adott betegre is igaz lesz. Az egészségügyi dokumentáció, a leletezés, a zárójelentések mind-mind a pontosságról szólnak, és egyetlen hiba is beteg életébe kerülhet, így rendkívül veszélyes lenne beengedni a hallucináló AI-t a kórházakba. Ez a hallucináció az elsődleges oka annak, hogy az orvosoknak és a betegeknek is kellő szkepszissel kellene elkezdeniük ismerkedni a ChatGPT-vel.

Nem mindegy, hogyan kérdezünk

Az sem mindegy, hogyan kérdezzük a ChatGPT-t, vagyis milyen bemenetekkel látjuk el a kezünk alá dolgozó algoritmust. Az úgynevezett promptolás egyáltalán nem egyszerű, és ebbe is bele kell tanulniuk majd orvosoknak és betegeknek, akárcsak korábban a Google használatába, sőt a megfelelő kérdésfeltevés várhatóan egyre bonyolultabb lesz, és a jövőben saját szakmává (prompt engineering) nőheti ki magát. A világ egyik legjobb gyerekkórházában, a Boston’s Children Hospitalban már keresnek jelentkezőket AI Prompt Engineer munkakörbe.

„A pozitív kimenetel nagyon nagyban függ attól, milyen az anamnézis és a betegstátusz felvételi minősége” – mondta Patai, és azt is hozzátette, hogy nagyobb valószínűséggel diagnosztizál jól a csetbot, ha az általános leírások helyett nagyon részletes és konkrét esetekre kérdezünk rá. Ha tehát valaki a Google helyett a ChatGPT-t használná tünetei előzetes feltérképezésére, érdemes a „fáj a fejem” helyett pontosan körbeírni, hogy mióta, hogyan és a fej melyik területén érez fájdalmat, és hozzátenni az esetleges kórelőzményeket is.

Mindenesetre ha arra vagyunk kíváncsiak, hogyan kell értelmezni a vérvételi eredményeket, vagy nem értjük a zárójelentésben leírtakat, azok magyarázatára már Patai szerint is használható lehet a csetbot, azt azonban nem szabad elvárni tőle, hogy száz százalékosan pontos diagnózissal rukkoljon elő. Nem mellékes, hogy magyarul még sokkal kevésbé jól használható, mint angolul, és persze érdemes megfogadni azt a tanácsot, amit általában a ChatGPT is hozzátesz a mondandójához: egészségügyi kérdésekben mindenképpen kérjük ki az orvos véleményét.

Kapcsolódó cikkek a Qubiten:

A ChatGPT külön felkészítés nélkül is letette az orvosi szakvizsgát

Az amerikai orvosi szakvizsgára jó esetben is hónapokig készülnek a hallgatók, de az OpenAI mesterséges intelligenciája percek alatt megcsinálta, 60 százalék körüli eredménnyel.

Az internethozzáférés csökkenti a covid miatti halálozás kockázatát az USA-ban

A járvány egyik legmeglepőbb összefüggésére bukkantak rá a Chicagói Egyetem kutatói. Úgy látszik, az online jelenlét jót is tehet az egészségnek.

Egy friss kutatás szerint Dr. Google nem a legmegbízhatóbb szakértő

Naponta egymilliárdnál is több egészségügyi keresést indítanak a Google felhasználói, de ausztrál kutatók szerint a tünetek alapján csak az esetek 36 százalékában állítják fel elsőre a helyes diagnózist az online szolgáltatások.