Itt a ChatGPT-őrület vége?

Óriási a felzúdulás az OpenAI háza táján: Sam Altman hétfőn átigazolt a Microsofthoz, miután az igazgatótanács kirúgta a legismertebb nagy nyelvi modellen alapuló chatbotot, a ChatGPT-t fejlesztő cég vezérigazgatói székéből. A bejelentés hírére több mint ötszáz alkalmazott írta alá azt a levelet, amelyben az OpenAI igazgatótanácsának lemondását követelik, különben otthagyják a céget, és követik Altmant a Microsofthoz.

A nagy zűrzavarban szinte teljesen elsikkadt az a beszéd, amit Altman néhány órával kirúgása előtt, a 2023 Hawking Fellowship Award díjátadóján adott elő, pedig amit mondott, az hatással lehet a mesterséges intelligencia fejlesztésének jövőbeli irányaira is.

„Szerintem újabb áttörésre van szükségünk. Még tovább tudjuk tolni a nagy nyelvi modellek határait, ezt is kell és ezt is fogjuk tenni. Tovább mászhatunk felfelé azon a hegyen, amin állunk, de a csúcsa még mindig elég messze van. De még ha elég messzire jutunk is, ebből talán néhány plusz dolog kisülhet, de nem hiszem, hogy valami olyasmi jönne ki belőle, amit én az általános mesterséges intelligencia szempontjából kulcsfontosságúnak gondolnék – mondta Altman. – Használjuk a szuperintelligencia szót. Ha nem tud új elméleteket alkotni a fizikában, akkor nem hiszem, hogy szuperintelligenciáról lehetne szó. Az ismert adatokon, az emberek viselkedésén és az emberi szövegek klónozásán alapuló tanítás szerintem nem fog minket oda eljuttatni. Szóval ott a kérdés, amin már régóta gondolkodnak a szakmában: mit kell összehoznunk egy nyelvi modellen kívül ahhoz, hogy egy rendszer újfajta fizikát alkothasson meg? Ez lesz a következő küldetésünk”.

Altman szavaira órákkal elhangzásuk után Budapesten reagált Barry Smith, a New York-i Állami Egyetem filozófiaprofesszora, a Why Machines Will Never Rule The World című, tavaly megjelent könyv szerzője. Smith múlt pénteken az MTA Tudományünnep keretében az MI: Robotikától a filozófiáig című nemzetközi tudományos konferencián azt mondta, hogy Altman gyakorlatilag beismerte: hiába fejlesztik még tovább a ChatGPT mögött álló nagy nyelvi modelleket, így nem lehet eljutni az általános mesterséges intelligenciához (artificial general intelligence, AGI), ami képes az összes olyan szellemi feladatot megoldani, amit az ember - és ezzel el is érkeztünk a ChatGPT-hype végéhez. (Arról nem tudni, hogy Altman meglehetősen szkeptikus beszédének volt-e köze a kirúgásához: a hivatalos indoklásban mindössze az áll, hogy vezérigazgatóként nem kommunikált elég nyíltan az igazgatótanáccsal, és így hátráltatta annak munkáját.)

Sztochasztikus papagáj

Smith szerint a világ összetett dinamikus rendszerekben működik, és megvannak a korlátai annak, hogy mennyire tudjuk előre jelezni viselkedésüket, hiszen ezek a rendszerek gyorsabban vagy lassabban, de állandóan változnak, és bizonyos mértékig kiszámíthatatlanok. Ilyen összetett rendszer az emberi agy és bármilyen organikus rendszer. Ezzel szemben a ChatGPT és a mögötte álló modellek zárt, mérnöki rendszerben működnek.

Bár vannak, akik azt állítják, hogy a ChatGPT mögött álló nagy nyelvi modellek már most elérték az AGI szintjét (köztük van Peter Norvig, a Stanford Institute for Human-Centered AI munkatársa), hiszen látszólag univerzális kapacitásuk van arra, hogy bármilyen témát feldolgozzanak, és látszólag emberi módon reagáljanak bármire. A filozófus Smith szerint azonban egyáltalán nem vagyunk még az általános mesterséges intelligencia közelében sem: a ChatGPT pedig gyakorlatilag egy sztochasztikus papagáj, ami a legnagyobb valószínűségek mentén jósolja meg a soron következő betűt és szót, ismétel és összekombinál dolgokat, de semmit nem tud, semmit nem ért meg és semmilyen értelemben nem nevezhető intelligensnek.

Smith szerint az algoritmus nem a való világhoz, hanem egy absztrakt szimulációhoz, az internethez kapcsolódik, ez az absztrakt világ pedig pontosan leírható nagy adatokkal úgy, ahogyan egy videojátékot is pontosan specifikál a hátterében futó szoftver. A ChatGPT így a filozófusprofesszor szerint ennek az absztrakt világnak a szakértője: szimbólumok sorozatát képes legenerálni, de ez egyáltalán nem egyenlő az emberi értelemben vett megértéssel.

Egy kósza járókelő is lehet olyan jó, mint a mesterséges intelligencia

Hasonlóan érvelt a konferencián Gerd Gigerenzer, a Potsdami Egyetem professzora, a berlini Max Planck Emberi Fejlődés Intézet (Max Planck Institute for Human Development) kockázati tudatossággal foglalkozó Harding Központjának igazgatója.

A közkeletű érvelés az, hogy a mesterséges intelligencia a legjobbakat is megverte sakkban és góban, ráadásul a számítási kapacitás Moore-törvényének megfelelően néhány évente megduplázódik, ezért a gépek hamarosan mindenben jobbak lesznek, mint az emberek. Gigerenzer szerint a premisszák helyesek, az ebből levont konklúzió viszont egyáltalán nem. A számítási kapacitás valóban rengeteg problémát meg tud oldani, de nem mindet, a többi pedig marketingesek által keltett hype és techno-vallásos hit. Ha a mesterséges intelligenciát mélytanuló neurális hálókként definiáljuk, és megnézzük, hogy ezek a hálók milyen területeken sikeresek és melyeken nem, azt látjuk, hogy az összetett algoritmusok a jól definiált, stabil világokban működnek jól, úgy, hogy nagy mennyiségű adat áll a rendelkezésükre. Ilyenek például a játékok, a háborúzás és az orvoslás bizonyos részei, ahol az alapprobléma viszonylag stabil, jól körülírható, és nem változik. Ehhez képest az emberi intelligencia rosszul definiált, gyorsan változó helyzetekkel, instabil világokkal is megbirkózik egy nagy adag bizonytalanság mellett – mondta a professzor.

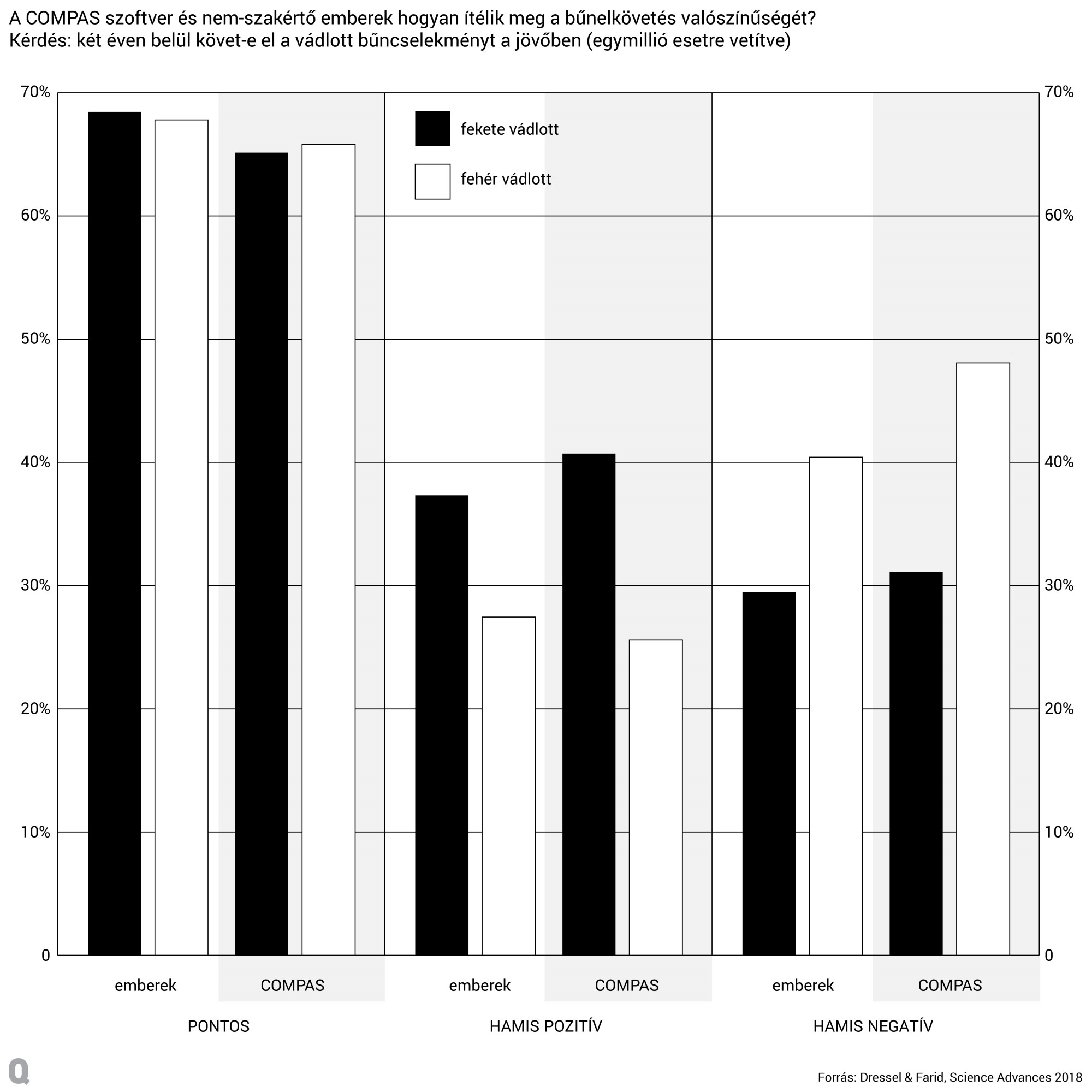

A marketingesek által keltett hype illusztrálására Grigerenzer olyan példákat hozott, mint a bűnüldözésben és prediktív bűnmegelőzésben bevetett algoritmusok, amelyek gyakorlatilag nem működnek, mégis sikerként prezentálták őket. Az Egyesült Államokban használatba állított COMPAS nevű program pontosságáról és hasznosságáról például már 2018-ban kiderült, hogy nem jobb a bűnmegelőzésben, mint egy kósza járókelő. Sem a téves pozitív, sem a téves negatív esetek számában nem különbözött a megítélése egy teljesen véletlenszerűen kiválasztott emberétől, ami többek között oda vezetett, hogy a színes bőrűekről inkább, fehérekről kevésbé feltételezte, hogy bűncselekményt követnek el – magyarul tőről metszett rasszistának bizonyult.

A professzor szerint ezeket a preemptív szoftvereket világszerte anélkül adják el a rendőrőrsöknek, hogy bizonyítékokkal alátámasztották volna, hogy tényleg jobban működnek, mint az emberi megítélés. A Los Angeles-i rendőrség 2021-ben le is állította az Operation Laser nevű projektet, mivel nem volt elég bizonyíték arra, hogy segített volna a bűnmegelőzésben.

Az önvezető autók csak a rájuk szabott környezetben fognak jól működni

Gigerenzer szerint meg kell különböztetni egymástól azokat a rendszereket, ahol a mesterséges intelligencia valószínűleg bevethető, és azokat, ahol egyáltalán nem. Sőt, bizonyos szituációkban az embereknek az a feladatuk, hogy stabilabbá tegyék a fizikai környezetet a gépek számára, és alkalmazkodniuk kell, ha azt akarják, hogy az AI működjön.

Ezt Gigerenzer az önvezető autók példáján mutatta be: szerinte Elon Musk évente bejelenti, hogy a következő évben már elérünk az önvezető autók ötös szintjéig, vagyis bármilyen körülmények között önjáróvá válik az autó, ehhez képest viszont jelenleg a kettes szintű önvezetésnél tartunk, vagyis bizonyos funkciókat képesek az autóknál automatizálni, az ötös szinttől ugyanakkor még nagyon messze járunk. Gigerenzer szerint nem is fogjuk elérni, és csak a négyes szintű önvezetés célozható meg, amikor az autó bizonyos területeken képes önvezetésre, de nem mindenhol.

Ehhez viszont újra kell tervezni városainkat, és olyan sávokat kell kialakítani, ahol csak négyes szintű önvezetésre képes autók közlekedhetnek, gyalogosok és biciklisek nem. Mivel az önvezető autók témája szintén az összetett, gyakran változó és nem stabil világok kategóriájába tartozik, ezen a területen csak így érhető el a mesterséges intelligencia megfelelő működése. Azt a tételt, hogy saját fizikai környezetünket a mesterséges intelligencia igényei alapján kezdjük átformálni, mi sem bizonyítja jobban, mint hogy Peking és Tokió környékén a városokat már a négyes szintű önvezető autókhoz kezdték el igazítani, és a Sanghajtól nyugatra fekvő Szucsouban nemrég megnyitottak egy önvezető taxikra szabott expresszsávot.

Ellenállhatatlan AI?

Ehhez képest James E. Katz, a Bostoni Egyetem professzora, az intézmény új médiával foglalkozó központjának igazgatója a konferencián amellett érvelt, hogy többnyire a gépek veszik át az uralmat a világban, és már most is rengeteg területen nagyon is érzékelhető a jelenlétük. Négy területet azonosított, ahol az emberi túlsúlynak meg kell lennie ahhoz, hogy ne a gépek uralkodjanak a világban: a döntéshozatal, a törvények betartása, erőszak alkalmazása bizonyos célok elérése érdekében és a társadalmak forrásai és vagyona feletti ellenőrzés.

Ehhez képest szerinte a gépek már most olyan döntéseket hoznak, amelyek meghatározzák az emberek életét: az Egyesült Államokban már algoritmusok döntenek az egyes emberek hitelminősítéséről. A második témakörre is akad példa: kamerák veszik fel az utakon a közlekedési kihágásokat, aztán ezekről a mesterséges intelligencia hoz ítéletet, megszabja a bírság összegét, amit az emberek általában kifizetnek anélkül, hogy megkérdőjeleznék a gép döntését. Az erőszak alkalmazása terén Katz azokat az autonóm drónokat említette, amelyek emberi beavatkozás nélkül azonosítják és veszik célba az ellenséget, például Ukrajnában.

A professzor szerint már a pénzügyi piacokon is autonóm rendszerek, algoritmusok adják-veszik a részvényeket és döntenek milliókról, emberi beavatkozás nélkül, és egyre több olyan terület lesz majd társadalmainkban, amit a mesterséges intelligencia ural. Katz erre a jelenségre a hidrogénbomba példáját hozta fel: a technológia ellenállhatatlannak bizonyult ahhoz, hogy ne vessék be – még úgy is, hogy bevetésének következményei ismeretlenek voltak. Szerinte az AI ugyanilyen ellenállhatatlan, emiatt nehéz lesz neki határt szabni.

A konferencián Gigerenzer vitába szállt Katz-cal: elmondta, hogy a hitelminősítő algoritmusok komplex modelljei nem működnek jobban, mint az egyszerűbb programok; a pénzügyi rendszerek prediktív algoritmusai jelenleg nem jobbak, mint az átlagos emberi portfóliókezelők, a katonai eszközök esetén pedig a mesterséges intelligencia veszélyei nem magából a technológiából erednek, hanem az őket használó emberekből, akik meghozzák a döntést a bevetésükről. Emiatt arra kell összpontosítani, hogy milyen esetekben és hogyan vethető a mesterséges intelligencia.

Kapcsolódó cikkek a Qubiten:

Megvan az OpenAI új vezére, miközben a régit, Sam Altmant befogadta a Microsoft

A Microsoft az OpenAI legnagyobb befektetője és kizárólagos felhőszolgáltatója, vagyis Altmannek gyakorlatilag még nagyobb hatalma lesz volt cége felett, mint vezérigazgatóként volt.

„Ha a ChatGPT nem ismerné a kereket, magától nem tudná feltalálni”

Pótolhatatlan tudományos asszisztens vagy béna bullshitgenerátor? Milyen szerepe lehet napjaink első számú gépsztárjának a tudományban? Aki válaszol: Kornai András matematikai nyelvész, Kmetty Zoltán szociológus és Nagybányai-Nagy Olivér pszichológus.