Christian Szegedy: Elfogyott az adat

Hogyan lehet önkritikával bíró rendszert létrehozni, vagyis olyan modellt alkotni, ami képes tanulni és dinamikusan fejleszteni saját magát? Ez a nagy nyelvi modellek fejlesztői előtt álló egyik legnagyobb kihívás és a fejlesztések következő fontos lépcsőfoka, mondta szerda este a HUN-REN SZTAKI által koordinált Mesterséges Intelligencia Nemzeti Laboratórium (MILAB) új meetup-sorozatának első előadásán Christian Szegedy magyar kutató-matematikus. Szegedy korábban a Google-nél dolgozott, nemrég pedig beszállt az Elon Musk által alapított kutatócsoportba, az xAI-ba.

A Magyarországra csak ritkán hazalátogató, mesterséges matematikus létrehozásán dolgozó matematikus arról beszélt, milyen jelenlegi kihívásokat és jövőbeli irányokat lát a generatív modellek fejlesztésében. A találkozón rajta kívül Berend Gábor egyetemi docens, a Szegedi Tudományegyetem Informatikai Intézetének munkatársa beszélt ezeknek a nyelvi modelleknek néhány interpretálhatósági és biztonsági kérdéséről, valamint Schäffer Krisztián programozó arról, hogyan alakíthatja át a fejlesztők munkáját a GPT-4 és a hozzá hasonló nyelvi modellek.

ChatGPT, Bard, Bing és a többiek

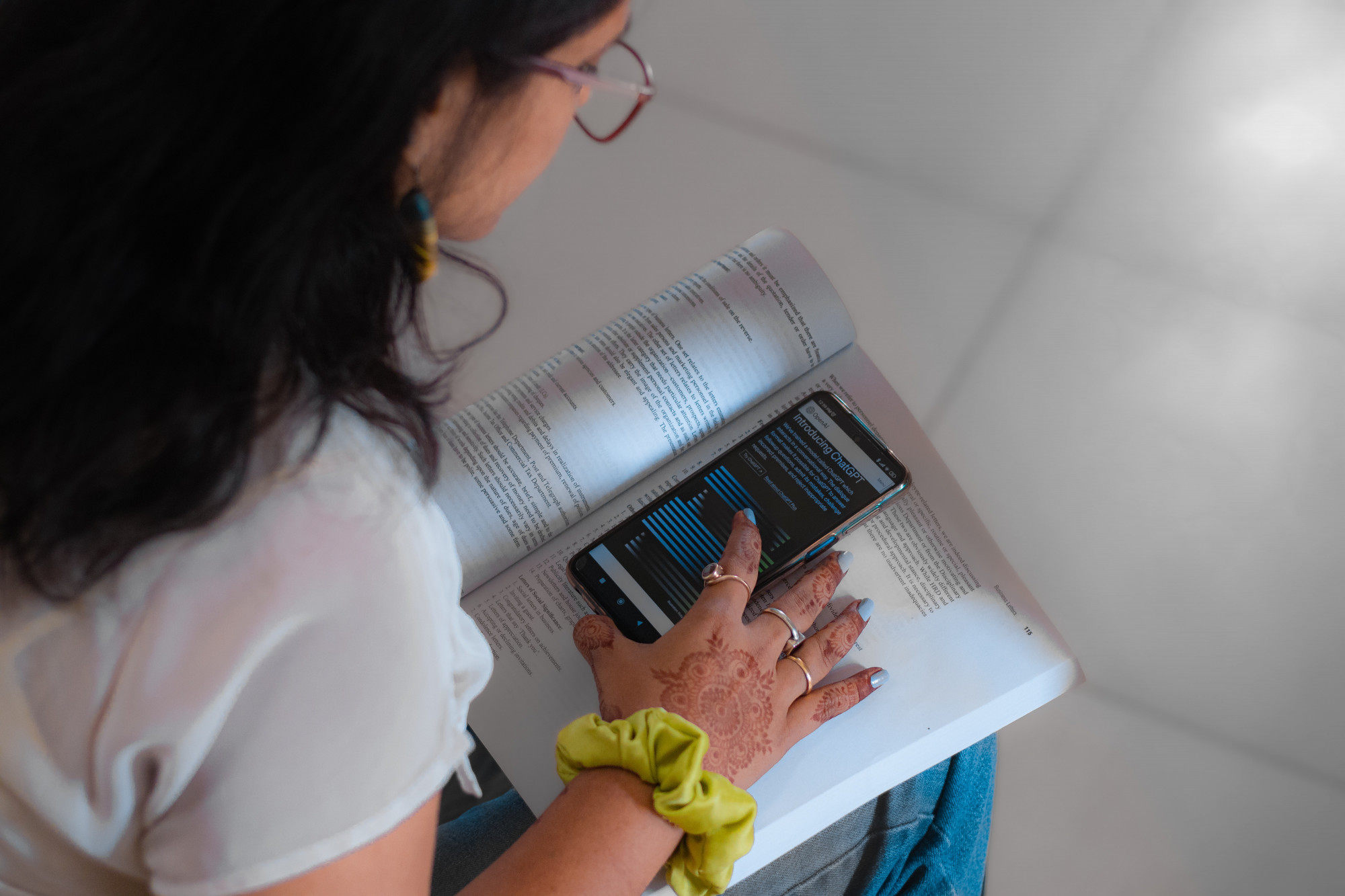

Az elmúlt évben elsősorban az ingyen elérhető ChatGPT révén a nagyközönséghez is eljutottak a tanuló algoritmusokat használó chatbotok, amelyek lassan átalakítják az egyetemi oktatást, a kutatást, sőt megjelentek az orvoslásban, a marketingben és az információgyűjtést és -feldolgozást végző ágazatokban is.

A generatív AI-modellek mindegyike ugyanarra a transzformer modellre épül, amit 2016-2017 körül a Google-nél találtak ki, mondta Szegedy, és ezeket skálázták fel úgy, hogy ma már több száz paraméterrel dolgozzanak. Az olyan generatív modelleket, mint a ChatGPT, a Google Bard, a Microsoft Bing, az Inflection, az Anthropic vagy a Hugging Face, gyakorlatilag arra tréningezték, hogy megjósolják a szövegben a soron következő szótagot vagy szót. A nagy techcégek jelenleg azon dolgoznak, hogy személyi asszisztens jellegű mesterséges intelligenciát, és így használható terméket alkossanak meg ezekből a nagy nyelvi modellekből.

Feltupíroz, kitalál, hablatyol, maszatol

A ChatGPT 2022 novemberi megjelenését meglehetős riadalom követte, hiszen az algoritmus olyan meggyőzőnek bizonyult, hogy sokan saját állásukat féltették tőle. Ezzel párhuzamosan megjelentek azok a hangok is, amelyek a technológia korlátaira figyelmeztettek. Szegedy három pontban összegezte a nagy nyelvi modellek korlátait:

statikusak,, vagyis csak olyan dolgokkal tudnak előállni, amelyek azelőtt történtek, hogy a modellt tréningezték;

elfogyott az adat; a techcégek kimerítették a szabadon elérhető tréningadatok tárházát – gyakorlatilag az egész internetet felhasználták már –, és nincs könnyen hozzáférhető új adat;

nincs garancia a válaszok helyességére és nincsenek referenciák – egy chatbot az esetek 90 százalékában jól működik, de 10 százalékában nem, és nehéz megmondani, helyes-e az adott válasz, hallucinál-e a modell vagy sem.

A modellek hallucinációjára, magyarul durva tévedéseire az egyik legemlékezetesebb példa az volt, amikor Mark Walters amerikai rádiós műsorvezető beperelte az OpenAI-t, miután kiderült, hogy a ChatGPT valótlan információkat terjesztett róla.

Multimodalitás és az AI hibáit javítgató AI

Szegedy szerint a szöveges input és output is korlátozza a chatbotok lehetőségeit, hiszen a felhasználók képeket, gráfokat, strukturált kimenetet is szeretne kapni a nagy nyelvi modellektől, és ezeket a cégek nagy erőkkel el is kezdtek fejleszteni. A GPT-4 már hónapok óta képekkel is dolgozik, a Google Bard nyáron elérhetővé tette a képekkel való promptolást, és a héten az OpenAI piacra dobta a Dall-E 3-mat, amihez hosszú írott promptok helyett elég, ha a ChatGPT-vel beszélget az ember, ha képeket szeretne generálni.

A matematikus elmondta: az egyik jellemző fejlesztési trend a multimodalitás erősítése, aminek köszönhetően a modellek egyre inkább képesek lesznek képekkel és hangokkal is megbirkózni. Erre szerinte a transzformer-modellek rugalmasságuk miatt nagyon is alkalmasak, és egyre inkább helyettesítik a gépi látáshoz és hangfeldolgozáshoz eddig használt konvolúciós hálókat.

Ezen kívül megkezdődött az emberi feedback hasznosítása: Szegedy szerint látszik, hogy elindult a hálózatok finomítása a felhasználók visszajelzései alapján. Erre többféle fejlesztési irány létezik, például az olyan extra modellek tréningezése, amelyek képesek eldönteni, hogy mi a hibás egy konkurens nagy nyelvi modell által kidobott outputban, vagy az a funkció, hogy a hálózat valós időben tudjon az interneten vagy egy belső adatbázisban információkat keresni.

Amikor már magát tanítja

Szegedy számára a legérdekesebb fejlesztési irány, amikor a generatív modell már használ bizonyos külső programokat, azok segítségével elemzi saját outputját, és ki is javítja a hibáit. Ha például programozás a feladata, akkor nem csupán megírja a programot, hanem futtatja is, és ha nem felel meg saját elvárásainak, debuggolja is a kódot.

A kutató a jövőt az olyan önfejlesztő, öntanuló modellekben látja, amelyek képesek adatokat generálni, visszajelzések alapján képesek javítani a minőségen. Ehhez kapcsolódó irány az olyan speciális modellek létrehozása, amelyek megtalálják a megfelelő információt ahelyett, hogy maguk generálnák le.

Létezik megoldhatatlannak tűnő kihívás? Szegedy elmondta: azt a problémát, hogy a generatív modellek száz százalékban helyes válaszokat adjanak, lehetetlen megoldani. Hiszen rengeteg olyan kérdés létezik, amire csak relatív válsz adható, és az is kérdés, hogy mennyire akarjuk, hogy a számítógép döntsön el helyettünk mindent.

Arról a kérdésre pedig, hogy az általános vagy a specialista modellek jobbak-e, a kutató azt mondta, hogy a felhasználástól függ, milyen célú rendszert hozunk létre. De ha a mesterséges intelligencia veszélyeiről gondolkozunk, egy speciális modellről könnyebb elképzelni, hogy egy szűk témában elkezd maga anyagot gyűjteni és feladatokat megoldani, mint egy generalista modellről.

Kapcsolódó cikkek a Qubiten:

Tíz éven belül jön a mesterséges matematikus, amit a Google magyar kutatója fejleszt

Christian Szegedy, a Google Research magyar kutatója csapatával olyan rendszert épít, ami nemsokára túlszárnyalhatja a matematikusok legvadabb álmait: rutinból ellenőrzi majd azokat a bizonyításokat, amelyeket csak néhány ember képes megérteni a Földön, új sejtéseket jósol meg, és olyan távlatokat nyit a matematikában, amelyekről ma még fogalmunk sincs. A fő cél egy programozási rendszer, amelynek interakcióit nem lehet megkülönböztetni az emberitől.

Magyar társalapítója is van Elon Musk új AI-cégének

Az xAI nevű vállalat 12 tagú kutatócsapatába Christian Szegedy, a Google korábbi matematikusa és AI-kutatója is bekerült.

Kapcsolódó cikkek