A Google elszabadult: jöhet a mindentudó okosszemüveg és a zenés-filmes AI-forradalom, de a kereső is teljesen átalakul

Magyar idő szerint kedden este 7-kor, a kaliforniai Mountain View-ban kezdetét vette a Google legnagyobb fejlesztői konferenciájának idei kiadása, a Google I/O 2024. Az esemény egy nappal azután tartották meg, hogy a mesterséges intelligencia (AI) területén a cég legnagyobb vetélytársának számító OpenAI bejelentette a maga új, még gyorsabb, még okosabb nyelvi modelljét, a frissített ChatGPT alapjául szolgáló GPT–4o-t. Az OpenAI új modelljének képességeit az ilyenkor szokásos módon videókon demonstrálták, amik azért általában túl szépek, hogy a valóságban is ilyen könnyen működjenek, de ha majd egyszer hozzám is megérkezik a GPT–4o, kiderül. Ilyesmikre kell gondolni, valós idejű videóbeszélgetéssel, élő képfelismeréssel, mindennel:

Ez mind szép és jó, de most már sejthetjük, hogy miért akarta letudni az OpenAI a nagy idei bejelentését egy nappal a Google konferenciája előtt: a techóriás még magasabbra tette a lécet, legalábbis a videós demók szintjén.

Google AI-gyorstalpaló

Ha a technikai részébe nem is akarunk nagyon belemászni (TensorFlow és társai), akkor sem nehéz belátni, hogy a Google maradandó nyomot hagyott az elmúlt évtizedek mesterségesintelligencia-kutatásaiban. A ChatGPT nevében például a T a transzformernek nevezett mély tanulási architektúrát jelöli, amit a Google kutatói dolgoztak ki, legendássá vált, Attention Is All You Need című tanulmányukban. 2014 óta ráadásul a DeepMind is a cégcsoport része, aminek a ChatGPT előtti világ legszenzációsabb AI-híreit köszönhettük, az önmagát sakkozni megtanító, a mesterien videójátékozó és a biológiát forradalmasító algoritmusaival. És persze a Google Lens képfelismerő, a Google Fotók arcfelismerő vagy a Google Asszisztens beszédleíró funkciójához is kell némi AI, de ezek már végképp hétköznapi technológiáknak számítanak.

A ChatGPT feltűnésére és a techvilág totális fókuszváltására azonban mintha mégsem lett volna felkészülve a Google. A 2022 végén kiadott ChatGPT-re kapkodva adott válaszuk a Bard nevű chatbot volt februárban, amit nem sikerült túl jól brandelni, úgyhogy 2023 decemberében Gemini néven leheltek belé új életet. A fenti szöveg a demonstrációs videókkal szembeni bizalmatlanságról nem véletlen: rögtön az esemény után kiderült, hogy a valós idejűként bemutatott funkciók valójában előre megrendezettek voltak, ami hatalmas csúsztatás egy ilyen termék esetében.

Azzal még várhatnánk néhány órát, netán napot, hogy kiderüljön, az I/O 2024-en bemutatott videók és élő demonstrációk is csak show-elemek voltak-e, de most nézzük meg legalább azt, hogy mit ígér a Google.

Mul-ti-mo-da-li-tás

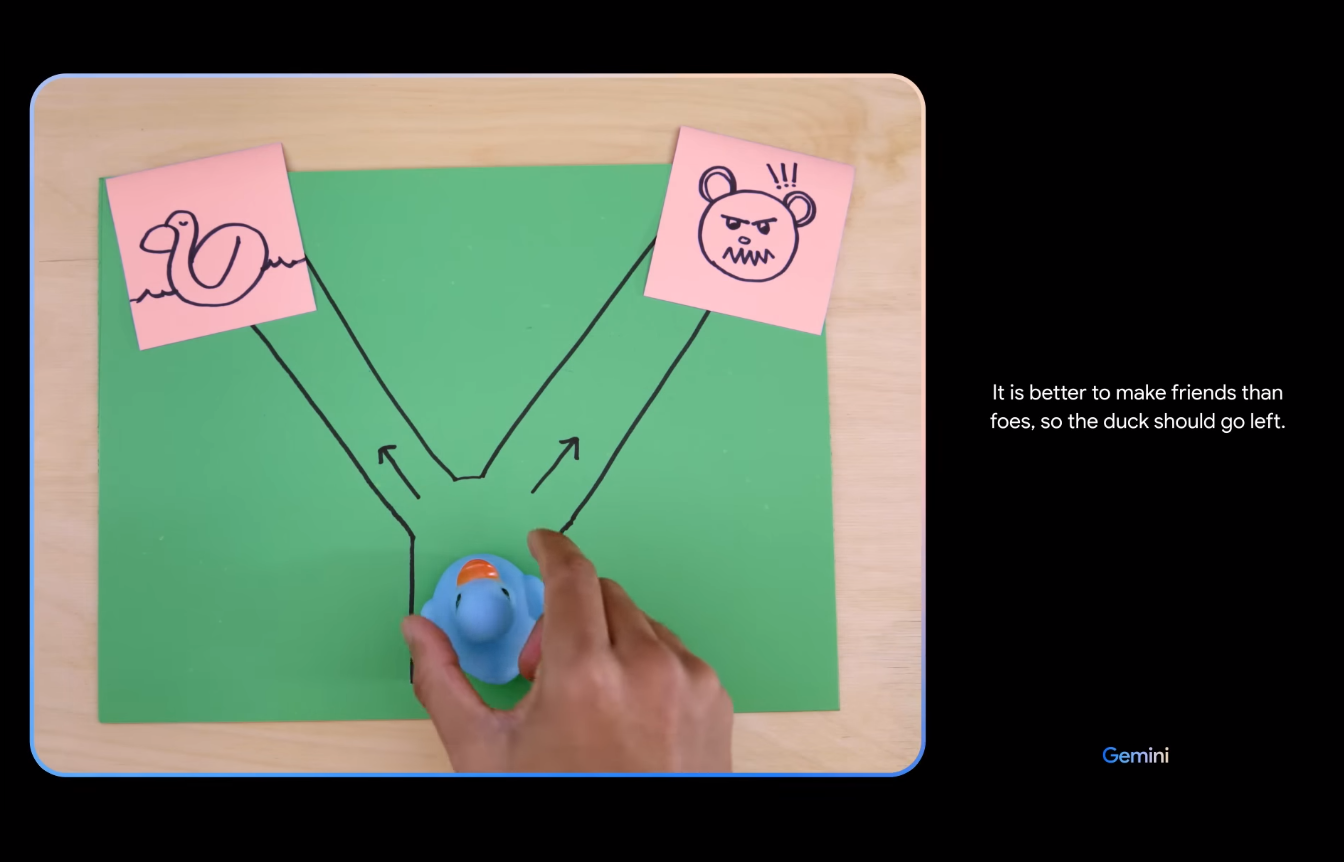

Az év kulcsszava a multimodalitás, ami lényegében azt takarja, hogy egy nyelvi modell, például a GPT vagy a Gemini egyszerre képes szövegekben, képekben és hangokban is gondolkodni. Ezt már láttuk a például képek tartalmát leíró korábbi modelleknél is, de most az OpenAI és a Google is olyan eszközzel rukkolt elő, amely mindent csinál egyszerre: mondjuk valós időben felismer a kamerakép alapján egy szöveget, amire aztán szóban válaszol.

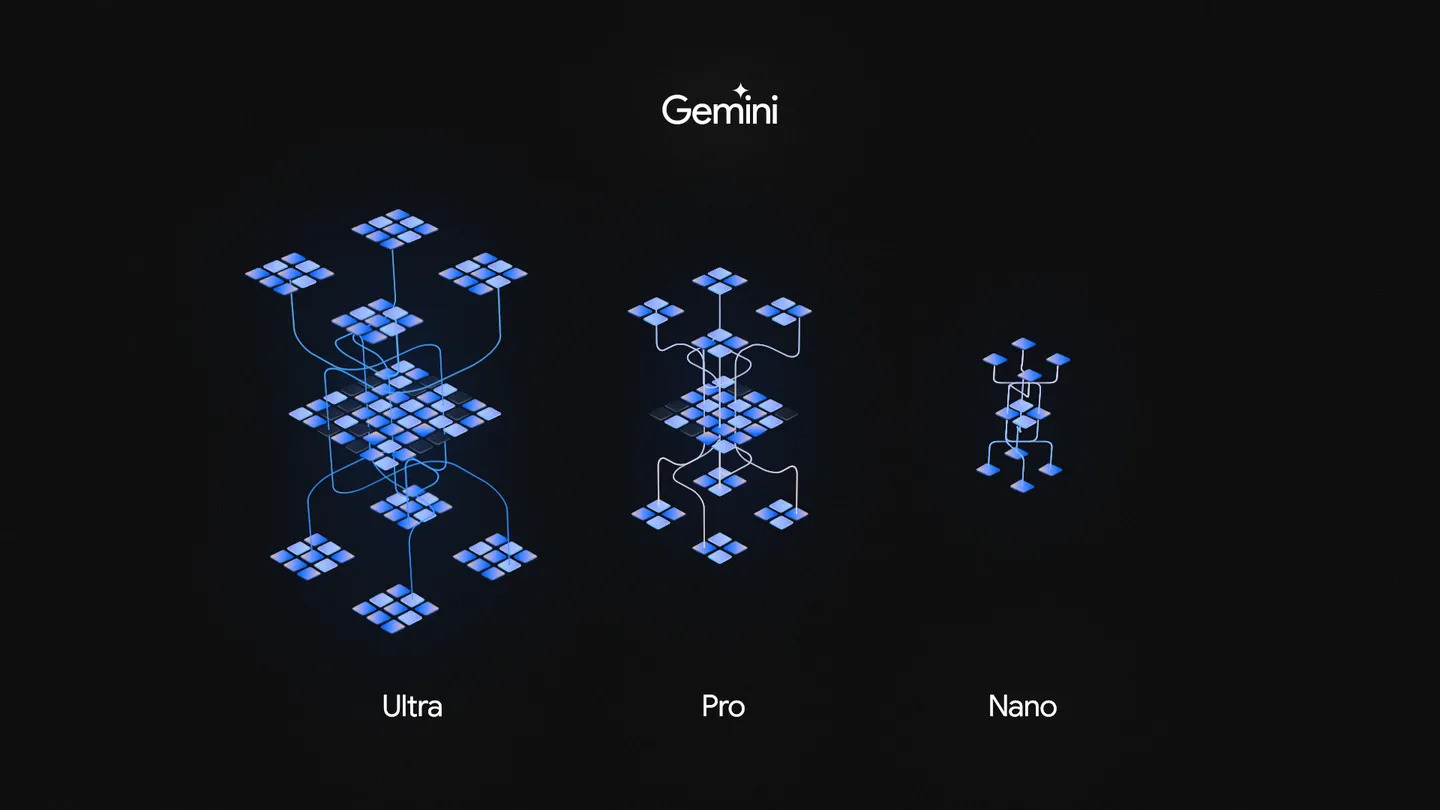

Az új Gemini a hardveres fejlesztésekből adódóan gyorsabb és hatékonyabb is, valamint hosszabb kontextust képes értelmezni. Hogy ez mit jelent? A bejelentés szerint mától minden fejlesztő hozzáfér az egymillió tokenes Gemini 1.5 Pro modellhez, de a kiválasztottak a kétmillió tokenes változathoz is hozzájuthatnak – a tokenek száma az értelmezési tartomány miatt fontos, tehát minél több a token, annál több szöveget vagy más adatot képes egyszerre kezelni, így például hosszabb beszélgetések során is emlékezik arra, miről volt szó az elején, vagy egy hosszabb videófelvétel esetén több részletet képes azonosítani és megjegyezni.

A várakozásoknak megfelelően (és az OpenAI tegnap bejelentett újdonságaihoz hasonlóan) jön a beszélgetőpartnerként funkcionáló AI-asszisztens, amit a Gemini Advanced előfizetői érhetnek majd el. A Gemini Live funkcióban az AI alkalmazkodik a felhasználó beszédstílusához és hangulatához, és már nemcsak robotszerűen felolvassa, amit egyébként szöveges válaszként nyújtana, hanem valós időben lehet vele kommunikálni – a multimodalitás jegyében pedig még a kamerához is hozzáférhet.

A Gemini Live ráadásul csak egyfajta betekintést nyújt majd a Project Astra néven bejelentett projektbe, amit már nem is AI-asszisztensként, hanem AI-ágensként aposztrofálnak, amik Sundar Pichai Google-vezérigazgató szerint „olyan intelligens rendszerek, amelyek képesek gondolkodni, tervezni és emlékezni”. A Project Astra demóvideója talán az egész rendezvény legnagyobb dobása volt, amelyben az AI a felhasználó kéréseire két perc alatt

- felismerte, hol van a hangszóró az irodában,

- felismerte, a hangszórónak melyik részéhez rajzolt egy nyilat a felhasználó,

- alliterálva leírta egy ceruzatartó tartalmát,

- a monitorról leolvasott egy programkódrészletet, és megmondta, hogy az mire való,

- az ablakon kitekintve felismerte, London melyik környékén járunk,

- a felhasználó kérdésére emlékezett, hol látott korábban egy szemüveget a szobában,

- megoldott egy táblára rajzolt informatikai feladatot,

- két rajzolt macska és egy felmutatott doboz alapján rájött, hogy itt Schrödinger macskájára kell gondolnia,

- végül egy plüsstigris és egy élő golden retriever láttán zenekarnevet javasolt a felhasználó kérésére: Golden Stripes.

A szemüveges epizóddal ráadásul valószínűleg egy későbbi bejelentést alapoztak meg, hiszen a videó második felét egy (a bukott Google Glassra emlékeztető) okosszemüvegen keresztül látjuk, amibe be van építve az AI-funkció is – erről a termékről azonban nem esett szó az I/O hátralevő részében.

Scorsese beájulna

A mindenes asszisztens mellett persze számos specializált AI-eszközt is bemutattak. Jön például a minden korábbinál élethűbb, fotorealisztikus képeket generáló Imagen 3 modell, ami kevésbé meglepő fejlemény, nem úgy, mint a belebegtetett zenés-filmes vonal.

Az OpenAI-féle Sora után itt a Google videógenerátora is, a Veo. A szöveges, képes és videós promptok alapján videókat készítő eszköz a DeepMind vezére, Demis Hassabis szerint „különböző vizuális és filmes stílusokban képes megvalósítani a részletes utasításokat. Lehet tőle légi felvételeket kérni egy tájról, vagy time lapse videókat, és további promptokkal bármikor tovább szerkesztheted az egyszer legenerált videókat”. A bemutatott kisfilmben Donald Glover (avagy Childish Gambino), az Atlanta alkotója, a Community vagy épp az új Mr. és Mrs. Smith színésze örvendezett az AI filmes lehetőségeinek – miközben a filmszakmában dolgozók általában nem szoktak örülni a mesterséges intelligencia vizuális térhódításának, és a tavalyi hollywoodi sztrájk egyik központi eleme is az AI elleni fellépés volt.

Zenei fronton hasonló a helyzet: már most ellepték a zenés platformokat a két kattintással generált gépzenék, és hol van még a vége. Ehhez képest a Google zenei AI-funkcióját promotáló Wyclef Jean és Marc Rebillet, na meg a Google szerint az AI valójában a kreativitást ösztönzi. Hogy pontosan miként, az nem derül ki igazán, mindenesetre a Youtube-ra hamarosan érkezik a Music AI Sandbox, ami jelentősen megkönnyíti azt, hogy a zenei ötletek úgy valósuljanak meg, ahogy azt fejben elképzeltük.

A kereső mindenre válaszol

Azt már a Microsoft is megmutatta a Binggel, ami amúgy az online ChatGPT, de egyébként azóta már Copilot, szóval a saját AI-keresőjével, hogy mennyiben más tud lenni az internetes keresés, ha nem kell perceken át gondolkodni a megfelelő kulcsszavakon, amelyek biztosan szó szerint szerepelnek a keresett oldalon, hanem emberi nyelven lehet kérdezni a géptől. Ezt fejlesztette most tovább a Google, amely az év végéig legalább egymilliárd felhasználónak igyekszik bekapcsolni az AI-keresés funkcióját.

Ha kell, a szokásos találatok megmutatása helyett egyből a kereső felületén megválaszolja a feltett kérdést, ha kell, összeállít egy heti étrendet egy koleszosnak, aki csak mikrózni tudja az ételt.

De ha még egy egyszerű kérdést is fáj bepötyögni, a Google Lensszel integrált videós keresés lesz a kedvenc funkciód. A bemutatott példavideóban azt látjuk, ahogy a felhasználó a kamera láttára megfityegteti a lemezjátszó hangkarját, és szóban teszi fel a kérdést: „Miért nem marad ez a helyén?” Innentől a Geminié a pálya: videó alapján felismeri, milyen készülék milyen alkatrészéről van szó, mire utal a kérdésben az „ez” szócska, aztán ha megvan a megfejtés, rá is keres, és szövegesen válaszol. Milyen jól jön ez, ha épp nem jut eszünkbe az a szó, hogy hangkar.

Hogy a kereső elmesterségesintelligenciásítása milyen következményekkel jár majd azokra nézve, akik az internetes forgalmuk jelentős részét a Google keresőjéből szerzik, egyelőre nem tudni, ahogy az is kissé zavaros maradt, hogy az egyes funkciók pontosan mikor válnak elérhetővé, és milyen körben. Mindenesetre a Google blogján részletesen is meg lehet ismerkedni az új AI-termékekkel.

Legközelebb az Apple tart fejlesztői konferenciát: a június 10-én kezdődő WWDC24-en várhatóan szintén nagy teret kap a mesterséges intelligencia – de legalább van 27 napunk fellélegezni, mielőtt a nyakunkba szakad egy újabb világmegváltó AI-asszisztens.

Frissítés (2024.05.15.): Ahogy olvasónk jelezte, az Apple előtt még a Microsoft is megtartja fejlesztői konferenciáját, a 2024-es Build május 21-én kezdődik. Ezen az eseményen is a mesterséges intelligencia lesz a központban, a Windows 11-be épített AI Explorertől a MacBook Air babérjaira törő, vadiúj AI-chippel ellátott Arm-laptopjáig.

Kapcsolódó cikkek

Itt a Google forradalmi mesterséges intelligenciája, a Gemini, ami még a ChatGPT-nél is többre képes