Valóban tudatra ébredt a mesterséges intelligencia?

Mint arról a Qubit is beszámolt, a mesterséges intelligenciával foglalkozók körében nagy feltűnést keltett egy új program, a GPT-3, amely óriási nyelvi adathalmazon tanulva képes nagyon kevés nyelvi inger hatására plauzibilis válaszokat adni, és egyáltalán értelmesen beszélni. Sokan kiemelték: a GPT-3 sikeressége alapvetően az adathalmaz méretének és nem a technológiai innovációnak köszönhető; így inkább átélhetővé tesz egy már korábban megtörtént, de kevésbé látványos technológiai forradalmat. Ez a technológiai forradalom azonban számos, kifejezetten nem informatikai-mérnöki jellegű kérdést vet fel – ezekről kérdezte a Daily Nous korunk kiemelkedő filozófusait.

Teremthet a mesterséges intelligencia kultúrát?

A legfontosabb kérdés az, hogy szükségünk van-e a mesterséges intelligenciára, szabad-e olyan fejlesztésbe belefognunk, amelynek kimenetelével nem vagyunk tisztában – hiszen fogalmunk sincs, képesek vagyunk-e kordában tartani a működését. Az egyik legtöbbet vitatott és politikailag talán legérzékenyebb terület a mesterséges intelligencián alapuló deepfake videók előállítása. Hasonlóan a botok által írt politikai tweetekhez és termékrecenziókhoz, itt is az a kérdés, hogy rendelkezünk-e olyan algoritmussal, amely képes felismerni és ellenőrzés alatt tartani a mesterséges intelligencia termékeit, vagy csak olyannal, amely előállítja őket.

Az algoritmus etikátlan felhasználása mellett további, például esztétikai kérdések is felmerülnek. Az egyik ilyen kérdés az, hogy milyen értékeket képvisel egy, az emberiség által létrehozott és digitális formában elérhető teljes kultúrán nevelkedett mesterséges intelligencia. C. Thi Nguyen, a Utahi Egyetem docense szerint az eddigi tapasztalatok alapján úgy tűnik, hogy csak alacsonyabb szintű esztétikai értékek kvantifikálhatók, a mesterséges intelligencia csak ezeket érzékeli, kizárólag ezek élvezete mérhető. Ahogyan a Las Vegas-i mérnökök szeme előtt a különböző szórakozási formák megtervezésekor az lebeg, hogy azok minél inkább függővé tegyék a fogyasztót, úgy ma a mesterséges intelligenciára támaszkodó játék- és filmipar is olyan értékek mentén tervezi az új tartalmakat, amelyek az ember alantasabb (pl. izgalomra, könnyű szórakozásra való) és nem magasabb rendű (pl. különböző nézőpontokkal való együttérzésre való) igényeit szolgálják ki: a cél az, hogy minél több időt töltsön a felhasználó az adott tartalommal, és nem az, hogy a tartalom magasabb rendű esztétikai célokat valósítson meg. Azonban egy olyan korban, amikor algoritmusok döntik el, hogy milyen alkotások megvalósítására jut pénz – példaként a Kártyavár (House of Cards) című Netflix-sorozat hozható fel, amely az algoritmusok ítéletének köszönheti létét – félő, hogy az igazán értékes kulturális termékekre nem jut erőforrás.

Ennél is komolyabb kérdés azonban, hogy mennyiben alakítja át a kultúra fogalmát az, ha számos, hagyományosan kulturálisnak tekintett terméket algoritmusok hoznak létre. Regina Rini, a Yorki Egyetem professzora azt állítja, hogy többnyire úgy gondolunk a kulturális termékekre, mint amelyeknek egy meghatározott személy az alkotója, azaz nem egy cél nélküli természeti folyamat eredményei, hanem egy célokat tételező gondolkodó lény hozta létre őket. Az algoritmus működésének sajátossága, hogy az esetek döntő hányadában senki nem tudja, milyen forrásokból származik a konkrét kérdésre adott válasz, így tulajdonképpen követhetetlenül komplex kulturális hatásmechanizmusokkal lehet számolni. Elképzelhető, hogy egy senki által sem olvasott blogbejegyzés valamiért rezonál az algoritmussal, amely így azt forrásként használja fel válaszai millióiban. Így az, amit eredeti formájában senki nem olvasott, tartalmát tekintve, ugyanakkor kontextusától megfosztva mégis milliókhoz juthat el. A döntő kérdés, hogy képesek vagyunk-e egy kulturális terméket alkotó nélküli tartalomként megítélni. Hogyan befolyásolja a hagyományosan kontextusokból táplálkozó ítéletalkotásainkat, hogy az algoritmus által létrehozott válaszok kontextusa szinte definíció szerint ismeretlen?

Képes-e a mesterséges intelligencia beszélni?

Kulturális termékeknek tekinthetők-e az ilyen homályos kontextusból felszínre bukkanó novellák, versek, állítások? Másképpen fogalmazva: vajon a gép által megformált kijelentések és az emberek által megfogalmazott kijelentések között pusztán fokozatbeli különbség áll fenn – azaz az ember kevesebb nyelvtani hibát vét, koherensebben fogalmaz stb. – vagy kategoriális különbség van – vagyis amit a gép produkál, az esszenciálisan másfajta dolog, mint amit az ember hoz létre? A klasszikus mondás szerint ha valami úgy totyog, mint egy kacsa és úgy hápog, mint egy kacsa, akkor az egy kacsa. Ennek analógiájára mondhatjuk-e azt, hogy ha valami beszédnek hangzik, és minden másban is úgy működik, mint a beszéd, akkor az beszéd?

David Chalmers, a New York-i Egyetem professzora, korunk egyik vezető elmefilozófusa erre a kérdésre kitérő választ adott. Összhangban a pánpszichikushoz közelítő álláspontjával Chalmers nem tartja valószínűtlennek, hogy a GPT-3 program tudatos, hiszen kétszer több neuronális jellegű kapcsolattal rendelkezik, mint egyes férgek, amelyek szerinte tudatosak. Ezzel szemben azzal kapcsolatban, hogy a program valóban képes-e a megértésre, azaz az algoritmus nyelvi kifejezései tényleg kifejeznek-e valamit, vagy pusztán csak a mintázatnak megfelelően bánik szimbólumokkal, Chalmers sokkal szkeptikusabb. Ezt a kérdést John Searle kínai szoba érve mutatja be: ha valaki egy szobában ül egy bonyolult szabályrendszerrel, ami megmondja, hogy az ajtó alatt becsúsztatott, kínai szimbólumokat ábrázoló papírokra milyen más, kínai szimbólumokat ábrázoló papírokat kell az ajtó alatt kicsúsztatnia, annak ellenére nem beszél kínaiul és nem ért semmit a beszélgetésből, hogy az ajtó előtt álló „beszélgető partnere” azt gondolja, hogy a szobában ülő érti őt, és valódi beszélgetés zajlik köztük. A GPT-3 esetében azonban nehéz biztosat mondani, hiszen nem világos, mi alapján lehet megkülönböztetni a megértésnek tűnő viselkedést a valódi megértéstől – hasonlóan ahhoz, ahogyan a fájdalomviselkedést sem egyszerű elkülöníteni a fájdalom érzésétől.

Justin Khoo, az MIT docense amellett érvel, hogy nem pusztán elvont akadémiai kérdés, hogy beszéd-e az, amit az algoritmus produkál, minthogy ez gyakorlati jelentőséggel bír. Hiszen a szólásszabadságot védő törvények pusztán a beszéd szabadságát védik, azonban ha nem beszéd az, amit az algoritmusok – vagy az algoritmusok által működtetett twitter-botok, véleményeket író hamis felhasználói fiókok stb. – létrehoznak, akkor nem érvényes rájuk a szólásszabadság védelme, és szankcionálhatók. Khoo azt állítja, hogy a szólásszabadságot azért illeti meg védelem, mert így biztosítható a gondolat piacának szabadsága: csak akkor várható el, hogy a gondolatok értékük alapján legyenek rangsorolva, ha mindenki a büntetéstől való félelem nélkül kiviheti erre a „piacra” a maga gondolatait. Azonban a mesterséges intelligencia által működtetett botok lehetővé teszik, hogy valaki a gazdasági hatalmát diszkurzív előnnyé konvertálja, és megengedhetetlen eszközökkel elhallgattassa az egyébként esetleg mélyebb gondolattal rendelkező, de gazdaságilag hátrányosabb helyzetben lévő versenytársát. Aki mesterséges intelligencia révén tisztességtelen versenyelőnyhöz jut és így a gondolatok piacának működését torzítja, már büntetendő.

Létezhet intelligencia anélkül, hogy az „valaki” intelligenciája lenne?

A XX. század előtt magától értetődőnek tekintették, hogy bizonyos típusú cselekvések és állapotok csak személyekhez tartozhatnak. Úgy vélték, hogy csak személyek képesek beszélni vagy gondolkodni, azaz csak a személyek lehetnek „intelligensek” – bármit is értsünk ezen. Éppen ez a felvetés generálta sokszor az állati intelligenciáról szóló vitákat: ha az állatok beszélnek, gondolkodnak és az „intelligencia” egyéb jeleit mutatják, akkor ez egy amellett szóló érv, hogy ők is személyek, és megilleti őket a személyeknek kijáró méltóság. Azonban az, hogy egy számítógépes program is képes intelligens módon viselkedni, és a belátható jövőben az emberekkel vetekedő kompetenciára tesz szert a nyelvi viselkedés és problémamegoldás terén, felveti azt a kérdést, hogy nem lehet-e, hogy a személy fogalmát túlságosan szűken értelmeztük? Lehetséges-e, hogy valaki intelligens legyen anélkül, hogy személy lenne?

Tulajdonképpen három megkérdezett kutató is emellett teszi le a voksát. A fent idézett Chalmers például azt állítja, hogy áthidalhatatlan szakadék van az ember és a program között, mivel a program nem rendelkezik célokkal és preferenciákkal, és így nem is képes cselekedni. A cselekvés filozófiai fogalma ugyanis feltételezi, hogy a cselekvő céljait és preferenciáit fejezi ki: az, hogy felkapcsolom a villanyt, azért az én cselekvésem, mert fel akartam kapcsolni a villanyt, egy olyan világot akartam teremteni, amelyben ég a villany. Ezzel szemben, ha idegességemben megremegett a kezem, és azért kapcsoltam fel a villanyt, akkor a villany felkapcsolása annak ellenére nem nevezhető az én cselekedetemnek, hogy én okoztam a villany felkapcsolását, mert nem volt szándékomban felkapcsolni a villanyt. Chalmers szerint tehát csak az ember képes cselekedni, még ha nagyon nehéz is a harmadik személyű nézőpontból eldönteni, hogy mely tettek tekinthetők cselekvésnek, és melyek nem.

Amanda Askell, a GPT-3 programot megalkotó OpenAI kutatója Chalmershez hasonlóan amellett érvel, hogy a program és az ember között alapvető szakadék tátong, mivel a program nem rendelkezik koherens identitással és stabil célokkal. A program a kontextus függvényében egymásnak ellentmondó állításokat is képes elfogadni, és ez az oka annak, hogy a GPT-3 nagyon rossz a természetes nyelvi érvelésben és vitában. Ezt tanúsítja az a Raphäel Millièr által a GPT-3-mal íratott filozófiai esszé, amelyet a mesterséges intelligencia írt arról, hogy lehet-e a mesterséges intelligencia tudatos. Az eredmény azonban inkább szórakoztató, mint revelatív, hiszen a szöveg a bombasztikus állítások és ordítóan hibás érvelések kétségtelenül izgalmas és élvezetes halmaza, amely inkább hasonlít egy rosszul megírt elsőéves filozófia szakos szemináriumi dolgozatra, mint egy koherens és átgondolt álláspont kifejtésére. Ezt a jelenséget sokan úgy írják le, hogy amikor a GPT-3-mal beszélgetnek, az az érzésük, hogy egy nagyon intelligens, de nem túl felkészült emberrel társalognak, aki megpróbál kamu dumával (bullshit) kompetensnek tűnni.

A stabil hitek és értékválasztások hiányára hívja fel a figyelmet Shannon Vallor, az Edinburgh-i Egyetem professzora is, aki azt emeli ki, hogy a megértés olyan ismeretelméleti munka, amelyre az algoritmus képtelen. Vallor szerint a megértés során a megértő szubjektum világot alkot, azaz koherens jelentéssel látja el a jelenségeket. Azonban éppen azért, mert a mesterséges intelligencia reakcióit mindig egy meglehetősen behatárolt kontextus határozza meg, nem képes egy saját világot alkotni, nem képes olyan új kapcsolatokat létrehozni jelentések között, amelyek értékválasztásait és ebből kifolyóan cselekvéseit vezérelni tudnák. Kérdés azonban, hogy ha nem azt tekintjük személynek, aki intelligens, hanem azt, aki stabil hitek és értékválasztások mentén rendelkezik identitással és ezen hitek és értékválasztások mentén cselekszik, akkor hányan vagyunk személyek azok közül, akik ezeket a sorokat olvassák?

Kapcsolódó cikkek a Qubiten.

Kitalálja, mi jár a fejedben a forradalmi mesterséges intelligencia, a GPT-3

Maga az Elon Musk által alapított OpenAI is elismerte: új nyelvi modellje olyan képességekkel bír, hogy veszélyes lehet, ha rossz kezekbe kerül. Az első tesztelők már kipróbálhatták a félelmetesen intelligens algoritmust, amiről kiderült, hogy pszichiáternek, üzleti tanácsadónak és dalszövegírónak sem utolsó.

Nem létezik olyan algoritmus, ami hülyébb lehetne, mint maga az ember

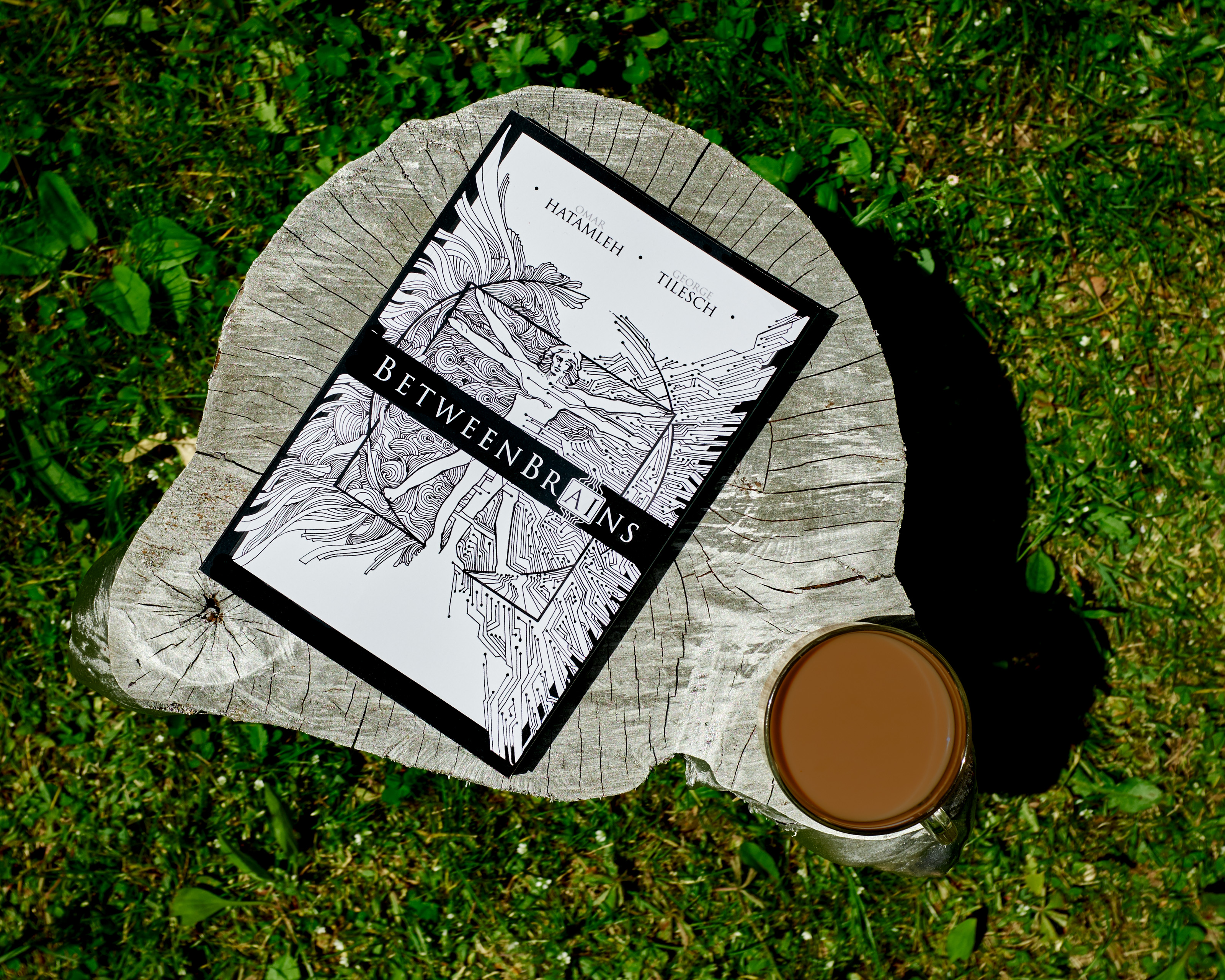

A mesterséges intelligencia lehet áldás és átok is: miközben gyakran az sem világos, hogy mire képes jelenlegi állapotában, komoly indulatokat gerjeszt a felhasználókban. Ebben a zűrzavarban próbál rendet vágni George Tilesch és Omar Hatamleh angolul nemrég megjelent könyve, a BetweenBrains.

A Moore-törvény halálától a tech-nooszféra születéséig

Az emberi kultúra több száz nemzedéken át alakult ki, arra viszont talán csak néhány évtizedünk lesz, hogy megszokjuk és elfogadjuk a mesterséges intelligencia által uralt tech-nooszférát. Sikerül vajon?