Nem akkora őrültség a techmilliárdosok legújabb álma, a mesterséges intelligencia világűrbe költöztetése

A Starlinkhez hasonló AI-műholdrendszereken keresztül valósulhat meg Elon Musk és több más techmilliárdos legújabb álma, a mesterséges intelligencián (AI) alapuló szolgáltatásokat működtető adatközpontok világűrbe költöztetése.

Miközben soha nem látott ütemben pörög a chatbotokat kiszolgáló földi adatközpontok építése az Egyesült Államokban, és az AI-cégek több százmilliárd dollárt ölnek az AI-infrastruktúrába, komoly kihívást jelent az adatközpontok energiaellátása és környezeti lábnyoma, valamint a helyi közösségekre mért hatásuk is egyre több tiltakozást vált ki.

Így érthető, hogy az AI-ipar egyre több szereplője azon dolgozik, hogy az AI-modellek tanításához és futtatásához szükséges chipeket a jövőben a világűrbe telepítsék, ahol működtetésükhöz szinte korlátlan energia áll rendelkezésre – igaz, a koncepcióval szemben kritikus szakértők szerint erre még nem áll készen a technológia, és az tisztán gazdasági szempontból egyébként sem érné meg.

A Starlink adta Musknak az inspirációt

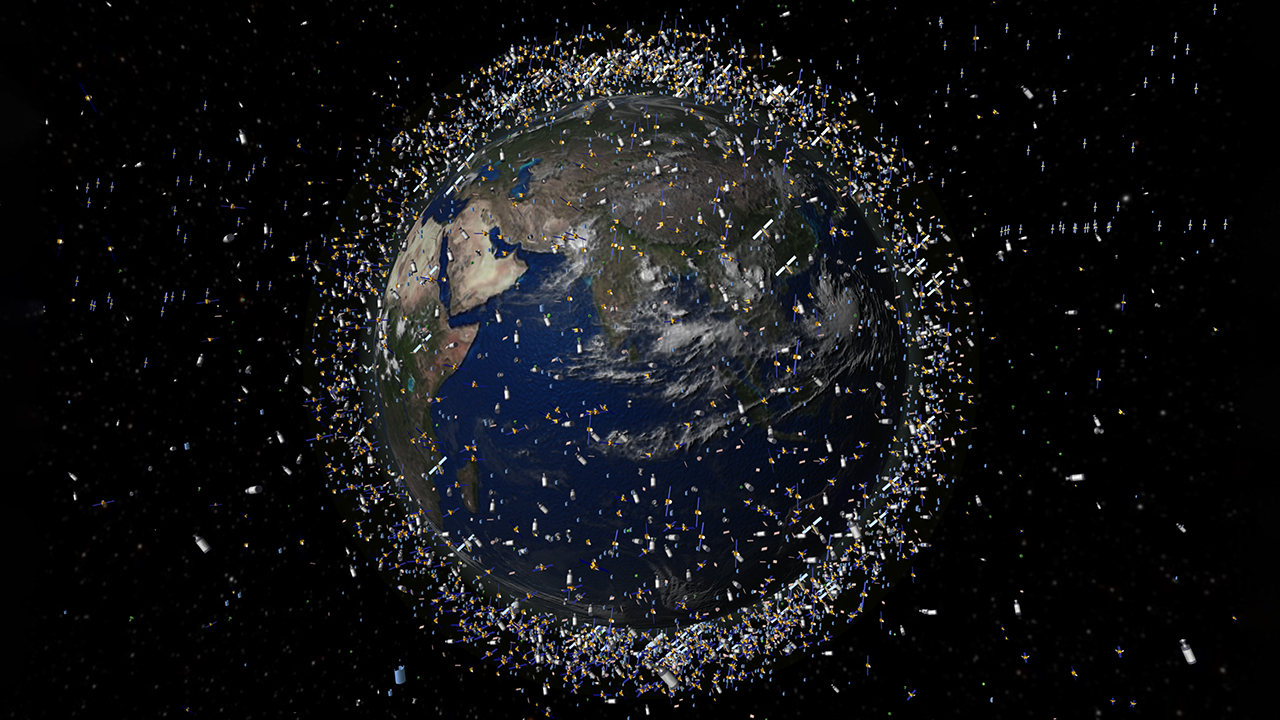

Ahhoz, hogy az űrbeli adatközpontok 2025 végére egyáltalán komolyan felmerülhessenek, két dolog kellett: a világűr hozzáférhetőbbé válása a SpaceX és a Blue Origin részben újrahasználható rakétáin keresztül, valamint a SpaceX űrinternetes Starlink műholdkonstellációjának sikere, amely ma már több mint 9000 műholdból áll. Ez utóbbi volt az, ami miatt Musk – aki a Grok chatbotot fejlesztő xAI cégén, valamint az Optimus emberszerű robotokon dolgozó Teslán keresztül vastagon benne van az AI-versenyben – elkezdett hinni abban, hogy egy hasonló, decentralizált műholdhálózat a jövőben kiegészítheti, vagy akár ki is válthatja a földi adatközpontokat.

És úgy tűnik, a SpaceX vezérigazgatója az AI-műholdhálózat megvalósítására hajlandó feltenni a világ vezető űrcégének jövőjét, és kockáztatni marsi álmait is. December elején a Wall Street Journal és a Bloomberg is arról számoltak be, hogy a jelenleg magántulajdonban lévő vállalat 2026-ban a tőzsdére mehet, aminek során több mint 30 milliárd dollárnyi tőkét kívánnak bevonni. Musk sokáig ellenezte a SpaceX tőzsdei bevezetését (IPO), az ArsTechnica szerint azért, mert nem élvezte a Teslát övező nyilvános figyelmet, és attól tartott, hogy a megtérülést váró befektetők érdekei nem egyeztethetők össze végső céljával, a Mars benépesítésével.

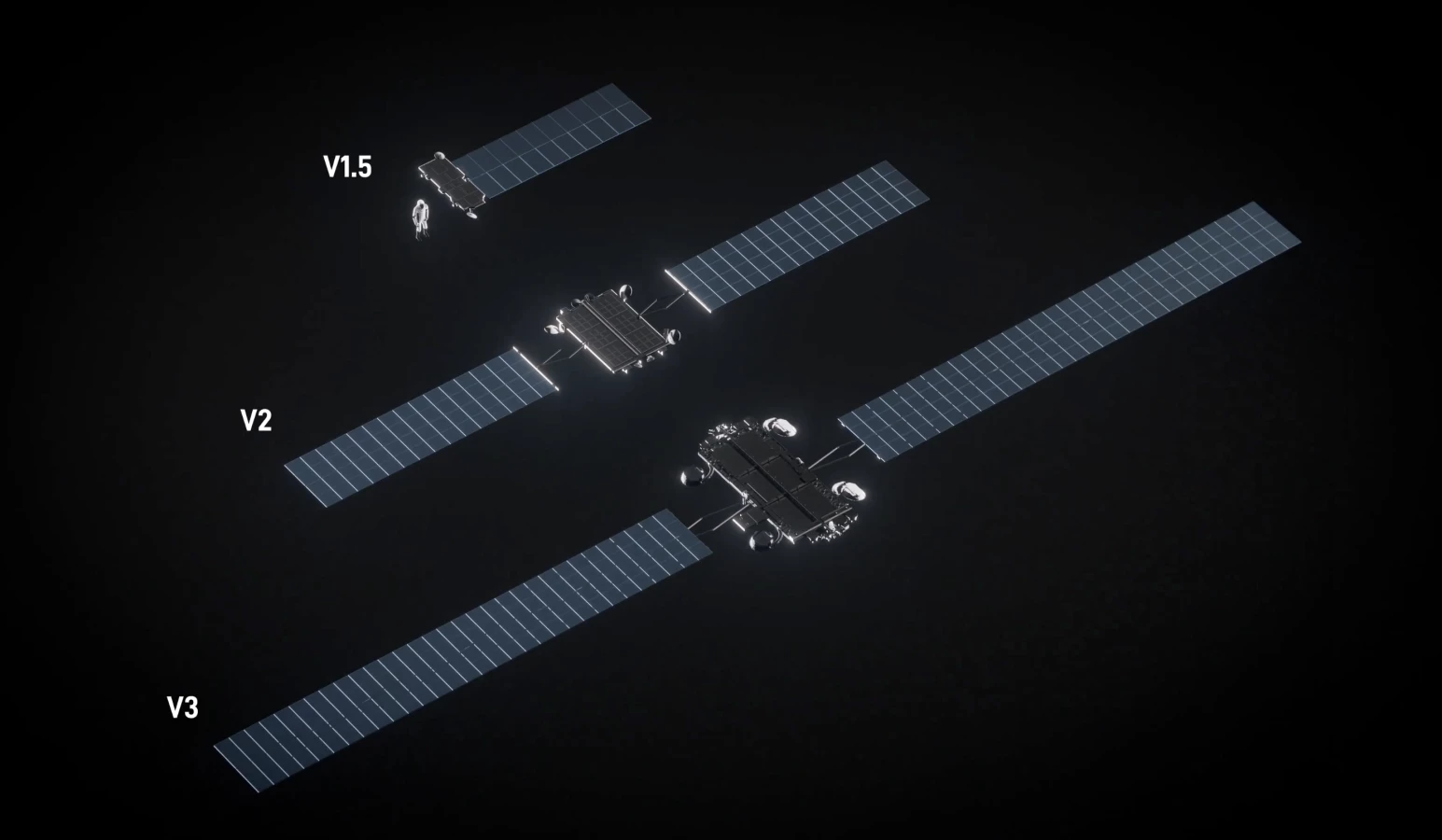

Az űrbeli AI-adatközpontok építésébe a SpaceX módosított, harmadik generációs, Starlink V3 műholdakkal szállna be, amelyek megépítéséhez és pályára állításához kell majd a jövő évi tőkebevonás. Musk októberben arról írt az X-en, hogy az első AI-műholdakhoz elegendő lehet az egymással lézereken keresztül kommunikáló, V3-as műholdak felskálázása. A V3-as Starlink-műholdak, amiket jövőre állíthat először pályára a Starship űrrakéta, a mostani Starlink V2-eseknél lényegesen nagyobb napelemtáblákkal bírnak, és náluk jóval több adatforgalmat képesek lebonyolítani. Decemberben Musk szokásához híven még tovább ment, és egészen futurisztikus víziót vázolt föl holdi AI-műhold-gyárakról, és az AI-műholdakat az égitest felszínéről Nap körüli pályára állító elektromágneses sínágyúkról, amelyekkel szerinte döbbenetes, 100 terrawattnyi számítási kapacitást lehetne nyerni évente.

Nem Musk az egyetlen, aki űrbeli adatközpontokban gondolkodik. Jeff Bezos, az Amazon alapítója és ügyvezető elnöke októberben azt jósolta, hogy a következő 10-20 évben gigawattos kapacitású adatközpontok épülhetnek a világűrben. Eközben a világ legértékesebb vállalata, az AI-chipgyártó Nvidia a Starcloud startupot támogatja, amelynek célja nagy űrbeli adatközpontok létrehozása. Ezek első prototípusát – a H100-as Nvidia grafikus kártyát szállító Starcloud–1 műhold képében – novemberben állították pályára. Az űrbeli adatközpontok iránt a ChatGPT-t kifejlesztő OpenAI vezérigazgatója, Sam Altman, valamint a mesterséges intelligencia terén vezető szerepre törő Google is érdeklődik, és a keresőóriás saját AI-chipjeivel működő első prototípus AI-műholdat 2027-ben kívánja feljuttatni.

Napfény van bőven, de működhet-e az AI-műholdkonstelláció?

Amellett, hogy az űrbeli adatközpontok – ha legyártásukat és fellövésüket nem számoljuk – nem okoznának közvetlenül környezeti terhelést, és nem tudnák ellehetetleníteni őket a lakossági tiltakozások, támogatóik leginkább a világűrben korlátlanul rendelkezésre álló energiára hivatkoznak, mint a legnagyobb előnyükre.

A SpaceX nagy riválisát, a Blue Origin űrcéget megalapító Bezos szerint a folyamatosan elérhető napenergia miatt az űrbeli adatközpontok idővel lekörözhetik a földi adatközpontok teljesítményét. „Ezeket az óriási AI-tréning klasztereket jobb lesz az űrben megépíteni, mert ott a napenergia a nap 24 órájában rendelkezésre áll. Nincsenek felhők, eső, vagy időjárás” – mondta Bezos, aki szerint a következő néhány évtizedben le tudják nyomni a költségek tekintetében a földi adatközpontokat.

Az olyan, alacsony Föld körüli pályán keringő eszközök, mint a Starlink vagy az Amazon Kuiper műholdjai, keringési idejük több mint harmadát töltik földárnyékban, és a működésükhöz szükséges energiát ezalatt a napelemek által feltöltött akkumulátorok biztosítják. Ezt ugyanakkor lehet optimalizálni: a Google Suncatcher néven futó rendszerének AI-műholdjai a cég kutatói szerint egy olyan Föld körüli, napszinkron pályán keringenének, amely maximalizálná azt az időtartamot, amíg napfény éri őket.

De képes lehet-e egyáltalán egy ilyen, decentralizált műholdhálózat az AI-modellek összehangolt tanítására és kiszolgálására? Ehhez a műholdaknak nagyon nagy sávszélességgel kellene kommunikálniuk egymással a Google szakemberei szerint. Bár optimisták, hogy a földi teszteken elért 1,6 Tbps (terabit per másodperc) sebességet fel lehet húzni a rendszer működéséhez szükséges 10-20 Tbps-re, ehhez a hálózat műholdjainak nagyon közel, 1 kilométeren belül kell majd repülniük egymáshoz.

Az is kérdés, hogy egyáltalán miként lehetne realisztikusan elegendő AI-chipet pályára állítani (az OpenAI például közel egymillió AI-chipet használ különböző adatközpontokban a ChatGPT fejlesztésére és működtetésére), és ezek meddig bírnák a Föld körüli pályán őket érő sugárzást. Ahhoz például, hogy a Suncatcher hálózat megérje, a Google TPU-kkal felszerelt műholdaknak legalább öt évig kellene működniük.

Irreálisnak tűnnek a nagy űrbeli adatközpontok

A New Scientist nemrég amellett érvelt, hogy nem lesznek egyhamar űrbeli AI-adatközpontok, legalábbis a földi létesítményekre hajazó, centralizált formában. „Kutatói szempontból az űrbeli adatközpontok messze nincsenek még kész az üzemszerű működésre” – mondta a lapnak Benjamin Lee, a Pennsylvaniai Egyetem kutatója. Lee szerint a sok AI-chip ellátásához egy űreszköznek óriási napelemekre lenne szüksége, ráadásul a chipek által kibocsátott hőt nem lenne könnyű elvezetni.

A világűrben ugyanis nincs levegő, így az elektronikai eszközök hűtését ventilátorok helyett komplex, a hőt hősugárzáson keresztül leadó radiátoros rendszerekkel kell megoldani. Ennek elméletben nincs akadálya, hiszen ilyen, ammónia hűtőközeget keringető radiátorok látják el ma a Nemzetközi Űrállomás (ISS) hűtését is. Csakhogy ezeknek a radiátoroknak nemcsak a mérete, hanem a tömege is elég nagy.

„Négyzetkilométernyi területre lesz szükség külön-külön az energiaellátáshoz és a hűtéshez – mondta Lee. – Ezek a létesítmények elég gyorsan nagyra nőhetnek. Amikor 1000 megawattos kapacitásról beszélünk, az a világűrben sok területet igényel”. Az Nvidia által támogatott Starcloud 5000 megawattos adatközpontokat kíván a világűrben építeni, amik 16 négyzetkilométeres mérete az ISS napelemtábláinak 400-szorosa lenne. A műholdkonstellációkkal ugyanakkor a probléma megkerülhető lehet. Scott Manley asztrofizikus és tudományos ismeretterjesztő youtuber például friss videójában amellett érvelt, hogy a mostani Starlink műholdak működése a bizonyíték arra, hogy annyi AI-chip hűtése, amennyit egy ilyen műhold el tud látni energiával, nem okozna komoly kihívást.

Persze nem biztos, hogy amikorra ténylegesen elérhetővé válnak az űrbeli adatközpontok, a mesterséges intelligenciának szüksége lesz az általuk biztosított hatalmas számítási kapacitásra – akár mert az AI-modellek fejlődése nem skálázódik tovább úgy a számítási kapacitás növekedésével, ahogy fejlesztőik várták, akár mert sikerül a modellek képességeit más úton, vagy új típusú AI-chippekkel növelni. „Tényleg elképzelhető, hogy az [AI-modellek] tréningigényei tetőznek vagy ellaposodnak, és ezzel együtt a gigantikus, nagy lépétékű adatközpontok iránti kereslet is eléri a maximumát, és stabilizálódik” – mondta Lee.

2025-ben az Egyesült Államok indította a világ űrrakétáinak több mint 60 és a feljuttatott rakománytömeg 85 százalékát. Ezek az arányok a következő években a Starship szolgálatba állásával a kínai űrprogram fejlődése ellenére is megmaradhatnak, vagy tovább nőhetnek az USA javára. Emiatt ha az AI-műholdkonstellációk ténylegesen megvalósulnak, működnek, és az AI-modellek teljesítménye tovább nő a számítási kapacitással, a jelenleg elrugaszkodott ötletnek tűnő űrbeli adatközpontok a mostaninál is nagyobb előnyhöz juttathatják az USA-t a mesterséges intelligencia terén, amit az ország ki is kíván használni a tudományos és technológiai fejlesztéseinek felgyorsítására.

Kapcsolódó cikkek